2023年,我国水稻产量约2.07×108 t,占全国粮食总产量的29.71%[1],是我国主要粮食作物之一。水稻穗表型参数如粒数、粒长、粒宽等,在一定程度上反映水稻品种在产量、品质和农艺性状等方面的表现。其中,穗粒数是指单个稻穗上着生的籽粒数,是稻穗表型关键指标,直接反映水稻结实能力和产量潜力,对筛选高产、优质水稻品种具有重要意义。传统人工脱粒计数,劳动量大、效率低,多人测量难以保证统一标准,数据质量易受主观因素影响。通过图像处理和计算机视觉技术,快速获取水稻穗粒数,对于降低劳动强度、加快考种速度等具有重要价值。

国内外学者在基于图像的穗粒计数上开展了相关研究工作。文献[2-7]在脱粒基础上,通过图像处理技术获取粒数,虽具有较高测量精度,但却破坏了原有穗型拓扑结构,影响其他表型参数的测量。马志宏等[8]根据稻穗几何形态特征和穗粒数二者之间的映射关系,提出了基于稻穗图像形态学特征和机器学习建模的在穗粒数测量技术,该方法平均误差为6.72%,若稻穗未充分铺开,会产生更大的误差,只适合小批量样本测量。YU等[9]在不脱粒、不脱壳前提下,用X射线和RGB扫描技术,建立了水稻穗部综合表型系统和相应的图像分析管道,用于提取水稻籽粒性状。杨万里等[10]以盆栽水稻为研究对象,应用Faster R-CNN实现了对盆栽水稻稻穗数的自动检测,但基于目标检测的计数方法需要通过非极大值抑制等后处理方法生成最终的目标检测结果,对于严重遮挡或粘连的目标,无法进行有效检测计数。王栋等[11]开发了一种无需脱粒、直接通过稻穗图像考察每穗粒数和多种穗粒相关性状的智能表型解析算法,该算法在穗稻粒计数决定系数R2为0.88,仍具有较大的提升空间。3D点云方法也常作为表型检测的技术手段[12],但难以适应细微的穗粒结构。刘庆华等[13]提出一种基于YOLO v7优化的水稻籽粒检测算法,用以解决水稻籽粒小目标密集场景下难以识别的问题,改进后模型mAP@0.5:0.95为70.10%,在模型精度上仍有提升空间。

由于稻粒数需完全计数,应用图像及计算机视觉技术进行稻粒在穗计数方便快捷,若能进一步提取稻穗枝梗拓扑信息,二者结合可对稻粒着生及在枝梗上的分布做进一步分析,这是脱粒计数无法实现的。但由于稻粒与枝梗相连,部分稻粒间相互粘连、遮挡,在此情形下,如何进行稻粒在穗计数,并进一步提高计数精度,是亟需解决的问题。本文将稻粒原位计数视作稻粒密度预测问题,通过预训练深度神经网络(Deep neural network,DNN),提取稻穗图像特征,基于少量选取的稻粒范本与图像特征的相关性,预测稻粒概率密度图,并基于密度图统计稻粒数量,通过试验验证方法的有效性,以期为稻穗表型检测和平台设计提供参考。

供试材料品种为天域稻2号,粳型常规水稻,生育期156 d左右,属中晚熟品种,株型紧凑,叶片直立,分蘖力强,苗期叶色浓绿,株高约106 cm,主茎约16片叶,半紧穗型,颖壳呈金黄色。水稻种植于辽宁省营口市大石桥市高坎镇,按当地常规方式种植管理。2023年9月,采集稻穗,置阴凉处风干备用。

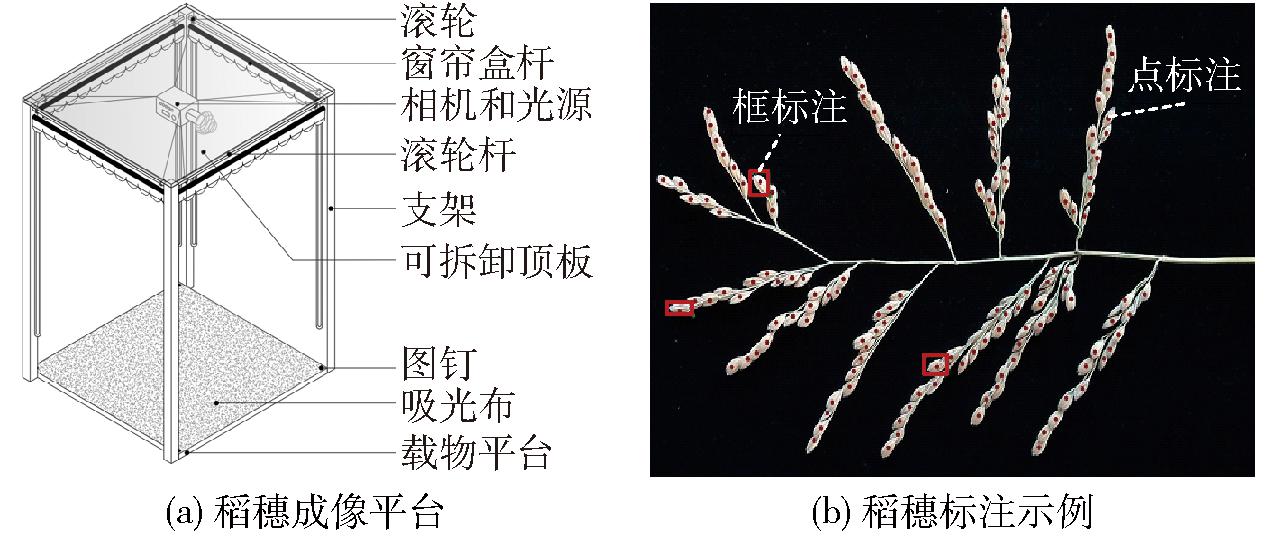

设计成像平台(图1a)用于稻穗图像采集。平台顶板及底板为硬质木板,长×宽为50 cm×50 cm、厚度为1.5 cm。底板上放置黑色吸光布,展平褶皱后固定于板上。顶板及底板四角处连接铝型材支架,支架高为80 cm,支架顶部四周安装窗帘盒杆,内置可收纳遮光布,可根据环境变化调节遮光布收放情况。支架顶部安装滚轮和牵引绳,固定相机和光源,通过滑动滚轮,可调整相机和光源水平位置与垂直位置。相机型号为松典DC201S,CMOS传感器,分辨率为8 000像素×6 000像素。光源为LED灯,亮度为350 Lx。

图1 稻穗成像与标注示意图

Fig.1 Schematic of rice spike imaging and labeling

将稻穗置于载物台上,手动分散开一次枝梗,最大程度地将稻粒呈现在图像中,降低稻粒被完全遮挡的概率。试验供试材料,梳理单个稻穗平均耗时不超过50 s,仍具有较高效率。调整相机高度并固定于载物台上方35 cm处,启动光源并成像。共拍摄不同稻穗图像1 300幅,用于后续试验。对完成拍摄的稻穗进行人工脱粒计数,作为实际稻粒数,并记录图像编号和实际稻粒数的对应关系。

采用LabelMe对所获取稻穗图像进行2种类型标注。首先对稻粒进行点标注,标注位置为每个稻粒的近似中心,如果稻粒的一部分被遮挡,则在其可视部分的近中心进行点标注;其次对有限的稻粒进行框标注,选取N个稻粒作为范本,采用最小外接矩形标注其所在位置及大小,选取的范本稻粒需满足一定要求,一部分范本边缘清晰且不被明显遮挡,如图像上存在稻粒遮挡情况,则选择一部分对其他稻粒具有明显遮挡的稻粒作为范本。标注结果示例如图1b所示。稻穗图像及对应标注结果与实际稻粒数共同构成本文数据集,并以比例7∶1∶2随机划分为训练集、验证集和测试集。

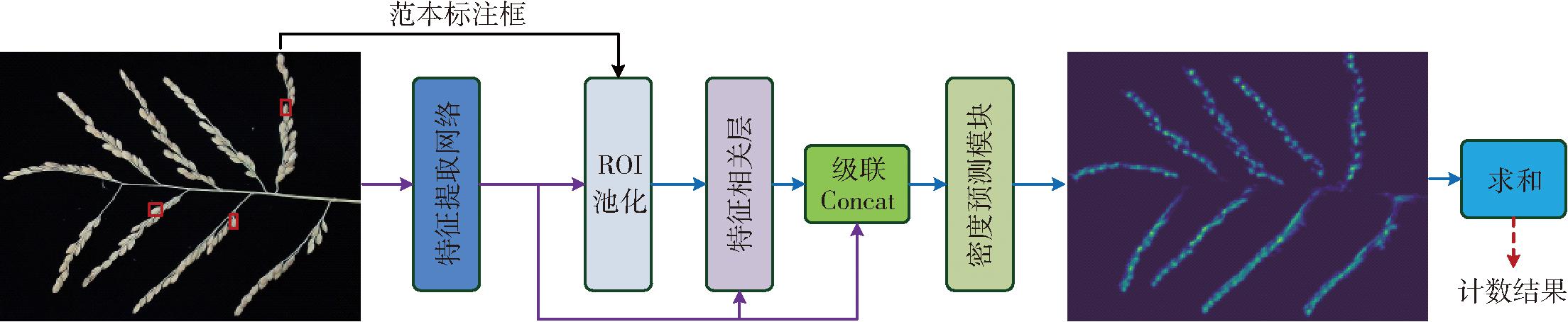

受RANJAN等[14]提出的FamNet方法的启发,本文也将稻粒原位计数视作稻粒密度预测问题。通过预训练的DNN提取稻穗图像I∈R3×H×W的特征图F∈RD×h×w,H×W为图像大小(H、W表示图像高度、宽度),D表示特征图通道数,h×w为特征图空间维度。进一步基于在稻穗图像上用框标注选取的少量范本稻粒,提取范本稻粒区域特征向量fi∈RD,i表示范本索引。兴趣区池化(Region of interest pooling,ROI Pool)操作[15]可应用范本稻粒框标注,直接在特征图F上提取其对应的特征向量fi。对于经过良好预训练的深度神经网络,同一类型目标的特征应具有近似性,即同一类型目标的特征相关性更高,基于这一特性,进一步计算范本向量fi和稻穗图像特征图的相关性,计算方法为用范本特征向量均值f在F的各个空间位置计算点积,即

(1)

![]()

(Cm∈R1×h×w)

(2)

式中 Cm——特征相关性图

在计算相关性图的过程中,![]() 用于对特征相关性进行归一化缩减。FamNet面向小样本通用计数,因此其主要基于相关性图来预测概率密度分布,本文只面向稻粒原位计数,无需考虑模型通用性,即只用于预测稻穗稻粒分布,无需像FamNet一样,用于预测多种类型目标物分布。在图像特征图里具有丰富的语义特征类型,能为稻粒分布预测提供附加线索,因此与FamNet不同,基于特征图F和特征相关性图Cm来预测密度图。应用神经网络构建密度预测模块,将F和Cm在通道维度上级联(Concat)后,作为模块的输入,预测稻粒在稻穗图像上的概率密度分布,获取密度图。利用密度图求和结果作为稻粒计数结果。稻粒在穗计数模型框架如图2所示,其中特征提取网络为预训练的DNN,特征相关层用于计算范本特征向量与图像特征图的相关性图。

用于对特征相关性进行归一化缩减。FamNet面向小样本通用计数,因此其主要基于相关性图来预测概率密度分布,本文只面向稻粒原位计数,无需考虑模型通用性,即只用于预测稻穗稻粒分布,无需像FamNet一样,用于预测多种类型目标物分布。在图像特征图里具有丰富的语义特征类型,能为稻粒分布预测提供附加线索,因此与FamNet不同,基于特征图F和特征相关性图Cm来预测密度图。应用神经网络构建密度预测模块,将F和Cm在通道维度上级联(Concat)后,作为模块的输入,预测稻粒在稻穗图像上的概率密度分布,获取密度图。利用密度图求和结果作为稻粒计数结果。稻粒在穗计数模型框架如图2所示,其中特征提取网络为预训练的DNN,特征相关层用于计算范本特征向量与图像特征图的相关性图。

图2 稻粒在穗计数模型框图

Fig.2 Model of rice grain counting in spike

卷积神经网络(Convolutional neural network,CNN)能够有效提取图像特征,在各类计算机视觉任务中得到广泛应用。FamNet采用ResNet-50[16]作为特征提取网络,该网络的卷积算子为常规卷积,感受野小,很难建立图像上不同像素间的长距离依赖,这限制了其特征提取性能。基于CNN网络的新进展,即可变形卷积(Deformable convolution,DCN)算子[17]来设计稻穗图像特征提取网络,以克服常规卷积的不足。

2.2.1 可变形卷积算子

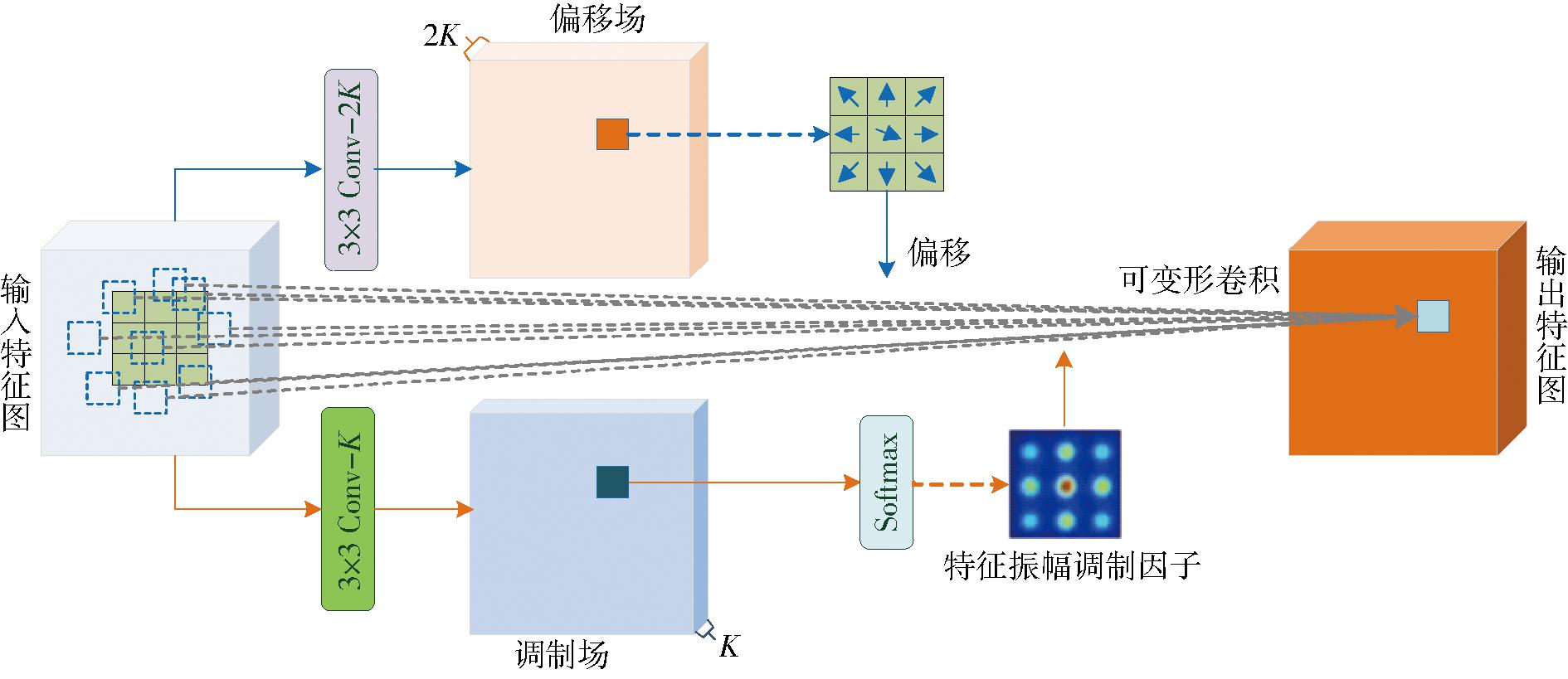

在稻穗图像上,不同位置稻粒大小、方向等形态都存在差异,常规卷积的固定形态采样网格难以直接适应这种形态的变化。WANG等[18]通过引入参数共享、分组机制,并对卷积采样范围内的特征振幅调制标量归一化,提出了新的DCN算子结构,本文基于该算子设计稻穗图像特征提取网络。设x∈RC×H×W、y∈RC×H×W为DCN输入、输出特征图,C表示模块输入、输出特征图通道数,p0为当前卷积运算位置,pk表示在K个常规采样网格内第k个采样点,且有pk∈{(-1,-1),(-1,0),…,(1,1)}。DCN借鉴分组卷积[19]和多头注意力机制(Multi-head self-attention,MHSA)[20]思想,将x在通道维度上平均分成G个组,对每组特征图xg∈RC′×H×W、C′=C/G分别做单独卷积运算,C′表示DCN的分组卷积通道数。进一步借鉴深度可分离卷积思想,对每组卷积核进行分解,拆分成点尺度运算和深度化运算,点尺度运算的线性变换参数对所有卷积采样点共享,即分组卷积核参数为wg∈RC′×C。深度化运算直接由位置感知特征振幅调制因子mg∈RK负责。DCN运算为

(3)

式中 Δpgk——卷积运算过程中的采样偏移

该偏移使采样点可以从常规采样网格中偏移到输入特征图的任意位置,以便建立更大尺度的感受野和局部特征间的长程依赖。DCN每个分组均具有独立的振幅调制因子mg和采样偏移Δpg∈R2K,并通过独立常规卷积Conv对相同的x的学习得到,即

Mg=Softmax(Conv(x;θm))

(θm∈RK×C×3×3,Mg∈RK×H×W)

(4)

ΔPg=Conv(x;θp) (θP∈R2K×C×3×3)

(5)

式中 θm、θP——卷积核参数

Mg——与x空间尺度相同的特征图

将Mg(p0)∈RK用作p0位置处可变形卷积运算的mg,将ΔPg(p0)∈R2K用作Δpg。θm和θp的初始值为0,使初始采样偏移为0,各采样点初始振幅调制因子均等。DCN结构及运算过程如图3所示。

图3 DCN结构及运算过程

Fig.3 DCN structure and operation process

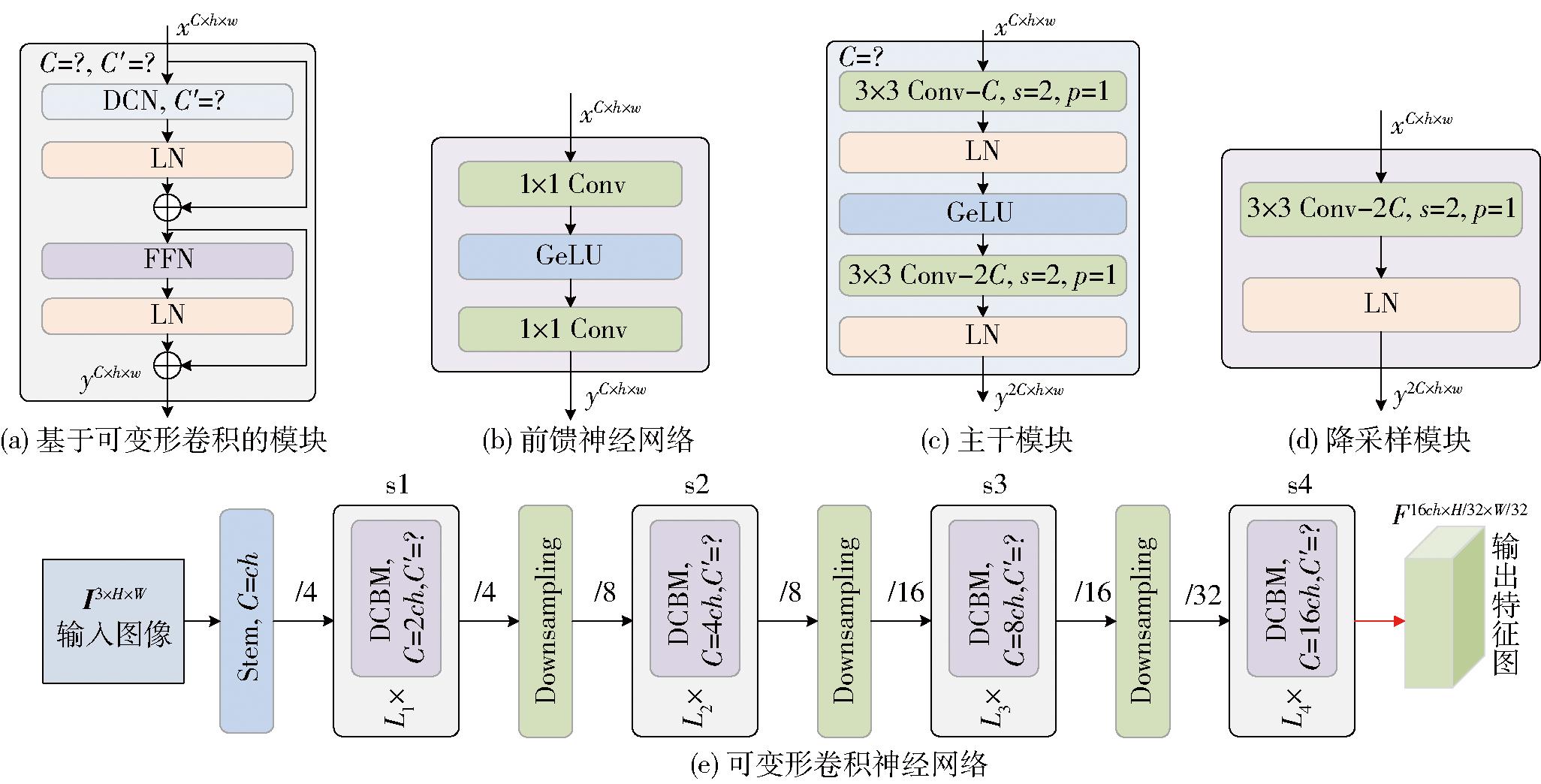

2.2.2 基于可变形卷积的特征提取网络设计

基于DCN算子设计基础模块(DCN-based module,DCBM),用于构造特征提取网络。DCN与Transformer类似,能够建立局部特征间的长程依赖,因此参考Transformer结构,构建DCBM(图4a)。在DCBM模块中,首先用DCN算子对输入特征图x进行特征提取,进而用层归一化(Layer norm,LN)[21]对输出特征图进行归一化处理,并通过恒等映射将输入x与归一化结果进行连接,输出层归一化特征图z,即

z=LN(DCN(x))+x

(6)

图4 特征提取网络结构图

Fig.4 Structure diagram of feature extraction network

随后通过前馈神经网络(Feed-forward network,FFN)[21]和LN对特征图进行处理和归一化,同样连接输入与输出,生成DCBM模块的输出特征图o,即

o=LN(FFN(z))+z

(7)

FFN结构如图4b所示。DCBM模块具有2个超参数C和C′,二者决定分组数G。

进一步用DCBM模块设计特征提取网络。首先构造主干(Stem)模块(图4c),用于将输出特征图的宽、高下采样为输入图像的1/4,该模块由2个Conv构成,卷积核大小为3×3,步长为2,边界填充为1(3×3 Conv,s2,p1),第2个卷积通道数为第1个的2倍,其间采用LN层进行归一化,并采用GeLU[22]作为激活函数。在Stem后,用DCBM模块和降采样模块(图4d)的多次重复堆叠构建CNN网络。降采样模块采用3×3的跨步卷积来构建,将输出特征图宽和高下降为输入的一半,通道数扩展为输入的2倍。将基于DCBM构造的CNN网络命名为可变形卷积神经网络(Deformable CNN,DCNN),结构如图4e所示,其中超参数ch决定整个网络宽度,L1、L2、L3和L4决定网络深度。

2.2.3 特征提取网络训练

将图4e所示DCNN超参数分别设置为ch=64、C′=16、L1=4、L2=4、L3=18、L4=4,并在网络末端连接分类器,参照文献[23],用ImageNet-1k[24]数据集训练该网络。训练结束后,去除s2后的全部模块,将剩余部分用于稻穗图像特征提取,此时其输出特征图为输入图像尺度的1/8。

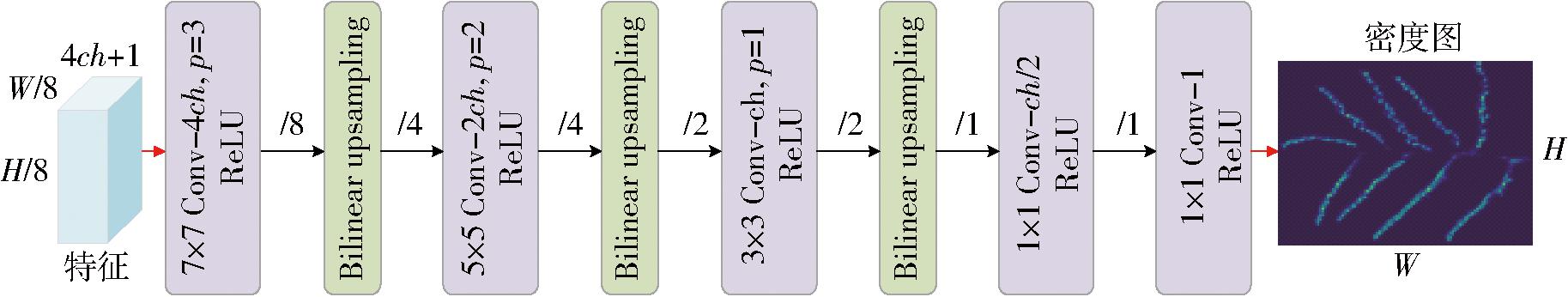

基于CNN设计稻粒密度预测模块(图5),用于预测稻穗图像稻粒分布密度图,该模块由5个卷积层和3个双线性插值上采样(Bilinear upsampling)层构成,3个上采样层分别位于第1、第2、第3个卷积层之后,最后一层卷积是输出通道数为1的1×1卷积(1×1 Conv-1),用于预测稻粒分布密度图![]() 所预测密度图

所预测密度图![]() 的空间尺度与稻粒在穗计数模型输入图像尺寸相同。

的空间尺度与稻粒在穗计数模型输入图像尺寸相同。

图5 稻粒密度预测模块结构图

Fig.5 Structure diagram of rice grain density map prediction module

用预测模块预测密度图,首先在DCNN提取的稻穗图像特征图F基础上,基于范本稻粒的框标注,应用ROI Pool层获取范本的特征向量fi,进一步基于特征相关层计算特征相关图Cm。将F和Cm在通道维度上用级联操作[…]进行连接,生成连接结果FCm=[F,Cm]。以FCm作为预测模块输入,预测稻穗图像的稻粒分布密度图。

2.4.1 真实稻粒密度图生成

采用有监督学习方法,训练本文稻粒在穗计数模型,使稻粒密度预测模块生成的密度图![]() 能够表达稻粒在图像上的分布,同时使

能够表达稻粒在图像上的分布,同时使![]() 的求和结果与图像上的稻粒数相同。直接应用稻穗图像的点标注作为监督信号来训练模型,将面临样本非均衡问题。原因为,如果直接用点标注结果作为真实密度图Z,与有限数量的前景标注相比,Z中存在数量众多的背景,样本严重不平衡,稻粒在穗计数模型难以训练。

的求和结果与图像上的稻粒数相同。直接应用稻穗图像的点标注作为监督信号来训练模型,将面临样本非均衡问题。原因为,如果直接用点标注结果作为真实密度图Z,与有限数量的前景标注相比,Z中存在数量众多的背景,样本严重不平衡,稻粒在穗计数模型难以训练。

借鉴人群计数相关研究工作[25]的处理方法,在点标注数据基础上,应用高斯平滑[26]生成真实密度图Z。首先生成二维高斯核 ,即

,即

(8)

式中 (i,j)——相对核中心点的偏移

σ——生成 时所用的标准差

时所用的标准差

随后对 进行归一化,生成归一化高斯核,即

进行归一化,生成归一化高斯核,即

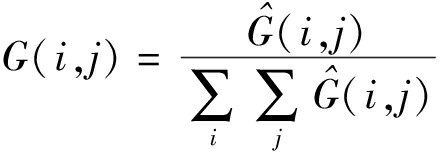

(9)

根据稻穗图像I点标注数据,构建灰度矩阵l∈RH×W,若在I(x,y)处有稻粒标注点,则l(x,y)=1,否则l(x,y)=0。用G对l进行卷积(平滑)处理,可生成密度图Z,即

(10)

由于标注点数量与稻穗图像上可视稻粒数量相同,用G对l做卷积运算所得密度图Z的元素和,也与可视稻粒数量相同,因此用Z作为稻粒分布的真实密度图。采用高斯平滑生成真实密度图可有效缓解稻粒间的部分遮挡问题,当稻穗图像上存在部分遮挡现象时,局部稻粒标注点密集,根据高斯卷积运算特点,在Z的对应区域上也会产生高的密度分布,用Z作为监督信号,也会使计数模型在遮挡区域产生高的密度预测。这与采用基于目标检测计数的方法相比,能够解决后处理导致的遮挡目标无法被有效计数的问题。

归一化高斯核G的生成需确定式(8)中的标准差σ,以及高斯核的窗口大小(宽和高)。根据每幅稻穗图像标注点之间的统计距离来自适应的确定高斯核窗口大小。计算每个标注点与其最邻近标注点之间的距离,进而求距离的平均值dn,将dn作为高斯核窗口的宽和高,并将高斯分布的标准差σ设置为dn/4。这种动态处理使高斯核可较好地覆盖稻粒区域。用高斯平滑生成真实密度图,可将前景标注扩散到标注点周围稻粒区域,可有效解决前景、背景严重不平衡问题。部分真实密度图生成示例如图6所示。

图6 真实密度图生成示例

Fig.6 Example of real density map generation

2.4.2 损失函数定义

用稻穗图像训练样本的真实密度图Z作为监督信号,采用预测密度图![]() 和真实密度图Z的均方误差作为模型训练所需损失函数一部分,即

和真实密度图Z的均方误差作为模型训练所需损失函数一部分,即

(11)

式中 ls——均方误差

对于每幅训练样本图像,除点标注数据外,还包括稻粒范本的框标注,在对范本进行标注时,选择了部分遮挡其他稻粒的范本稻粒,因此标注框内存在多于1个稻粒的情况,为进一步解决遮挡问题,引入标注框计数损失。设B为样本图像I的标注框集合,b为其中的一个标注框,设![]() 为模型预测密度图在b范围内的裁剪块,由于b内具有可能多于1个的完整稻粒,因此

为模型预测密度图在b范围内的裁剪块,由于b内具有可能多于1个的完整稻粒,因此![]() 块元素求和结果

块元素求和结果![]() 应满足

应满足![]() 恒成立,当范本标注框内的计数结果小于1,即

恒成立,当范本标注框内的计数结果小于1,即![]() 时,应产生计数损失。需约束该条件

时,应产生计数损失。需约束该条件

(12)

式中 lm——范本标注框计数损失

通过lm损失,进一步激励计数模型在遮挡区域生成高密度分布。将ls和lm的线性组合结果作为稻粒在穗计数模型的最终损失函数,即

l=ls+λlm

(13)

式中 l——总损失函数

λ——线性组合系数,取0.01

以argminl作为模型训练目标。本文模型在训练完成后,无需在推理阶段再通过多次误差反传来修正网络参数,这与小样本计数方法FamNet不同。

2.4.3 模型训练及测试

基于PyTorch 2.1,应用Python 3.9编程实现本文稻粒在穗计数模型。在一台配置有AMD Ryzen 9 7945HX with Radeon Graphics处理器,NVIDIA GeForce RTX 3090显卡,Windows 10操作系统,CUDA 11.8并行加速库的计算机上开展模型训练及测试试验。

用稻穗图像训练集训练稻粒在穗计数模型,用Adam优化器迭代优化模型参数,学习率设置为10-5。训练过程中,固定预训练特征提取网络DCNN的权重参数,仅训练稻粒密度预测模块,使其能够基于DCNN提取的稻穗图像特征和特征相关图来预测稻粒分布密度图。将输入图像调整为固定的512像素×384像素,训练中用颜色随机抖动、随机水平、垂直翻转等数据增广处理来增加样本多样性。用稻穗图像验证集和测试集评估计数模型的有效性。评估过程中,模型输入图像尺寸与训练时相同,但不再采用数据增广处理。

选取平均绝对误差(Mean absolute error,MAE)、均方根误差(Root mean squared error,RMSE)和平均相对误差(Mean relative error,MRE)来衡量计数方法的准确性,采用决定系数(R2)来衡量模型的拟合优度和预测性能。

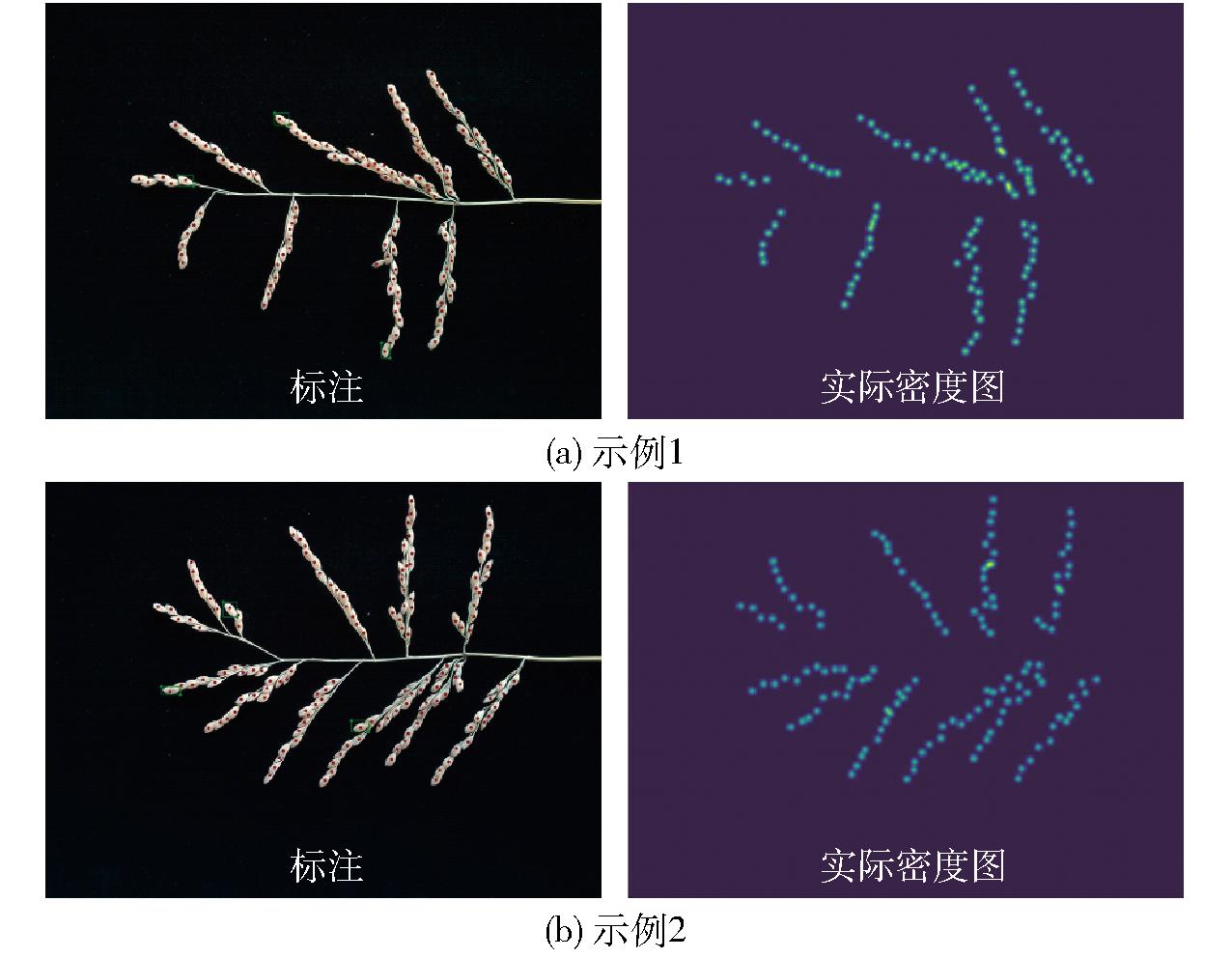

用稻穗图像验证集和测试集评估本文稻粒在穗计数模型的有效性,同时,和现有一些基准模型(T-Rex2[27]、FamNet、CSRNet[28]和ICACount[29])进行比较。其中,T-Rex2为基于目标检测的计数模型,后3种方法为基于密度图预测的计数方法,CSRNet被广泛应用于人群或车辆计数。此外选取两种常用的移动计数工具:精点相机[30]和帮你数[31],测试其在稻穗计数上的适用性。进一步将稻穗图像点标注结果视为人工走查计数结果,由于稻粒可能会被完全遮挡,基于图像的人工走查计数结果只是可视稻粒数量,这和脱粒计数结果可能存在差异,因此将人工走查计数也视为一种方法。各方法计数性能如表1所示。

表1 不同在穗计数方法计数性能对比

Tab.1 Comparison of counting performance of different in-fringe counting methods

方法验证集测试集MAERMSEMRE/%MAERMSEMRE/%单帧耗时/s人工走查3.0775.0882.14.3545.5412.2180~300精点相机65.45069.96749.154.19258.31339.915帮你数38.12343.85927.555.53159.26740.810TRex241.00848.81228.943.44649.40931.24FamNet19.57225.2199.020.75525.93312.81.38CSRNet16.60722.01311.014.77326.76911.61.20ICACount20.89730.62710.522.41827.38514.54.25本文方法4.7198.0641.94.7106.9202.90.92

由表1可知,本文方法在稻粒在穗计数上的精度仅低于人工走查计数结果,高于其他计数方法和工具,其在验证集上的MAE和RMSE分别为4.719和8.064,MRE为1.9%,比人工走查方式低0.2个百分点。本文方法在测试集上MAE和RMSE分别为4.710和6.920,MRE为2.9%,MRE比对应的人工走查结果高0.7个百分点,表明本文方法具有较高的稻粒在穗计数精度。与人工走查图像相比,本文方法的误差与其相接近,但实际应用中,人工走查统计1幅图像中稻粒数需180~300 s,而本文方法只需0.92 s,大幅提高工作效率。与基准方法FamNet相比,本文方法在测试集上的MRE低9.9个百分点,具有更高的计数精度。本文方法和FamNet同时应用了少量范本和图像特征的相关图来预测稻粒密度分布,但与FamNet相比,本文方法在预测密度分布时,同时应用了稻穗图像的深层特征,且优化设计了特征提取骨干网络,该网络能够建立特征间的长程依赖,具有更好的特征提取能力。与CSRNet、ICACount相比,本文方法MRE在验证集上分别低9.1、8.7个百分点,在测试集上分别低8.6、11.6个百分点,3种方法虽然均基于密度图预测,但本文方法具有更好的表现。与本文方法相比,通用计数工具和基于目标检测的T-Rex2方法,在稻粒在穗计数任务上的精度均较低,表明通用计数工具在稻粒计数上的泛化性仍较差,难以直接应用,开发专用的稻粒在穗计数方法是必要的。由于稻粒在稻穗图像上属于小目标,且相互粘连、遮挡,目标检测难度大,计数精度较低。总体上,本文方法稻粒计数MRE低于3%,为理想计数精度,可用于稻粒在穗计数等表型检测任务。

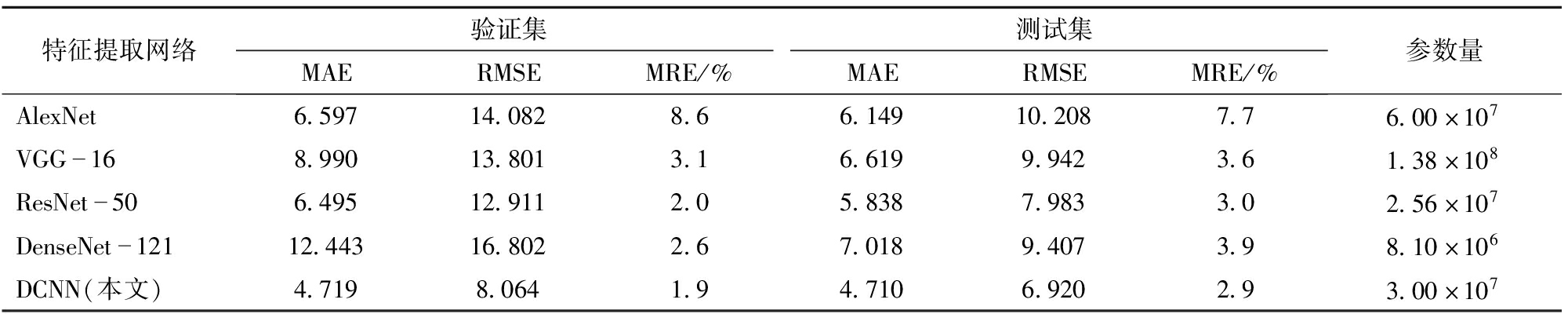

基于可变形卷积,优化设计了用于稻穗图像特征提取的骨干网络DCNN,为分析该网络在稻粒计数任务上的有效性,和现有典型CNN网络进行比较。分别将AlexNet[20]、VGG-16[32]、ResNet-50[16]和DenseNet-121[33]用做本文稻粒在穗计数模型的图像特征提取骨干网络,模型其他各组件保持不变,各网络均已在ImageNet-1k[25]数据集上完成预训练。不同骨干网络的计数模型均采用相同的训练和测试设置,结果如表2所示。

表2 不同特征提取网络的稻粒计数性能对比

Tab.2 Comparison of rice grain counting performance of different feature extraction networks

特征提取网络验证集测试集MAERMSEMRE/%MAERMSEMRE/%参数量AlexNet6.59714.0828.66.14910.2087.76.00×107VGG168.99013.8013.16.6199.9423.61.38×108ResNet506.49512.9112.05.8387.9833.02.56×107DenseNet12112.44316.8022.67.0189.4073.98.10×106DCNN(本文)4.7198.0641.94.7106.9202.93.00×107

由表2可知,当采用本文设计的特征提取网络DCNN时,计数模型具有最高的计数精度。DCNN参数量低于AlexNet和VGG-16,但前者在验证集和测试集上的计数误差均低于AlexNet和VGG-16,表明优化设计的网络结构具有更好的参数利用率。与ResNet-50相比,DCNN与其参数量接近,在MRE指标上,二者在验证集和测试集上的表现也近似。针对测试集,DCNN与ResNet-50相比,MAE和RMSE分别降低19.3%和12.9%。与ResNet-50相比,DCNN具有可变形卷积的优势,且具有更大的感受野,和根据目标调节采样范围的灵活卷积运算,能够提取更有利于稻粒计数的图像特征。DenseNet-121具有最低的参数量和最深的网络深度,但在计数精度上未表现出优势。进一步分析计数模型在用不同CNN作为特征提取骨干网络时的拟合优度,图7为对应的决定系数。

图7 稻粒预测值与实际值的相关性

Fig.7 Correlation between predicted and actual values of rice grains

由图7可知,当采用DCNN作为模型骨干网络时,模型决定系数R2最高,在验证集和测试集上分别为0.919 0和0.940 5,均高于其他4种网络。基于DCNN的模型预测结果与稻粒数量的实际值具有良好的一致性。总体上,DCNN网络能够有效提高稻粒在穗计数的精度。

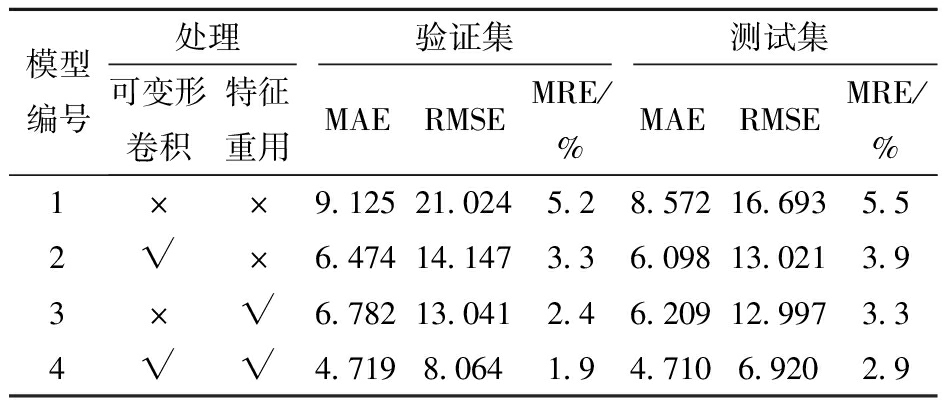

为验证本文稻粒计数模型各组件设计的有效性,在此基础上,通过采用不同处理,构建几种变体模型,分析各组件有效性。本文DCNN采用基于可变形卷积的模块构建,用常规卷积取代可变形卷积来构建DCNN,用其作为模型骨干。FamNet只基于特征相关图预测密度图,本文则将特征图和特征相关图在通道维度连接后,作为密度预测模块的输入,称该处理为特征重用,在另一变体模型中不再采用特征重用,即采用与FamNet相同的密度图预测方法,来分析该处理的有效性。构建了3种变体模型,连同原模型,共4种模型,采用相同的训练和测试方法,结果如表3所示。

表3 不同变体模型的稻粒计数结果对比

Tab.3 Comparison of rice grain counting results of different variant models

模型编号处理验证集测试集可变形卷积特征重用MAERMSEMRE/%MAERMSEMRE/%1××9.12521.0245.28.57216.6935.52√×6.47414.1473.36.09813.0213.93×√6.78213.0412.46.20912.9973.34√√4.7198.0641.94.7106.9202.9

注:√表示采用此处理,×表示不采用此处理。

由表3可知,可变形卷积和特征重用均可有效提高稻粒在穗计数模型的精度。模型2在模型1的基础上,其特征提取网络采用基于可变形卷积的构造块进行设计,网络的其他部分不变。与模型1相比,模型2在验证集上的MAE和RMSE分别降低29.1%和32.7%,MRE则降低1.9个百分点;在测试集上,MAE和RMSE则分别降低28.9%和22.0%,MRE降低1.6个百分点。同时比较模型2与表1中的FamNet,两者的特征提取网络不同,前者各项误差指标均低于后者,其中在测试集上的MRE下降8.9个百分点,进一步表明本文特征提取网络的有效性。可变形卷积的引入有效降低了模型预测误差,表明采用可变形卷积设计模型骨干网络是有效的。相比于常规卷积,可变形卷积能够自适应地建立局部特征间的长程依赖,也能够根据任务需要,通过学习调节感受野形状和局部特征振幅,更利于加强局部稻粒的特征,用于后续计数任务。与模型1相比,模型3在稻粒密度预测模块输入上增加了骨干网络提取特征图,使其在验证集上,MAE和RMSE分别降低25.7%和38%,MRE降低2.8个百分点,在测试集上,MAE和RMSE分别降低27.6%和22.1%,MRE降低2.2个百分点,表明特征重用对提高密度预测模块预测精度具有重要作用,本文对FamNet的处理改进是有效的。模型4为本文全状态模型,同时采用可变形卷积和特征重用,这使其与模型2、3相比,进一步降低了稻粒计数误差。综上,应用可变形卷积设计特征提取网络,并在密度图预测时重用网络提取特征图,对提高模型预测精度均有效。

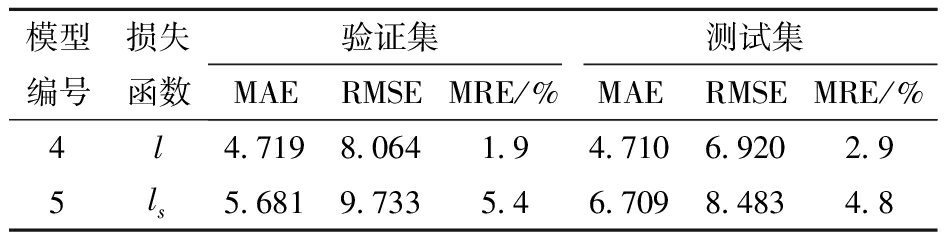

为进一步分析稻粒计数模型所设计损失函数的有效性,用相同的DCNN作为骨干网络构建2种模型,如表4所示。模型4为本文全状态模型,采用损失函数l作为训练目标,模型5仅使用均方误差损失ls,即模型5中未包含范本标注框计数损失。

表4 不同损失函数稻粒计数结果对比

Tab.4 Comparison of rice grain counting results applying different loss functions

模型编号损失函数验证集测试集MAERMSEMRE/%MAERMSEMRE/%4l4.7198.0641.94.7106.9202.95ls5.6819.7335.46.7098.4834.8

由表4可知,模型4计数精度高于仅采用均方误差的模型5。模型4在模型5的基础上,引入范本标注框计数损失lm,在验证集上使模型4 MAE、RMSE分别降低16.9%和17.1%,MRE降低3.5个百分点,在测试集上的MAE和RMSE则分别降低29.8%和18.4%,MRE降低1.9个百分点。范本标注框计数损失充分应用了范本稻粒标注信息,该损失项可激励计数模型在遮挡区域生成高密度分布,降低因遮挡引入的计数误差。总体上,在均方误差基础上,引入范本标注框计数损失有效。

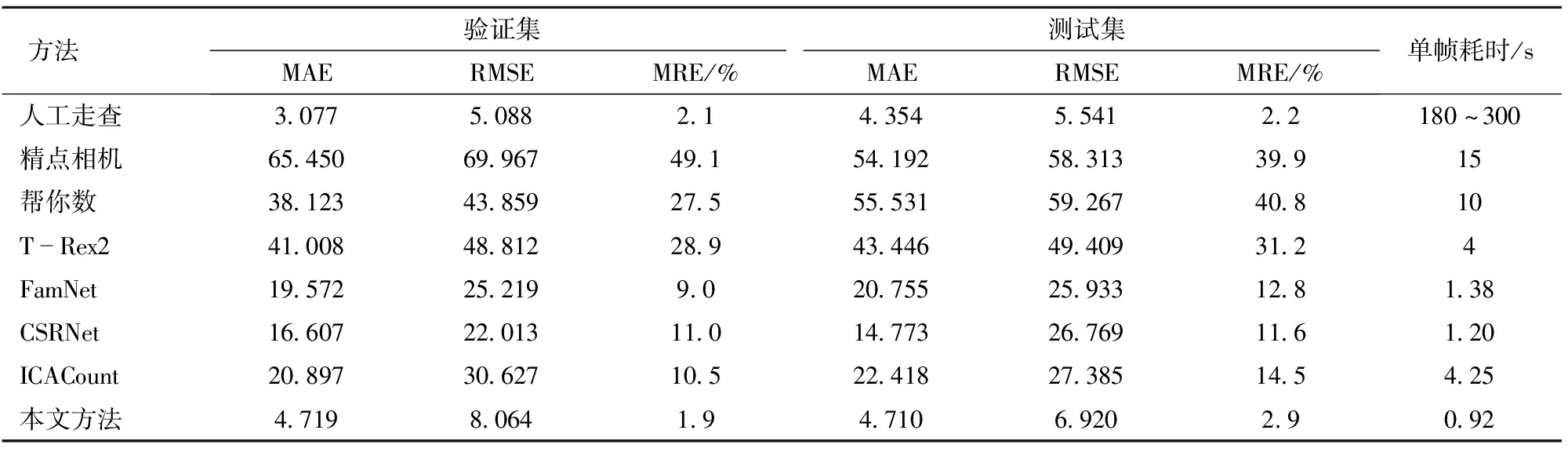

用本文模型预测稻穗图像测试集中部分样本的密度图,同时用2.4.1节方法,根据样本的点标注生成对应的真实密度图,转换成热力图后进行可视化,结果如图8所示。图8第3行为稻穗图像和模型预测密度图叠加结果,可看出,模型有效地预测了图像上稻粒分布,其高密度区域均与稻粒区域重合,稻粒区域密度分布也表现出了由稻粒近中心位置向周边逐渐降低的趋势。同时由第2行也可看出,每个稻粒密度分布范围之间存在一定的界限,这可能会为基于密度图的稻粒分割提供一定线索,值得进一步研究。同时,由第1行和第2行的对比可以看出,稻粒在穗计数模型基于输入稻穗图像预测的稻粒数与真实稻粒数之间较接近,模型可用于稻粒在穗计数。

图8 稻粒密度图示例

Fig.8 Examples of rice grain density map

(1)将稻粒原位计数视为密度预测问题,提出一种稻粒在穗计数模型,设计可变形卷积神经网络提取稻穗图像特征,基于图像特征和少量选取的稻粒范本特征和图像特征的相关性,预测稻粒密度分布。模型具有较高的稻粒在穗计数精度,在测试样本上的MAE和RMSE分别为4.71和6.92,MRE为2.9%,仅比人工走查方式高0.7个百分点。

(2)与现有基准方法FamNet、CSRNet和ICACount相比,本文方法MRE分别降低9.9、8.6、11.6个百分点,具有较高的计数精度,单幅稻穗图像处理时间为0.92 s,可有效提高工作效率。

(3)基于可变形卷积设计的稻穗图像特征提取骨干网络能够有效提高稻粒计数精度,在参数量接近的前提下,该网络MAE和RMSE比ResNet-50分别低19.3%和12.9%,具有良好的拟合能力,决定系数R2达0.940 5。

(4)相同网络架构下,可变形卷积比常规卷积稻粒计数MAE和RMSE分别降低28.9%和22.0%,MRE下降1.6个百分点;特征重用对提高预测精度具有重要作用,在测试集上使模型MAE和RMSE下降27.6%和22.1%,MRE下降2.2个百分点;引入的范本标注框计数损失能有效提高计数精度,在测试集上使模型MAE和RMSE下降29.8%和18.4%,MRE降低1.9个百分点。可为稻穗表型检测和平台设计提供技术参考。

[1] 国家统计局.年度数据[EB/OL].[2024-03-20].https:∥data.stats.gov.cn/easyquery.htm?cn=C01.

[2] NEELAMEGAM P,ABIRAMI S,PRIYA K V,et al.Analysis of rice granules using image processing and neural network[C]∥IEEE Conference on Information &Communication Technologies,2013:879-884.

[3] 梁文东,蒋益敏.基于MATLAB的玉米果穗颗粒统计方法[J].江苏农业科学,2015,43(2):406-408.LIANG Wendong,JIANG Yimin.A MATLAB-based method for corn cob grain statistics[J].Jiangsu Agricultural Sciences,2015,43(2):406-408.(in Chinese)

[4] LIU Tao,CHEN Wen,WANG Yifan,et al.Rice and wheat grain counting method and software development based on Android system[J].Computers and Electronics in Agriculture,2017,141:302-309.

[5] WU Wenhua,ZHOU Lei,CHEN Jian,et al.GainTKW:a measurement system of thousand kernel weight based on the Android platform[J].Agronomy,2018,8(9):178.

[6] 许杰,周子力,潘大宇,等.水稻穗部籽粒参数快速无损获取方法研究[J].计算机工程与应用,2017,53(8):203-208.XU Jie,ZHOU Zili,PAN Dayu,et al.Study on fast and nondestructive method of rice grain parameters acquisition of rice panicle[J].Computer Engineering and Applications,2017,53(8):203-208.(in Chinese)

[7] 陈孟燕,王敏娟,宋青峰,等.基于ECA-FV-CNN的水稻单籽粒质量分级方法[J].农业机械学报,2023,54(增刊2):235-243.CHEN Mengyan,WANG Minjuan,SONG Qingfeng,et al.Method for single rice grain weight grading based on ECA-FV-CNN[J].Transactions of the Chinese Society for Agricultural Machinery,2023,54(Supp.2):235-243.(in Chinese)

[8] 马志宏,贡亮,林可,等.基于稻穗几何形态模式识别的在穗籽粒数估测[J].上海交通大学学报,2019,53(2):239-246.MA Zhihong,GONG Liang,LIN Ke,et al.Estimation of panicle seed number based on panicle geometric pattern recognition[J].Journal of Shanghai Jiaotong University,2019,53(2):239-246.(in Chinese)

[9] YU Lejun,SHI Jiawei,HUANG Chenglong,et al.An integrated rice panicle phenotyping method based on X-ray and RGB scanning and deep learning[J].The Crop Journal,2021,9(1):42-56.

[10] 杨万里,段凌凤,杨万能.基于深度学习的水稻表型特征提取和穗质量预测研究[J].华中农业大学学报,2021,40(1):227-235.YANG Wanli,DUAN Lingfeng,YANG Wanneng.Deep learning-based extraction of rice phenotypic characteristics and prediction of rice panicle weight[J].Journal of Huazhong Agricultural University,2021,40(1):227-235.(in Chinese)

[11] 王栋,陈佳玮,沈利言,等.基于图像的水稻穗粒相关性状智能检测算法研究[J].植物生理学报,2022,58(5):957-971.WANG Dong,CHEN Jiawei,SHEN Liyan,et al.The development of a vision-based phenotypic analysis algorithm for measuring spikelet-related traits in rice[J].Plant Physiology Journal,2022,58(5):957-971.(in Chinese)

[12] 徐胜勇,李磊,童辉,等.基于RGB-D相机的黄瓜苗3D表型高通量测量系统研究[J].农业机械学报,2023,54(7):204-213,281.XU Shengyong,LI Lei,TONG Hui,et al.High-throughput measurement system for 3D phenotype of cucumber seedlings using RGB-D camera[J].Transactions of the Chinese Society for Agricultural Machinery,2023,54(7):204-213,281.(in Chinese)

[13] 刘庆华,杨欣仪,接浩,等.基于融合GhostNetV2的YOLO v7水稻籽粒检测[J].农业机械学报,2023,54(12):253-260,299.LIU Qinghua,YANG Xinyi,JIE Hao,et al.Rice grain detection based on YOLO v7 fusing of GhostNetV2[J].Transactions of the Chinese Society for Agricultural Machinery,2023,54(12):253-260,299.(in Chinese)

[14] RANJAN V,SHARMA U,NGUYEN T,et al.Learning to count everything[C]∥2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR),2021:3393-3402.

[15] GIRSHICK R.Fast R-CNN[C]∥2015 IEEE International Conference on Computer Vision (ICCV),2015:1440-1448.

[16] HE Kaiming,ZHANG Xiangyu,REN Shaoqing,et al.Deep residual learning for image recognition[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR),2016:770-778.

[17] DAI Jifeng,QI Haozhi,XIONG Yuwen,et al.Deformable convolutional networks[C]∥2017 IEEE International Conference on Computer Vision (ICCV),2017:764-773.

[18] WANG Weihai,DAI Jifeng,CHEN Zhe,et al.InternImage:exploring large-scale vision foundation models with deformable convolutions[C]∥2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR),2023:14408-14419.

[19] KRIGHEVSKY A,SUTSKEVER I,HINTON G E.ImageNet classification with deep convolutional neural networks[J].Communications of the ACM,2017,60(6):84-90.

[20] VASWANI A,SHAZEER N,PARMAR N,et al.Attention is all you need[C]∥ Thirty-first Annual Conference on Neural Information Processing Systems (NIPS 2017),2017:5998-6008.

[21] BA J L,KIROS J R,HINTON G E.Layer normalization[EB/OL].[2016-07-21].https:∥arxiv.org/abs/1607.06450.

[22] HENDRYCKS D,GIMPEL K.Bridging nonlinearities and stochastic regularizers with gaussian error linear units[EB/OL].[2023-06-06].https:∥arxiv.org/abs/1606.08415.

[23] LIU Zhuang,MAO Hanzi,WU Chaoyuan,et al.A convnet for the 2020s[C]∥2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR),2022:11966-11976.

[24] DENG Jia,DONG Wei,SOCHER R,et al.ImageNet:a large-scale hierarchical image database[C]∥2009 IEEE Conference on Computer Vision and Pattern Recognition,2009:248-255.

[25] ZHANG Yingying,ZHOU Desen,CHEN Siqin,et al.Single-image crowd counting via multi-column convolutional neural network[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR),2016:589-597.

[26] 谢勤岚.图像降噪的自适应高斯平滑滤波器[J].计算机工程与应用,2009,45(16):182-184.XIE Qinlan.Adaptive Gaussian smoothing filter for image denoising[J].Computer Engineering and Applications,2009,45(16):182-184.(in Chinese)

[27] JIANG Qing,LI Feng,ZENG Zhaoyang,et al.T-Rex2:towards generic object detection via text-visual prompt synergy[EB/OL].[2024-03-21].https:∥arxiv.org/abs/2403.14610.

[28] LI Yuhong,ZHANG Xiaofan,CHEN Deming,et al.CSRNet:dilated convolutional neural networks for understanding the highly congested scenes[C]∥2018 IEEE Conference on Computer Vision and Pattern Recognition (CVPR),2018:1091-1100.

[29] HUANG Yifeng,RANJAN V,HOAI M,et al.Interactive class-agnostic object counting[C]∥Proceedings of the IEEE/CVF International Conference on Computer Vision (ICCV),2023:22312-22322.

[30] 精典相机.人工智能点数应用[EB/OL].[2024-04-28].https:∥counting.movingshop.cn/.

[31] 腾讯应用宝.帮你数[EB/OL].[2024-04-28].https:∥sj.qq.com/appdetail/com.iseely.detect.

[32] SIMONYAN K,ZISSERMAN A.Very deep convolutional networks for large-scale image recognition[C]∥3rd International Conference on Learning Representations (ICLR 2015),2015:1409-1556.

[33] HUANG Gao,LIU Zhuang,VAN DER MAATEN L,et al.Densely connected convolutional networks[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR),2017:4700-4708.