福建省是食用菌生产大省,其中漳州杏鲍菇产量占全国50%以上[1]。食用菌栽培工艺复杂、劳动强度高,发展机械化代替人工生产是食用菌产业发展的必然趋势[2]。近年来,随着劳动力减少、科技水平提高,“智慧菇房”装备日益引起重视。智慧菇房可以实现食用菌栽培过程中的智能化管理。目前,智慧菇房能实现菇房内温度、相对湿度等环境参数的控制[3-6],但缺乏动态监测系统和智能识别系统,食用菌生长状态仍然靠人工巡检获取[1]。为了提高智慧菇房自动化能力,实时掌握食用菌生长状态,自动获取菇房内食用菌表型参数极为重要。

表型参数是指描述生物体外在形态、生理功能以及其他可以直接观察到或测量到的特征数据,可以直接反映食用菌对菇房环境的响应。在表型参数测量中,许多工作基于二维图像展开[7]。然而,二维图像擅长于处理颜色、纹理等特征信息,却缺少对体积、厚度等具有深度的信息的处理手段。因此,许多研究者在三维技术的基础上开展表型参数测量工作[8-15]。

但是,上述方法都是在拥有良好的视野、完整的点云获取角度下进行的,而在光照强度低、空间狭小、杏鲍菇生长密集的菇房内,可操作空间仅为过道区域。在此情况下对杏鲍菇进行点云拍摄时容易丢失仰视视角从而造成杏鲍菇底部点云数据缺失。针对点云数据缺失的问题,许多研究者在深度学习技术的基础上提出PCN[16]、FoldingNet[17]、PoinTr[18]、AdaPoinTr[19]、SnowFlakeNet[20]等模型[21-23],完成了对残缺点云修补,并取得了良好效果。文献[24-25]证明了在点云残缺情况下点云补全对提高表型参数测量精度的有效性,但仍仅聚焦于叶片面积、宽度等表型参数测量,未考虑诸如杏鲍菇等三维立体事物的补全和体积等表型参数测量,模型性能还有待提升。

针对菇房内由于视角受限而导致杏鲍菇点云残缺的问题,本文提出一种SwinPoinTr模型。该方法首先实现对输入点云特征的提取并编制成多维图像块。然后由编解码模块和重建模块完成对点云特征的编码、解码和重建。最后通过泊松重建算法对补全后的点云进行表面重建实现由离散点云到模型的转换,并据此模型测得杏鲍菇表型参数。

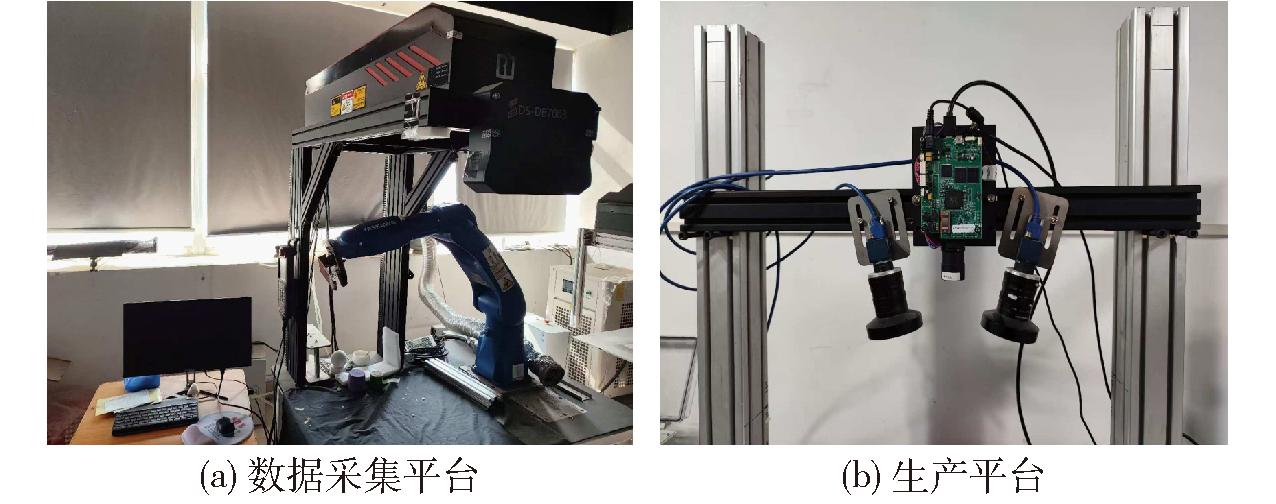

为完成对残缺点云的补全,模型需要分析总结大量完整点云的特征,所以三维扫描平台需要具备获取完整点云的能力。然而,菇房内无法提供采集完整点云的理想环境,故搭建数据采集平台和生产平台,如图1所示。数据采集平台用于采集杏鲍菇完整点云,构建杏鲍菇数据库。其由结构光双目相机与机械臂组成,通过机械臂将杏鲍菇摆动不同位姿完成杏鲍菇完整点云的采集,能满足拍摄杏鲍菇点云所需要的全部视角,且杏鲍菇扫描精度可达0.1 mm。生产平台结构简单、移动便捷,主要用于菇房内杏鲍菇的扫描。它由结构光双目相机与滑轨基座组成,通过滑动实现对菇房内杏鲍菇的逐行扫描,用于采集菇房内杏鲍菇顶部两个视角的点云。本文以数据采集平台所构建的杏鲍菇数据库为基础,将其作为先验知识用于模型训练。待模型训练完成后,利用该模型对生产平台在菇房内扫描获取的残缺点云进行补全操作,从而完成获取菇房内杏鲍菇完整点云的工作。

图1 数据采集与生产平台

Fig.1 Data collection and production platform

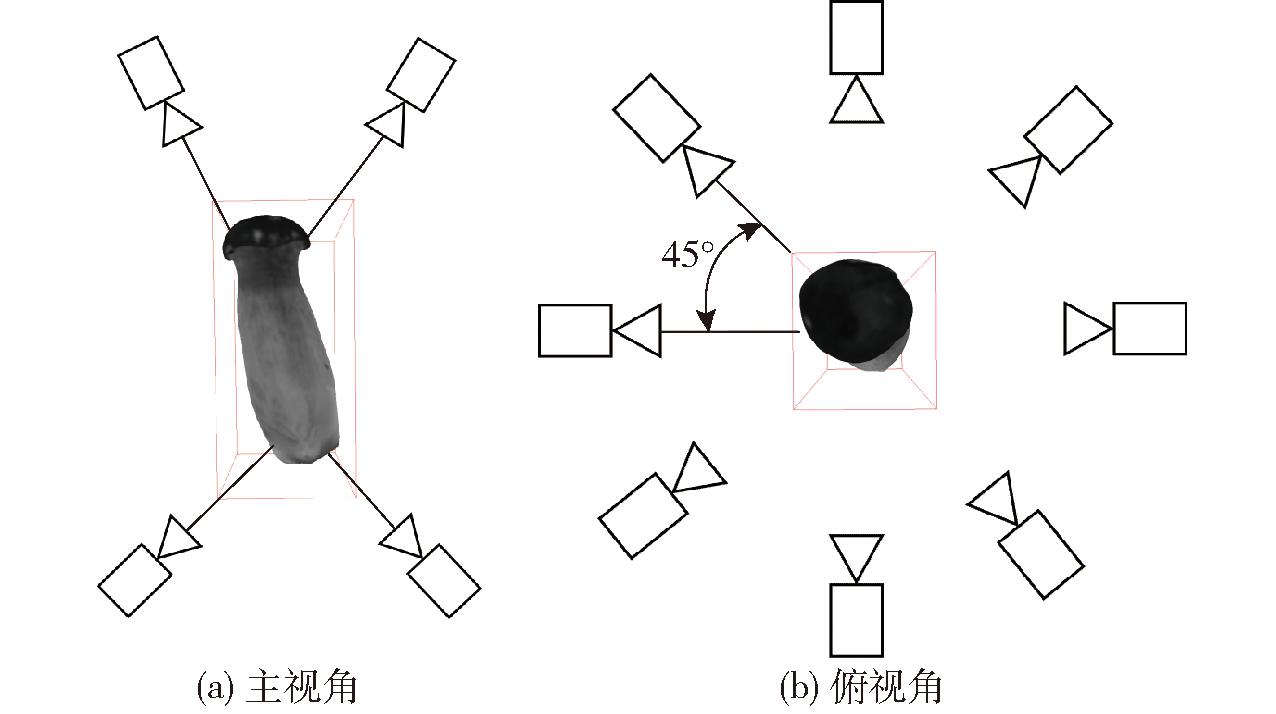

鉴于菇房内常为弱光环境,可采用自带光源的结构光三维重建方法[26]。使用数据采集平台,对目标物进行多视角扫描以获取完整点云。图2为数据采集平台采集视角示意图。其中,侧面拍摄由8个视角组成,每个视角相隔45°,顶部与底部分别安排2个视角,总共为12个视角。

图2 采集视角示意图

Fig.2 Schematic of acquisition perspective

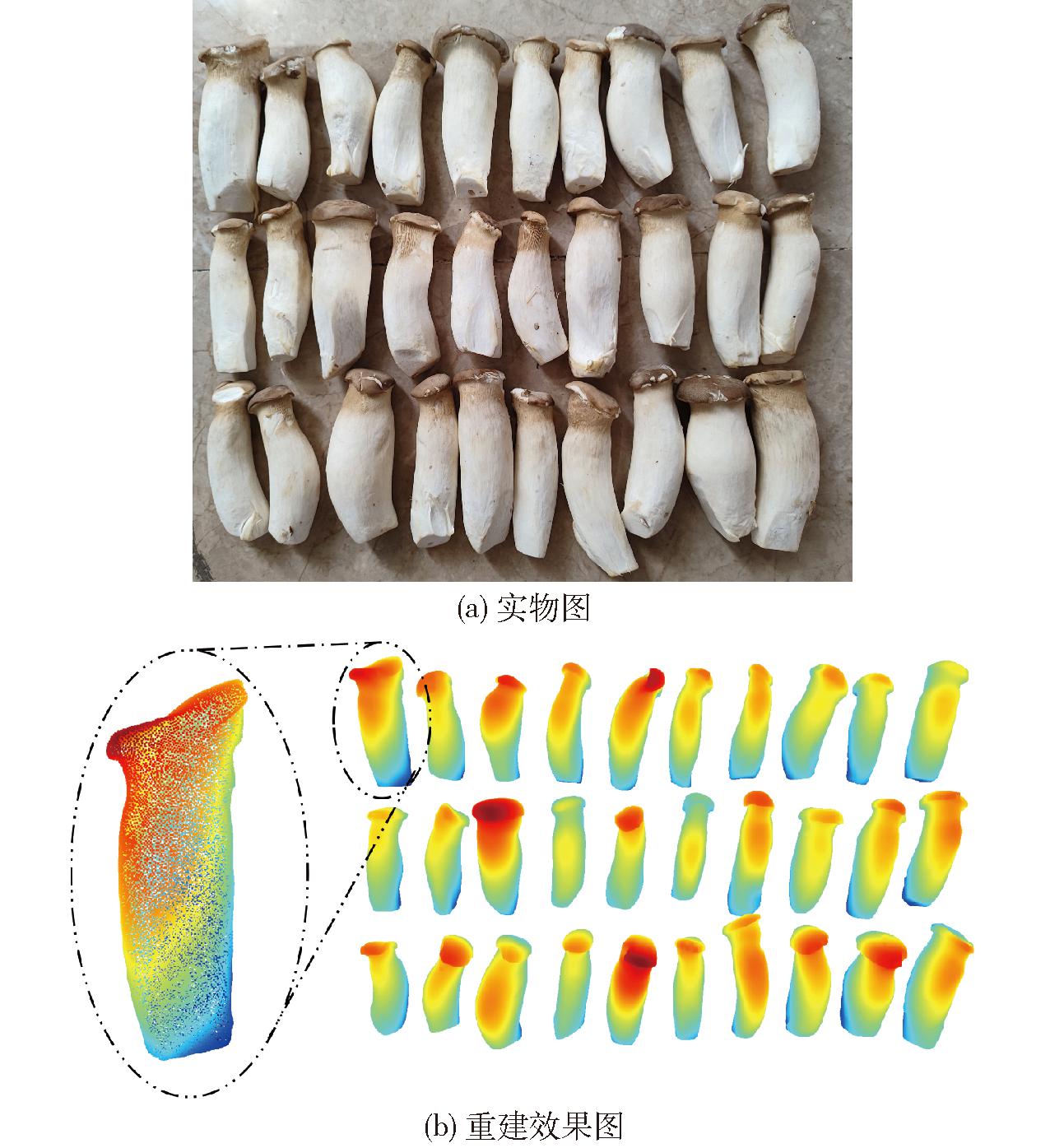

采用“一次配准”的方法,制作类杏鲍菇的标记物并贴上标记点。预设的标记点可有效加快算法的运行速度和提高算法精度。由迭代最近点(Iterative closest point,ICP)算法[27]以第1个视角为基准视角逐一匹配标记点,并计算旋转矩阵和平移矩阵,最终得到各自视角相对基准视角的转换矩阵。在相机相对位置不变的情况下,之后各视角成像点云只需乘以转换矩阵即可完成点云数据对齐工作。图3为杏鲍菇实物和重建效果图。

图3 部分杏鲍菇实物和重建效果图

Fig.3 Partial photographs of actual Pleurotus eryngii and reconstruction renderings

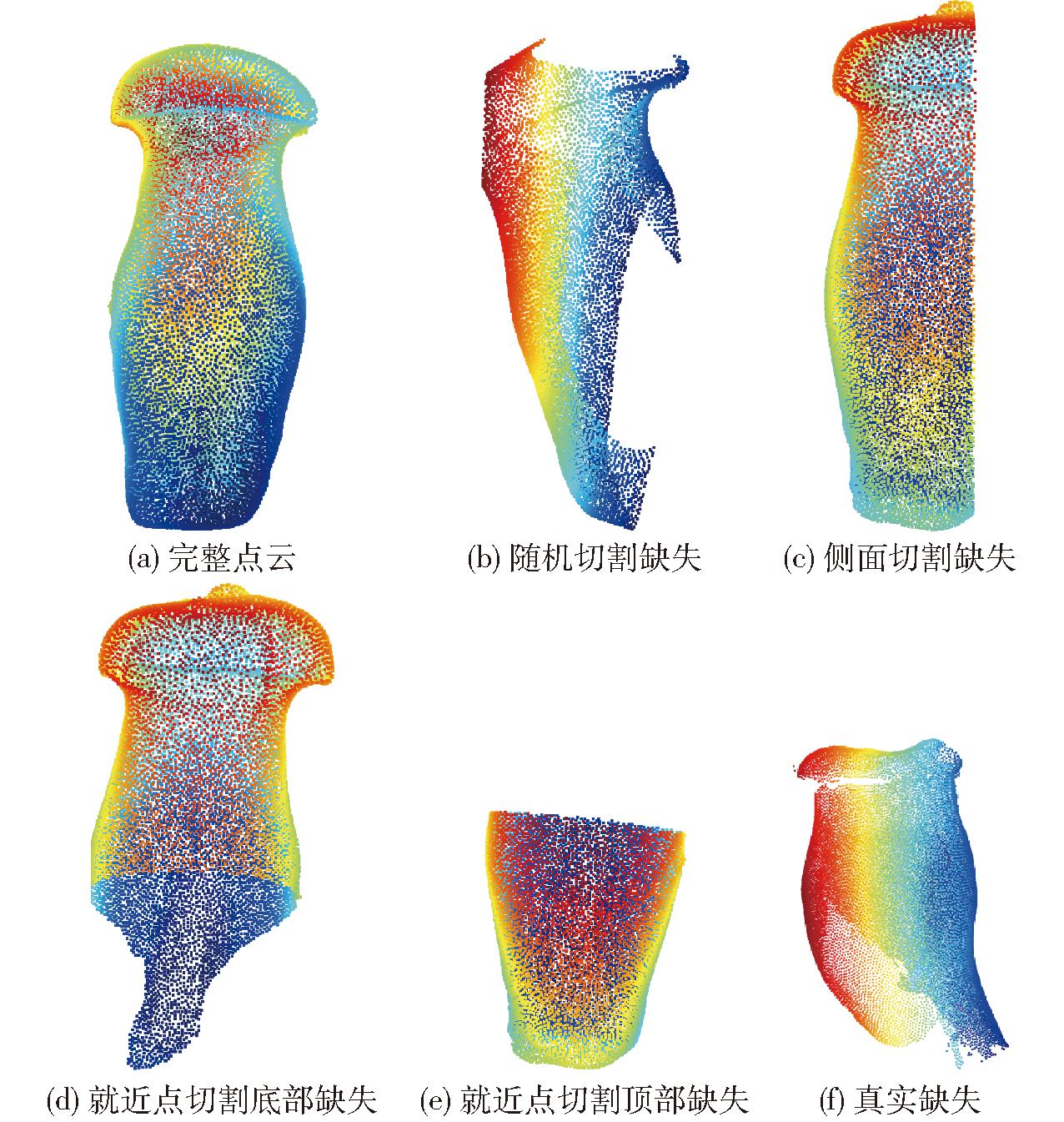

利用前述三维重建方法获得完整杏鲍菇点云246个,切割后得到4 920个残缺点云,其中3 920个作为训练集,600个作为测试集,400个作为验证集,每一个样本由一个残缺点云与其对应的完整点云组合而成。对点云进行去噪处理并删除离群点,采用最远点采样法(Farthest point sampling,FPS)将点云下采样至固定点数。将每个点云进行归一化处理,将坐标值缩放至[-0.5,0.5]区间内,使得模型更容易提取出点云的关键特征。为提高模型对不同缺失特征的学习,分别使用随机切割、侧面切割、就近点切割对完整点云进行20次切割,点云切割策略如图4所示。

图4 点云切割策略图

Fig.4 Point cloud segmentation strategy diagrams

其中,图4a为完整点云图;图4b为随机切割得到的结果,可获得4个点云,具有较强的随机性且切割程度较大,可以提高模型泛化能力;图4c为侧面切割结果,该方法可获得6个点云,可在不同点云侧面轴上以不同深度对点云进行切割,提高了模型对实际拍摄情况的补全能力。就近点切割方法为在完整点云上使用最远点采样方法获取10个点,然后以这10个点为基点使用就近点采样并切除,此种切割方法能构造不同的缺失特征,提高模型的补全能力。图4d为由就近点采样构造的底部缺失结果;图4f为真实缺失情况,其由生产平台使用双视角拍摄而成,主要表现形式为底部缺失。同样,由于菌盖遮挡,菌盖下面一部分也会存在缺失。

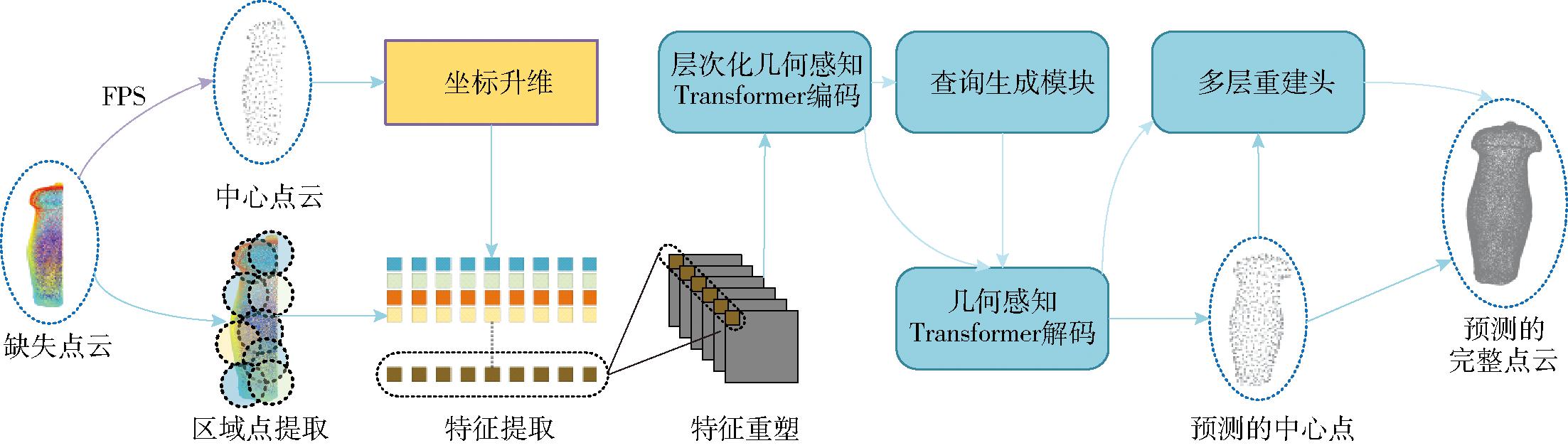

PoinTr[18]是一种经典的点云补全算法,其以DGCNN算法[22]提取点云特征,vision Transformer[28]算法完成特征的编解码,FoldingNet[17] 算法完成点云的重建。然而,以vision Transformer算法作为编解码模块在处理局部特征时效果较差,容易忽略图像中的局部细节,并且,该模块需要对所有图像块进行全局自注意力计算,导致计算复杂度较高,严重限制了输入点云大小。针对这两个问题,提出了一种基于移位窗口的多层次Transformer杏鲍菇点云补全网络模型SwinPoinTr,其流程图如图5所示。

图5 杏鲍菇点云补全网络模型流程图

Fig.5 Point cloud completion network for Pleurotus eryngii

该网络以残缺的杏鲍菇点云为输入,首先使用最远点采样得到残缺点云特征点,并以这些特征点为中心进行区域点提取。得到区域点集后送入特征提取模块计算得到区域点集的特征集,同时坐标升维模块将XYZ坐标点映射至高维空间得到高维坐标点集。点集相加后输入特征编制模块进行特征层次化构造,再由层次化构造Transformer模块进行编码与特征提取,然后与查询生成模块生成的动态查询子一同输入到解码器中。最后由多层重建头完成完整点云预测。

1.3.1 特征提取与重塑

单独的点云坐标仅能描述各点在空间中的位置信息,而无法直接反映点与点之间的特征关系[29-30]。若直接将点坐标作为网络输入,则网络难以有效捕捉点云数据中的局部特征关系与全局特征关系,并且若网络直接以输入数据作为处理数据,则网络训练负担过重。为了解决这个问题,所提出的模型先对输入点云数据进行最远点采样,得到N个点,并以这N个点为中心使用k近邻算法(k-nearest neighbors,k-NN)[31],构建其边关系并确定局部区域。再使用具有分层下采样结构的轻量级动态图卷积神经网络(Dynamic graph convolutional neural network,DGCNN)[22]获取点中心局部特征。同时,通过坐标升维模块对中心点坐标全局位置进行显式编码,并与中心点局部特征相加,完成全局特征与局部特征结合,得到特征序列集{T1,T2,…,TN}。

为了使计算得到的点云特征适用于移位窗口编码器的输入,需要对特征序列集数据形状进行重塑。首先根据中心点数确定窗口大小,然后将每一个特征序列Ti切分为长度相等的小块,最后各个序列的小块在不同维度按窗口大小进行对应位置拼接,得到多维点云特征图。

1.3.2 Transformer编解码模块

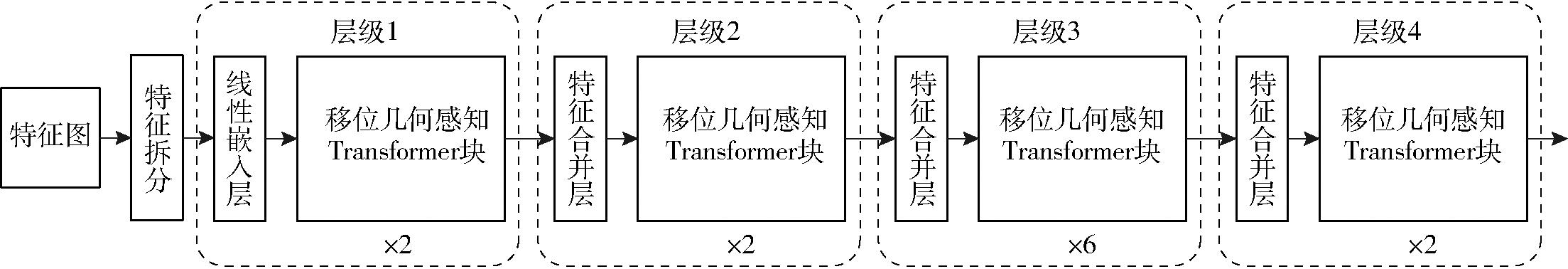

尽管Transformer通过自注意力机制能够捕捉长距离依赖关系,但同样在计算自注意力时需要储存大量的中间矩阵,特别是在处理长序列时内存的消耗将变得难以接受。这种特性将导致输入网络的点数极其有限,网络难以学习到输入点云的全部特征,特别是在更复杂的点云模型中,这种情况将更为明显。为了解决这个问题,基于移位窗口方案提出了具有层次化构造的几何感知Transformer编码模块,该模块可以在高效提取点云几何特征的同时,逐层减小特征图大小,减轻内存开销,有利于对复杂点云模型处理。其流程如图6所示。

图6 层次化构造几何感知Transformer模块流程图

Fig.6 Hierarchical geometric-aware Transformer module workflow diagram

在该流程中,特征拆分模块将特征重塑得到的特征图拆分为非重叠等尺寸的小块,对应位置拆分的小块拼接并展平为序列。线性嵌入层将输入的数据投影到一个固定的维度,将输入数据进行规范化,确保输入特征具有相似的尺度,利于后续层的学习。特征合并层在每个窗口中将相邻小块拼接,使得特征图的空间尺寸减小,有助于模型捕获更高层次抽象特征。同时,特征合并层会增加特征图通道数,用于容纳更多的抽象信息。

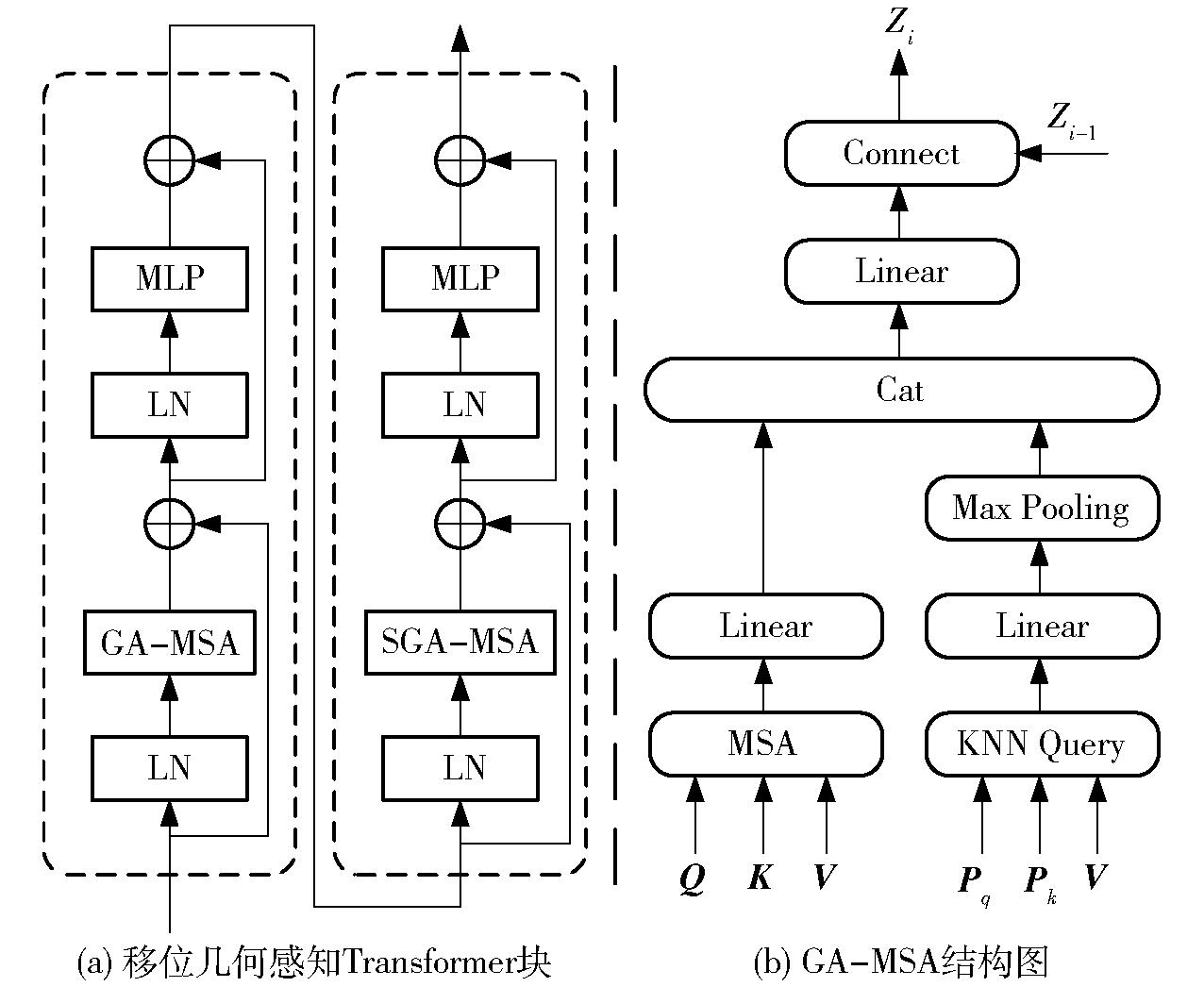

移位几何感知Transformer块在非重叠的局部窗口中计算具有几何感知的注意力,其流程如图7a所示。一个完整的移位几何感知Transformer块主要由两部分构成,第1部分在窗口内进行几何感知注意力计算,第2部分将窗口平移,进行跨窗口的几何感知注意力计算。在第1部分中,点云数据先进行层规范化(Layer normalization,LN),再由几何感知多头自注意力层(Geometry aware-multi head self attention,GA-MSA)计算几何感知注意力,并与输入数据相加,其计算公式为

Zi=GAMSA(LN(Zi-1))+Zi-1

(1)

图7 移位几何感知Transformer块结构图

Fig.7 Shifted geometric-aware Transformer blocks

式中,GAMSA为计算几何感知多头自注意力,LN为层规范化,Zi-1为输入数据,Zi为计算后数据。

几何感知多头自注意力层结构如图7b所示。首先将输入数据进行线性投影生成Q、K、V矩阵,再输入多头自注意力层(Multi head self attention,MSA)。Q矩阵为查询矩阵,K矩阵为键矩阵,V矩阵为值矩阵,多头自注意力层首先将Q矩阵与K矩阵相乘进行相似度计算,然后将相似度计算结果与V矩阵进行加权匹配,完成对不同特征提取。多头自注意力计算公式为

(2)

式中,dk为缩放因子,用于防止softmax函数输入值过大而导致梯度消失。

单独的多头自注意力机制缺少一些归纳偏差[32],不能很好地对点云结构进行建模。为了便于模型更好地利用点云几何结构的感应偏差,几何感知多头自注意力层在计算自注意力的同时,利用k近邻算法捕捉点云关键特征,并与自注意力计算结果结合,构成具有几何感知能力的自注意力计算机制。

在得到Zi并再次进行层规范化后,再由多层感知机(Multi-layer perceptron,MLP)完成对提取特征的线性变换,捕捉不同特征之间的关系,得到Zi+1。并将Zi+1与Zi相加,完成第1部分的特征提取。第1部分在各自的窗口内计算注意力,虽然减小了注意力的计算量,但同时也限制了模型跨窗口之间的联系与交流。于是,移位窗口方法在特征图上将窗口整体平移,并将伸出部分剪切填充,构造为新的窗口,再结合几何感知多头自注意力层形成具有移位窗口的几何感知多头自注意力层(Shifted windows geometry aware-multi head self attention,SGA-MSA)。第2部分将注意力计算模块替换为具有移位窗口的几何感知多头自注意力层,在第1部分的基础上再次进行计算,完成特征的编码。

在完成对点云数据的编码并提取到特征图后,将其送入动态查询模块。动态查询模块在接收到输入后,先使用线性层将数据投影到更高的维度,然后对这些高维数据进行最大池化操作获取编码特征,再使用MLP层将这些编码特征重建为查询向量,与特征图一同送入几何感知Transformer解码模块,完成对完整点云中心点的预测。最后将解码特征和预测的中心点输入到多层重建头模块,分别恢复中心点局部区域的点云,从而完成全分辨率下点云的补全与重建。

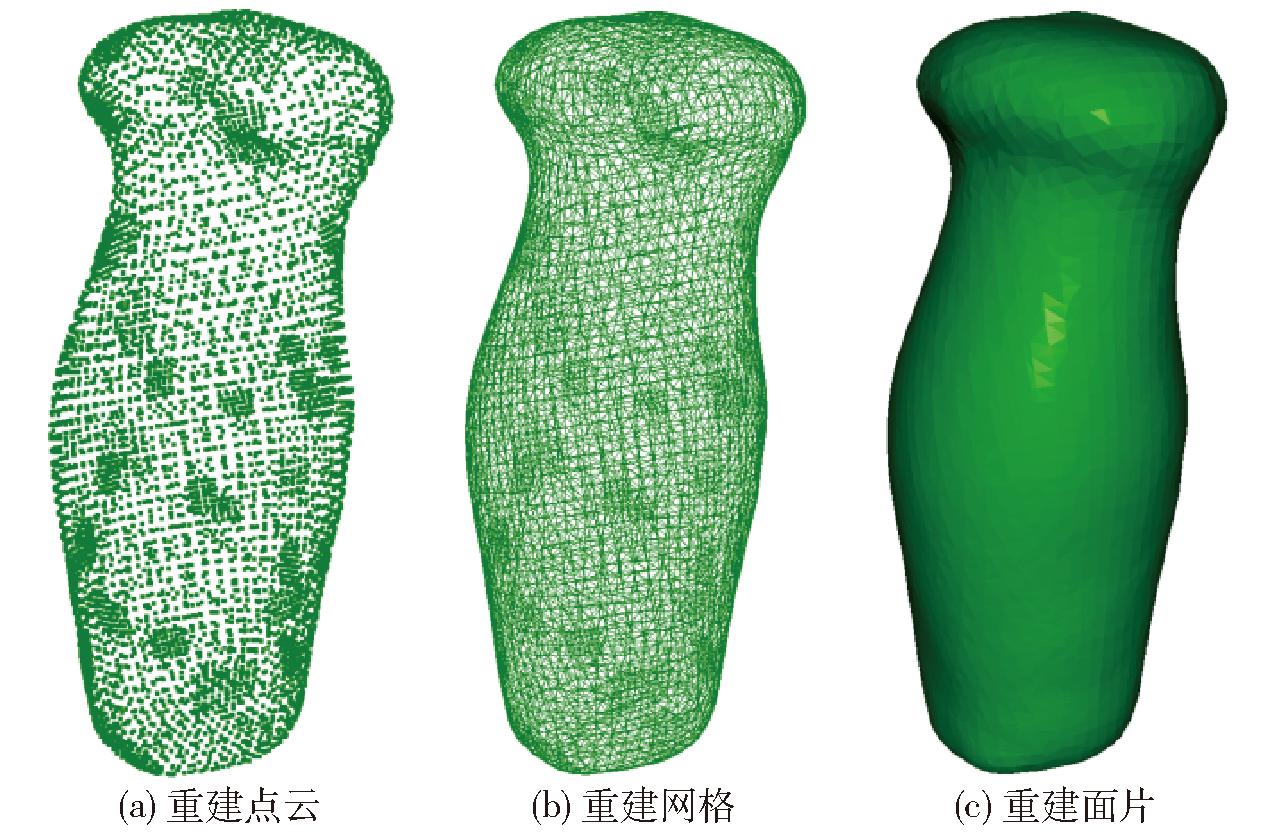

杏鲍菇点云在补全后,原本缺失的位置生成的点云会较为稀疏且含有噪声,所以本文使用基于泊松表面重建[33]的隐式重建方法进行点云数据处理和表面重建。泊松表面重建具有极强的噪声处理能力,并且能生成平滑且闭合的表面,其重建流程为:

(1)法向量计算:使用主成分分析法(Principal component analysis,PCA)为点云中的每个点估计法线方向。

(2)构建梯度场:使用八叉树法将空间划分为多个子立方体,并将每个点的法线向量分配到其所在的叶节点中,为所有节点设置基函数G,这些函数的线性和可以表示向量场Φ。

(3)创建向量场:使用三次条样差值(三线差值)方法,用向量场Φ逼近指示函数梯度。

(4)求解泊松方程:构建并求解泊松方程,得到指示函数。泊松方程形式为

(3)

式中 Δχ——向量场散度

![]() 拉普拉斯算子

拉普拉斯算子

χ——指示函数

(5)提取等值面:从指示函数中提取零等值面,生成多边形网格。

经过以上步骤获得的杏鲍菇点云重建效果如图8所示。

图8 杏鲍菇三维重建过程

Fig.8 3D reconstruction process of Pleurotus eryngii

重建后面片模型由一系列三角形面片构成。通过分别计算每个三角形面片面积,并将这些面积累加,最终能够获得整个模型的总表面积。同理,将模型分解为多个小的多面体单元(如四面体),分别计算每个单元体积,然后将这些体积累加,可以得到整个模型总体积。

模型训练在Windows 10操作系统下完成,使用CPU为Intel Core i9-10900K,主频为3.7 GHz,GPU为NVIDIA GeForce RTX2080 Super。深度学习环境为Python 3.10.0、CUDA 11.8、Pytorch 2.2.2、Open3d 0.18.0。

模型训练迭代次数(Epoch)为150,初始学习率为0.000 1,每21步更新一次,学习率按衰减因子0.9逐渐衰减,直至最小学习率为0.000 002。

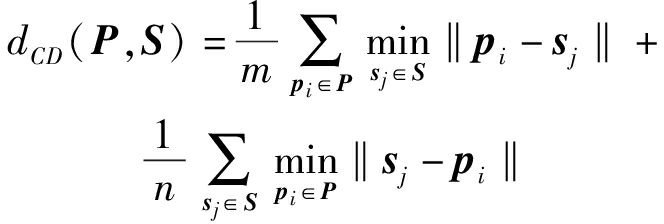

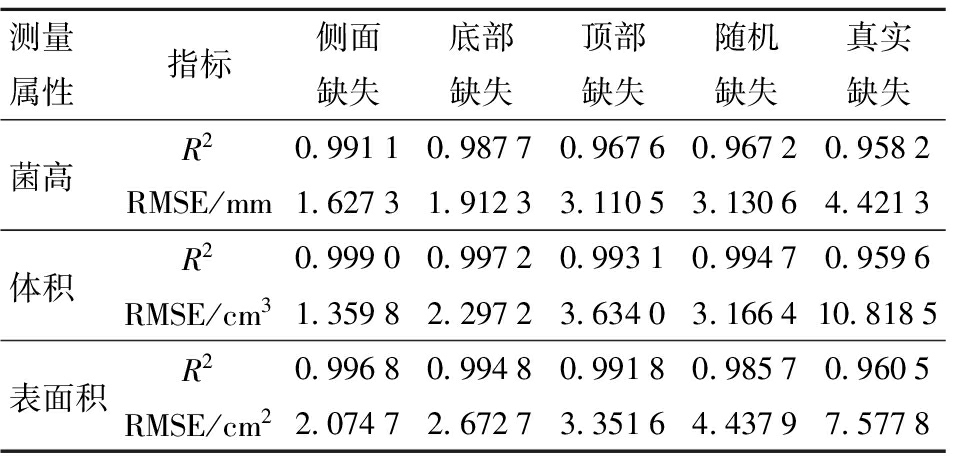

以倒角距离(Chamfer distance,CD)、地球移动距离(Earth mover’s distance,EMD)、F1分数(F1 score)作为模型评估指标。倒角距离是一种用于度量两个点云之间相似性的方法,通过计算两个点云中每个点到另一个点云中最近点距离来衡量它们的相似性,其计算公式为

(4)

式中,P和S表示给定的两个点云,其中P包含点集{p1,p2,…,pm},S包含点集{s1,s2,…,sn},m、n分别为P、S点集中点个数,‖pi-sj‖表示点pi和点sj之间的欧氏距离。

地球移动距离通过计算将一个点云中所有的点移动到另一个点云中所需要的最小距离,来衡量两个点云相似性。其计算公式为

(5)

F1分数综合考虑精确率和召回率,计算重建点云与真实点云一定距离内的百分比,表示重建准确性。

倒角距离越小,表示输出点云更接近杏鲍菇表面,能反映出点云形状的完整性和边缘轮廓的平滑状态。地球移动距离越小,表明补全网络输出的每个空间点,均能与完整点云的点云位置以较小距离两两配对,这体现了点云分辨率与稠密程度具有相似性。

为了评估SwinPoinTr对残缺杏鲍菇点云的补全性能,将本模型与具有代表性的模型(FoldingNet[17],GRNet[34],PCN[16],PoinTr[18],SnowFlakeNet[20],AdaPoinTr[21],TopNet[35])进行对比试验。各模型保持原有的最佳超参数设定,在本文所制作的数据集上训练并且验证。这几种方法在杏鲍菇点云数据集上的补全结果如表1所示。

表1 不同模型对残缺杏鲍菇点云补全结果

Tab.1 Point cloud completion results of incomplete Pleurotus eryngii using different models

模型倒角距离地球移动距离F1分数/%FoldingNet[17]3.618×10-444.333162.01PCN[16]3.907×10-437.750462.56TopNet[35]2.885×10-434.006866.13GRNet[34]4.198×10-432.135569.72PoinTr[18]1.800×10-423.893484.09AdaPoinTr[19]1.420×10-422.713887.14SnowFlakeNet[20]1.504×10-423.645287.23SwinPoinTr1.316×10-421.328287.87

分析表1可知,相对于其他模型,本文提出的SwinPoinTr模型在完成残缺杏鲍菇补全任务中,其倒角距离、地球移动距离和F1分数3个指标都有提升。这表明SwinPoinTr模型能够更好地学习到点云的全局特征和局部特征,不仅能够更准确地补全点云的缺失部分,提高几何精度,而且在补全的完整性和准确性方面也优于其他模型,展现其更强的鲁棒性和泛化能力。

不同模型对不同缺失方式的杏鲍菇点云补全效果如图9所示。从图中可以看出,AdaPoinTr、SnowFlakeNet、SwinPoinTr模型对不同缺失方式的点云补全皆取得了较优效果。其中,顶部缺失点云补全效果相对较差,其原因为杏鲍菇菌盖差异较大,在完全缺失菌盖特征的情况下,模型难以凭空生成细节特征。相较之下,SnowFlakeNet生成的点云更加均匀,表面更加平滑,但也因此缺失了许多细节特征。而SwinPoinTr模型不仅能在全局上较优地恢复点云,同时也提高了细节特征的恢复能力。

图9 不同模型对不同缺失形式点云补全结果可视化

Fig.9 Visualization of point cloud completion results for different missing patterns using various models

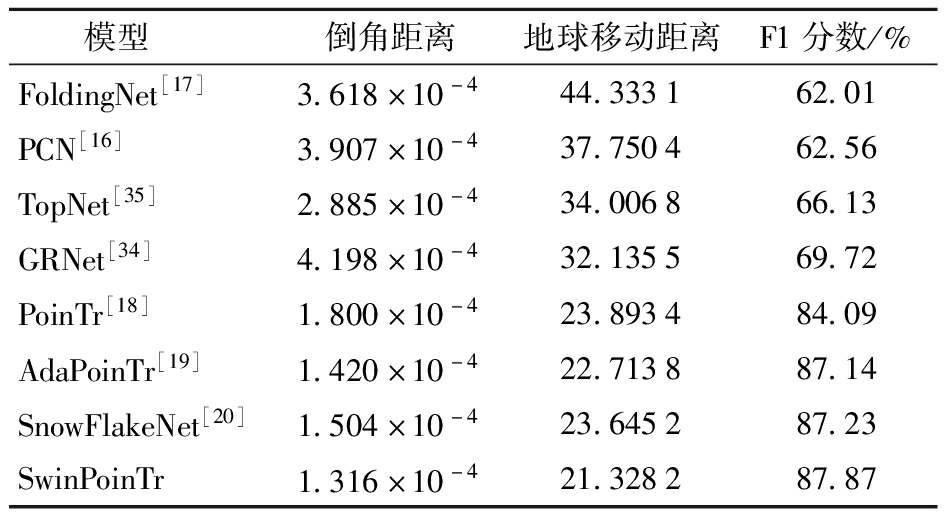

为了验证SwinPoinTr模型对残缺杏鲍菇点云补全后表型参数测量的准确性,从训练集与验证集中随机选取50个杏鲍菇点云模型,重新以顶部切割、底部切割、侧面切割、随机切割4种切割方法进行切割,除此之外,再使用生产平台以双视角拍摄的方法拍摄10个生产情况下的杏鲍菇点云进行测试。测试计算的表型信息为体积、面积和菌高,其真实值由数据采集平台采集的点云重建后计算得到,测量值为对不同缺失方式下的残缺点云进行补全后计算得到,并以决定系数R2和均方根误差(RMSE)进行评估。其计算结果如图10所示。

图10 基于SwinPoinTr的杏鲍菇表型参数估测结果

Fig.10 Phenotypic parameter estimation results of Pleurotus eryngii using SwinPoinTr

从图10中可以看出,在综合考虑所有缺失形式下,模型估测杏鲍菇体积、面积、菌高决定系数均大于0.98,均方根误差分别为3.215 5 cm3、3.215 4 cm2、2.389 5 mm,表明SwinPoinTr模型的估算有较高的相关性,且估算结果与真实值偏差均在允许范围内。同时,为明确生产工作中杏鲍菇表型参数自动测量系统工作效率,分别对不同部分进行计时,其中,生产平台采集单个视角点云耗时0.5 s,生产实际中使用双视角拼接点云,故点云采集部分耗时1 s,点云补全模型补全单个点云耗时0.03 s,点云表面重建并测量表型参数用时0.7 s,总用时1.73 s,其中,点云采集与表面重建未使用显卡加速。

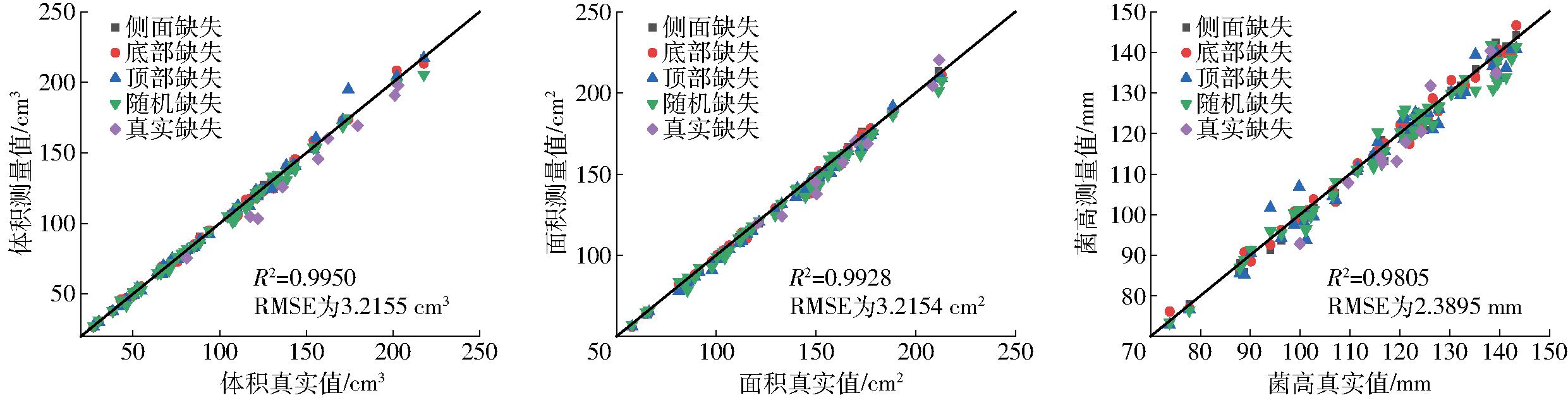

表2为模型对不同测量属性下不同切割方式评估结果。可见,模型在侧面缺失和底部缺失情况下估算结果更好,顶部缺失和随机缺失相对较差。这是由于,杏鲍菇菌盖形式多样、特征多变,在菌盖特征完全缺失的情况下,模型难以凭空还原。同时,由于随机切割会采用较大程度的切割以提高模型泛化能力,而侧面缺失和底部缺失会保留更多的模型特征,所以相较而言,侧面缺失和底部缺失会取得比顶部缺失和随机缺失更好的结果。同时发现,模型在真实缺失任务中的估测结果虽优异但较在其他缺失方式任务中的表现差。这是由于模型在训练过程中处理的由4种切割方式生成的点云多于真实点云,模型对于4种切割方式生成点云的缺失特征的掌握程度高于真实点云。

表2 不同切割方式评估指标

Tab.2 Evaluation indicators for different cutting methods

测量属性指标侧面缺失底部缺失顶部缺失随机缺失真实缺失菌高R20.99110.98770.96760.96720.9582RMSE/mm1.62731.91233.11053.13064.4213体积R20.99900.99720.99310.99470.9596RMSE/cm31.35982.29723.63403.166410.8185表面积R20.99680.99480.99180.98570.9605RMSE/cm22.07472.67273.35164.43797.5778

同时,真实情况下的点云数据会产生更多的噪声,点云密度具有随机性,点云输入模型的初始位姿也不固定。因此,在真实环境下模型效要略差于其他切割方式。但总体而言,其估测效果优异且结果准确。

(1)搭建了基于双目结构光的数据采集平台和生产平台。利用数据采集平台完成了完整杏鲍菇的点云扫描,通过生产平台获取了生产情况下的残缺点云并利用不同的算法对完整点云进行切割共同构造了训练数据集,提高了模型的泛化能力。数据采集平台可以更快速、更自动化地获取完整点云。生产平台结构简单、移动便捷,可以适应菇房内的生产情况。

(2)提出了SwinPoinTr点云补全算法,该算法将提取的特征重塑后引入了具有层次化几何感知能力的Transformer模块。该算法相对于其他算法可以利用更多的输入数据,掌握更多的点云细节。在残缺杏鲍菇点云补全任务中,模型倒角距离为1.316×10-4,地球移动距离为21.328 2,F1分数为87.87%。在表型参数估测任务中,SwinPoinTr模型对杏鲍菇菌高、体积、表面积估测结果决定系数分别为0.958 2、0.959 6、0.960 5,均方根误差分别为4.421 3 mm、10.818 5 cm3、7.577 8 cm2。SwinPoinTr模型补全效果较好,估测偏差较小,具有一定的实用性。

[1] 陈小宇,郑岸颖,潘雁艳.福建省“移动菇房”装备技术现状及发展建议[J].福建农机,2024(2):7-10.CHEN Xiaoyu,ZHENG Anying,PAN Yanyan.Present situation and development suggestion of equipment technology for “mobile mushroom house” in Fujian Province[J].Fujian Agricultural Machinery,2024(2):7-10.(in Chinese)

[2] 唐义平.福建省食用菌机械化发展现状及对策建议[J].农机科技推广,2024(5):39-41.

[3] 邹宇航,王明飞,张馨,等.基于模型预测控制的工厂化菇房空调调控方法[J].中国农机化学报,2024,45(6):98-105.ZOU Yuhang,WANG Mingfei,ZHANG Xin,et al.Control method of factory mushroom room air conditioning based on model predictive control[J].Journal of Chinese Agricultural Mechanization,2024,45(6):98-105.(in Chinese)

[4] 张馨,孔祥书,郑文刚,等.基于模型预测控制的菇房空调节能控制方法[J].农业机械学报,2024,55(3):352-361.ZHANG Xin,KONG Xiangshu,ZHENG Wen’gang,et al.Energy-saving control method of air conditioning in mushroom house based on model predictive control[J].Transactions of the Chinese Society for Agricultural Machinery,2024,55(3):352-361.(in Chinese)

[5] 赵全明,宋子涛,李奇峰,等.基于CNN-GRU的菇房多点温湿度预测方法研究[J].农业机械学报,2020,51(9):294-303.ZHAO Quanming,SONG Zitao,LI Qifeng,et al.Multi-point prediction of temperature and humidity of mushroom based on CNN-GRU[J].Transactions of the Chinese Society for Agricultural Machinery,2020,51(9):294-303.(in Chinese)

[6] 王琢,肖进,何雨霜,等.食用菌菇房环境多因子协同调控技术[J].中国农机化学报,2023,44(12):47-52.WANG Zhuo,XIAO Jin,HE Yushuang,et al.Multi-factor coordinated regulation technology of edible fungi house environment[J].Journal of Chinese Agricultural Mechanization,2023,44(12):47-52.(in Chinese)

[7] 陈燕,陆嘉豪,胡小春,等.基于VGG-UNet的食用菌菌丝体表型参数自动测量方法[J].农业机械学报,2024,55(1):233-240.CHEN Yan,LU Jiahao,HU Xiaochun,et al.Automated measurement method of phenotypic parameters of edible mushroom mycelium based on VGG-UNet[J].Transactions of the Chinese Society for Agricultural Machinery,2024,55(1):233-240.(in Chinese)

[8] OJO M O,ZAHID A,MASABNI J G.Estimating hydroponic lettuce phenotypic parameters for efficient resource allocation[J].Computers and Electronics in Agriculture,2024,218:108642.

[9] GUO R,XIE J,ZHU J,et al.Improved 3D point cloud segmentation for accurate phenotypic analysis of cabbage plants using deep learning and clustering algorithms[J].Computers and Electronics in Agriculture,2023,211:108014.

[10] ZHU B,ZHANG Y,SUN Y,et al.Quantitative estimation of organ-scale phenotypic parameters of field crops through 3D modeling using extremely low altitude UAV images[J].Computers and Electronics in Agriculture,2023,210:107910.

[11] YAN J,TAN F,LI C,et al.Stem-leaf segmentation and phenotypic trait extraction of individual plant using a precise and efficient point cloud segmentation network[J].Computers and Electronics in Agriculture,2024,220:108839.

[12] GAO R,CUI S,XU H,et al.A method for obtaining maize phenotypic parameters based on improved quickshift algorithm[J].Computers and Electronics in Agriculture,2023,214:108341.

[13] 朱逢乐,严霜,孙霖,等.基于深度学习多源数据融合的生菜表型参数估算方法[J].农业工程学报,2022,38(9):195-204.ZHU Fengyue,YAN Shuang,SUN Lin,et al.Estimation method of lettuce phenotypic parameters using deep learning multi-source data fusion[J].Transactions of the CSAE,2022,38(9):195-204.(in Chinese)

[14] 李添天,戴倩,谢元澄.基于改进神经辐射场的植物表型参数测量方法[J].农业工程学报,2024,40(17):188-196.LI Tiantian,DAI Qian,XIE Yuancheng.Measuring plant phenotypic parameters using improved neural radiance fields[J].Transactions of the CSAE,2024,40(17):188-196.(in Chinese)

[15] 朱磊,江伟,孙伯颜,等.基于神经辐射场的苗期作物三维建模和表型参数获取[J].农业机械学报,2024,55(4):184-192,230.ZHU Lei,JIANG Wei,SUN Boyan,et al.Three-dimensional reconstruction and phenotype parameters acquisition of seeding vegetables based on neural radiance fields[J].Transactions of the Chinese Society for Agricultural Machinery,2024,55(4):184-192,230.(in Chinese)

[16] YUAN W,KHOT T,HELD D,et al.PCN:point completion network[C]∥2018 International Conference on 3D Vision (3DV).IEEE,2018:728-737.

[17] YANG Y,FENG C,SHEN Y,et al.FoldingNet:point cloud auto-encoder via deep grid deformation[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition.IEEE,2018:206-215.

[18] YU X,RAO Y,WANG Z,et al.PoinTr:diverse point cloud completion with geometry-aware transformers[C]∥2021 IEEE/CVF International Conference on Computer Vision (ICCV).IEEE,2021:12478.

[19] YU X,RAO Y,WANG Z,et al.AdaPoinTr:diverse point cloud completion with adaptive geometry-aware transformers[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2023,45(12):14114.

[20] XIANG P,WEN X,LIU Y S,et al.SnowflakeNet:point cloud completion by snowflake point deconvolution with skip-transformer[C]∥2021 IEEE/CVF International Conference on Computer Vision (ICCV).IEEE,2021:5479-5489.

[21] HUANG Z,YU Y,XU J,et al.PF-Net:point fractal network for 3D point cloud completion[C]∥2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).IEEE,2020:7659-7667.

[22] WANG Y,SUN Y,LIU Z,et al.Dynamic graph CNN for learning on point clouds[J].ACM Transactions on Graphics,2019,38(5):1-12.

[23] LI S,GAO P,TAN X,et al.ProxyFormer:proxy alignment assisted point cloud completion with missing part sensitive transformer[C]∥2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).IEEE,2023:9466-9475.

[24] CHEN H,LIU S,WANG C,et al.Point cloud completion of plant leaves under occlusion conditions based on deep learning[J].Plant Phenomics,2023,5:0117.

[25] 肖海鸿,徐焕良,马仕航,等.遮挡条件下基于MSF-PPD网络的绿萝叶片点云补全方法[J].农业机械学报,2021,52(9):141-148.XIAO Haihong,XU Huanliang,MA Shihang,et al.Point cloud complementation method of Epipremnum aureum leaves under occlusion conditions based on MSF-PPD network[J].Transactions of the Chinese Society for Agricultural Machinery,2021,52(9):141-148.(in Chinese)

[26] 孙帮勇,吴思远.格雷码与六步相移编码融合的三维结构光学测量方法[J].强激光与粒子束,2021,33(2):17-23.SUN Bangyong,WU Siyuan.Structured light technology based on gray code and six-step phase shift method[J].High Power Laser and Particle Beams,2021,33(2):17-23.(in Chinese)

[27] BESL P J,MCKAY N D.A method for registration of 3D shapes[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,1992,14(2):239-256.

[28] DDOSOVITSKIY A,BEYER L,KOLESNIKOV A,et al.An image is worth 16x16 words:transformers for image recognition at scale[C]∥9th International Conference on Learning Representations,ICLR 2021,Virtual Event,2021.

[29] CHARLES R Q,SU H,KAICHUN M,et al.PointNet:deep learning on point sets for 3D classification and segmentation[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).IEEE,2017:77-85.

[30] QI C R,YI L,SU H,et al.Pointnet++:deep hierarchical feature learning on point sets in a metric space[C]∥Proceedings of the 31st International Conference on Neural Information Processing Systems (NIPS’17),2017:5105-5114.

[31] TAUNK K,DE S,VERMA S,et al.A brief review of nearest neighbor algorithm for learning and classification[C]∥2019 International Conference on Intelligent Computing and Control Systems (ICCS).Madurai:IEEE,2019:1255-1260.

[32] 曾安,彭杰威,刘畅,等.基于多尺度几何感知Transformer的植物点云补全网络[J].农业工程学报,2022,38(4):198-205.ZENG An,PENG Jiewei,LIU Chang,et al.Plant point cloud completion network based on multi-scale geometry-aware point Transformer[J].Transactions of the CSAE,2022,38(4):198-205.(in Chinese)

[33] KAZHDAN M,BOLITHO M,HOPPE H.Poisson surface reconstruction[C]∥Proceedings of the Fourth Eurographics Symposium on Geometry,2006:61-70.

[34] XIE H,YAO H,ZHOU S,et al.GRNet:gridding residual network for dense point cloud completion[M]∥VEDALDI A,BISCHOF H,BROX T,et al.Computer Vision-ECCV 2020.Cham:Springer International Publishing,2020:365-381.

[35] TCHAPMI L P,KOSARAJU V,REZATOFIGHI H,et al.TopNet:structural point cloud decoder[C]∥2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).IEEE,2019:383-392.