表型(Phenotype)是指生物个体或群体在特定环境下所展现出的全部物理特征与行为模式,它是基因型(Genotype)与环境因素相互作用的结果。作物的产量、品质、抗逆性等关键农艺性状,都是表型的具体体现。表型性状的改良对于保障粮食安全、推动农业可持续发展起着举足轻重的作用,因此实现作物表型精准高效鉴定对于深入理解遗传与环境的互作机制、解析表型与基因的内在联系、加速育种进程意义重大。与迅猛发展的基因组技术相比,传统作物表型性状采集方式主要依靠人工,存在效率低下、主观性强、可重复性差等问题,部分性状还需剪取作物器官进行有损测量,在很大程度限制了作物育种及功能基因组学研究进展。随着作物育种研究对表型数据与日俱增的需求,数据驱动的智能育种已成为全球研究热点,精准、高效的作物表型数据获取方案成为这一领域的关键所在[1-2]。与此同时,智能传感器、计算机视觉以及人工智能等技术的飞速发展,为作物表型检测技术发展提供了强大的推动力。

在此背景下,学者研制了手持式、移动式、固定式以及无人机载式等表型技术,分别从不同尺度进行作物表型精准鉴定,一定程度满足了育种研究对作物表型性状采集解析需求[3]。与手持式及无人机载式表型技术相比,移动式及固定式等地面端高通量表型平台因其高效率检测、近距离高分辨率检测、多角度全方位检测、便于扩展传感器多模态检测、室内及大田多场景检测、成像环境可控高稳定检测等优点,近年来得以快速发展。国内科研团队纷纷建立固定式表型平台,如轨道式及流水线式表型平台,实现“Sensor to Plant”及“Plant to Sensor”两种模式下,作物颜色纹理、结构形态、生理组分等多类型表型信息获取及解析,极大支撑了作物育种相关研究。然而,轨道式表型平台采集区域相对固定,流水线式表型平台针对盆栽作物且需将作物运送至固定位置,除此之外,固定式表型平台通常需要定制、建设成本高昂,难以覆盖大部分作物育种相关科研团队。

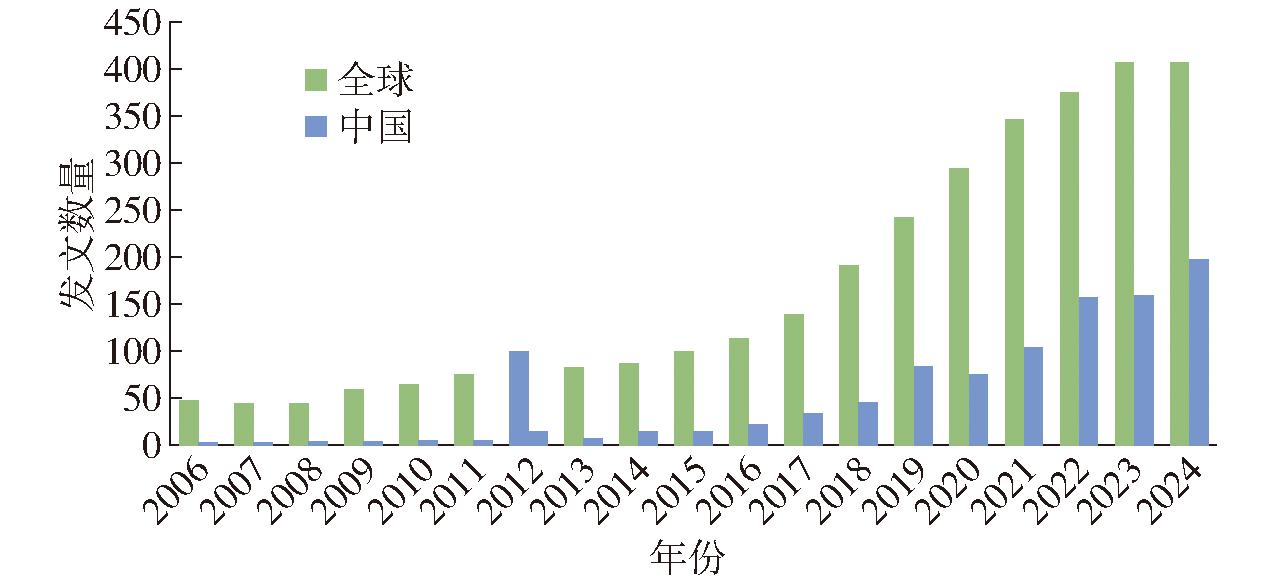

作物表型机器人是实现作物表型自动采集和解析的农业机器人系统,主要针对科研人员对不同类型作物多生育期、多尺度、多角度、多模态表型性状高效获取需求,基于移动机器人平台,通过搭载二维图像、三维点云、多/高光谱等传感器,实现作物颜色纹理、结构形态、生理组分等表型信息获取,为作物优异种质资源鉴定和遗传育种研究提供数据支撑。作物表型机器人兼具机器人的特性和表型性状获取及解析能力,具备移动灵活、作业不受时空限制,扩展性强、可挂载多种类传感器,近地多视角采集数据分辨率高,以及无人或少人操作、智能化程度高等诸多优势,且相比固定式表型平台成本较低,适用于广大农业科研人员。随着作物表型组学研究的蓬勃发展,表型机器人研发及应用也成为研究热点。图1展示了自2006年以来全球关于表型机器人研究的相关文献数量趋势。

图1 表型机器人相关研究论文数量

Fig.1 Number of publications related to phenotypic robots

人工智能技术和机器人技术的高速发展推动着表型机器人向适应多样化田间场景的感知能力、契合表型检测需求的路径规划能力,应对复杂场景任务的决策能力,从而实现少人化或无人化作物表型采集与解析的方向发展。随着现代农业对工业化、规模化及精准化生产要求的不断提高,农业机器人的发展与应用已成为推动智慧农业发展的重要力量[4]。随着数智时代的来临,传统育种领域正经历着深刻变革,由于精准的表型数据对于优异种质资源鉴定及功能基因高效挖掘至关重要[5],作物表型机器人的应用将会为作物遗传育种研究提供新的范式。基于此,本文首先综述国内外作物表型机器人研究现状,总结归纳表型机器人组成架构,并就表型机器人系统控制及导航方法这两个关键内容进行阐述,在此基础上介绍基于机器人的表型性状获取及解析方法,最后讨论表型机器人面临的挑战并对未来发展加以展望。

作物表型对作物优异种质资源鉴定、遗传机制解析、生长特性理解、种植策略优化等均具有重要价值。作为高通量表型检测领域的新兴技术手段,作物表型机器人正发挥着越来越重要的作用。与工业机器人的使用场景相比,表型机器人作业场景复杂,其对象多为娇嫩、复杂的农作物。由于作物表型的研究应用主要服务于作物育种科研,表型机器人需结合实际育种相关研究场景,这对功能和适应性提出了更高要求。相较于固定式表型平台,作物表型机器人具备灵活小巧的独特优势,可在无需额外基础建设的条件下行驶于不同地块。相较于无人机系统,虽然单套表型机器人采集效率低,但可通过部署多台机器人协同作业来缩小这一差距,此外表型机器人可同时搭载多种传感器,通过单一或多种光学传感器设备,如光谱传感器、激光雷达、深度相机等,从不同维度获取作物表型信息。基于表型机器人可以在地面端高效、精准行驶的优势,其搭载的传感器可以获取更高分辨率的表型数据,为作物器官、单株等尺度的准确分割提供保障。

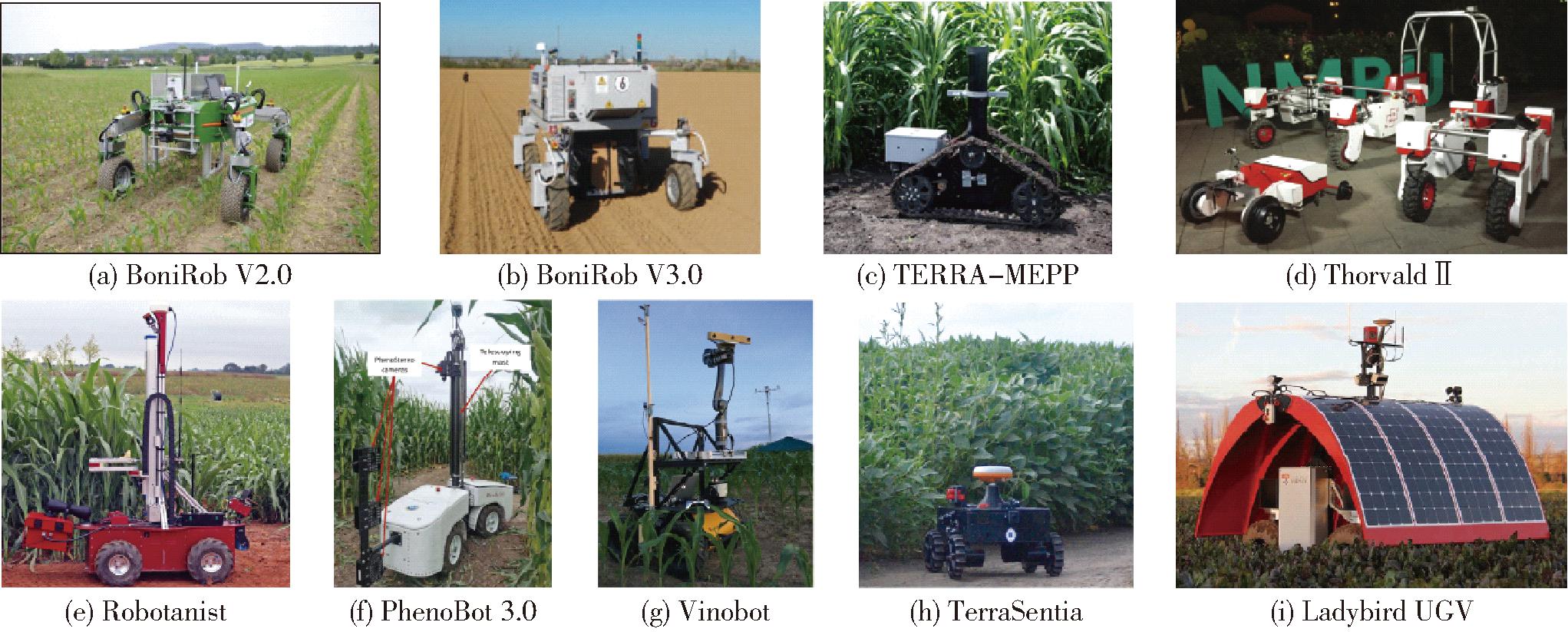

国外作物表型机器人研究起步较早,大多通过获取冠层表型数据的方式对植物表型进行评价。例如,德国博世公司于2009年研制出BoniRob[6]机器人平台(图2a),可用于田间玉米和小麦单株的冠层表型性状检测。它通过铰接臂与底盘连接,构建出了具备全方位行走和行距可调的表型机器人。BoniRob[7]主要由3个模块组成:用于控制机器人自主行走的导航模块、负责控制机器人运动转向的驱动模块,以及用于计算植物表型信息感知和计算的表型检测模块。该机器人采用液压驱动,并逐步迭代发展(图2b)。随着不同研究团队的深入推进,专用高通量表型机器人平台相继问世,如Ladybird[8]和Thorvald Ⅱ[9]等跨行式表型机器人,在设计和功能上各有特点。其中,Ladybird配备了光伏遮阳板(图2i),不仅能够将太阳能高效转化为电能,满足设备部分能源需求,还能通过优化光照条件,为可见光图像采集营造稳定成像环境。而Thorvald Ⅱ(图2d)可适用于多种农业场景。例如,在果园中,它可灵活穿梭于果树间进行果实监测与采摘辅助;在大田作物种植环境,能执行作物生长状况巡查等任务。

图2 国外典型作物表型机器人

Fig.2 Illustrations of foreign typical crops phenotype robots

除了大型机器人对冠层作物表型数据的获取,搭载各类传感器灵活穿梭于作物行间的小型机器人,更适用于作物内部或侧视多角度表型数据采集。为缩短开发周期,SHAFIEKHANI等[10]基于商用HuskyUGV移动平台开发了用于玉米植物表型分析的Vinobot机器人(图2g)。该机器人通过安装深度相机的机械臂获取玉米植株三维形态信息。这种基于商用移动平台进行二次开发,为玉米表型分析提供了一种新途径。由于种植环境和作物长势的多样性,商业化底盘往往难以适应田间实际种植场景,研究人员针对特定作物与田间环境,研制不同类型的表型机器人。如卡内基梅隆大学机器人学院研制的Robotanist机器人(图2e),可实现玉米、高粱等农作物的株行自主导航,通过机械手测量植物茎杆强度,并通过非接触式传感器模块化阵列收集表型数据。爱荷华州立大学研制的PhenoBot 3.0(图2f)搭载了多个自主设计的PhenoStereo相机,实现了玉米田间的自主导航任务,并实现了玉米叶夹角、株高、茎粗等表型性状获取。挪威生命科学大学设计了TERRA-MEPP(图2c)和TerraSentia(图2h)两款小型机器人,其中TERRA-MEPP是2016年YOUNG等[11]开发的低成本履带机器人,用于高粱田间表型鉴定。它在桅杆顶部安装立体摄像机测高粱高度,下方搭载基于飞行时间(Time of flight)原理的深度相机测茎秆直径,以解决高粱植株高大、冠层密集带来的测量难题。TerraSentia[12]则配备激光雷达与框架式侧视RGB摄像机,可在玉米、大豆等行作物行间灵活行驶,通过结合激光雷达获取的三维点云数据与RGB相机颜色信息,实现多种作物表型分析。

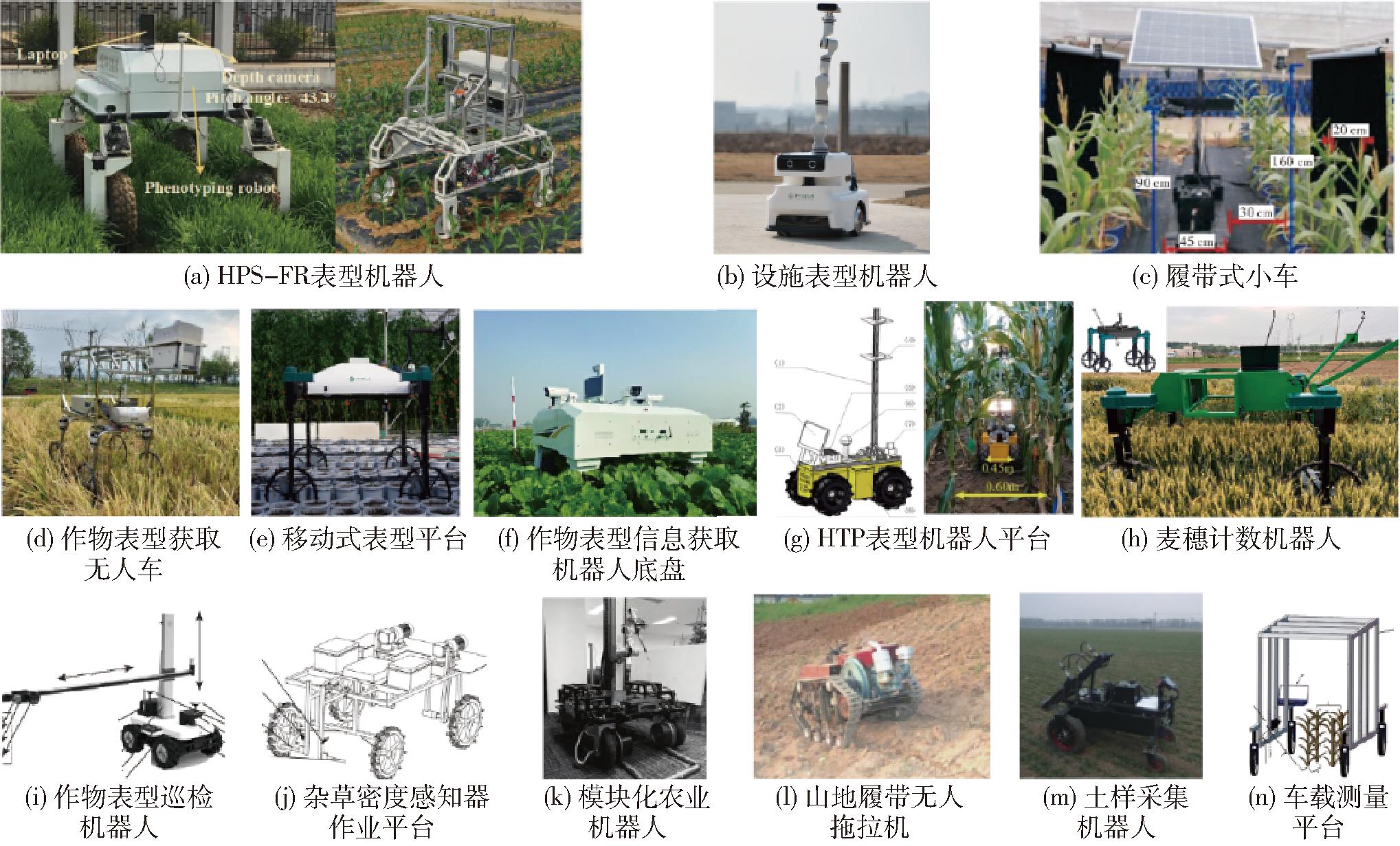

国内在表型机器人领域的研究虽起步较晚,但发展迅速。浙江大学唐政等[13]设计了一款用于田间作物表型获取的无人车平台(图3d),可搭载多种常见的光学表型设备,如高光谱相机、多光谱相机以及热成像仪等。为解决复杂农田路况通行问题,中国农业机械化科学研究院集团有限公司徐圣林等[14]设计出适用于复杂路况的表型信息获取机器人底盘(图3f),其摆臂结构可依路面起伏自动调整,改变底盘与地面接触,显著提高通过性,为复杂地形田间表型信息获取提供可靠基础。针对光学传感器田间信息采集易受光照干扰的问题,华中农业大学研发出一款具备暗室结构的表型机器人(HPS-FR)[15],有效隔绝了外界光照影响,该机器人能稳定获取可见光、高光谱及三维点云数据。为进一步提高表型机器人的智能化程度,该团队基于机器视觉技术与深度相机,实现了对田间环境特征的快速识别分析,引导机器人避障并精准定位,实现日夜场景导航(图3a、3c),为表型机器人无人化作业奠定基础[16]。针对设施环境作物表型采集需求,复旦大学潘宇真等[17]提出了一种基于模块化的多场景农业机器人(图3k),该机器人模块化设计理念使其能够根据不同设施环境和作业需求,灵活组合模块,快速适配多种场景,为设施环境下机器人设计和应用提供参考。华中农业大学则研制了一款搭载六自由度机械臂的设施表型机器人(图3b),其采用激光雷达进行建图导航,并通过侧视相机进行盆栽识别和定位,并利用深度相机对盆栽植株全程无人化逐一进行表型性状采集和解析,实现设施环境盆栽作物表型性状采集全程无人化,该机器人还可应用于设施环境智能巡检。

图3 国内典型作物表型机器人

Fig.3 Illustrations of domestic typical crops phenotype robots

由于农业场景的多样性,国内越来越多的团队针对特定场景和需求研制表型机器人。如南京农业大学邱小雷等[18]设计了作物表型巡检机器人(图3i),能够高效、准确地采集作物生长过程中各种表型数据。华南农业大学陈学深等[19]设计的表型机器人(图3j)可感知杂草密度,通过精准评定苗期水稻区域的杂草密度,为针对性的杂草防治提供科学依据,在水稻苗期管理中具有重要应用价值。西北农林科技大学、北京石油化工研究院FAN等[20]设计的HTP表型机器人平台(图3g)能够灵活地在大田环境中玉米的狭窄行间穿梭,适应复杂的田间地形和作物布局,运用表型算法,可实现高精度的行间玉米茎粗原位测量,能够准确获取玉米茎粗。国家农业信息化工程技术研究中心樊江川等[21]为了有效解决高通量草莓叶龄及冠幅提取问题,基于移动式表型平台(图3e)实现了对草莓冠层的有效数据采集,通过实例分割技术,实现了草莓叶片的高通量表型提取。面向研究土壤物理力学特性中土壤原状采集的使用需求,北京农学院邱权团队[22]设计了原状土样采集移动机器人(图3m),适用于不同场景下的土样采集。针对山地丘陵环境特点,西北农林科技大学杨福增团队[23]升级了小型山地履带无人拖拉机(图3l),具备稳定的运转性能,有效避免了坡地侧翻对驾驶人员造成伤害。表1总结了国内外表型机器人研发成果。

表1 作物表型机器人典型研究成果

Tab.1 Overview of crop phenotyping robots

表型机器人名称搭载传感器开发机构适用场景主要特点BoniRob表型模块(光谱相机、三维ToF相机、二维激光雷达)、土壤采集设备模块、精准喷施模块、精准除草模块RobertBoschGmbH大田4AWS平台,可拓展性强,支持土壤阻力、土壤温度和湿度的自动化测量功能,适用于玉米、小麦等作物ThorvaldⅡ可见光相机、热成像相机NorwegianUniversityofLifeSciences大田/设施4AWS平台,适用于土壤取样、UVB光杀菌处理,具有表型数据采集功能,适用于小麦、草莓、黄瓜场景LadybirdUGVsystem线扫描高光谱相机、双目立体相机、热红外视觉TheUniversityofSydney大田4AWS平台,适用于小麦、蚕豆、大鹰嘴豆、扁豆、小麦、豌豆的表型检测,主要参数包含植物高度、冠层闭合度、NDVIVinobot双目相机、环境传感器、机械臂、RFIDUniversityofMissouri大田使用HuskyUGV平台,具备机械臂,可实现玉米田间表型检测功能TerraSentia可见光相机UniversityofIllinois大田可穿梭于玉米冠层以下的场景当中,统计玉米茎秆数量、粗细等表型参数Robotanist机械夹爪、双目立体相机卡内基梅隆大学机器人学院FRC实验室大田四轮差速运动,通过GPS进行全局定位,前后有单线激光雷达用于避障。可使用二指加持器对植物茎秆进行测量和数据采集,可扩展搭载双目立体视觉单元进行表型采集PhenoBot3.0多个PhenoStereo相机爱荷华州立大学大田四轮拖挂式驱动,能够在作物间穿梭。适用于玉米植株表型测量,利用深度卷积神经网络进行二维图像中叶角检测,并通过三维建模提取定量数据HPSFR表型机器人可见光图像、热成像相机、高光谱相机华中农业大学大田4AWS平台,适用于多种作物表型采集,可制造暗室采集环境获取稳定表型信息移动式表型平台可见光相机国家农业信息化工程技术研究中心设施基于3WPZ200A型自走式设备设计了移动式表型平台,可实现草莓叶龄的精准估算和冠幅的参数提取麦穗计数机器人可见光相机山东农业大学大田采用DeepSORT融合YOLOv7的跟踪方法,实现了对麦穗进行跟踪并计数的功能田间作物表型获取无人车平台可见近红外高光谱成像仪、RGB相机、近红外高光谱成像仪、KinectDK相机浙江大学大田4AWS平台,搭载了多种传感器,轻量化的车架可适用于田间的植物表型数据获取作物表型获取机器人中国农业机械化科学研究院集团有限公司大田4AWS平台,适用于小麦场景,通过仿真和样机验证,实现了机器人在田间的功能性验证作物表型信息获取机器人RGB相机、可见近红外高光谱成像仪、近红外高光谱成像仪、KinectDK相机浙江大学大田通过稳定轻量化的结构实现了机器人在田间的稳定运行HTP双目相机西北农林科技大学、北京石油化工研究院人工智能研究院大田四轮差速驱动,适用于玉米狭窄行间的表型数据采集,通过表型算法实现了高精度行间玉米茎粗原位测量作物表型巡检机器人实验平台深度相机、RGB相机、多光谱相机南京农业大学大田一款多用途实验教学平台,能够搭载多种表型传感器实现田间表型数据获取模块化农业机器人复旦大学设施机器人以模块化理念进行设计,为农业设施环境下机器人的设计和应用提供了参考原状土样采集移动机器人土壤采集模块北京农学院智能科学与工程学院大田针对不同场景(如农田、坡地、试验田等)做了适应性设计杂草密度感知作业平台触觉传感器华南农业大学大田适用于水田并通过接触方式的杂草检测机器人田间测量平台RGBD相机浙江大学大田使用田间测量平台实现了基于RGBD相机测量玉米植株高度的方法小型山地履带无人拖拉机西北农林科技大学大田适用于山地场景运行的小型无人履带拖拉机

作物表型机器人主要用于作物表型自动采集和自主解析,具备高度集成化、智能化等特性。其以移动平台为运动载体,搭载各类传感器在农业场景中自主行走,并获取作物多种表型信息。故表型机器人主要包括机器人移动平台和表型采集及数据处理两部分,其中机器人移动平台又包括移动机器人本体结构、运动控制单元、自主导航单元。面对农业场景复杂、任务多变的场景,精准的运动控制和高效的自主导航,能让机器人适应不同作业需求,确保表型数据采集准确高效。因此,机器人运动控制方法和自主导航方法对表型机器人功能实现至关重要。表型机器人整体控制系统如图4所示,主控制器通常采用高算力的边端计算模块或工业计算设备作为上位机[24-25],通过与机器人运动控制单元、自主导航单元、表型采集单元等实时通讯,控制表型机器人实现多模式运动、自主导航移动、表型数据自动采集等功能。

图4 表型机器人核心控制框图

Fig.4 Core control schematic diagram of phenotyping robot

机器人主控制器根据导航信息感知传感器,如激光雷达获取周围环境的三维信息,GNSS设备提供精确地理位置信息等,计算机器人当前位置并实时规划运动路径,同时与运动控制单元交互,控制机器人按照规划路径运动[26-27]。同时,在移动过程,表型采集与数据处理单元可通过串口RS232等接口与机器人主控制器进行通讯[7],结合导航定位信息,针对不同表型采集任务实现表型数据采集控制[28]。

表型机器人运动控制单元通常以单片机(MCU)或可编程逻辑控制器(PLC)作为主要控制器[29]。单片机具有体积小、成本低、功耗小等特点,能高效处理简单逻辑和控制任务,适用于对成本和功耗有严格要求的场景。可编程逻辑控制器可靠性高、灵活性强,适用于复杂工业控制场景,能够应对多变的农田环境和复杂的表型检测作业任务,二者为机器人平台的稳定运行提供基础。当前作物表型机器人主要有差速运动和四轮独立驱动转向运动两种方式。小型表型机器人通常采用差速运动方式,该方式结构简单、成本较低,适用于较为狭窄的作物行内行走或设施环境行走,也有采用前后铰接的形式进一步减小其宽度[30],从侧视多视角方向采集作物表型数据。在差速运动方式下,机器人通过调节左右两侧驱动轮转速使其具有速度差,从而实现转向和移动。大型表型机器人通常采用四轮独立驱动转向运动模式,即每个轮组具备独立的驱动和转向模块且均可单独控制,该运动方式下机器人具备阿克曼、楔形移动、原地转向等多种运动模式,在不同地形条件下具备良好的通过性能,具备灵活调整姿态和移动方向,能有效应对农田中的各种障碍物和复杂路况,也可应用于无机耕道的复杂地块,该机器人通常跨行行驶从冠层采集作物表型数据。表型机器人运动控制是其实现精准、高效表型数据采集的关键。根据不同作物表型检测需求,选择合适的运动方式,能够使表型机器人在复杂农田环境中稳定运行并高效获取高质量表型数据。

无论是差速运动还是四轮独立驱动转向运动,均需对多个电机进行独立或同步控制,因此运动控制单元通常采用总线控制方式,实现多电机的组合控制与数据监控,有效降低控制延迟,确保机器人稳定运动。运动控制单元控制器通过串口、RS232、RS485、CAN等通讯协议,将传感器数据、机器人运动控制数据以及状态模式数据等,传输至机器人主控制器;主控制器负责对环境数据进行解算与融合,处理多元传感器数据。该模块依据获取的机器人实时位置和周围场景信息,规划机器人的运动路径,并将基于局部路径数据计算得出的运动数据传输至运动控制单元控制器,实现对机器人的运动控制。

自主导航是实现表型机器人自主作业的关键。室外环境中主要应用基于全球卫星导航系统(Global navigation satellite system,GNSS)的导航技术。该技术通过实时动态定位模块(Real-time kinematic,RTK)实现高精度定位,具有抗磁干扰能力强、定位精准等特点,能够为农业智能装备提供实时的厘米级定位精度。目前,许多田间表型机器人,如BoniRob、Thorvald Ⅱ等,均采用基于GNSS的导航传感器进行自主导航。基于该技术的智能装备通常要依赖预先记录的控制点,通过路径规划算法计算形成导航路径从而控制实现田间导航行走[31]。作物表型检测通常需要覆盖作物全生命周期,而作物在不同生长阶段的植株形态存在较大差异。该方法计算形成的导航路径无法根据作物动态生长过程进行自适应调整,从而影响表型性状采集效果。此外,基于GNSS的导航技术在设施环境或植株内部表型检测过程,信号易受干扰,难以全面满足作物表型检测机器人的自主导航需求。

随着深度相机、激光雷达、高算力板卡等硬件的快速发展,工业上的导航技术如视觉技术和同步定位与地图构建(Simultaneous localization and mapping,SLAM)技术,逐渐在农业场景中得到应用。视觉技术通过搭载视觉传感器获取机器人行驶路径上的可见光图像,并利用图像分割技术提取导航关键信息(如作物行或垄沟区域)。随后,通过对作物行或垄沟图像进行直线拟合提取导航路径,实现自主导航[32]。例如,关卓怀等[33]基于灰度化算法提出一种水稻收获作业过程中的视觉导航路径提取方法。赵腾等[34]基于作物收获边缘线的快速提取方法实现了小麦田间导航线的获取。随着深度学习技术的发展,视觉导航在处理复杂农业环境方面展现出显著优势,能够在不同光照条件下稳定提取作物行或垄沟在图像中的像素位置信息[35-36],甚至可以通过训练直接提取机器人行驶导航路径[37]。如卢心缘等[38]基于履带式机器人平台设计了基于YOLO的路径提取算法,成功实现在枣园环境下导航行走。

尽管视觉导航技术在农业场景中具有广阔应用前景,但其模型训练过程需要大量农业场景数据的支撑。与城市道路场景(具有车道线、信号灯等模式化对象)不同,农业场景的复杂性和多样性使得数据获取更具挑战。目前,用于农业领域导航研究的开源数据集仍然有限,如2017年BoniRob采集了一份涵盖整个生产周期的田间作物数据[39],2023年ARD-VO提供了一份在葡萄园和橄榄树种植园中采集的表型数据和机器人感知数据集[40],同年RumexWeeds也提供了一份基于机器人采集的草原杂草数据集[28]。AGUIAR等[41]对当前农业和森林环境中的定位方法进行了总结和综述,并概述了用于开发和测试这些方法的可用数据集。然而,这些数据集无法满足纯视觉导航方法在农业场景中对数据的需求。

也有团队基于深度相机开展视觉导航方法研究,深度相机能同时获取目标二维图像和深度信息,从而使农业机器人具有更加精准、稳定的导航能力。与此同时,SLAM技术也在农业场景中逐步推广。SLAM技术通过同时构建地图和确定机器人在地图中的位置,实现机器人在未知环境中的自主导航[42]。GIMENEZ等[43]提出ICM-SLAM方法,通过对树木主干进行检测实现了行间机器人导航。TANG等[44]通过联合激光SLAM方案采集林间树木数据,进一步提升了GNSS+IMU系统的导航可靠性。与普通相机和深度相机相比,激光雷达获取的作物株行点云数据更为精准。然而,在导航作业过程如何有效分析和利用这些三维点云数据仍有待深入研究。实现对植物点云的精准识别,将有助于推动导航功能和植物三维表型数据获取方法的发展。

为进一步推动农业机器人导航技术的发展,多源数据的获取和利用至关重要。PIRE等[45]提供了一份田间种植大豆的传感器数据集,包含了里程计、IMU、双目摄像头、GPS-RTK数据信息;REIS等[46]提供了一个不同森林环境的数据集,涵盖了三维激光雷达、热像仪、惯性单元、GNSS、RGB相机等多种传感器数据。然而,农业场景的复杂性限制了这些数据的利用可行性。未来,如何融合多源数据进行导航技术开发,如何获取有效数据集供研究者使用,是表型机器人通用导航技术实现突破的关键。

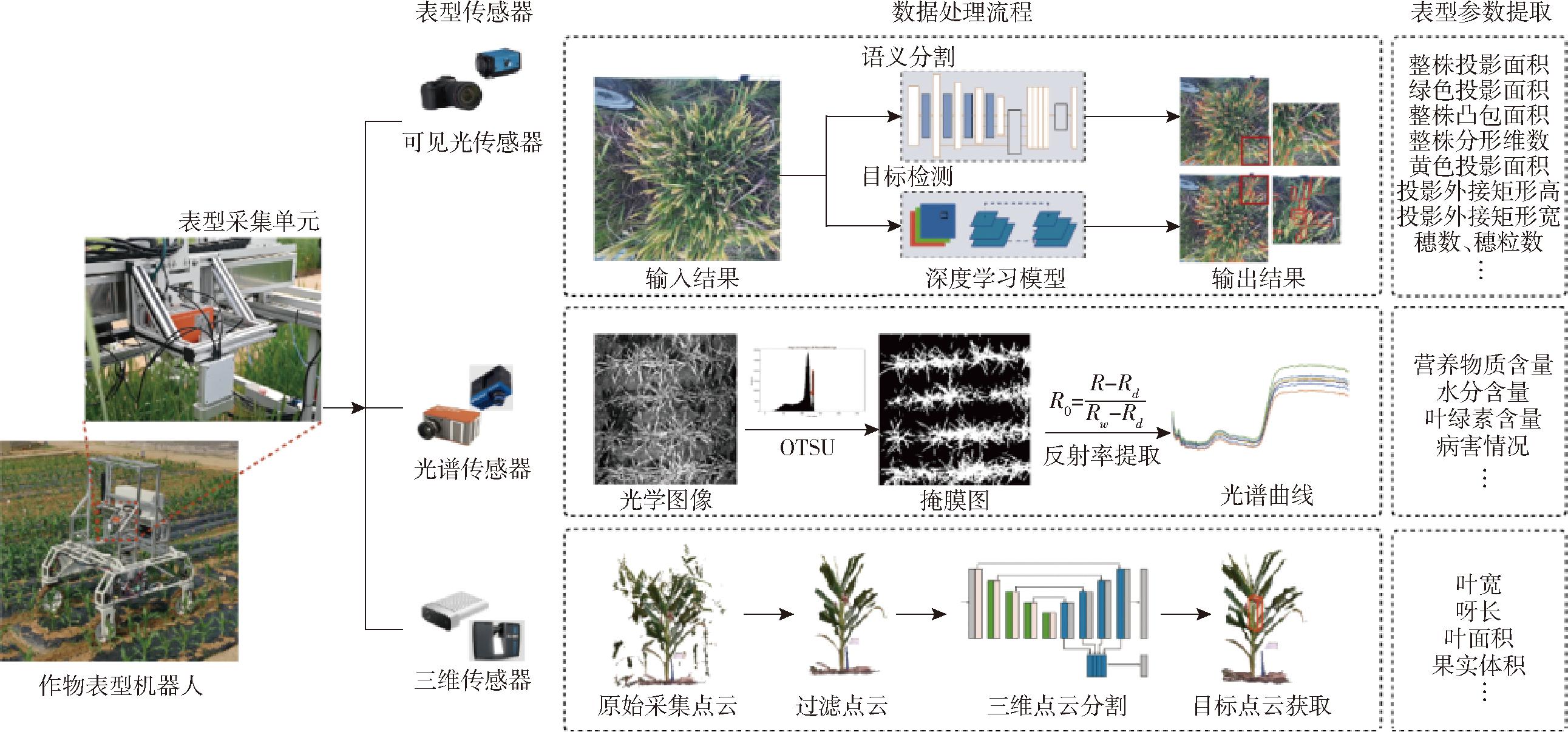

基于“Plant to Sensor”和“Sensor to Plant”的高通量表型检测系统为表型机器人数据采集与解析提供了有效参考。在获取群体植物表型的需求下,机器人往往通过冠层或植株侧视视角对植物群体进行观测。目前,基于表型机器人采集及解析的表型数据主要有3种类型:①二维图像数据,通过可见光成像传感器采集,在数据处理阶段,可通过传统处理流程进行处理,也可利用深度学习模型通过目标检测及图像分割方法解析获得。该类数据在分析作物颜色纹理、投影尺寸及数量等方面具有优势。②三维点云数据,通过三维成像传感器如激光雷达、深度相机或可见光成像传感器采集系列图像后重建获取,通过机器学习和深度学习方法能够实现对三维点云数据的有效分割,该类数据能精确描绘作物在物理空间中的生长状态,可以连续监测植物及其器官的生长过程,通常用于作物结构形态性状提取、发育动态评估等。③光谱数据,通过近红外波段光谱传感器采集植物反射光谱或图像,该类数据包含被检测对象不同成分物质反射光谱信息,通过对光谱数据的预处理并结合模型构建的方法可用于作物含水率、叶绿素含量、代谢物等生理相关表型预测。采用表型机器人进行作物表型性状采集时,需根据实验目的按需搭载表型传感器,由于不同传感器采集到的原始数据格式各异,需分别进行处理分析。深入了解基于表型机器人所采集的可见光图像数据、三维点云数据及光谱数据解析方法,如图5所示,对推动作物表型研究与表型机器人技术的融合发展具有重要意义。由于当前作物表型机器人相关文献对数据处理相关内容发表较少,在表型数据处理解析中将部分引述相关适用于表型机器人的方法内容。

图5 作物表型机器人数据获取与处理流程图

Fig.5 Crop phenotype robot data acquisition and processing flowchart

可见光传感器在作物表型研究中应用广泛,在目标识别、检测、计数等任务中展现出多样化方法和流程。近年来,随着研究场景的复杂化,传统图像处理方法逐渐难以满足复杂背景下的表型性状解析需求。深度学习技术的发展使作物表型性状解析方法有了新突破,在复杂背景下的目标识别和分割性能大幅提升了植物表型领域对植物数字表型提取的能力,在结合多源数据时对表型特征的鉴定能力有进一步的提升[47-49]。

单一植株的准确识别及分割是表型机器人获取作物表型性状面临的难题,早期主要通过传统数字图像处理的方法实现。例如,QIU等[50]基于机器人进行图像采集,通过彩色图像中玉米植株位置来初步确定目标区域,选取HSV颜色空间中的S分量识别植株中心区域。面对设施环境下无遮挡场景,精细化的表型检测功能则更为适用,XIANG等[51]设计了RoAD机器人,将RGB相机安装在机械臂末端,先获取玉米和拟南芥顶视RGB图像,再配合激光轮廓仪从5个视角扫描植物,为3D重建提供数据。获取到的图像先通过超绿分割(正常植物)或结合HSV颜色空间色调信息及花盆边缘检测(干旱植物)获取植物的像素位置信息,将相关掩模图像结合得到植物RGB图像,最终获取到如2D面积、基于HSV颜色空间的颜色相关参数等2D植物表型数据,用于后续特征提取与分析。基于固定或手持式的田间调研中也有相关研究,具备进一步应用在表型机器人上的潜力。其中,基于简单图像算法的表型数据获取手段最具实时表型数据分析获取的可能,如黄成龙等[52]基于时间序列对玉米植株的叶片性状进行动态追踪,利用图像分割、叶片骨架提取等算法,成功获取单片叶长、叶角度、叶弯曲度参数。吴兰兰等[53]则通过对比分析多种数据处理流程,利用多种常用的植被指数搭配阈值算法实现大田油菜图像准确分割,进一步成功获取了油菜表型数据。翟瑞芳等[54]通过高斯HI颜色分割算法对油菜图像进行前处理,实现油菜苗期的精准分割。这些研究表明,传统图像处理方法能够在简单背景条件下,快速获取有效植株数量、植株密度、生物量、叶面积指数(LAI)、光通量、卷叶程度、穗数、叶面积和产量等表型指标[6,55],这对需要大规模连续检测的作物表型研究具备重大意义。

不仅仅局限于传统数字图像处理方法,深度学习方法的快速迭代促进了植物表型性状高效提取。作物穗数、穗粒数等表型是重要的产量相关性状,LI等[56]基于麦穗计数机器人,采用DeepSORT融合YOLO v7的跟踪方法,对麦穗进行跟踪,并通过跨线分区计数法,依据麦穗中心像素坐标与线的位置关系避免重复计数。SONG等[57]针对复杂田间环境检测小麦花期存在背景复杂、小穗小花易遮挡重叠、目标小且尺度变化大的问题,利用田间采集平台收集了麦穗不同时期的图像数据,并提出了利用YOLO v5s深度学习检测开花期的模型。段凌凤等[58]提出了一种基于深度学习的大田水稻稻穗精准分割方法,实现了稻穗的在体分割。杨万里等[59]基于Faster R-CNN和SegNet深度学习方法提取水稻穗部表型特征,并通过回归分析构建预测模型,成功预测了水稻鲜质量和干质量。这些研究不仅提高了表型分析的精度,还为表型机器人在田间环境对小麦、水稻等作物产量性状提取提供了新思路。基于深度学习的图像处理方法在作物病害检测中也展现出巨大优势[60],基于采集的作物图像可实现病害种类和严重程度识别[61-63],这些研究方法均具备应用于表型机器人上的潜力,使得基于表型机器人进行作物可见光表型动态实时获取及解析成为现实[64]。

作物三维点云获取方法主要有两类:主动获取和计算重建。主动获取方法通过激光雷达及深度相机等传感器采集形成三维点云数据。计算重建主要通过系列二维图像重建生成点云数据,主要重建方法包括体素雕刻、运动恢复结构(SfM)、深度学习等。这些方法在当前农业场景作物三维表型性状提取过程均有较多应用。

在表型机器人上多通过主动获取方法获取植物三维表型。如,BENDER等[8]通过安装在Ladybird上的激光雷达记录原始数据,同时获取RTK/GPS/INS地理位置信息,其将获取的三维点云数据与实际地理空间位置关联配准后进行列体素化处理,将每个3 cm2网格内的最大高度数据进行平均来获取植株高度;QIU等[65]设计的Phenomobile平台,通过激光雷达可实现冠层高度、冠层覆盖度、叶面积指数、叶角分布、生物量等表型数据的获取;RoAD通过搭载的机械臂配合末端相机和激光轮廓仪从5个视角扫描获取多视图数据生成3D点云,拼接获取植物三维点云[51];DairyBioBot使用激光雷达获取的数据提取植物体积、生物量及NDVI,并将LiDAR数据与卫星数据融合,生成包含地理坐标信息的点云数据[66]。SONG等[67]将消费级深度相机搭载在表型机器人上,实现了玉米、棉花等作物三维点云的高效获取,通过对植物株高、投影面积、叶面积检测精度进行对比,该方法在重建植物点云的精度上与激光雷达相当。

此外,被动获取植物点云的方法通常在固定表型采集设备中被使用,具备进一步应用在表型机器人上的潜力。WU等[68]利用体素雕刻方法,根据图像中的轮廓信息对水稻进行三维重建,无论是在不同品种还是不同生长时期的水稻样本中,均取得了良好的重建效果。在基于图像的三维点云重建研究中,SfM是一种常见的方法,它通过分析相机视点移动过程中图像信息的变换,利用几何原理计算相机相关参数,从而恢复重建出目标物体的三维点云信息。ROSSI等[69]使用一套旋转台成像系统,采集玉米和番茄植株图像,基于SfM方法进行点云重建,结果在株高等性状呈现出较好的一致性,其提出的点云分割算法能够准确的提取叶面积、叶倾角等性状[70]。SUN等[71]利用多视角成像系统在田间连续采集棉花图片信息,并通过点云重建,准确获得棉铃数量和体积信息。ZHANG等[72]利用深度学习中的神经辐射场(NeRF)技术,构建了NeRF-Ag模型,该模型基于农业场景中草莓种植环境的多角度图像数据,成功实现了点云重建。

仅通过对作物点云的获取无法实现对植物表型数据的有效提取,三维表型数据的有效提取依赖于准确的器官、单株分割。传统点云处理方法主要借助机器学习手段,通过分析不同器官和个体的点云分布差异来实现分割。常见的方法包括随机采样一致性(通过随机选择点集,根据特定几何模型拟合数据,去除不符合模型的点)、欧氏聚类(基于点云空间距离相似性进行分类)、区域生长(从种子点出发,根据生长准则合并符合条件的邻域点)、超体素分割(将三维空间划分为小体素块,并基于特征相似性进行聚类)等,最终提取的植物表型数据主要有植物高度、宽度、茎直径、体积、表面积、叶面积等数据[73]。

由于直接获取的点云数据存在噪声等问题,点云数据需要进行预处理以方便后续的数据处理。如RoAD在获取点云数据后,点云需要经过下采样、滤波等预处理,利用迭代最近点算法配准合并。接着,通过将2D图像前景映射到点云进行植物冠层分割,再基于表面平滑度和点连通性分离植物及叶片,提取如植物高度、体积等3D表型特征,最后用体素网格滤波器去除重复点,可获取植物高度、植物体积、凸包体积等植物形态数据,玉米植物还会采用点云骨架化方法进一步分析,处理后的数据用于获取叶片曲率和叶片长宽数据[51]。TANG团队[30,74]基于其自主研发的PhenoBot 3.0表型机器人,融合点云及图像数据,提出一种关键点提取及拟合方法,实现了玉米叶夹角、茎粗等表型性状提取,为研究株型相关表型提取提供新方法。徐胜勇等[75]使用邻域最值滤波改进算法,去除了深度相机重建过程中易出现的边缘点云噪声,通过深度学习方法能够精准获取黄瓜苗株的高度、茎粗、下胚轴等表型数据。杨琳等[76]提出一种结合超体素和区域增长的自适应分割算法,对油菜的多个物候期的表型数据实现了三维点云的有效分割。胡松涛等[77]利用可见光相机和激光扫描仪,结合马铃薯植株可见光图像和激光雷达数据,开发了分别从可见光图像和激光雷达点云中提取植株表型性状的有效方法,为未来的表型数据分析提供了更加有效的解决方案。此外,基于机器人平台的激光雷达能够深入到植株冠层以下部分,获取更准确、稠密的点云数据,从而更精准地提取植物表型性状[78]。例如,JIMENEZ-BERNI等[79]通过安装在轻型移动地面平台上的激光雷达,实现对树冠高度、地被覆盖和地上生物量的快速多时相无损估计。MADEC等[80]探索了搭载激光雷达的移动无人地面车辆和配备高分辨率RGB相机的无人机提供植物高度估计的能力,验证了植物高度与开花期前干旱影响的相关性。

不同三维点云获取方法和表型数据提取方法在精度、效率和适用范围上各有特点。在三维点云获取方面,激光雷达通常能提供高精度点云数据,但成本相对较高;而基于深度学习的重建方法在复杂场景下表现出较好的适应性,但该方法对计算资源要求较高。在表型数据提取方面,不同的分割算法适用于不同的植物表型和场景需求。如超体素分割在处理复杂结构植物时更具优势,而欧氏聚类则在简单几何形状的点云分割中更为高效。

光谱技术通过捕捉植物反射光线,收集其在不同波长下的反射率数据,该技术的应用极大深化对植物内部物质组成、结构及其特性的理解,光谱技术的核心在于分析光在物质中的反射、吸收和透射现象,从而揭示植物在生理和生化层面的细微变化。在植物表型研究中,光谱数据的获取与分析已成为不可或缺的手段。在实际研究过程,多光谱和高光谱相机是植物表型领域常用的光谱数据采集工具。多光谱相机主要捕捉几个特定波段的光谱信息,而高光谱相机则能够获取更连续、更细致的光谱数据,从而包含更丰富的植物生理信息。如何利用这些光谱数据来解析植物的生长状况是植物表型研究领域的关键环节。近年来,研究人员结合多种技术手段,成功开发了系列基于光谱数据的分析方法,并在不同场景中取得了显著成果。

在表型机器人的实际应用中,Ladybird搭载近红外高光谱(VNIR)线扫描相机采集,在采集数据前后,通过白色或灰色的标定板校准采集的光谱数据,通过NDVI值对地面和冠层的像素进行区分,最后通过归一化差异植被指数(NDVI)反应植物的生长情况,同时通过对比NDVI的差别对群体的冠层闭合度进行评估[8]。Phenomobile平台搭载了近红外光谱传感器,光谱采集时以速度1 m/s在田间进行数据采集,每条扫描线都带有GPS时间标记,以便基于RTK-GPS和车轮编码器的信息进行地理定位。利用田间收集冠层光谱反射率数据,并利用偏最小二乘回归(PLSR)构建模型,可以对小麦不同基因型之间的产量差异进行定性评估[81]。DEERY等[82]通过在田间收集光谱数据,实现了NDVI和PRI数据的计算。穗-病原体相互作用的生化和光谱变化与赤霉病的发展是一致的,这表明高光谱信息在改善精准农业应用中FHB(赤霉病)早期监测方面具有应用前景[83]。例如,利用高光谱反射数据预测整个生长季节的小麦产量,通过在灌浆早期(EGF)和灌浆中期(MGF)收集的光谱数据,通过遗传力分析表明DSLRE预测有效捕捉了遗传因素对产量变异的影响。

由于光谱数据预处理环境较多,其处理分析过程通常在数据获取后单独进行。已有的多光谱/高光谱数据处理方法及模型将为基于表型机器人采集的光谱数据解析提供参考。由于光谱数据能一定程度反映作物营养分布、代谢成分、水分含量、健康状况等信息[82,84-85],其在作物种子、植株等检测中得以广泛应用。如,赵爽等[86]结合透射和反射特征光谱集合并构建模型,实现对水稻成分(如粗蛋白、支链淀粉和水分)的无损分析。该方法避免了传统化学分析方法的繁琐步骤和潜在误差。XIE等[87]利用高光谱成像技术进行小麦冠腐病早期诊断,NAGASUBRAMANIAN等[88]通过选择的6个波段能够早期识别大豆炭腐病感染。在大田作物监测方面,刘红芸等[89]通过机载高光谱技术对采摘期的烟草叶片水分进行建模分析,能够精准解析烟叶的含水量,为烟草采集过程提供了重要的数据支撑。张天亮等[90]结合机器学习方法,对大田种植不同植密度的玉米植株进行了光谱数据采集,分析得到玉米种植的最佳抗倒伏密度,为作物种植密度的优化提供了科学依据。杨欣等[91]采集了植物多波段的表型数据,通过XGBoost(Extreme gradient boosting)集成学习算法成功构建了冬小麦全氮含量遥感反演模型,对不同土壤肥力条件下田块尺度的小麦氮素含量空间分布实现了有效推演。齐浩等[92]利用采集的小麦灌浆期的高光谱数据,通过与产量数据构建组合分析数据模型解决了小麦品系的产量估测问题。在国际研究领域,DEERY等[82]通过在田间收集光谱数据,实现了NDVI和PRI数据的计算,这些指数能够有效反映植物的生理状态和光合作用效率,为植物健康监测和环境适应性研究提供了重要工具。

尽管光谱数据在植物表型研究中展现出巨大潜力,但在实际应用中仍面临一些挑战。首先,高稳定性光谱数据获取通常要求稳定的光照条件、固定的采集高度等,基于表型机器人的光谱数据采集需要排除周围环境影响,这在农业场景尤其是室外环境存在巨大挑战,目前主要通过构建稳定光照环境或通过软件补偿校准方式进行弥补。且由于作物表型性状采集过程,海量待测目标株高存在差异,难以在动态采集过程保证光谱传感器和目标植株的距离一致,这对其数据一致性也存在影响。另外,光谱数据的复杂性要求研究人员具备专业的光谱分析知识和技能,且光谱数据的处理和分析需要结合先进的计算方法,如机器学习和人工智能技术,才能充分发挥其价值。此外,光谱数据的采集和分析成本较高,限制了其在大规模农业生产中的广泛应用。未来,随着光谱技术的不断发展和成本降低,光谱数据在植物表型研究中的应用将更加广泛。研究人员可以进一步探索光谱数据与其他多源数据(如气象数据、土壤数据等)的融合,以实现更全面的植物生长监测和精准农业管理[93]。同时,随着机器学习和人工智能技术的不断进步,光谱数据的处理和分析将更加高效和精准,为植物表型研究提供更强大的技术支持。

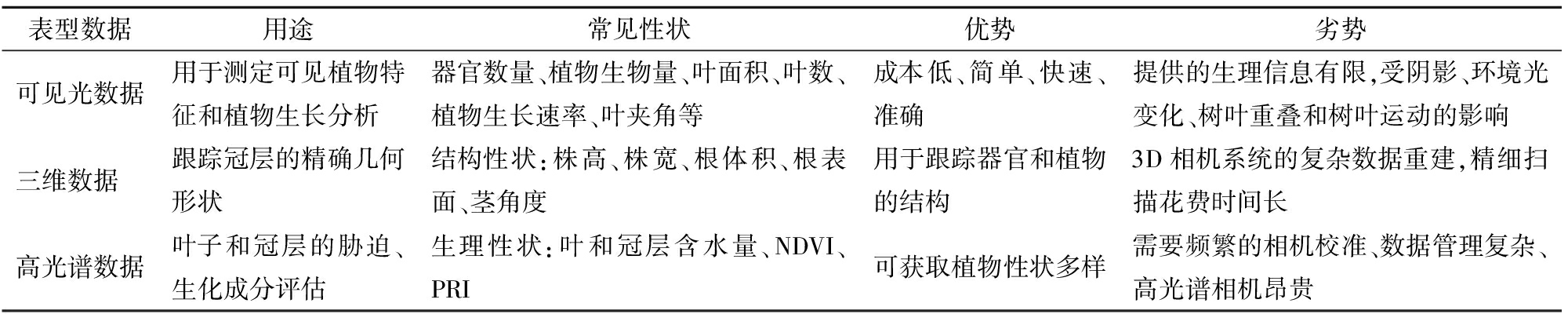

表2展示了表型机器人主要采集的3种表型数据及其功能特点。

表2 基于表型机器人的植物表型获取及解析

Tab.2 Plant phenotypic traits acquisition and analysis based on phenotype robots

表型数据用途常见性状优势劣势可见光数据用于测定可见植物特征和植物生长分析器官数量、植物生物量、叶面积、叶数、植物生长速率、叶夹角等成本低、简单、快速、准确提供的生理信息有限,受阴影、环境光变化、树叶重叠和树叶运动的影响三维数据跟踪冠层的精确几何形状结构性状:株高、株宽、根体积、根表面、茎角度用于跟踪器官和植物的结构3D相机系统的复杂数据重建,精细扫描花费时间长高光谱数据叶子和冠层的胁迫、生化成分评估生理性状:叶和冠层含水量、NDVI、PRI可获取植物性状多样需要频繁的相机校准、数据管理复杂、高光谱相机昂贵

在现代农业研究中,表型机器人作为植物表型研究的重要工具逐渐受到关注。近年来,尽管在传感器和机器人技术方面取得了较大进展,但开发能够在农业场景中稳定、高效作业的表型机器人仍然面临诸多挑战。

(1)育种科研场景全程无人化或少人化表型获取关键技术亟待突破。表型机器人优势在于其自动化和智能化程度,可以在设施或室外环境少人或无人操作时实现作物表型性状的自动采集,因此自主导航技术是表型机器人的关键技术之一。高通量表型检测通常为作物育种研究提供服务,而育种研究的种植模式与大规模农业生产场景不同,基于GNSS的导航技术难以满足表型机器人检测自主导航需求,通常需要融合视觉、激光雷达等传感器,结合作物动态生长过程进行导航,目前在作物表型检测场景中具有普适性的导航方法仍存在一定挑战。且实际育种科研中,通常需要对成千上万个小区的作物材料进行表型数据采集,虽然表型机器人采集效率与传统方法相比有很大的提高,但与无人机相比仍然偏低。例如,单个表型机器人采集作物二维图像、三维点云及高光谱数据需约250 h/hm2,难以保证数据采集过程的时间同步。

(2)农业场景及个性化表型采集需求制约表型机器人标准化进程。大部分表型机器人是针对特定作物和种植方式设计的,如受作物种植环境影响,适用于小麦、棉花等旱田种植作物的表型机器人不一定适用于水稻表型检测;受作物生长高度影响,适用于小麦全生育期的表型机器人不适用于玉米全生育期表型检测;受作物种植模式影响,跨行行驶的表型机器人难以大范围调整其行间距,应用适应性受限。由于表型机器人在作物行间或行内行走时可能会损坏植物,因此其设计受到诸如行间距等种植模式的影响,且这些因素通常受研究对象及研究目的影响而有所差异,使得在不牺牲功能的前提下设计能够在这些约束条件下稳定工作的表型机器人变得极具挑战,这在一定程度上制约了表型机器人标准化和商业化。

(3)多模态表型性状时空一致性采集需求对传感器采集方法提出新要求。作物表型性状通常包含颜色纹理、形态结构、生理组分等多方面表型,包含细胞、个体、群体等不同尺度表型。在作物育种相关研究过程的表型检测通常希望采集到的表型信息具有时空一致性,由于采集不同表型所采用的传感器种类不同,如颜色纹理相关性状通常采用可见光传感器,形态结构相关性状通常采用激光雷达或深度相机,生理组分相关性状通常采用近红外光谱传感器,而不同传感器的采集条件及采集模式各不相同,且在群体实验时,不同作物材料的高度差异明显会极大影响作物表型信息采集质量。作物表型信息采集过程尤其在室外环境中如何稳定、同步获取高质量作物多维表型信息极具挑战。

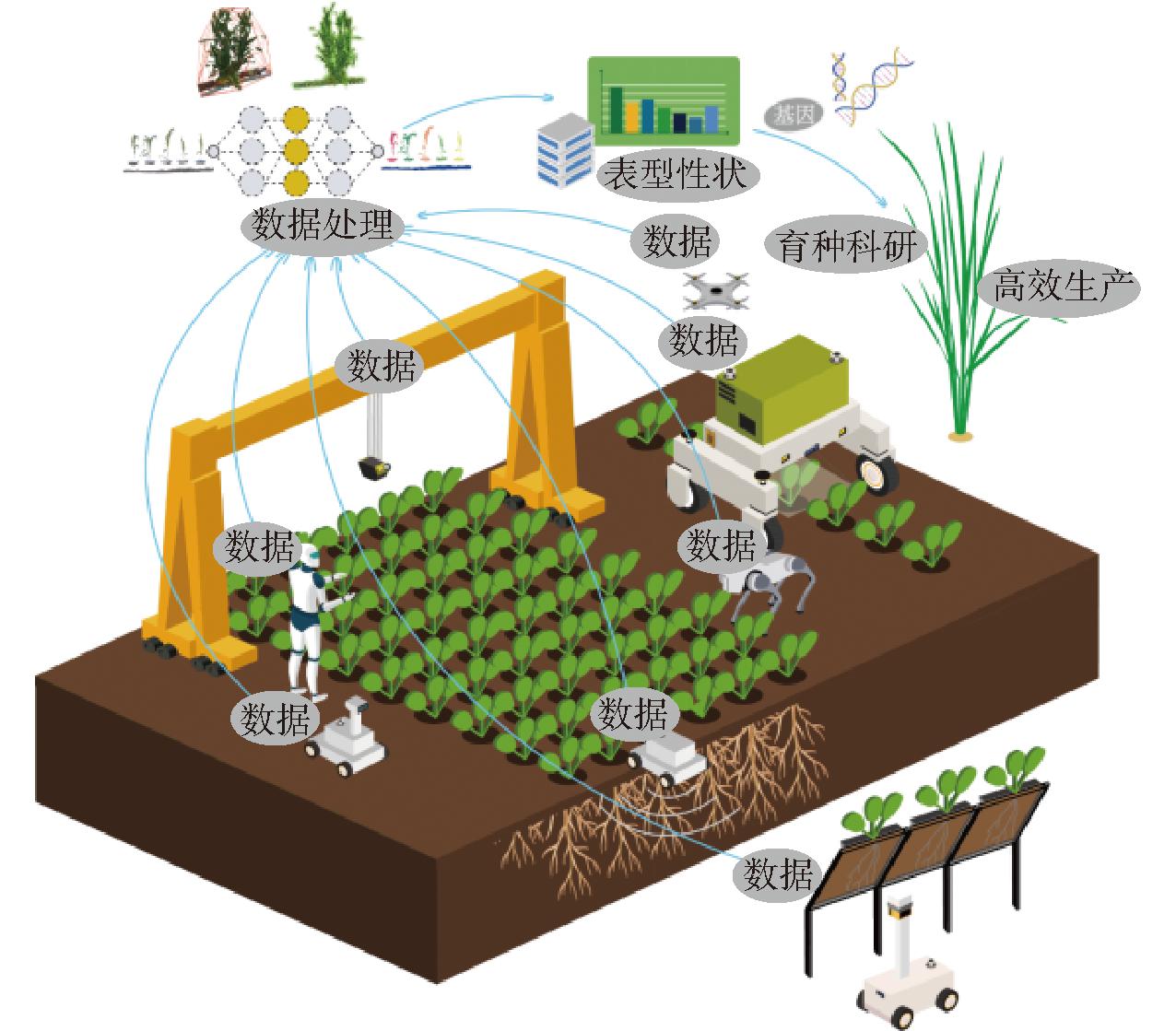

未来将会有更多的表型机器人深入农业研究及生产各个场景,全面、精准、高效获取作物全生育期表型数据(图6),助力数智育种及农业智慧生产发展。在智能感知、人工智能、机器人技术等领域高速发展的大环境下,作物表型机器人有如下发展趋势:

图6 作物表型机器人应用场景

Fig.6 Scenarios of crop phenotyping robots

(1)机器人多样性推动高通量表型检测快速发展

在作物表型检测过程,轮式或履带式移动机器人平台已被广泛应用,但随着机器人技术的快速发展,轮足式、足式、人形机器人等均已商业化并在不断探索具体场景应用,其配套的一体化驱控性能也在不断提升。这些技术的发展使得表型机器人的形式具有多样性,采用机器狗式或人形的表型机器人在移动灵活性及表型检测动作细致性优于已有表型检测机器人。除此之外,小型化、特殊模式的表型机器人有望成为未来表型研究的新方向,小型化机器人能够更好地适应田间复杂多变的地形,具有在大田中近距离采集植物表型的潜在应用价值,小型化机器人体积较小、成本较低,使得采用群体机器人进行大量样本表型采集成为可能,这将大大提高作物表型性状采集效率。与此同时,无人机和表型机器人在作物表型检测中各具优势,二者的协同作业将为作物表型检测提供新的突破性应用[94]。

(2)人工智能技术促进表型高效获取与解析

目前表型机器人在农业领域多依赖规则化控制完成作业,与完全自主作业仍有差距。随着人工智能向端到端解决方案发展,农业领域急需成熟的智能化采集策略与全面导航数据[95]。机器人本体控制优化是关键,通过充分发挥机械结构优势,结合多种运动模式,可增强其在大田的运行能力。将具身智能技术融入表型机器人系统,使其能基于环境感知自主决策,实现智能表型数据的有效获取。通过先进算法对获取的数据进行深度解析,挖掘数据背后的植物生长规律与特征[96-97]。未来,表型机器人将进一步深入融合作物代谢组、基因组、环境组与种植管理数据,构建全面的育种数据库[98]。利用大数据分析与人工智能技术,深入解析基因与表型关系,为智慧育种提供精准指导,推动农业育种技术的革命性变革[99]。

(3)表型机器人与新型传感器协同创新

当前表型数据采集多依靠可见光、激光雷达、多光谱、高光谱等传感器,难以全面满足现代作物育种研究需求。新型农业传感器的研发如激光诱导击穿光谱[100]、电化学感知传感器[101]、显微成像传感器[102]等用于植物体内活性物质含量、微观表型信息采集等将成为重要的发展方向。例如,激光诱导击穿光谱技术因其快速、实时、原位检测等优点,已在植物元素分析中展现出巨大潜力。作物离子流及活性小分子检测传感器基于电化学原理[103],可进行作物体内活性小分子及主要离子运输速率检测。显微成像传感器可观测作物根毛特征,甚至可以深入到细胞尺度进行表型性状检测[104]。这些传感器的研制为表型深入研究奠定基础,未来结合机器人技术,全方位实现植物微观-宏观、物理-生理、地上-地下部分表型无人化、高效提取,为植物长势机理分析、遗传机制解析等提供更全面的解决方案。

[1] 黄怡淳.中国作物育种研究热点与发展趋势——基于创新要素供给视角[J].农业图书情报学报,2022,34(5):31-46.HUANG Yichun.Research on the development trend of crop breeding in China from the supply of innovative elements[J].Journal of Library and Information Sciences in Agriculture,2022,34(5):31-46.(in Chinese)

[2] 温维亮,郭新宇,张颖,等.作物表型组大数据技术及装备发展研究[J].中国工程科学,2023,25(4):227-238.WEN Weiliang,GUO Xinyu,ZHANG Ying,et al.Technology and equipment of big data on crop phenomics[J].Strategic Study of CAE,2023,25(4):227-238.(in Chinese)

[3] 程曼,袁洪波,蔡振江,等.田间作物高通量表型信息获取与分析技术研究进展[J].农业机械学报,2020,51(增刊1):314-324.CHENG Man,YUAN Hongbo,CAI Zhenjiang,et al.Review of field-based information acquisition and analysis of high-throughput phenotyping[J].Transactions of the Chinese Society for Agricultural Machinery,2020,51(Supp.1):314-324.(in Chinese)

[4] 赵春江.智慧农业的发展现状与未来展望[J].华南农业大学学报,2021,42(6):1-7.ZHAO Chunjiang.Current situations and prospects of smart agriculture[J].Journal of South China Agricultural University,2021,42(6):1-7.(in Chinese)

[5] 郭庆华,杨维才,吴芳芳,等.高通量作物表型监测:育种和精准农业发展的加速器[J].中国科学院院刊,2018,33(9):940-946.GUO Qinghua,YANG Weicai,WU Fangfang,et al.High-throughputcrop phenotyping:accelerators for development of breeding and precision agriculture[J].Bulletin of the Chinese Academy of Sciences,2018,33(9):940-946.(in Chinese)

[6] RUCKELSHAUSEN A,BIBER P,DORNA M,et al.BoniRob:an autonomous field robot platform for individual plant phenotyping[M]∥Precision Agriculture’09.Wageningen Academic,2009:841-847.

[7] GOETTINGER M,SCHOLZ C,MOELLER K,et al.GNSS-based navigation for the multipurpose field robot platform BoniRob to measure soil properties[C]∥72 International Conference Agricultural Engineering,2014.

[8] BENDER A,WHELAN B,SUKKARIEH S.A high-resolution,multimodal data set for agricultural robotics:a Ladybird’s-eye view of Brassica[J].Journal of Field Robotics,2019,37(1):73-96.

[9] GRIMSTAD L,FROM P.The Thorvald Ⅱ agricultural robotic system[J].Robotics,2017,6(4):24.

[10] SHAFIEKHANI A,KADAM S,FRITSCHI F B,et al.Vinobot and vinoculer:two robotic platforms for high-throughput field phenotyping[J].Sensors,2017,17(12):214.

[11] YOUNG S N,KAYACAN E,PESCHEL J M.Design and field evaluation of a ground robot for high-throughput phenotyping of energy sorghum[J].Precision Agriculture,2018,20(4):697-722.

[12] CALERA EST VO SERAFIM,DE O G C,LIMA A G,et al.Under-canopy navigation for an agricultural rover based on image data[J].Journal of Intelligent &Robotic Systems:Theory &Application,2023,108(2):29.

VO SERAFIM,DE O G C,LIMA A G,et al.Under-canopy navigation for an agricultural rover based on image data[J].Journal of Intelligent &Robotic Systems:Theory &Application,2023,108(2):29.

[13] 唐政,余越,刘羽飞,等.田间作物表型获取无人车平台主体结构设计与优化[J].浙江大学学报(农业与生命科学版),2023,49(2):280-292.TANG Zheng,YU Yue,LIU Yufei,et al.Design and optimization of main structure of unmanned vehicle-based field crop phenotyping platform[J].Journal of Zhejiang University (Agriculture &Life Sciences),2023,49(2):280-292.(in Chinese)

[14] 徐圣林,朱立成,韩振浩,等.作物表型信息获取机器人底盘设计与试验[J].农业机械学报,2023,54(增刊2):388-399.XU Shenglin,ZHU Licheng,HAN Zhenhao,et al.Design and experiment of robot chassis for obtaining crop-phenotypic information[J].Transactions of the Chinese Society for Agricultural Machinery,2023,54(Supp.2):388-399.(in Chinese)

[15] 卢少志,杨蒙,杨万能,等.田间作物表型检测平台设计与试验[J].华中农业大学学报,2021,40(4):209-218.LU Shaozhi,YANG Meng,YANG Wanneng,et al.Design and experiment of a platform for detecting phenotype of field crop[J].Journal of Huazhong Agricultural University,2021,40(4):209-218.(in Chinese)

[16] YANG M,HUANG C,LI Z,et al.Autonomous navigation method based on RGB-D camera for a crop phenotyping robot[J].Journal of Field Robotics,2024,41(8):2663-2675.

[17] 潘宇真,魏佳炜,KHAN Rezwan Al Islam,等.新型模块化农业机器人设计分析与冗余协同控制[J].机械工程学报,2024,60(23):88-101.PAN Yuzhen,WEI Jiawei,KHAN Rezwan Al Islam,et al.Design and analysis of a novel modular agricultural robot with its redundant cooperative control strategy[J].Journal of Mechanical Engineering,2024,60(23):88-101.(in Chinese)

[18] 邱小雷,张小虎,李彦,等.作物表型巡检机器人实验平台设计与教学应用[J].教育教学论坛,2024(39):21-24.QIU Xiaolei,ZHANG Xiaohu,LI Yan,et al.Design and teaching application of experimental platform for crop phenotype inspection robot[J].Education Teaching Forum,2024(39):21-24.(in Chinese)

[19] 陈学深,熊悦淞,王宣霖,等.基于触觉感知的稻田苗带区域杂草密度等级评估[J].农业工程学报,2023,39(2):116-125.CHEN Xueshen,XIONG Yuesong,WANG Xuanlin,et al.Evaluation of weed density grade in paddy field seedling line zone based on tactile perception[J].Transactions of the CSAE,2023,39(2):116-125.(in Chinese)

[20] FAN Z,SUN N,QIU Q,et al.In situ measuring stem diameters of maize crops with a high-throughput phenotyping robot[J].Remote Sensing,2022,14(4):1030.

[21] 樊江川,王源桥,苟文博,等.基于实例分割技术的草莓叶龄及冠幅表型快速提取方法[J].智慧农业(中英文),2024,6(2):95-106.FAN Jiangchuan,WANG Yuanqiao,GOU Wenbo,et al.Fast extracting method for strawberry leaf age and canopy width based on instance segmentation technology[J].Smart Agriculture,2024,6(2):95-106.(in Chinese)

[22] 闫全涛,李丽霞,邱权,等.小型农田原状土样采集机器人系统研发与测试[J].智能化农业装备学报(中英文),2024,5(1):12-22.YAN Quantao,LI Lixia,QIU Quan,et al.development and test of a small robotic system for in-field undisturbed soil sampling[J].Journal of Intelligent Agricultural Equipment,2024,5(1):12-22.(in Chinese)

[23] 孙景彬,刘志杰,杨福增,等.丘陵山地农业装备与坡地作业关键技术研究综述[J].农业机械学报,2023,54(5):1-18.SUN Jingbin,LIU Zhijie,YANG Fuzeng,et al.Research review of agricultural equipment and slope operation key technologies in hilly and mountains region[J].Transactions of the Chinese Society for Agricultural Machinery,2023,54(5):1-18.(in Chinese)

[24] LI Q,XU Y.Minimum-time row transition control of a vision-guided agricultural robot[J].Journal of Field Robotics,2021,39(4):335-354.

[25] LE T D,PONNAMBALAM V R,GJEVESTAD J G O,et al.A low-cost and efficient autonomous row-following robot for food production in polytunnels[J].Journal of Field Robotics,2019,37(2):309-321.

[26] XU R,LI C.A modular agricultural robotic system (MARS) for precision farming:concept and implementation[J].Journal of Field Robotics,2022,39(4):387-409.

[27] UNDERWOOD J,WENDEL A,SCHOFIELD B,et al.Efficient in-field plant phenomics for row-crops with an autonomous ground vehicle[J].Journal of Field Robotics,2017,34(6):1061-1083.

[28] GÜLDENRING R,VAN EVERT F K,NALPANTIDIS L.RumexWeeds:a grassland dataset for agricultural robotics[J].Journal of Field Robotics,2023,40(6):1639-1656.

[29] BAWDEN O,KULK J,RUSSELL R,et al.Robot for weed species plant-specific management[J].Journal of Field Robotics,2017,34(6):1179-1199.

[30] XIANG L,GAI J,BAO Y,et al.Field-based robotic leaf angle detection and characterization of maize plants using stereo vision and deep convolutional neural networks[J].Journal of Field Robotics,2023,40(5):1034-1053.

[31] 田永浩,刘禹,张硕,等.面向大田作物冠层信息采集的自走式轮式平台设计与试验[J].农业机械学报,2024,55(增刊1):101-107.TIAN Yonghao,LIU Yu,ZHANG Shuo,et al.Design and test of self-propelled wheeled platform for field crop canopy information collection[J].Transactions of the Chinese Society for Agricultural Machinery,2024,55(Supp.1):101-107.(in Chinese)

[32] LI S,ZHANG Z,DU F,et al.A new automatic real-time crop row recognition based on SoC-FPGA[J].IEEE Access,2020,8:37440-37452.

[33] 关卓怀,陈科尹,丁幼春,等.水稻收获作业视觉导航路径提取方法[J].农业机械学报,2020,51(1):19-28.GUAN Zhuohuai,CHEN Keyin,DING Youchun,et al.Visual navigation path extraction method in rice harvesting[J].Transactions of the Chinese Society for Agricultural Machinery,2020,51(1):19-28.(in Chinese)

[34] 赵腾,野口伸,杨亮亮,等.基于视觉识别的小麦收获作业线快速获取方法[J].农业机械学报,2016,47(11):32-37.ZHAO Teng,NOBORU Noguchi,YANG Liangliang,et al.Fast edge detection method for wheat field based on visual recognition[J].Transactions of the Chinese Society for Agricultural Machinery,2016,47(11):32-37.(in Chinese)

[35] SIVAKUMAR A N,MODI S,GASPARINO M V,et al.Learned visual navigation for under-canopy agricultural robots[J].arXiv Preprint,arXiv:2107.02792,2021.

[36] KAYACAN E,ZHANG Z,CHOWDHARY G.Embedded high precision control and corn stand counting algorithms for an ultra-compact 3D printed field robot[C]∥Robotics:Science and Systems,2018:9.

[37] DE SILVA R,CIELNIAK G,GAO J.Towards agricultural autonomy:crop row detection under varying field conditions using deep learning[J].arXiv Preprint,arXiv:2109.08247,2021.

[38] 卢心缘,赵华民,任锐,等.基于YOLOv5s-seg的非结构化枣园视觉导航路径提取[J].南京农业大学学报,2024,47(6):1241-1250.LU Xinyuan,ZHAO Huamin,REN Rui,et al.Unstructured jujube garden visual navigation path extraction based on YOLOv5s-seg[J].Journal of Nanjing Agricultural University,2024,47(6):1241-1250.(in Chinese)

[39] CHEBROLU N,LOTTES P,SCHAEFER A,et al.Agricultural robot dataset for plant classification,localization and mapping on sugar beet fields[J].The International Journal of Robotics Research,2017,36(10):1045-1052.

[40] CROCETTI F,BELLOCCHIO E,DIONIGI A,et al.ARD-VO:agricultural robot data set of vineyards and olive groves[J].Journal of Field Robotics,2023,40(6):1678-1696.

[41] AGUIAR A S,DOS SANTOS F N,CUNHA J B,et al.Localization and mapping for robots in agriculture and forestry:a survey[J].Robotics,2020,9(4):97.

[42] 窦汉杰,陈震宇,翟长远,等.果园智能化作业装备自主导航技术研究进展[J].农业机械学报,2024,55(4):1-22.DOU Hanjie,CHEN Zhenyu,ZHAI Changyuan,et al.Research progress on autonomous navigation technology for orchard intelligent equipment[J].Transactions of the Chinese Society for Agricultural Machinery,2024,55(4):1-22.(in Chinese)

[43] GIMENEZ J,SANSONI S,TOSETTI S,et al.Trunk detection in tree crops using RGB-D images for structure-based ICM-SLAM[J].Computers and Electronics in Agriculture,2022,199:107099.

[44] TANG J,CHEN Y,KUKKO A,et al.SLAM-aided stem mapping for forest inventory with small-footprint mobile LiDAR[J].Forests,2015,6(12):4588-4606.

[45] PIRE T,MUJICA M,CIVERA J,et al.The rosario dataset:multisensor data for localization and mapping in agricultural environments[J].International Journal of Robotics Research,2019,38(6):633-641.

[46] REIS R,DOS SANTOS,F N,et al.Forest robest and data sets for biomass collection[C]∥Robot 2019:Fourth Iberian Robotics Conference,2019:152-163.

[47] LIU C,FENG Q,SUN Y,et al.YOLACTFusion:an instance segmentation method for RGB-NIR multimodal image fusion based on an attention mechanism[J].Computers and Electronics in Agriculture,2023,213:108186.

[48] YAMATI F R I,BMER J,NOACK N,et al.Configuration of a multisensor platform for advanced plant phenotyping and disease detection:case study on cercospora leaf spot in sugar beet[J].Smart Agricultural Technology,2025,10:100740.

[49] LI Y,QI X,CAI Y,et al.A rice leaf area index monitoring method based on the fusion of data from RGB camera and multi-spectral camera on an inspection robot[J].2024,16(24):4725.

[50] QIU R,ZHANG M,HE Y.Field estimation of maize plant height at jointing stage using an RGB-D camera[J].The Crop Journal,2022,10(5):1274-1283.

[51] XIANG L,NOLAN T M,BAO Y,et al.Robotic assay for drought (RoAD):an automated phenotyping system for brassinosteroid and drought responses[J].Plant J.,2021,107(6):1837-1853.

[52] 黄成龙,张雪海,吴迪,等.基于时间序列的玉米叶片性状动态提取方法研究[J].农业机械学报,2017,48(5):174-178,198.HUANG Chenglong,ZHANG Xuehai,WU Di,et al.Dynamic extraction method of maize leaf traits based on time series[J].Transactions of the Chinese Society for Agricultural Machinery,2017,48(5):174-178,198.(in Chinese)

[53] 吴兰兰,熊利荣,彭辉.基于RGB植被指数的大田油菜图像分割定量评价[J].华中农业大学学报,2019,38(2):109-113.WU Lanlan,XIONG Lirong,PENG Hui.Quantitative evaluation of in-field rapeseed image segmentation based on RGB vegetation indices[J].Journal of Huazhong Agricultural University,2019,38(2):109-113.(in Chinese)

[54] 翟瑞芳,方益杭,林承达,等.基于高斯HI颜色算法的大田油菜图像分割[J].农业工程学报,2016,32(8):142-147.ZHAI Ruifang,FANG Yihang,LIN Chengda,et al.Segmentation of field rapeseed plant image based on Gaussian HI color algorithm[J].Transactions of the CSAE,2016,32(8):142-147.(in Chinese)

[55] XU WANG K R T,JEFFREY W W,ANDREW N F,et al.Approaches for geospatial processing of field-based high-throughput plant phenomics data from ground vehicle platforms[J].Transactions of the ASABE,2016,59(5):1053-1067.

[56] LI Z,ZHU Y,SUI S,et al.Real-time detection and counting of wheat ears based on improved YOLOv7[J].Computers and Electronics in Agriculture,2024,218:108670.

[57] SONG X,LIU L,WANG C,et al.Real-time determination of flowering period for field wheat based on improved YOLOv5s model[J].Frontiers in Plant Science,2023,13:1025663.

[58] 段凌凤,王新轶,王治昊,等.基于改进Pix2Pix-HD网络的多品种水稻生长可视化预测方法[J].作物学报,2024,50(12):3083-3095.DUAN Lingfeng,WANG Xinyi,WANG Zhihao,et al.Growth visualized prediction method of multi-variety rice based on improved Pix2Pix-HD network[J].Acta Agronomica Sinica,2024,50(12):3083-3095.(in Chinese)

[59] 杨万里,段凌凤,杨万能.基于深度学习的水稻表型特征提取和穗质量预测研究[J].华中农业大学学报,2021,40(1):227-235.YANG Wanli,DUAN Lingfeng,YANG Wanneng.Deep learning-based extraction of rice phenotypic characteristics and prediction of rice panicle weight[J].Journal of Huazhong Agricultural University,2021,40(1):227-235.(in Chinese)

[60] 张林鍹,巴音塔娜,曾庆松.基于StyleGAN2-ADA和改进YOLO v7的葡萄叶片早期病害检测方法[J].农业机械学报,2024,55(1):241-252.ZHANG Linxuan,BA Yintana,ZENG Qingsong.Grape disease detection method based on StyleGAN2-ADA and improved YOLO v7[J].Transactions of the Chinese Society for Agricultural Machinery,2024,55(1):241-252.(in Chinese)

[61] WANG X,LIU J.An efficient deep learning model for tomato disease detection[J].Plant Methods,2024,20(1):61.

[62] REIS H C,TURK V.Potato leaf disease detection with a novel deep learning model based on depthwise separable convolution and transformer networks[J].Engineering Applications of Artificial Intelligence,2024,133:108307.

[63] NAZEER R,ALI S,HU Z H,et al.Detection of cotton leaf curl disease’s susceptibility scale level based on deep learning[J].J.Cloud Comput-Adv S.,2024,13(1):50.

[64] 张慧春,周宏平,郑加强,等.植物表型平台与图像分析技术研究进展与展望[J].农业机械学报,2020,51(3):1-17.ZHANG Huichun,ZHOU Hongping,ZHENG Jiaqiang,et al.Research progress and prospect in plant phenotyping platform and image analysis technology[J].Transactions of the Chinese Society for Agricultural Machinery,2020,51(3):1-17.(in Chinese)

[65] QIU Q,SUN N,BAI H,et al.Field-based high-throughput phenotyping for maize plant using 3D LiDAR point cloud generated with a “phenomobile”[J].Front.Plant Sci.,2019,10:554.

[66] NGUYEN P,BADENHORST P E,SHI F,et al.Design of an unmanned ground vehicle and LiDAR pipeline for the high-throughput phenotyping of biomass in perennial ryegrass[J].Remote Sensing,2021,13(1):20.

[67] SONG P,LI Z,YANG M,et al.Dynamic detection of three-dimensional crop phenotypes based on a consumer-grade RGB-D camera[J].Frontiers in Plant Science,2023,14:1097725.

[68] WU D,YU L,YE J,et al.Panicle-3D:a low-cost 3D-modeling method for rice panicles based on deep learning,shape from silhouette,and supervoxel clustering[J].The Crop Journal,2022,10(5):1386-1398.

[69] ROSSI R,LEOLINI C,COSTAFREDA-AUMEDES S,et al.Performances evaluation of a low-cost platform for high-resolution plant phenotyping[J].Sensors,2020,20(11):3150.

[70] ROSSI R,COSTAFREDA-AUMEDES S,LEOLINI L,et al.Implementation of an algorithm for automated phenotyping through plant 3D-modeling:a practical application on the early detection of water stress[J].Computers and Electronics in Agriculture,2022,197:106937.

[71] SUN S,LI C,CHEE P W,et al.Three-dimensional photogrammetric mapping of cotton bolls in situ based on point cloud segmentation and clustering[J].ISPRS Journal of Photogrammetry and Remote Sensing,2020,160:195-207.

[72] ZHANG J,WANG X,NI X,et al.Neural radiance fields for multi-scale constraint-free 3D reconstruction and rendering in orchard scenes[J].Computers and Electronics in Agriculture,2024,217:108629.

[73] SALAS FERNANDEZ M G,BAO Y,TANG L,et al.A high-throughput,field-based phenotyping technology for tall biomass crops1[OPEN][J].Plant Physiology,2017,174:2008-2022.

[74] BAO Y,TANG L,SRINIVASAN S,et al.Field-based architectural traits characterisation of maize plant using time-of-flight 3D imaging[J].Biosystems Engineering,2019,178:86-101.

[75] 徐胜勇,李磊,童辉,等.基于RGB-D相机的黄瓜苗3D表型高通量测量系统研究[J].农业机械学报,2023,54(7):204-213,281.XU Shengyong,LI Lei,TONG Hui,et al.High-throughput measurement system for 3D phenotype of cucumber seedlings using RGB-D camera[J].Transactions of the Chinese Society for Agricultural Machinery,2023,54(7):204-213,281.(in Chinese)

[76] 杨琳,翟瑞芳,阳旭,等.结合超体素和区域增长的植物器官点云分割[J].计算机工程与应用,2019,55(16):197-203.YANG Lin,ZHAI Ruifang,YANG Xu,et al.Segmentation of plant organs point clouds through super voxel-based region growing methodology[J].Computer Engineering and Applications,2019,55(16):197-203.(in Chinese)

[77] 胡松涛,翟瑞芳,王应华,等.基于多源数据的马铃薯植株表型参数提取[J].智慧农业(中英文),2023,5(1):132-145.HU Songtao,ZHAI Ruifang,WANG Yinghua,et al.Extraction of potato plant phenotypic parameters based on multi-source data[J].Smart Agriculture,2023,5(1):132-145.(in Chinese)

[78] MANISH R,LIN Y C,RAVI R,et al.Development of a miniaturized mobile mapping system for in-row,under-canopy phenotyping[J].Remote Sensing,2021,13(2):276.

[79] JIMENEZ-BERNI J A,DEERY D M,ROZAS-LARRAONDO P,et al.High throughput determination of plant height,ground cover,and above-ground biomass in wheat with LiDAR[J].Frontiers in Plant Science,2018,9:237.

[80] MADEC S,BARET F,DE SOLAN B,et al.High-throughput phenotyping of plant height:comparing unmanned aerial vehicles and ground LiDAR estimates[J].Frontiers in Plant Science,2017,8:2002.

[81] FERRIO J P,VILLEGAS D,ZARCO J,et al.Assessment of durum wheat yield using visible and near-infrared reflectance spectra of canopies[J].Field Crops Research,2005,94(2-3):126-148.

[82] DEERY D,JIMENEZ-BERNI J,JONES H,et al.Proximal remote sensing buggies and potential applications for field-based phenotyping[J].Agronomy,2014,4(3):349-379.

[83] MUSTAFA G,ZHENG H B,KHAN I H,et al.Enhancing fusarium head blight detection in wheat crops using hyperspectral indices and machine learning classifiers[J].Computers and Electronics in Agriculture,2024,218:108663.

[84] FENG H,CHEN G,XIONG L,et al.Accurate digitization of the chlorophyll distribution of individual rice leaves using hyperspectral imaging and an integrated image analysis pipeline[J].Frontiers in Plant Science,2017,8:1238.

[85] LI D,TIAN L,WAN Z F,et al.Assessment of unified models for estimating leaf chlorophyll content across directional-hemispherical reflectance and bidirectional reflectance spectra[J].Remote Sensing of Environment,2019,231:111240.

[86] 赵爽,宋京燕,陈国兴,等.基于水稻种粒高光谱的品质性状预测方法[J].华中农业大学学报,2023,42(3):211-219.ZHAO Shuang,SONG Jingyan,CHEN Guoxing,et al.A method for predicting rice quality based on hyperspectral analysis of rice seed[J].Journal of Huazhong Agricultural University,2023,42(3):211-219.(in Chinese)

[87] XIE Y,PLETT D,EVANS M,et al.Hyperspectral imaging detects biological stress of wheat for early diagnosis of crown rot disease[J].Computers and Electronics in Agriculture,2024,217:108571.

[88] NAGASUBRAMANIAN K,JONES S,SARKAR S,et al.Hyperspectral band selection using genetic algorithm and support vector machines for early identification of charcoal rot disease in soybean stems[J].Plant Methods,2018,14:86.

[89] 刘红芸,吴雪梅,李德仑,等.基于高光谱技术的采摘期烟叶水分含量研究[J].中国农机化学报,2021,42(9):157-163.LIU Hongyun,WU Xuemei,LI Delun,et al.Study on the moisture content of tobacco leaves during the picking period based on hyperspectral technology[J].Journal of Chinese Agricultural Mechanization,2021,42(9):157-163.(in Chinese)

[90] 张天亮,张东兴,崔涛,等.高光谱成像鉴别玉米品种早期抗倒性[J].光谱学与光谱分析,2022,42(4):1229-1234.ZHANG Tianliang,ZHANG Dongxing,CUI Tao,et al.Identification of early lodging resistance of maize by hyperspectral imaging technology[J].Spectroscopy and Spectral Analysis,2022,42(4):1229-1234.(in Chinese)

[91] 杨欣,袁自然,叶寅,等.基于无人机高光谱遥感的冬小麦全氮含量反演[J].光谱学与光谱分析,2022,42(10):3269-3274.YANG Xin,YUAN Ziran,YE Yin,et al.Winter wheat total nitrogen content estimation based on UAV hyperspectral remote sensing[J].Spectroscopy and Spectral Analysis,2022,42(10):3269-3274.(in Chinese)

[92] 齐浩,吕亮杰,孙海芳,等.基于无人机高光谱遥感与机器学习的小麦品系产量估测研究[J].农业机械学报,2024,55(7):260-269.QI Hao,LÜ Liangjie,SUN Haifang,et al.Yield estimation of wheat lines based on UAV hyperspectral remote sensing and machine learning[J].Transactions of the Chinese Society for Agricultural Machinery,2024,55(7):260-269.(in Chinese)

[93] 李道亮,赵晔,杜壮壮.农业领域多模态融合技术方法与应用研究进展[J].农业机械学报,2025,56(1):1-15.LI Daoliang,ZHAO Ye,DU Zhuangzhuang.Advances in multi-modal fusion techniques and applications in agricultural field[J].Transactions of the Chinese Society for Agricultural Machinery,2025,56(1):1-15.(in Chinese)

[94] 杨扬,刘洋,苏宸,等.基于超分辨率重建与机器学习的油菜苗情监测方法[J].农业机械学报,2024,55(6):196-201.YANG Yang,LIU Yang,SU Chen,et al.Seed rape seedling monitoring method based on super-resolution reconstruction and machine learning[J].Transactions of the Chinese Society for Agricultural Machinery,2024,55(6):196-201.(in Chinese)

[95] 陈明方,黄良恩,王森,等.移动机器人视觉里程计技术研究综述[J].农业机械学报,2024,55(3):1-20.CHEN Mingfang,HUANG Liang’en,WANG Sen,et al.Survey of research on visual odometry technology for mobile robots[J].Transactions of the Chinese Society for Agricultural Machinery,2024,55(3):1-20.(in Chinese)

[96] 陆声链,李沂杨,李帼,等.基于RGB与深度图像融合的生菜表型特征估算方法[J].农业机械学报,2025,56(1):84-91,101.LU Shenglian,LI Yiyang,LI Guo,et al.Lettuce phenotype estimation using integrated RGB-depth image synergy[J].Transactions of the Chinese Society for Agricultural Machinery,2025,56(1):84-91,101.(in Chinese)

[97] 朱磊,江伟,孙伯颜,等.基于神经辐射场的苗期作物三维建模和表型参数获取[J].农业机械学报,2024,55(4):184-192,230.ZHU Lei,JIANG Wei,SUN Boyan,et al.Three-dimensional reconstruction and phenotype parameters acquisition of seeding vegetables based on neural radiance fields[J].Transactions of the Chinese Society for Agricultural Machinery,2024,55(4):184-192,230.(in Chinese)

[98] 翟肇裕,张梓涵,徐焕良,等.YOLO算法在动植物表型研究中应用综述[J].农业机械学报,2024,55(11):1-20.ZHAI Zhaoyu,ZHANG Zihan,XU Huanliang,et al.Review of applying YOLO family algorithms to analyze animal and plant phenotype[J].Transactions of the Chinese Society for Agricultural Machinery,2024,55(11):1-20.(in Chinese)

[99] 袁培森,李润隆,王翀,等.基于BERT的水稻表型知识图谱实体关系抽取研究[J].农业机械学报,2021,52(5):151-158.YUAN Peisen,LI Runlong,WANG Chong,et al.Entity relationship extraction from rice phenotype knowledge graph based on BERT[J].Transactions of the Chinese Society for Agricultural Machinery,2021,52(5):151-158.(in Chinese)

[100] 张俊宁,方宪法,张小超,等.基于激光诱导击穿光谱的土壤钾素检测[J].农业机械学报,2014,45(10):294-299.ZHANG Junning,FANG Xianfa,ZHANG Xiaochao,et al.Detection of soil potassium content based on laser-induced breakdown spectroscopy[J].Transactions of the Chinese Society for Agricultural Machinery,2014,45(10):294-299.(in Chinese)

[101] 丁露雨,吕阳,李奇峰,等.融合多环境参数的鸡粪氨气排放预测模型研究[J].农业机械学报,2022,53(5):366-375.DING Luyu,LÜ Yang,LI Qifeng,et al.Prediction model of ammonia emission from chicken manure based on fusion of multiple environmental parameters[J].Transactions of the Chinese Society for Agricultural Machinery,2022,53(5):366-375.(in Chinese)

[102] 徐胜勇,段宏兵,李东臣,等.小麦茎秆截面参数显微图像测量系统[J].农业机械学报,2017,48(7):46-52.XU Shengyong,DUAN Hongbing,LI Dongchen,et al.Measurement system for parameters of wheat stem section based on microimage processing[J].Transactions of the Chinese Society for Agricultural Machinery,2017,48(7):46-52.(in Chinese)

[103] 栾雅珺,徐俊增,李亚威,等.极性交换电场辅助植物修复稻田土壤镉污染研究[J].农业机械学报,2024,55(3):331-339.LUAN Yajun,XU Junzeng,LI Yawei,et al.Electrokinetic-assisted phytoremediation of soil cadmium pollution in paddy fields under polarity exchange technology[J].Transactions of the Chinese Society for Agricultural Machinery,2024,55(3):331-339.(in Chinese)

[104] 翁海勇,李效彬,肖康松,等.基于Mask R-CNN的柑橘主叶脉显微图像实例分割模型[J].农业机械学报,2023,54(7):252-258,271.WENG Haiyong,LI Xiaobin,XIAO Kangsong,et al.Instance segmentation model for microscopic image of citrus main leaf vein based on Mask R-CNN[J].Transactions of the Chinese Society for Agricultural Machinery,2023,54(7):252-258,271.(in Chinese)