0 引言

小麦是我国的主要粮食作物之一,在国家粮食安全体系构建中发挥着重要作用[1-2]。小麦赤霉病是由多种镰刀菌引起的全球小麦生产中最广泛和最具破坏力的病害之一[3-4],严重时会减产80%~90%,甚至颗粒无收,且赤霉病产生的次生代谢产物均为毒素,人畜误食后严重危害健康。因此在小麦生长过程中实现赤霉病发生发展的及时准确监测,进而采取有效的防治措施,对确保小麦优质、高效、安全生产具有重要意义。此外从GB/T 15796—2011《小麦赤霉病测报技术规范》中了解到,统计小麦赤霉病病小穗数是获取赤霉病病情严重度的重要依据,且是研究小麦抗性育种(抗赤霉病)的重要指标。因此,实现对小麦小穗赤霉病的检测有利于评估病害对小麦产量和质量的影响,指导农户和相关人员采取相应的控制和管理措施。

目前针对小麦小穗赤霉病识别的方法主要有人工田间目视调查、高光谱成像等。基于人工目视调查的方法耗时耗力,且不利于大规模调查防治;高光谱成像技术因其抗干扰能力强、检测速度快等特点广泛应用于作物病害检测领域[5-7],结合光谱分析与图像处理技术[8],可以精确地识别出小麦赤霉病籽粒。文献[9]利用高光谱成像技术与机器学习方法结合提出一种小麦赤霉病籽粒识别算法,可以快速、准确地实现对小麦赤霉病籽粒的识别;文献[10]结合高光谱成像技术和图像处理方法建立了小麦赤霉病籽粒识别模型,识别准确率达到90%以上,能够较好地识别小麦赤霉病籽粒。上述方法虽然能达到较高的识别精度,但高光谱成像仪较为昂贵且笨重,难以在田间进行实时检测。

随着深度学习的不断发展,卷积神经网络在图像识别领域取得了一定的成果[11-13]。在农林业方面,学者也对此进行了深入的研究[14-16]。文献[17]提出一种基于深度学习的番茄病害识别方法,对5种番茄叶片病害进行检测,平均识别准确率可达97.29%;文献[18]提出一种CNN和BiLSTM相结合的水稻病害识别方法,实验结果表明平均识别精度达到99.38%;文献[19]提出一种改进MobileNetV3Small模型,对PlantVillage数据集上水稻病害进行识别,在非迁移学习下,识别准确率达到97.47%。以上研究实现了简单背景下作物病害识别,并取得了较好的检测结果。

但大田环境下背景通常复杂,难以实现高精度的检测。鉴于此,文献[20]以YOLOX模型为基础,提出一种基于改进YOLOX的木薯叶病害检测模型,来解决田间环境下叶片遮盖和背景复杂等因素引起的木薯叶病害识别困难的问题,检测精度达到93.53%;文献[21]针对玉米作物病虫害目标检测中由于图像背景复杂、无关因素干扰较多而导致的对病虫害目标检测效果不理想等问题,提出一种基于YOLO v5s改进模型的玉米作物病虫害检测方法,平均精度达到90.1%。然而,大田环境下拍摄的图像同样受到外界光照条件的影响,因此,针对以上问题,本文以大田复杂环境下不同光照条件的小麦小穗赤霉病为研究对象,基于YOLO v8s模型提出一种改进的赤霉病检测方法,使用全维动态卷积替换主干网络中的标准卷积,增强模型对小麦小穗的特征提取能力,利用改进Efficient RepGFPN网络融合多尺度特征,增强模型泛化能力,并将CIoU损失函数替换为EIoU,提高模型识别精度,以期为小麦赤霉病小穗检测计数和赤霉病害病情监测提供技术基础。

1 小麦赤霉病图像数据集建立

1.1 数据来源

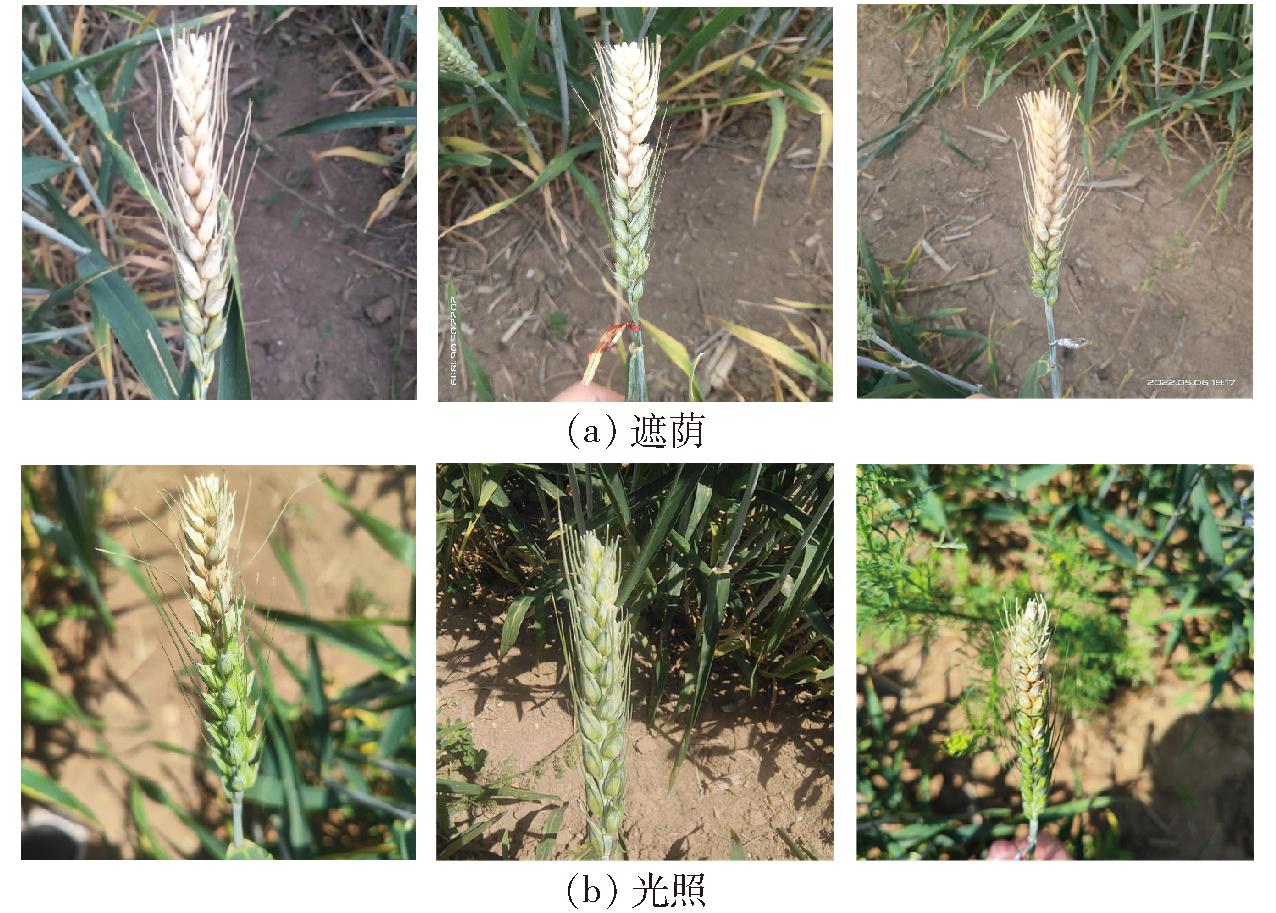

本研究数据采集于河南农业大学国家小麦工程技术研究中心基地(35°01′N,113°40′E)。试验田区域分为多个种植小区域,将小麦试验品种进行秋播,每个品种2行,随机排列。品种包括宁麦9号、扬麦158、苏麦3号与周麦18,致病菌为禾谷镰刀菌。数据采集时间为2022年5月2—15日和2023年5月11—24日,拍摄角尽可能为90°,拍摄小麦穗部侧面,尽量保证所获得的图像中只有一株麦穗。拍摄设备为智能手机,图像格式为JPG,尺寸为1 200像素×1 600像素,部分图像为1 920像素×1 920像素。经过对原始图像的筛选,在剔除冗余与模糊图像后,整理得到640幅麦穗图像,其中遮荫条件下489幅,光照条件下151幅。部分数据集样本示例如图1所示。

图1 不同光照条件下小麦赤霉病图像

Fig.1 Images of wheat FHB under different light conditions

1.2 数据标注和划分

在训练模型前,需要对数据集中的图像进行人工标注,标注工具使用LabelImg工具。在标注时,首先定义标注对象类别,将图像中的健康小穗定义为HS,病小穗定义为DS,然后使用外接矩形框框选目标,并选择适当的标签进行标注。在标注完成后,LabelImg会将每个图像的标注信息保存为XML文件,由于YOLO模型需要的标注格式为TXT文件,因此,在完成标注后,还需要将XML格式的文件转化为TXT格式的文件。在将640幅小麦小穗图像标注完成后,将其按8∶1∶1的比例随机划分为训练集、验证集、测试集。训练集图像512幅,验证集图像64幅,测试集图像64幅。其中训练集用于训练目标检测模型,验证集用于评估模型的性能,测试集用于测试模型对赤霉病患病小穗的计数效果,同时也用于预测小麦赤霉病病情严重度。

2 小麦小穗赤霉病检测模型

2.1 YOLO v8模型

YOLO v8是YOLO系列[22-24]最新模型,与前几代YOLO模型相比,进一步提高了其检测性能。YOLO v8网络主要由输入端(Input层)、主干网络(Backbone层)、颈部网络(Neck层)和输出端(Head层)4部分组成。Input层的作用是将图像数据输入到模型中,Backbone层的作用是对输入图像进行特征提取,Neck层的作用是对主干网络提取特征进行融合,Head层的作用是对特征进行预测,得到目标位置信息和类别信息。

YOLO v8属于单目标检测网络,根据模型尺寸的不同,分为YOLO v8n、YOLO v8s、YOLO v8m、YOLO v8l、YOLO v8x,这5个模型的深度和宽度依次增加,检测精度逐渐提升,但训练花费时间也依次提高。本研究结合农业实际生产情况,选用YOLO v8s模型作为基准模型,在保证检测精度的同时,又兼顾了识别速度,可以满足小麦赤霉病实时检测的要求。

2.2 OCE-YOLO v8s模型

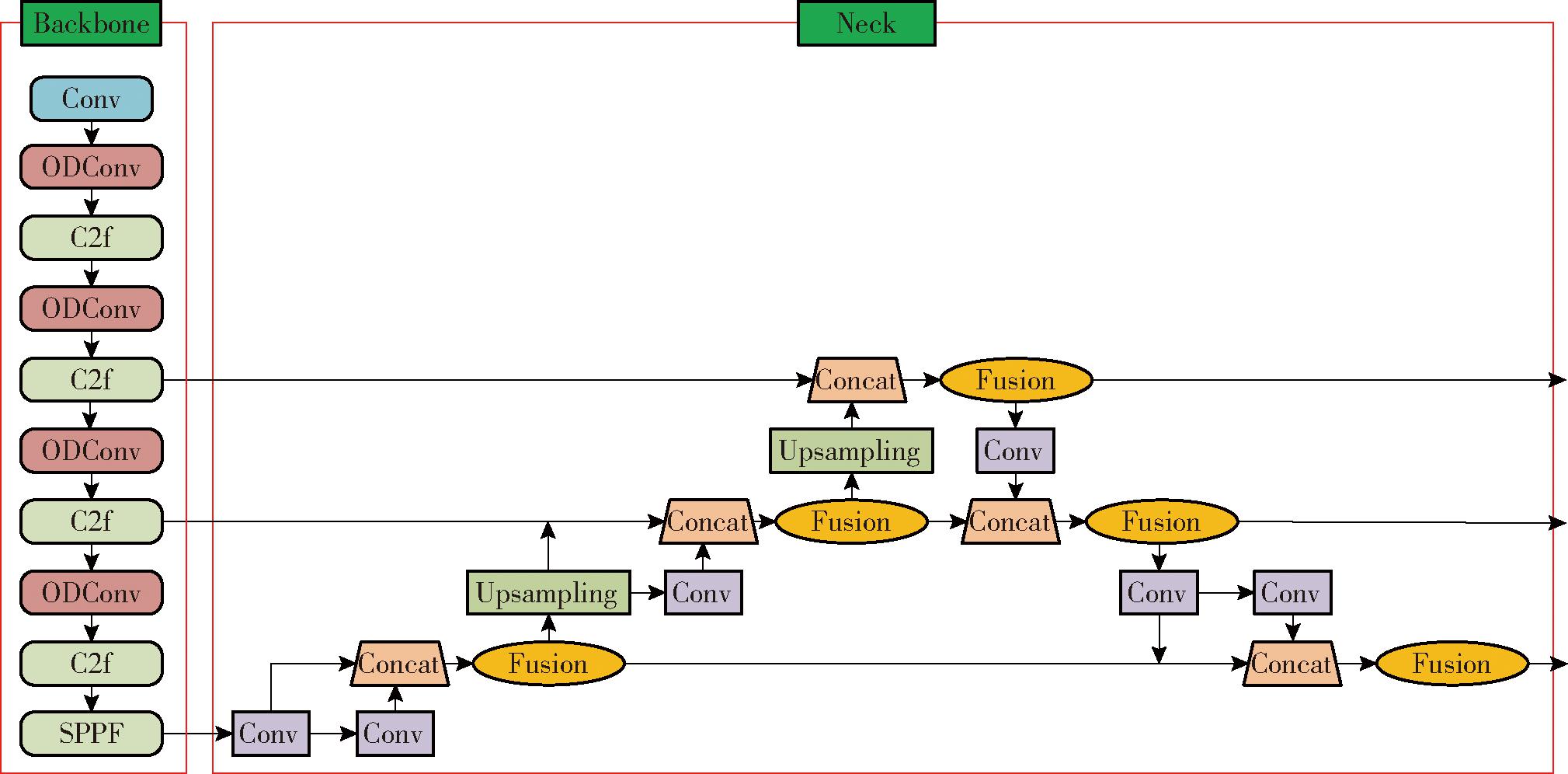

为提高对大田环境下小麦小穗赤霉病的识别效果,本文在YOLO v8s模型基础上加以改进,首先使用全维动态卷积ODConv替换主干网络中的普通卷积,降低模型计算量的同时提高模型识别精度,其次在模型Neck层使用C-Efficient RepGFPN网络提高模型特征融合能力,从而提高模型对小麦小穗赤霉病的识别准确率,最后更换损失函数为EIoU损失函数,进一步提高模型收敛速度和准确率,最终得到改进的OCE-YOLO v8s模型。改进模型网络结构如图2所示。

图2 OCE-YOLO v8s模型

Fig.2 OCE-YOLO v8s model

2.2.1 ODConv全维动态卷积

对于大田复杂背景下小麦小穗赤霉病识别,提高模型精度的关键在于抑制杂乱背景信息的干扰,使模型关注于小麦小穗特征的提取,全维动态卷积ODConv[25]是通过并行策略采用多维注意力机制沿核空间的4个维度学习卷积核的动态卷积,不仅考虑输入通道维度、输出通道维度和空间维度,还考虑卷积核形状和尺寸,可以增强模型对小麦小穗特征的关注程度,从而提高模型识别准确率。

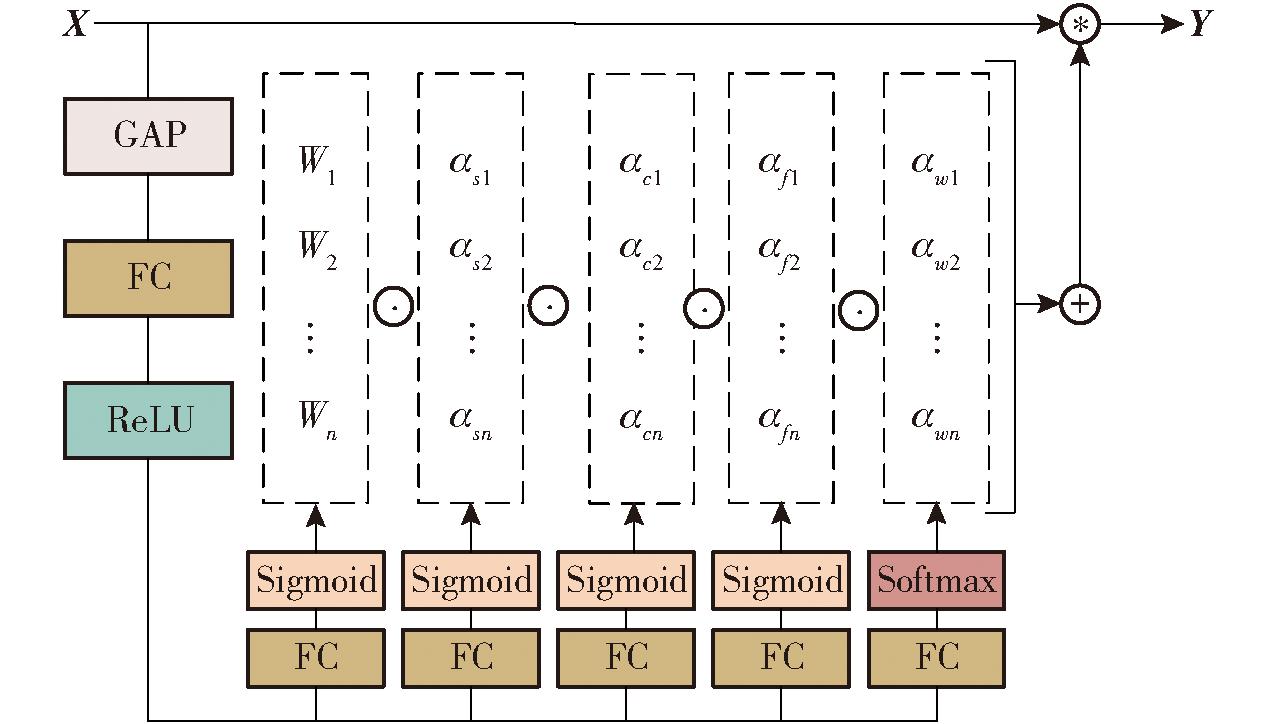

图3为ODConv卷积的结构图。首先将输入特征X通过全局平均池化层(Global average pooling, GAP)压缩为长为cin的特征向量,压缩后的特征向量再由一个全连接层(Fully connected layers, FC)和修正线性单元(Rectified linear unit, ReLU)处理,其中FC层以1/16的压缩率将特征向量映射到低维空间,以此简化动态卷积的复杂性,ReLU激活函数将特征向量中的负值置零。最后创建4个头部分支,每个分支包括一个全连接层和一个Softmax函数或Sigmoid函数,然后生成ODConv卷积模块的4类注意力。

图3 ODConv卷积结构

Fig.3 ODConv convolutional structure

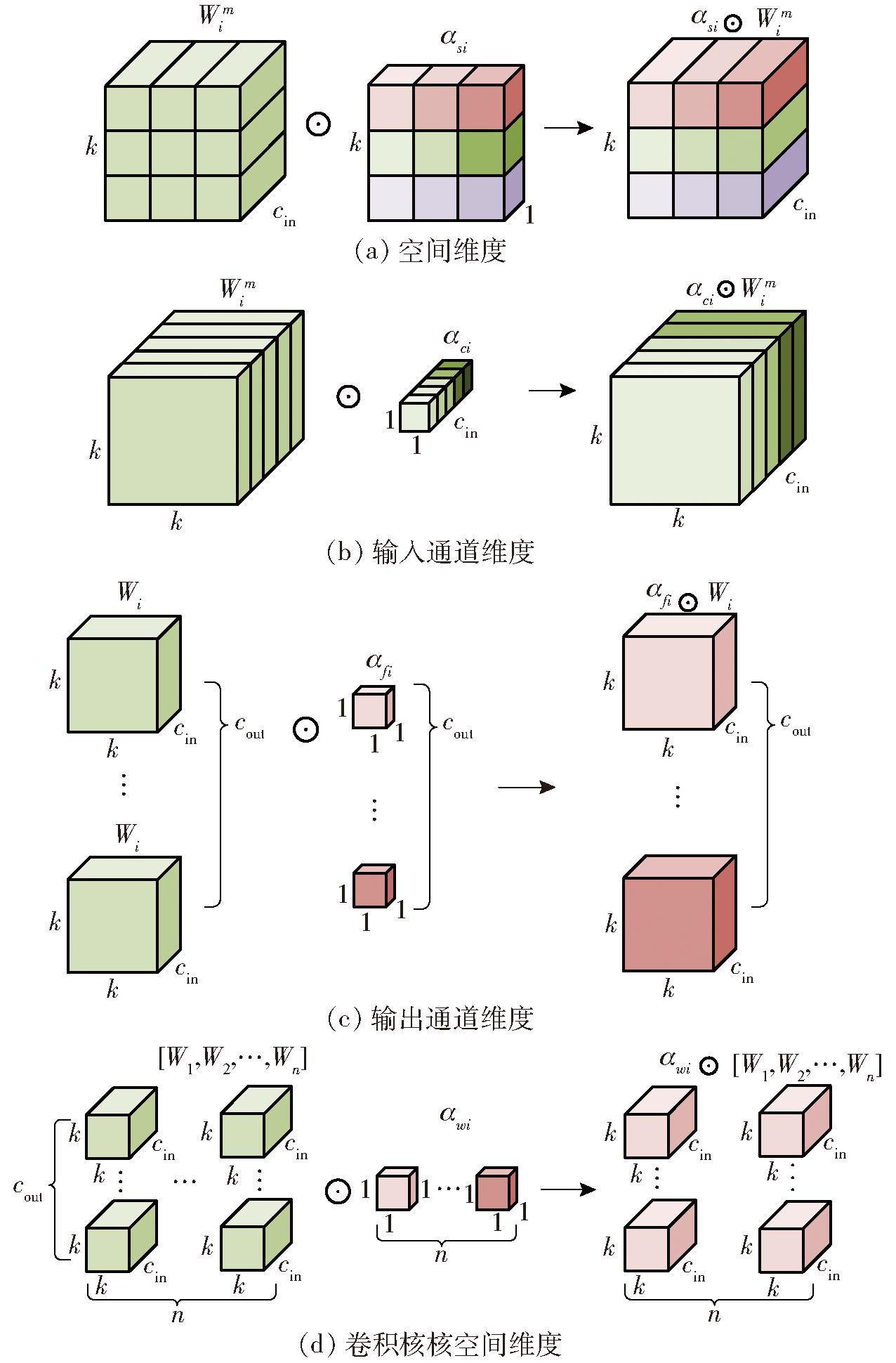

图4展示了这4种类型的注意力乘以卷积核的过程。图4a为ODConv沿空间维度的卷积注意力运算过程,αsi对卷积核Wi在空间维度上的每个位置赋予不同的注意力权重,使模型更关注输入图像的空间位置信息,在空间维度上捕捉小麦赤霉病图像中目标特征的空间分布和形态特征;图4b为ODConv沿输入通道维度的卷积注意力运算过程,αci对卷积核Wi每个输入通道的卷积滤波器赋予不同的注意力权重,使模型更加专注不同通道之间的特征关系,帮助模型更好地提取和组合不同通道的信息,使模型更关注小麦小穗赤霉病图像中的特定颜色通道或纹理特征,从而适应不同光照条件下的小麦赤霉病数据;图4c为ODConv沿输出通道维度的卷积注意力运算过程,αfi对卷积核Wi每个输出通道的卷积滤波器赋予不同的注意力权重,使模型在不同输出通道之间进行更有针对性的特征选择,对光照条件变化引起的不同病征做出响应,从而增强模型对于健康小穗和病小穗不同类别特征的提取能力;图4d为ODConv沿卷积核核空间维度的卷积注意力运算过程,αwi对整个卷积核赋予不同的注意力权重,使模型可以更加全局地调节卷积操作,适应不同大小和形状的赤霉病病斑,从而能够更好地捕获输入数据的整体特征。4种注意力机制相互配合补充,使模型在不同维度上对各个输入数据产生不同维度的影响,从而更好地捕获小麦小穗关键特征和上下文信息,提高模型性能和泛化能力。本研究使用全维动态卷积ODConv替换主干网络中的普通卷积,保证模型充分提取小麦小穗赤霉病特征,提高检测精度。

图4 ODConv沿4种维度的卷积运算过程

Fig.4 ODConv along four dimensions convolution operation process

2.2.2 改进Efficient RepGFPN网络

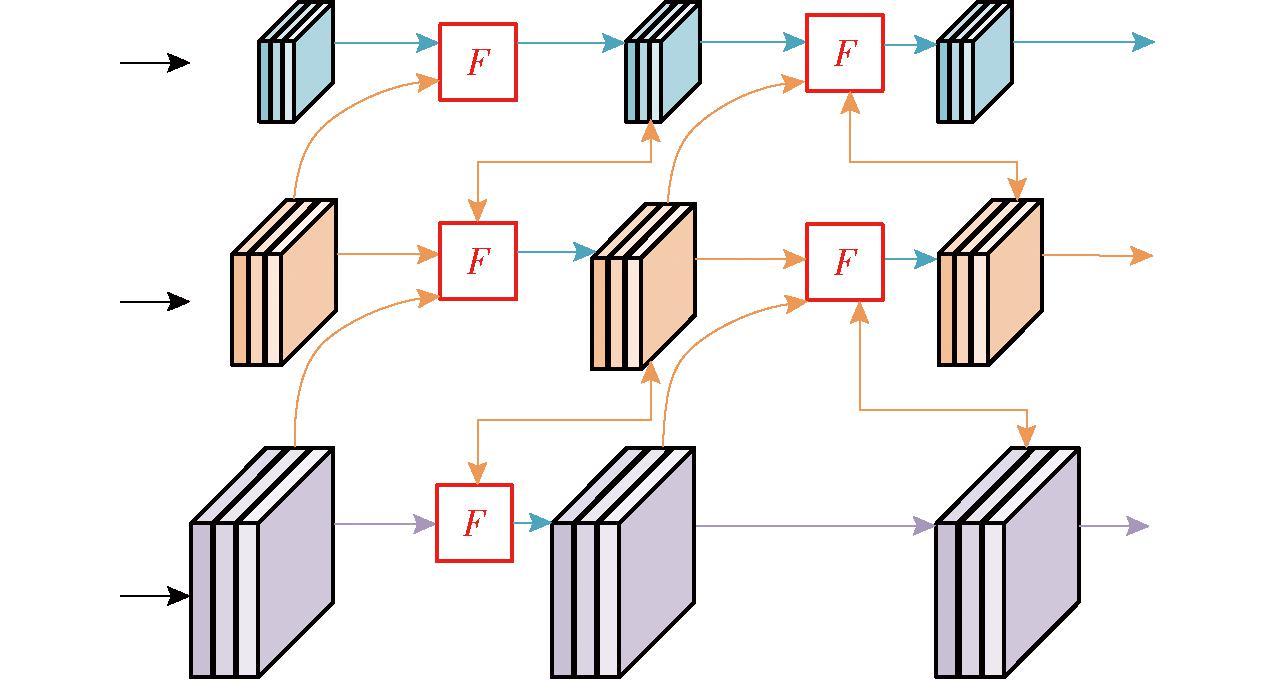

传统的FPN[26]通过自顶向下的路径来融合多尺度特征,但计算成本增加。BiFPN[27]通过删除只有一个输入边的节点,并在同一级别上添加跳过链路来提升模型性能。GFPN[28]能够充分交换高级语义和低级空间信息,实现更好的性能。但GFPN不同尺度的特征共享统一的通道,且Queen-Fusion带来了大量额外的上采样和下采样运算。Efficient RepGFPN[29]则解决了上述问题。Efficient RepGFPN在特征融合中采用不同尺度特征图具有不同通道维度的设置来控制计算成本,能够有效捕捉到小麦赤霉病图像中不同尺度的特征;另外在保证实时检测的前提下,删除Queen-Fusion中的额外上采样操作,能够更高效地进行特征融合和处理;在特征融合中,用CSPNet替换原始的基于3×3卷积的特征融合,CSPNet能够有效地交换高级语义信息和低级空间信息,从而提升网络对小麦赤霉病的识别精度;然后再通过引入重新参数化机制和高效层聚合网络(ELAN)的连接来升级CSPNet,进一步提升网络的性能和精度,使模型能够更准确地检测小麦赤霉病。Efficient RepGFPN网络结构如图5所示。

图5 Efficient RepGFPN网络结构

Fig.5 Efficient RepGFPN network structure

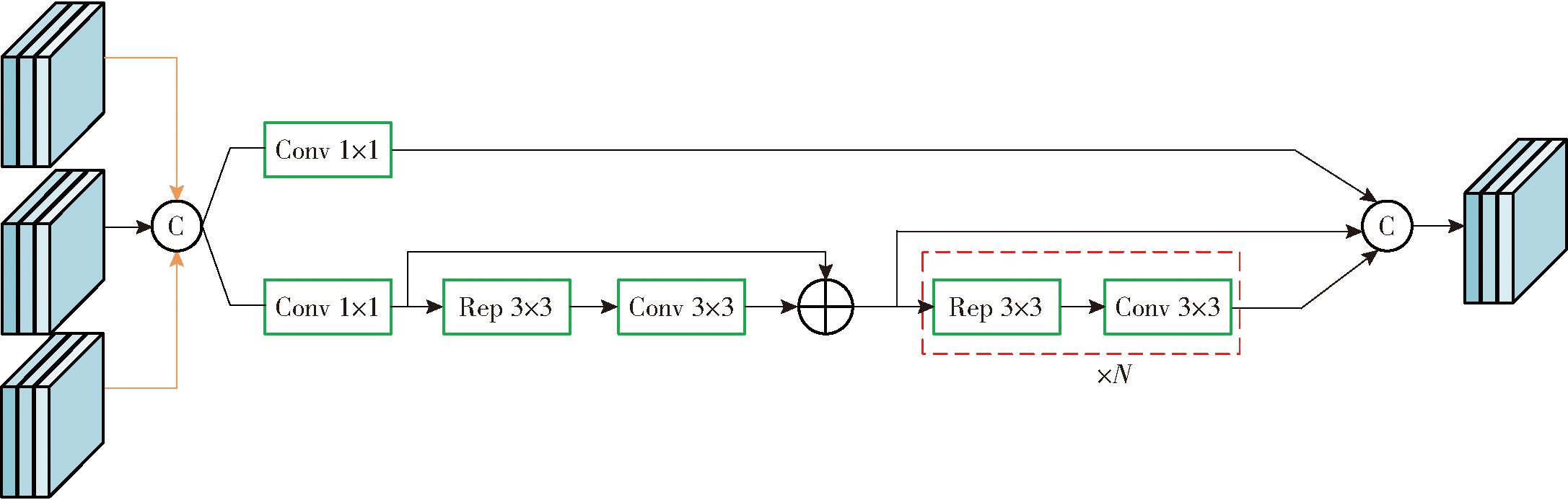

Fusion Block是Efficient RepGFPN网络的主要融合模块,首先对输入的特征图进行Concat操作,然后分别通过1×1卷积进行通道降维,再使用多个Rep 3×3卷积和3×3卷积进行特征变换,同时多个层输出,最后通过Concat操作得到最终的输出。Fusion Block模块结构如图6所示。

图6 Fusion Block网络结构

Fig.6 Fusion Block network structure

为了更好地将主干网络输出特征层与Efficient RepGFPN网络进行融合,提高模型对目标特征的检测能力,本文在主干网络输出的特征图送入Efficient RepGFPN之前加入一个1×1卷积,引入更多的灵活性和非线性表达能力,提高网络对小麦小穗赤霉病特征的识别,进而提高模型识别准确率,改进后的Efficient RepGFPN网络命名为C-Efficient RepGFPN。C-Efficient RepGFPN网络结构如图7所示。

图7 C-Efficient RepGFPN网络结构

Fig.7 C-Efficient RepGFPN network structure

2.2.3 EIoU损失函数

YOLO v8原损失函数为CIoU损失函数[30],CIoU损失函数仅能反映目标框长宽比的差异,并不是长宽分别与其置信度的真实差异,从而阻止了模型优化相似性。因此为了提升模型精度,用EIoU[31]损失函数替换CIoU损失函数。

EIoU损失值LEIoU共由3部分相加而成:交并比(IoU)损失值LIoU、预测框与真实框的中心点距离损失值Ldis、高宽损失值Lasp,其计算公式为

LEIoU(b,bgt)=LIoU+Ldis+Lasp=

(1)

式中 b、bgt——预测框、真实框中心点坐标

ρ2——相应计算元素中心点欧氏距离

c——最小外接框最短对角线长度

w、wgt、h、hgt——预测框宽度、真实框宽度、预测框高度、真实框高度

cw、ch——最小外接框宽度、高度

EIoU损失函数考虑目标边界框的精确性和位置信息,能够更好地衡量检测框与真实目标之间的重叠程度,由于EIoU损失函数更加关注目标的精确位置和形状,能够更好地捕捉到小尺度目标的细节信息,因此对小麦赤霉病这样的小尺度目标检测效果更优。

2.3 试验设置

本研究所有试验均使用PyTorch作为深度学习模型框架,GPU为NVIDIA GeForce RTX3090,迭代次数为150, 批量大小设置为32,优化器使用AdamW优化器,初始学习率为0.01,动量为0.937,权值衰减为0.000 5。

2.4 评价指标

为了衡量网络模型对小麦小穗赤霉病的检测性能,将识别精确率、召回率、平均检测精度(Average precision,AP )和平均精度均值mAP (Mean average precision,mAP)作为评价指标[32]。

3 结果与分析

3.1 加入ODConv对模型的影响

ODConv能使模型更关注小麦小穗特征的提取,提高检测精度。为探究ODConv在网络结构中的位置与模型性能的关系,设置3组试验,试验1为只替换主干网络中的Conv,试验2为只替换Neck网络中的Conv,试验3为将主干网络和Neck网络中的Conv都替换,如表1所示。

表1 ODConv对模型的影响

Tab.1 Effect of ODConv on model %

试验编号位置精确率召回率mAP1Backbone95.094.798.32Neck94.094.697.73Backbone+Neck93.795.098.0

从表1中可以看出,在Backbone中替换ODConv的模型,其mAP高于在Neck网络替换ODConv的模型,而在将主干网络和Neck网络中的Conv都替换之后,mAP低于试验1的结果,原因在于ODConv在主干网络中更好地学习了图像低级和中级特征,因此在替换Conv层时可以提升模型性能。然而,Neck网络通常负责更高级的特征提取和检测,需要更复杂的特征表示来实现目标检测任务,ODConv在Neck中无法充分适应特定任务的特征提取要求,导致性能下降。

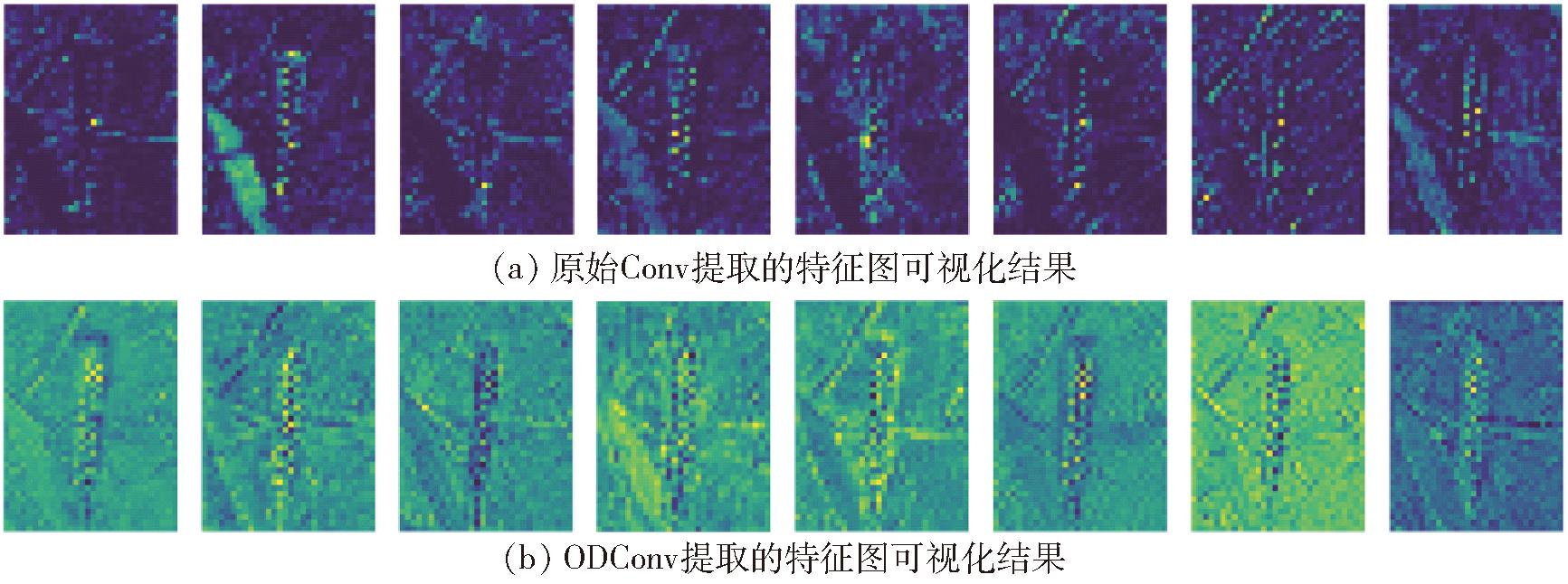

图8b为将主干网络的第5层的Conv替换为ODConv的特征图可视化结果,图8a为原始Conv提取的特征图可视化结果。从图中可以看出,在将Conv替换为ODConv后,提取出的特征图其特征更为明显,进一步验证了ODConv有利于模型性能的提高。

图8 特征可视化结果

Fig.8 Feature visualization result

3.2 不同损失函数对识别结果的影响

为验证不同损失函数对本文模型检测结果的影响,使用CIoU、DIoU、WIoU和EIoU共4种损失函数来进行对比试验,结果如表2所示。

表2 不同损失函数对识别结果的影响

Tab.2 Effect of different loss functions on recognition results %

损失函数精确率召回率mAPCIoU91.994.096.3DIoU93.394.097.3WIoU92.393.496.6EIoU94.193.897.6

从表2中可以看出,使用EIoU损失函数在本文数据集上取得了最好的效果,精确率、召回率和mAP均为最高,mAP较CIoU、DIoU、WIoU损失函数分别高1.3、0.3、1个百分点。原因在于EIoU损失函数能够更准确地衡量检测框与真实目标之间的重叠度,尤其在边界框预测不准确或目标尺寸较小时,相比于其他损失函数,EIoU能够更准确地评估边界框的匹配程度,使得模型在检测小麦小穗赤霉病等小目标时具有更好的性能和鲁棒性。

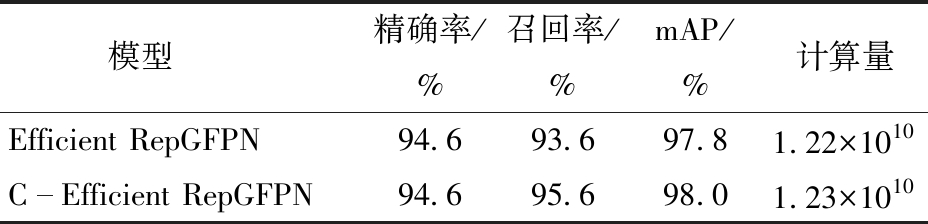

3.3 加入1×1卷积对模型的影响

本文在主干网络输出的特征图送入Efficient RepGFPN之前加入一个1×1卷积,为验证加入1×1卷积对模型性能的影响,设计两组试验,结果如表3所示。

表3 1×1卷积对模型的影响

Tab.3 Effect of 1×1 convolution on model

模型精确率/%召回率/%mAP/%计算量Efficient RepGFPN94.693.697.81.22×1010CEfficient RepGFPN94.695.698.01.23×1010

通过表3可以看出,在特征图送入Efficient RepGFPN网络之前加入1×1卷积,模型在计算量略有增加的情况下,模型的召回率提高了2.0个百分点,mAP提高了0.2个百分点,原因在于1×1卷积可以对输入特征图的每个像素进行线性组合,从而引入非线性变换,有助于模型学习更复杂的特征,从而通过计算量较少的方式提高模型对小麦小穗赤霉病的检测能力,提高模型检测精度。

3.4 消融试验

为验证本研究提出的改进算法的性能,设置5组对比消融试验,结果如表4所示。

表4 消融试验结果

Tab.4 Results of ablation experiment %

注:√表示基线模型采用此模块;×表示基线模型未采用此模块。

试验编号ODConvCEfficient RepGFPNEIoU精确率召回率mAP1×××91.994.096.32√××92.794.496.93×√×94.695.698.04××√94.193.897.65√√√95.094.798.3

由表4中试验2与试验1的结果对比可知,主干网络使用全维动态卷积ODConv替换普通卷积Conv后,模型的精确率、召回率均有提升,mAP提高0.6个百分点,说明嵌入全维动态卷积的模型通过学习4个维度的注意力提高了模型的识别准确率;通过试验3与试验1的结果对比可知,采用C-Efficient RepGFPN结构进行特征融合后,模型的mAP为98.0%,比原模型提高1.7个百分点,说明该特征融合结构能够更好地融合高级语义信息和低级空间信息,从而提高模型对小麦小穗赤霉病特征的提取;通过试验4与试验1的结果对比可知,用EIoU损失函数替换CIoU损失函数后,模型的mAP提高1.3个百分点,能有效提高检测准确率。由试验5最终改进结果与试验1的结果对比可知,最终改进模型OCE-YOLO v8s的精确率较原模型提高3.1个百分点,召回率提高0.7个百分点,mAP提高2.0个百分点,能够有效提高模型对小麦小穗赤霉病的识别。

3.5 不同模型对比试验

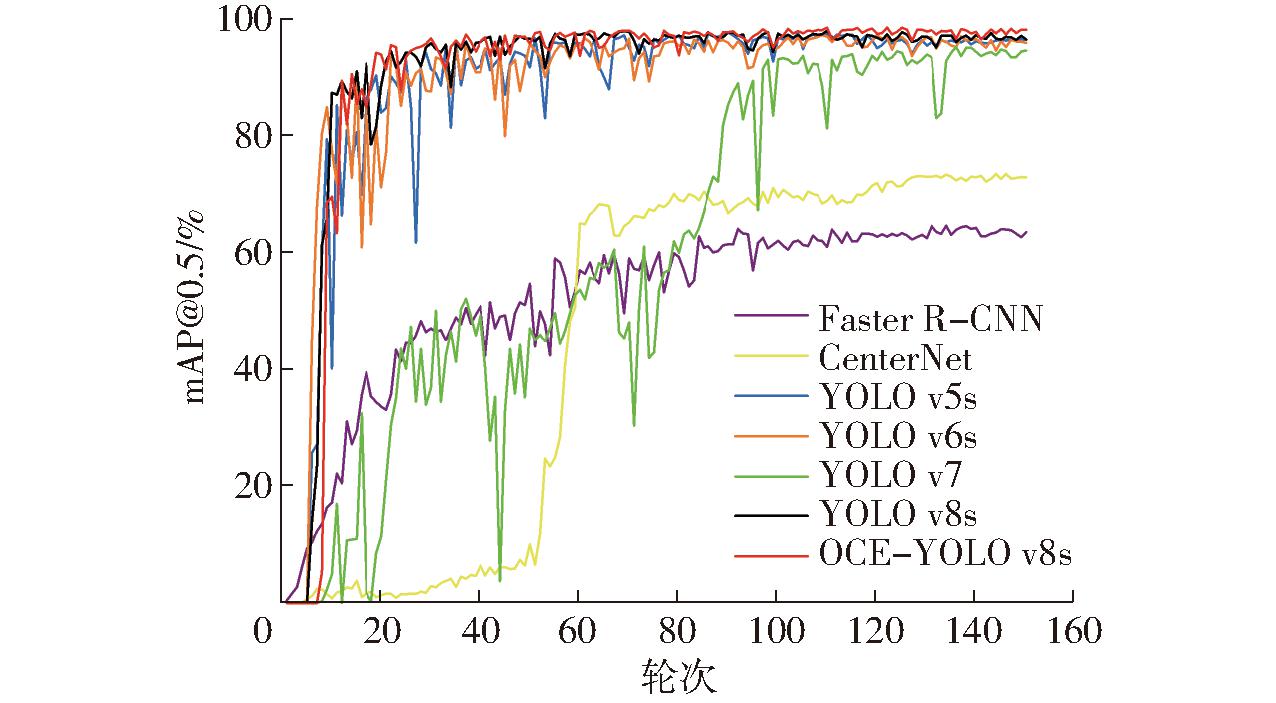

为进一步验证模型性能,选取Faster R-CNN、CenterNet和YOLO系列其他模型,如YOLO v5s、YOLO v6s、YOLO v7、YOLO v8s模型进行对比,结果如表5所示。

表5 不同模型对比结果

Tab.5 Comparative experiment results with different models

模型精确率/%召回率/%mAP/%计算量Faster RCNN66.546.762.33.697×1011CenterNet69.361.472.67.020×1010YOLO v5s91.892.396.22.400×1010YOLO v6s93.892.195.74.420×1010YOLO v790.588.794.41.051×1010YOLO v8s91.994.096.32.840×1010OCEYOLO v8s95.094.798.32.580×1010

从表5中可以看出,本研究所提出方法的mAP达98.3%,比Faster R-CNN、CenterNet、YOLO v5s、YOLO v6s、YOLO v7、YOLO v8s算法分别高36、25.7、2.1、2.6、3.9、2.0个百分点。Faster R-CNN、CenterNet的mAP均较低,且计算量较大;YOLO v5s模型的mAP与YOLO v8s模型相差不大,但其精确率和召回率相对较低;YOLO v6s和YOLO v7模型的mAP相对较低,且计算量大,消耗算力,不适于移动端等低算力设备;本文所提模型OCE-YOLO v8s拥有最高的mAP、精确率和召回率,且计算量较原YOLO v8s模型有所降低,能够满足实时检测的需求。模型的准确率曲线如图9(图中mAP@0.5表示IoU阈值为0.5时每个类别AP的平均值)所示。

图9 各模型mAP@0.5变化曲线

Fig.9 mAP@0.5 change curves for each model

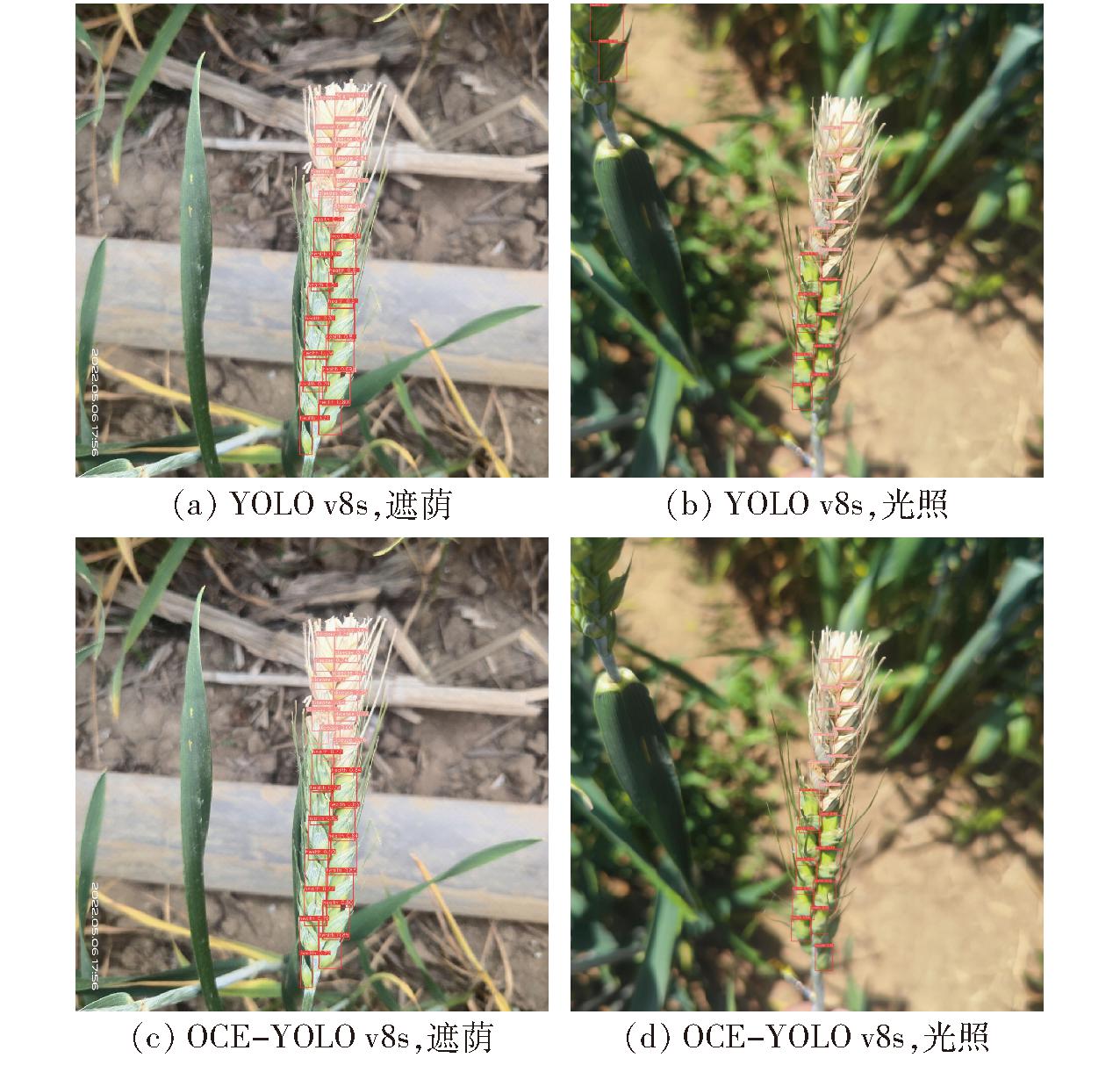

为了更直观地比较改进模型与原模型的检测效果,图10展示了测试集上模型改进前、后的检测结果。其中原模型中会出现误检漏检的情况,且置信度低于改进后的模型,而改进后的模型大幅改善了这一问题,验证了本文算法的有效性。综合结果表明,本文所提算法在小麦小穗赤霉病检测上具有较高的精度,能够更好地对小麦小穗赤霉病进行准确检测。

图10 模型检测结果

Fig.10 Model detection results

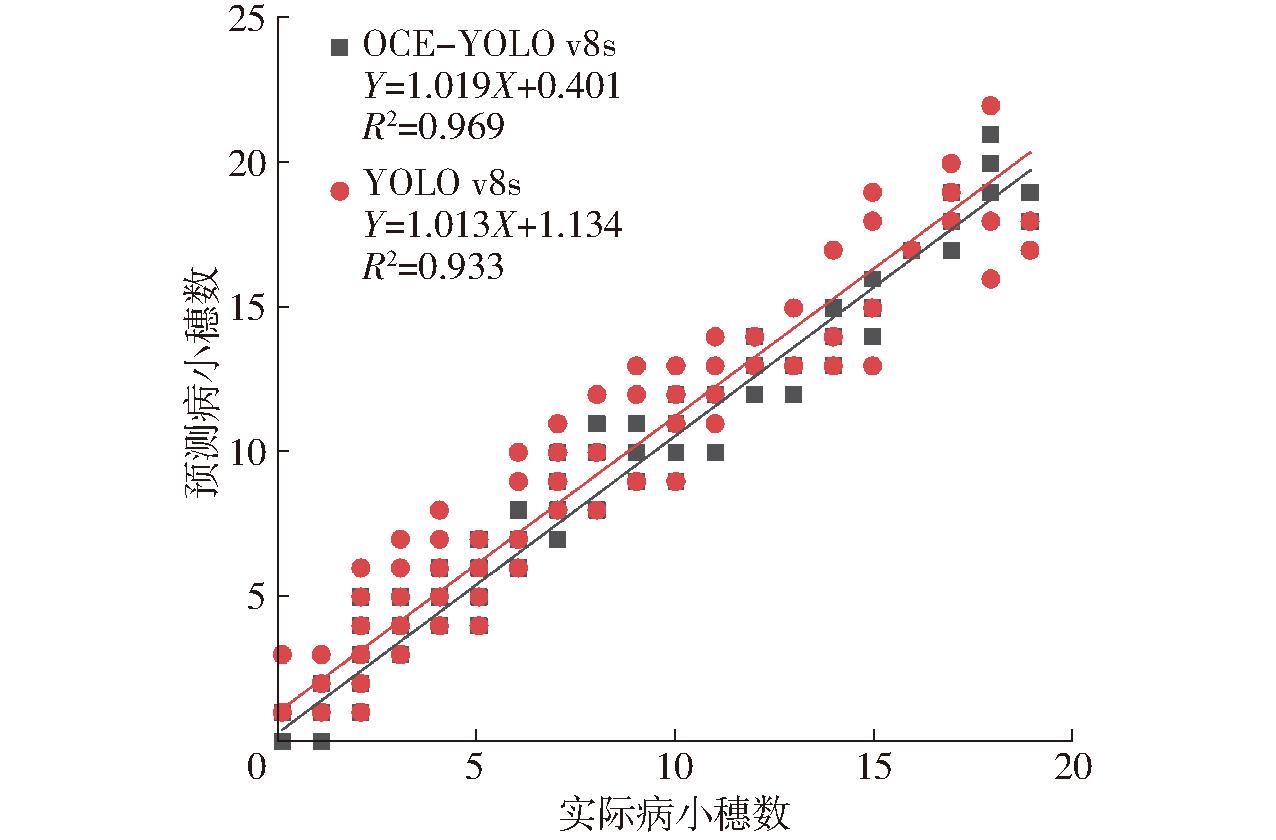

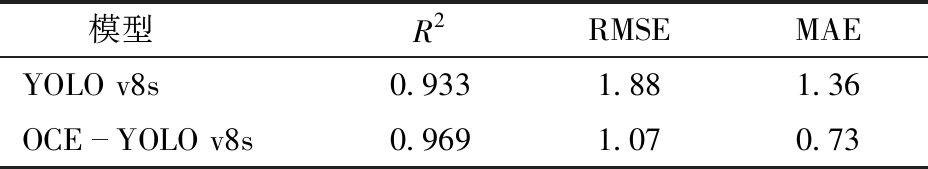

3.6 小麦小穗赤霉病计数结果和分析

为衡量OCE-YOLO v8s模型与原YOLO v8s模型在小麦小穗计数结果上的差异,另外选取88幅小麦小穗赤霉病图像作为测试集,加上原来的64幅一共152幅图像,然后将模型改进前、后的预测值和人工真实统计值进行统计,并对病小穗数和健康小穗数的预测值和真实值进行线性拟合。从图11中可以看出,OCE-YOLO v8s模型预测病小穗数与拟合线比较接近,原YOLO v8s模型预测病小穗数相对分散,表明OCE-YOLO v8s模型对病小穗计数的拟合结果优于原模型,OCE-YOLO v8s模型的决定系数R2为0.969,比原YOLO v8s模型的决定系数高0.036,说明OCE-YOLO v8s模型在单幅图像上的病小穗计数预测值与人工统计的真实值之间具有显著的线性相关。

图11 YOLO v8s改进前、后的病小穗数拟合结果

Fig.11 Diseased spikelet fitting results before and after YOLO v8s improvement

表6为YOLO v8s模型改进前、后的病小穗计数结果评价指标对比。从表6中可以看出,OCE-YOLO v8s模型在病小穗计数上的均方根误差(RMSE)为1.07,比原YOLO v8s模型低0.81,平均绝对误差(MAE)为0.73,比原YOLO v8s模型低0.63,说明本文提出的OCE-YOLO v8s模型在小麦病小穗计数结果方面优于原YOLO v8s模型。

表6 病小穗计数结果对比

Tab.6 Diseased spikelet counting results comparison

模型R2RMSEMAEYOLO v8s0.9331.881.36OCEYOLO v8s0.9691.070.73

图12为OCE-YOLO v8s模型和原YOLO v8s模型在测试集上预测的健康小穗数与人工实际统计健康小穗数的拟合结果。从图中可以看出,OCE-YOLO v8s模型预测的健康小穗数的拟合结果优于原模型,且OCE-YOLO v8s模型的决定系数R2比原YOLO v8s模型高0.042,表明OCE-YOLO v8s模型在单幅图像上的健康小穗计数预测值与人工统计的真实值之间具有显著的线性相关。

图12 YOLO v8s改进前、后的健康小穗数拟合结果

Fig.12 Healthy spikelet fitting results before and after YOLO v8s improvement

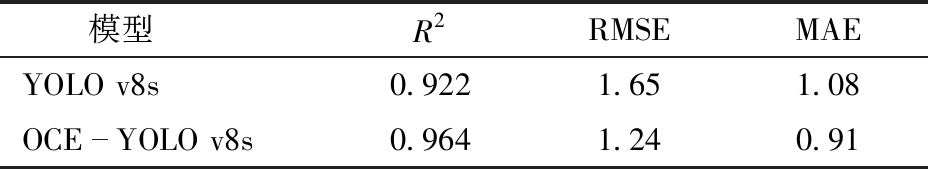

表7为YOLO v8s模型改进前、后的健康小穗计数结果评价指标对比。从表7中可以看出,OCE-YOLO v8s模型在健康小穗计数上的RMSE比原YOLO v8s模型低0.41,MAE比原YOLO v8s模型低0.17,说明本文提出的OCE-YOLO v8s模型在小麦健康小穗计数结果方面优于原YOLO v8s模型。

表7 健康小穗计数结果对比

Tab.7 Healthy spikelet counting results comparison

模型R2RMSEMAEYOLO v8s0.9221.651.08OCEYOLO v8s0.9641.240.91

从OCE-YOLO v8s模型对病小穗和健康小穗的预测结果来看,OCE-YOLO v8s模型对病小穗的计数结果高于对健康小穗的计数结果,原因可能是病小穗与图像背景区别明显,模型对于病小穗的识别结果更好。综合结果表明,OCE-YOLO v8s模型在病小穗和健康小穗的计数方面均优于原YOLO v8s模型,表明OCE-YOLO v8s模型在小麦小穗赤霉病计数上有较好的结果,能有效满足对小麦小穗赤霉病的精确检测和计数。

3.7 小麦赤霉病病情严重度预测结果

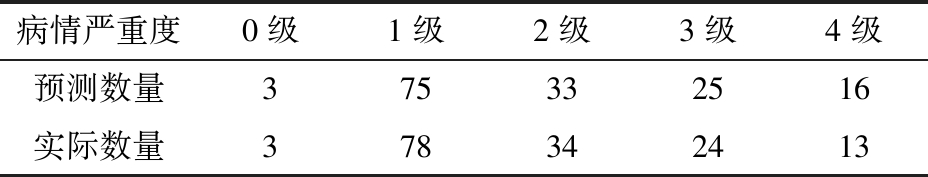

在GB/T 15796—2011《小麦赤霉病测报技术规范》中,规定小麦赤霉病病情严重度是指病小穗数占全部小穗数的比例,共划分为5级。0级:无病;1级:病小穗数占全部小穗的1/4以下;2级:病小穗数占全部小穗的1/4~1/2;3级:病小穗数占全部小穗的1/2~3/4;4级:病小穗数占全部小穗的3/4以上。根据改进模型OCE-YOLO v8s在152幅测试集图像上的计数结果进行病情严重度划分,结果如表8所示。

表8 小麦赤霉病病情严重度预测结果

Tab.8 Results of wheat FHB severity prediction

病情严重度0级1级2级3级4级预测数量375332516实际数量378342413

从表8中可以看出,改进模型在测试集的152幅小麦小穗赤霉病图像中,预测病情严重度各级别数量与真实级别的数量相差不大,病情严重度主要集中在1级,原因在于该试验地块中小麦赤霉病的产生是使用带致赤霉病菌的微量移液器以单花滴注的方式注入到麦穗中上部(自穗顶端向下第5排小穗)的小花内,致使发病小穗主要集中于麦穗上部,因此小麦赤霉病病情严重度主要为1级。

4 结束语

针对大田复杂背景下的小麦小穗赤霉病小目标检测问题,提出OCE-YOLO v8s算法,用全维动态卷积ODConv替换YOLO v8s特征提取网络中的普通卷积来提高算法精度;使用C-Efficient RepGFPN特征融合网络对不同的特征层进行融合,提高模型对小麦小穗赤霉病特征的识别;使用EIoU损失函数代替CIoU损失函数,进一步提高模型预测准确率。试验结果表明,改进后的算法在小麦小穗赤霉病数据集上的准确率、召回率、mAP指标上都有所提高,mAP达到98.3%,且计算量有所减少。总体来说,改进后的模型在算法计算量降低的前提下,检测准确性更高,有效解决了大田复杂背景下小麦小穗赤霉病小目标检测问题,实现了对小麦小穗赤霉病病情严重度分级。

[1] SAVARY S. Plant health and food security[J]. Journal of Plant Pathology, 2020, 102(3): 605-607.

[2] GRUBER K. Agrobiodiversity: the living library[J]. Nature, 2017, 544(7651): S8-S10.

[3] GHIMIRE B, SAPKOTA S, BAHRI B A, et al. Fusarium head blight and rust diseases in soft red winter wheat in the southeast United States: state of the art, challenges and future perspective for breeding[J]. Frontiers in Plant Science, 2020, 11: 1080.

[4] SARI E, KNOX R E, RUAN Y, et al. Historic recombination in a durum wheat breeding panel enables high-resolution mapping of fusarium head blight resistance quantitative trait loci[J]. Scientific Reports, 2020, 10(1): 7567.

[5] 章海亮,高俊峰,何勇. 基于高光谱成像技术的柑橘缺陷无损检测[J]. 农业机械学报, 2013, 44(9): 177-181. ZHANG Hailiang, GAO Junfeng, HE Yong. Nondestructive detection of citrus defection using hyper-spectra imaging technology[J].Transactions of the Chinese Society for Agricultural Machinery,2013,44(9):177-181.(in Chinese)

[6] 褚璇,王伟,张录达,等. 高光谱最优波长选择及Fisher判别分析法判别玉米颗粒表面黄曲霉毒素[J]. 光谱学与光谱分析, 2014,34(7):1811-1815. CHU Xuan, WANG Wei, ZHANG Luda, et al. Hyperspectral optimum wavelengths and Fisher discrimination analysis to distinguish different concentrations of aflatoxin on corn kernel surface[J]. Spectroscopy and Spectral Analysis,2014,34(7):1811-1815.(in Chinese)

[7] 谢传奇,王佳悦,冯雷,等. 应用高光谱图像光谱和纹理特征的番茄早疫病早期检测研究[J]. 光谱学与光谱分析, 2013, 33(6):1603-1607. XIE Chuanqi, WANG Jiayue, FENG Lei, et al. Study on the early detection of early blight on tomato leaves using hyperspectral imaging technique based on spectroscopy and texture[J]. Spectroscopy and Spectral Analysis, 2013,33(6): 1603-1607.(in Chinese)

[8] ZHANG N, PAN Y, FENG H, et al. Development of fusarium head blight classification index using hyperspectral microscopy images of winter wheat spikelets[J]. Biosystems Engineering, 2019,186:83-99.

[9] 刘爽,谭鑫,刘成玉,等. 高光谱数据处理算法的小麦赤霉病籽粒识别[J]. 光谱学与光谱分析,2019,39(11):3540-3546. LIU Shuang, TAN Xin, LIU Chengyu, et al. Recognition of fusarium head blight wheat grain based on hyperspectral data processing algorithm[J]. Spectroscopy and Spectral Analysis,2019,39(11):3540-3546.(in Chinese)

[10] 梁琨,杜莹莹,卢伟,等. 基于高光谱成像技术的小麦籽粒赤霉病识别[J].农业机械学报,2016,47(2):309-315.LIANG Kun, DU Yingying, LU Wei, et al. Identification of fusarium head blight wheat based on hyperspectral imaging technology[J].Transactions of the Chinese Society for Agricultural Machinery,2016,47(2):309-315.(in Chinese)

[11] ALQARAGHULI A, O UZ A T A. Optimized YOLO v4 algorithm for car detection in traffic flow[J]. Turkish Journal of Science and Technology,2022,17(2):395-403.

UZ A T A. Optimized YOLO v4 algorithm for car detection in traffic flow[J]. Turkish Journal of Science and Technology,2022,17(2):395-403.

[12] 蔡舒平,孙仲鸣,刘慧,等. 基于改进型YOLO v4的果园障碍物实时检测方法[J].农业工程学报,2021,37(2):36-43.CAI Shuping, SUN Zhongming, LIU Hui, et al. Real-time detection methodology for obstacles in orchards using improved YOLO v4[J]. Transactions of the CSAE, 2021, 37(2): 36-43. (in Chinese)

[13] YAN B, FAN P, LEI X, et al. A real-time apple targets detection method for picking robot based on improved YOLO v5[J]. Remote Sensing,2021,13(9):1619.

[14] FERNANDEZ-GALLEGO J A, KEFAUVER S C, GUTIERREZ N A, et al. Wheat ear counting in-field conditions: high throughput and low-cost approach using RGB images[J]. Plant Methods,2018,14:1-12.

[15] 王宇歌,张涌,黄林雄,等. 基于卷积神经网络的麦穗目标检测算法研究[J]. 软件工程, 2021,24(8):6-10.WANG Yuge, ZHANG Yong, HUANG Linxiong, et al. Research of wheat ear target detection based on convolutional neural network[J].Software Engineering,2021,24(8):6-10.(in Chinese)

[16] 许景辉,邵明烨,王一琛,等. 基于迁移学习的卷积神经网络玉米病害图像识别[J].农业机械学报,2020,51(2):230-236,253.XU Jinghui, SHAO Mingye, WANG Yichen, et al. Recognition of corn leaf spot and rust based on transfer learning with convolutional neural network[J]. Transactions of the Chinese Society for Agricultural Machinery,2020,51(2):230-236,253.(in Chinese)

[17] 马丽,周巧黎,赵丽亚,等. 基于深度学习的番茄叶片病害分类识别研究[J].中国农机化学报,2023,44(7):187-193,206. MA Li, ZHOU Qiaoli, ZHAO Liya, et al. Classification and recognition of tomato leaf diseases based on deep learning[J]. Journal of Chinese Agricultural Mechanization,2023, 44(7):187-193,206.(in Chinese)

[18] 路阳,刘婉婷,林立媛,等. CNN与BiLSTM相结合的水稻病害识别新方法[J].江苏农业科学,2023,51(20):211-217. LU Yang, LIU Wanting, LIN Liyuan, et al. A new methodfor rice disease identificationby combining CNN and BiLSTM[J]. Jiangsu Agricultural Sciences,2023,51(20):211-217.(in Chinese)

[19] 袁培森,欧阳柳江,翟肇裕,等.基于MobileNetV3Small-ECA的水稻病害轻量级识别研究[J].农业机械学报,2024,55(1):253-262. YUAN Peisen, OUYANG Liujiang, ZHAI Zhaoyu, et al. Lightweight identification of rice diseases based on improved ECA and MobileNetV3Small[J]. Transactions of the Chinese Society for Agricultural Machinery,2024,55(1):253-262.(in Chinese)

[20] 宋玲,曹勉,胡小春,等.基于YOLOX的复杂背景下木薯叶病害检测方法[J].农业机械学报,2023,54(3):301-307.SONG Ling, CAO Mian, HU Xiaochun, et al. Detection of cassava leaf diseases under complicated background based on YOLOX[J].Transactions of the Chinese Society for Agricultural Machinery,2023,54(3):301-307.(in Chinese)

[21] 施杰,林双双,罗建刚,等.基于YOLO v5s改进模型的玉米作物病虫害检测方法[J].江苏农业科学,2023,51(24):175-183.SHI Jie, LIN Shuangshuang, LUO Jian’gang, et al. Study on a detection method for crop diseases and insect pests based on YOLO v5s improved model[J]. Jiangsu Agricultural Sciences, 2023,51(24):175-183.(in Chinese)

[22] REDMON J, FARHADI A. Yolov3: an incremental improvement[J]. arXiv preprint arXiv:1804.02767,2018.

[23] BOCHKOVSKIY A, WANG C Y, LIAO H Y M. YOLO v4: optimal speed and accuracy of object detection[J]. arXiv preprint arXiv:2004.10934,2020.

[24] ZOU X, WW Z, ZHOU W, et al. YOLOX-PAI: an improved YOLOX, stronger and faster than YOLO v6[J]. arXiv preprint arXiv:2208.13040,2022.

[25] LI C, ZHOU A, YAO A. Omni-dimensional dynamic convolution[J].arXiv preprint arXiv:2209.07947,2022.

[26] LIN T Y, DOLLAR P, GIRSHICK R, et al. Feature pyramid networks for object detection[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Honolulu:IEEE,2017:2117-2125.

[27] TAN M, PANG R, LE Q V. Eficientdet: scalable and effcient object detection[C]∥Prceedings of the lEEE/CVF Conference on Computer Vision and Pattern Recognition, 2020:10781-10790.

[28] JIANG Y, TAN Z, WANG J, et al. Giraffedet: a heavy-neck paradigm for object detection[J]. arXiv preprint arXiv:2202.04256, 2022.

[29] XU X, JIANG Y, CHEN W, et al. Damo-YOLO: a report on real-time object detection design[J]. arXiv preprint arXiv: 2211.15444, 2022.

[30] WANG X, SONG J. ICIoU: improved loss based on complete intersection over union for bounding box regression[J]. IEEE ACCESS,2021,9:105686-105695.

[31] ZHANG Y F, REN W, ZH Z, et al. Focal and efficient IOU loss for accurate bounding box regression[J]. Neuro Computing,2022, 506:146-157.

[32] JIANG K L, XIE T Y, YAN R, et al. An attention mechanism-improved YOLO v7 object detection algorithm for hemp duck count estimation[J].Agriculture,2022,12(10):1659.