奶牛的行为是对其内部生理变化或外部环境刺激做出的反应,直接或间接地反映了奶牛的健康及生理状况[1]。例如,奶牛的躺卧行为是奶牛每日所需时间最长的行为,其躺卧时间与产奶量成正比[2];奶牛在产犊前甩尾次数增加且幅度增大,可以预估其产犊时间;通过监测奶牛的进食行为评估其饲料摄入量,了解其饮食习惯和食欲情况等。因此,在奶牛养殖过程中对奶牛日常行为进行监测,是实现奶牛健康管理的关键[3]。随着奶牛养殖规模的逐渐扩大,传统的人工监测方法因效率低下、准确率难以保证等原因已无法满足养殖要求[4],因此,利用先进的信息技术实现智能养殖,保障奶牛身体健康、提高奶牛生活福利和养殖场经济效益已经成为奶牛养殖研究领域的重要目标和任务[5]。

目前的行为识别方法主要分为接触式[6-9]和非接触式[10-14]两种。接触式监测方法主要依靠在奶牛不同部位固定的传感器收集不同行为产生的运动数值,并根据数值的差异进行识别[9]。非接触式监测主要依靠视频图像分析,其中深度学习[15]作为奶牛行为识别的计算方法被广泛应用。

WANG等[16]在YOLO v5模型上引入了空洞空间金字塔池化模块和C3GC-3特征增强模块,实现了高层语义信息的多尺度融合,提高了对奶牛爬跨行为的识别准确率。BLOCH等 [17]考虑到训练数据集和迁移学习的使用,构建了基于卷积神经网络(CNN)的奶牛喂养行为分类模型,对不同的进食行为进行分类,平均准确率达到90%。MA等[18]通过将Rexnet网络扩展为秩扩展三维网络(Rexnet 3D),识别单头奶牛的躺卧、站立和行走行为,识别准确率达到95.00%,但行为类别较少。王克俭等[19]提出一种基于时空特征(TFL-TSN)的奶牛行为识别算法,对奶牛行走、站立、进食、躺卧4种行为的识别平均准确率达到82.60%。

虽然接触式传感器具有较高识别精度,但随着使用时间的延长,传感器会产生老化或水分渗透等问题,影响记录数值的准确性,从而对行为产生误判。而在非接触式的视频图像分析方法中,虽避免了传感器的弊端,但仍存在识别行为类别较少,个别行为准确率较低的缺点。

针对以上问题,本文以牧场自然环境下群体养殖的奶牛为监测对象,使用高清摄像头实时获取奶牛在牛棚中不同时段的运动行为,为实现对奶牛行为的快速监测和及时干预,选择以图像帧的方式进行处理,构建一种多分支并行且融合空间和通道注意信息的结构(CAFNet模型),对奶牛多行为识别分类,进而提高模型行为识别准确率与运行效率。

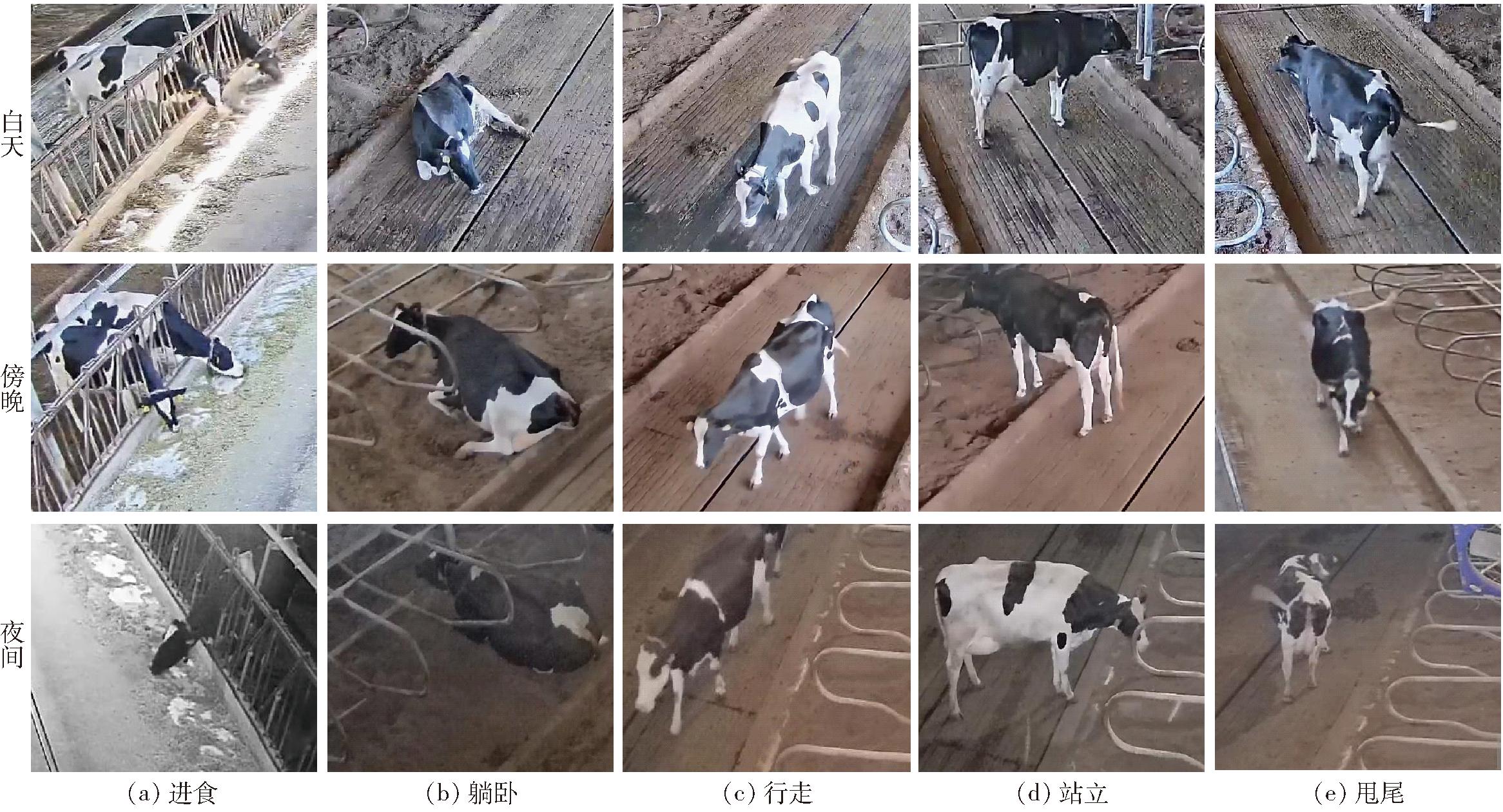

原始视频数据集采集自河北省保定市满城区宏达牧场,牛舍总长50 m、宽30 m, 4个广角摄像机(DH-IPC-HFW8449K-ZFR型,大华)安装在牛舍中部的左右两侧,安装高度距地面6 m,相对的2台摄像机之间距离为12 m,俯视角约为15°,摄像机焦距为3.6 mm,分辨率为2 688像素×1 520像素。图像采集现场环境如图1所示。视频采集时段为10:00—03:00,由于在实验过程中发现不同光照条件下各行为识别准确率存在差异,将其划分为白天、傍晚和夜间3个时间段,其中定义10:00—17:00为白天,定义17:00—19:00为傍晚,定义19:00—03:00为夜间,旨在研究不同时间段的光照条件对奶牛行为识别的影响。本文选取的5种基本行为及描述分别为进食(站立时头部伸出栏杆)、躺卧(腹部贴近地面)、行走(蹄部抬起或四肢不在同一水平线)、站立(蹄部贴地且至少两只平行)、甩尾(其他基本行为状态下牛尾非自然下垂),识别时进食主要区分头部及附近特征,躺卧区分腹部附近特征,站立与行走主要区分蹄部是否抬起或腿部是否交叉,甩尾与站立、行走行为主要区分在尾部特征。图2为实验所用数据集中的不同行为示例。

图1 图像采集现场环境

Fig.1 Image acquisition site environment

图2 奶牛不同行为示例图

Fig.2 Example diagrams of different behaviors of cows

对采集到的原始视频进行筛选,剔除掉因拍摄角度或其他因素引起的视频无奶牛主体或视频模糊片段,且截取的视频片段中只包含单头或多头奶牛的同一种行为。考虑到不同时间段的光照条件可能会对识别结果产生影响,因此每种行为均包括白天、傍晚和夜间采集的视频,裁剪得到924个视频片段,每个视频片段时长3~10 s不等,其中白天、傍晚和夜间的时间比约为4∶3∶3,由于奶牛夜间进食行为较少,本文仅对其他4种行为的夜间情况进行研究。利用稀疏采样[20]的思想将924个视频片段按秒划分为若干个子视频,依次从每个子视频中随机抽取一帧图像,共得到5 708幅视频帧图像,按8∶2划分为训练集和测试集。图像由“行为名称_编号”命名,且每种行为的样本数据集相对平衡。

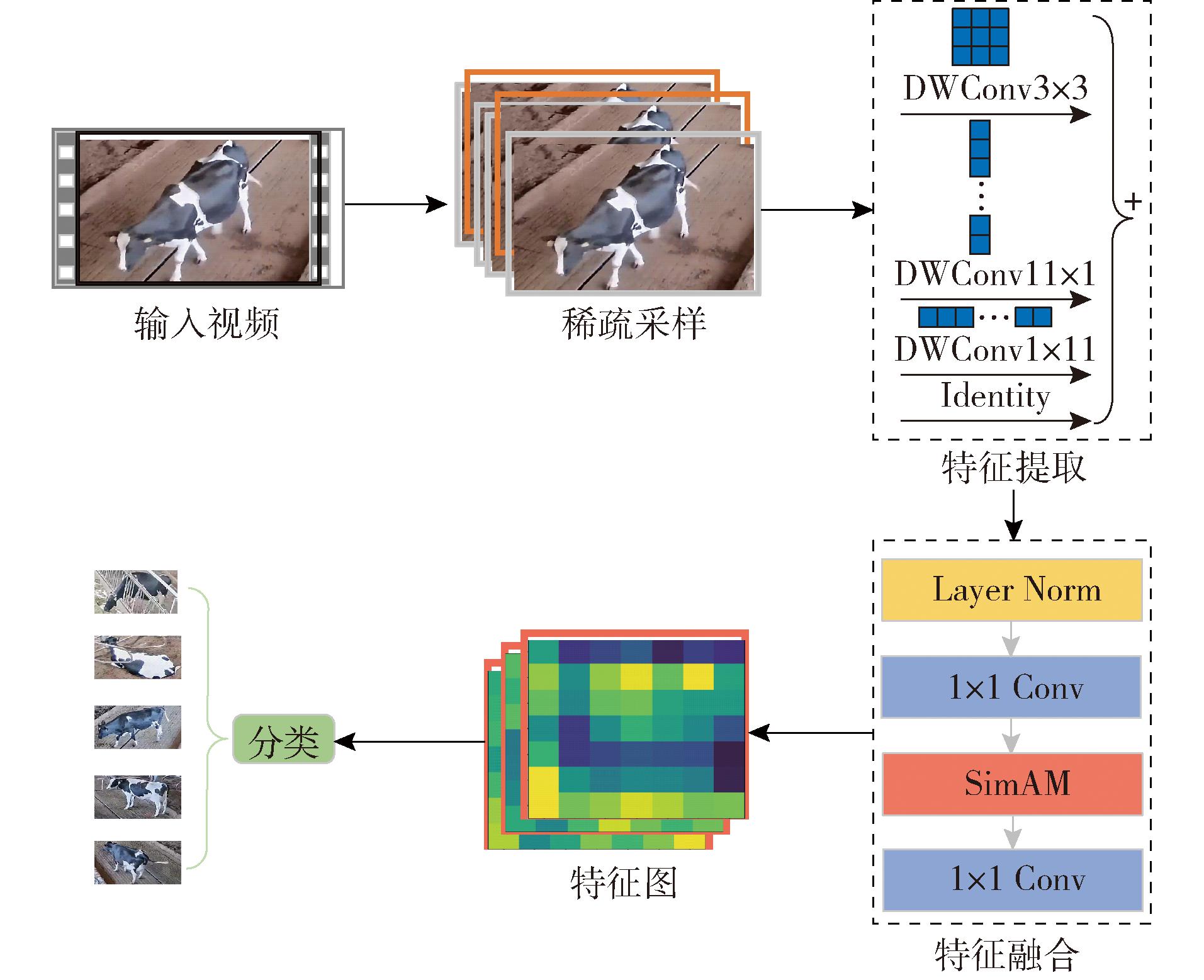

奶牛行为识别可定义为测试行为图像与预先校准的行为参考特征之间的匹配度[21]。由于现阶段奶牛行为识别准确率及效率较低,本文提出了融合时间和空间注意信息的多分支并行卷积识别模型CAFNet,该模型在卷积网络ConvNeXt基础上融合了非对称多分支卷积模块(ACM)和特征注意力模块(FAM),并经过Layer Scale与Dorp Path操作,如图3所示。

图3 CAFNet模型结构图

Fig.3 CAFNet model structure diagram

首先经过下采样单元进行特征降维,使模型在处理较大尺寸图像时显著降低浮点运算量;然后在ACM进行特征提取的过程中保留一部分原始特征,防止信息过度丢失;之后通过FAM使模型在空间和通道维度学习更多有辨性神经元并完成不同通道之间的特征融合;再通过Layer Scale使模型自适应地缩放每个通道,更好地匹配数据的特性,经过Dorp Path随机丢弃网络中的某些通道,使网络不过度依赖特定的权重连接,有助于模型更加适应不同数据样本,最后将结果输入到全连接层得到最终的分类结果。

奶牛行为识别流程图如图4所示。首先将采集到的视频序列通过稀疏采样策略,得到本实验所需图像帧数据集并输入到CAFNet中;然后分别通过ACM、FAM进行特征提取与特征融合;最后,将融合后的特征输入全连接层得到分类结果。

图4 奶牛行为识别流程图

Fig.4 Cow behavior recognition flowchart

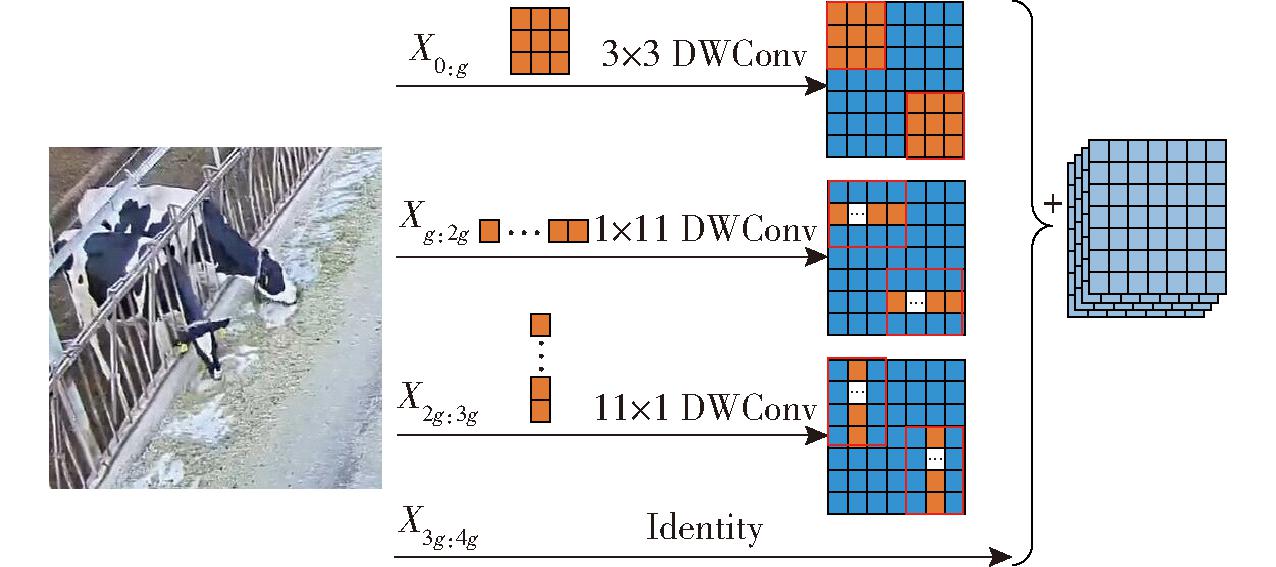

因传统卷积相关模型通常采用较大卷积核进行深层堆叠,导致参数量和浮点运算量急剧增加,在计算资源有限的情况下无法高效运行,且容易受到训练和推理速度的影响。因此在逐通道卷积的基础上引入了ACM模块。采用小核逐通道卷积与非对称卷积的组合,并保持部分通道不变,将其标识为恒等映射的一个分支。通过保留部分通道,在特征提取过程中保持一些原始输入信息,有助于防止信息过度丢失,并提供一种路径,使模型能够利用原始输入的一些低级特征或低频信息。对于输入X,沿着通道维度分为4组并行分支,其数学表达式为

Split(Xhw,Xw,Xh,Xid)=(X0:g,Xg:2g,X2g:3g,X3g:4g)

(1)

式中 Split(·)——沿通道维度划分操作

X0:g——输入X从0到g的分支

Xg:2g——输入X从g到2g的分支

X2g:3g——输入X从2g到3g的分支

X3g:4g——输入X从3g到4g的分支

Xhw——方形卷积核分支

Xw——宽度方向非对称卷积分支

Xh——高度方向非对称卷积分支

Xid——恒等映射分支

g——卷积分支的通道数

下一步划分输入到不同的并行分支,采用滑动窗口机制[22]对得到的特征图进行特征提取,最后将每个分支的输出连接合并。

(2)

(3)

(4)

X′id=Xid

(5)

X′=Concat(X′hw,X′w,X′h,X′id)

(6)

式中 DWConv——深度可分离卷积操作

Concat——拼接操作

X′hw——方形卷积核分支输出

X′h——高度方向非对称卷积分支输出

X′w——宽度方向非对称卷积分支输出

X′id——恒等映射分支

X′——不同分支输出拼接后的结果

ks——方形卷积核大小

kb——非对称卷积核大小

非对称卷积核大小决定了模型在输入数据中能够捕获的局部信息的最大范围,较大的卷积核可以覆盖更大的感受野,能够捕获更广泛的上下文信息。但形状过大需要更多参数和计算量,且在处理局部细节和细粒度特征时效果较差;形状过小在感受野范围内能够捕获的局部信息相对有限,特征表达能力较低。本文采取大小为11的非对称卷积核,如图5所示。

图5 非对称多分支卷积模块

Fig.5 Asymmetric multi branch convolutional module

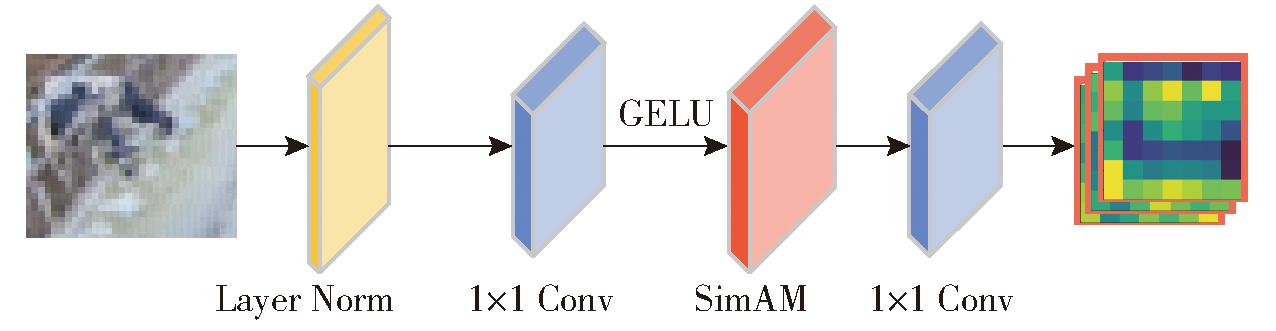

因现有注意力模块只能沿着通道或空间维度细化特征,限制了模型学习跨通道和空间变化注意力权重的灵活性。为从全局视图中捕获更多的上下文线索,同时针对因拍摄角度导致的奶牛主体较小,模型存在将奶牛主要部位推理为背景,无法正常检测奶牛行为的问题,对于特征提取后的结果,本文采用图6所示的特征注意力模块。FAM通过不同通道之间的特征映射增强特征之间的关联性,获取更多有关小目标物体的特征。实验使用3D无参注意力模块(SimAM)[23],其独特优势在于无需增加额外参数,即可为特征图推导出三维权值(空间和通道维度),使得网络学习更多有辨性神经元以增强重要特征的有效提取,强化奶牛主体特征并抑制背景特征。

图6 特征注意力模块

Fig.6 Feature attention module

针对每层提取的特征,通过逐点卷积对不同通道之间的特征进行融合,再经过非线性、计算复杂度低的GELU激活函数得到初步融合的特征图;随后对该特征图采用SimAM注意力机制直接提取空间和通道上的重要特征并通过逐点卷积进行融合,得到下一阶段的输入。逐点卷积融合计算公式为

Tout(i,j)=∑(Tin(i,j,s)Ws) (s∈[0,K-1])

(7)

式中 Tout——输出特征映射

Tin——输入特征映射

(i,j)——输出特征映射中元素位置

s——输入特征映射通道索引

Ws——滤波器

K——输入特征映射通道数

其中,SimAM注意力机制直接对特征图推导出三维权值,寻找表现出明显空间抑制效应的神经元并将其赋予更高的优先权,其能量函数计算得到的能量越低,说明神经元t与周围神经元区别越大,所以为神经元t赋予更高的优先权,从而增强奶牛主要特征提取,有效抑制了周围环境特征干扰。

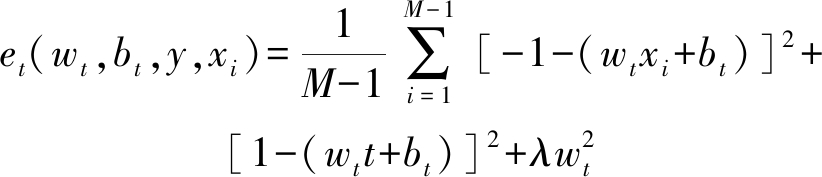

计算每个神经元能量函数公式为

(8)

式中 et——神经元能量函数

wt——权重系数 bt——偏置系数

y——标签值

xi——输入特征X其他神经元

M——某通道上所有神经元个数

t——输入特征X目标神经元

λ——正则化系数

为保证奶牛行为分类准确率及效率,在提取并融合图像的特征后,使用全局平均池化层[24](Global average pooling,GAP)、层归一化[25-26](Layer normalization,LN)与全连接层的组合。其中替代平均池化层(Average pooling,AP)的GAP对整个特征图进行平均,不需要额外参数,得到固定长度的特征向量且具有位置不变性,不同位置的相同目标都会生成相似的特征表示,使得模型对于目标物体在图像中的位置变化更加鲁棒,GAP通过将整个特征图平均化,捕捉整体图像的全局信息,从而更好地保留特征图中的重要特征,使模型更加有效地进行分类。其次对于GAP操作后得到的特征向量,使用LN替代传统卷积网络中的批归一化(Batch normalization,BN)进行归一化,使得每个维度上的特征具有相似的均值和方差,规范化特征向量,减少特征间协变量偏移,且LN在每个样本上独立计算均值和方差,能够更好地保持输出特征通道之间的独立性。最后将学习到的特征作为全连接层的输入进行分类并输出。

实验在Linux 4.15.0系统下,基于PyTorch 1.13.1+CUDA 11.4实现。计算机配置为CPU Intel(R) Xeon(R) Gold 5220,NVIDIA Quadro RTX 5000显卡。激活函数为GELU[27]函数,批处理量设置为16,迭代次数为300。为了使模型更好地拟合数据,采用余弦退火(Cosine annealing)策略[28],初始学习率设为0.000 1,最大倍率因子为0.001,最小倍率因子为0.000 001,学习率在训练过程中以余弦函数的形状逐渐减小,使得网络在训练初期可以更快地收敛,而在后期可以更加细致地调整参数。

选取参数量(Parameters)、浮点运算量(FLoPs)、帧速率(Frame per second,FPS)、平均准确率(Average accuracy,Acc)作为评价指标衡量模型性能,其中参数量和计算复杂度越小说明模型具有更快的推理速度和更低的资源消耗且易于部署;帧速率为每秒传输的帧数,表示模型每秒检测的图像帧数,高帧速率表示模型能够更快地处理图像数据;高平均准确率表明模型能更加正确地对不同类别的样本进行分类。

3.3.1 不同大小非对称卷积核对模型的影响

为寻找本模型ACM模块中非对称卷积核的最优大小,采集白天(2 280幅)、傍晚(1 640幅)和夜间(1 788幅)的视频帧图像,对不同大小非对称卷积核进行测试,实验证明当非对称卷积核大小为11时效果最好,如表1所示。

表1 不同大小非对称卷积核对模型的影响

Tab.1 Impact of different sizes of asymmetric convolution kernels on model

非对称卷积核大小帧速率/(f·s-1)平均准确率/%383.5687.40594.6288.90794.3088.78996.9589.0811122.7891.0613105.1189.27

在测试过程中,非对称卷积核初始大小设定为3,随着卷积核大小的逐渐增加,本模型参数量及浮点运算量变化可忽略不计,而当卷积核大小为11时,模型的帧速率达到122.78 f/s,平均准确率达到91.06%,均为本次测试最大值,故而本文采用大小为11的非对称卷积核。

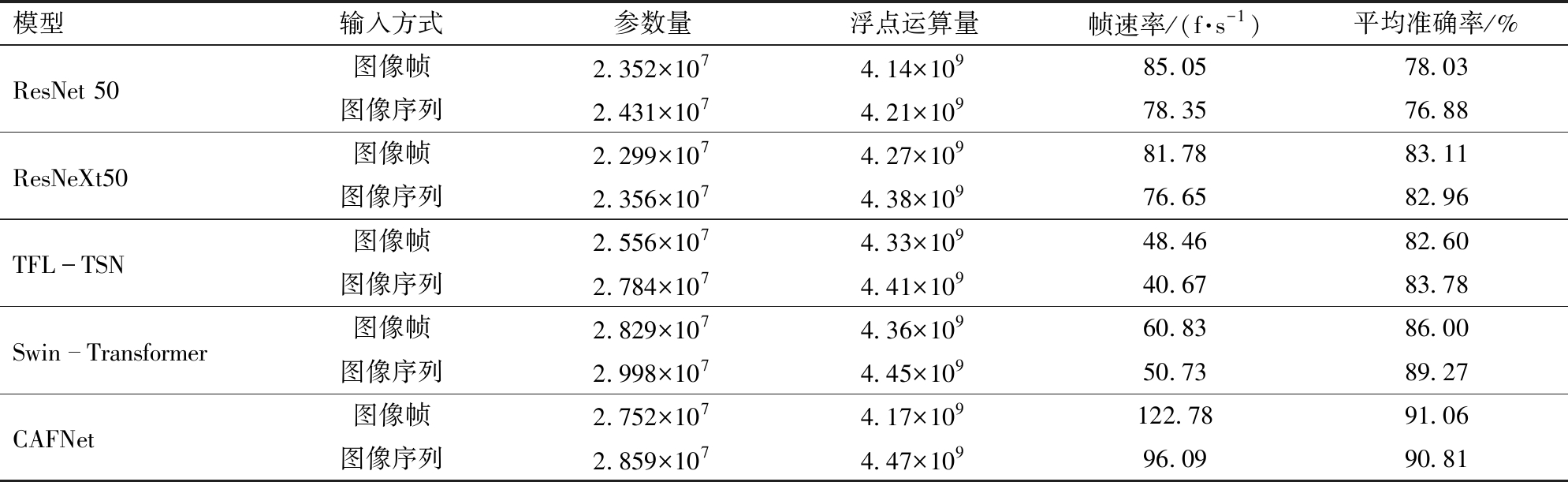

3.3.2 不同模型对比

在上述相同实验条件下将CAFNet模型与ResNet 50、ResNeXt50、TFL-TSN、Swin-Transformer模型进行对比实验,并与图像序列输入方式进行对比,由表2可知,本文模型识别平均准确率分别提升13.03、7.95、8.46、5.06个百分点。相较于ResNet 50、ResNeXt50、TFL-TSN,参数量略微增加,帧速率与识别平均准确率提升效果明显,其原因在于本文提出的CAFNet能有效利用小核多分支的特点提升模型推理速度,扩大感受野并增强学习局部特征的能力,结合空间和通道下的不同特征信息,从而提高不同行为的辨识度与识别准确率。

表2 不同模型实验结果对比

Tab.2 Comparison of experimental results of different models

模型输入方式参数量浮点运算量帧速率/(f·s-1)平均准确率/%ResNet 50图像帧2.352×1074.14×10985.0578.03图像序列2.431×1074.21×10978.3576.88ResNeXt50图像帧2.299×1074.27×10981.7883.11图像序列2.356×1074.38×10976.6582.96TFLTSN图像帧2.556×1074.33×10948.4682.60图像序列2.784×1074.41×10940.6783.78SwinTransformer图像帧2.829×1074.36×10960.8386.00图像序列2.998×1074.45×10950.7389.27CAFNet图像帧2.752×1074.17×109122.7891.06图像序列2.859×1074.47×10996.0990.81

通过表2中不同输入方式对比可见,ResNet 50、ResNeXt50、TFL-TSN、Swin-Transformer、CAFNet的图像帧输入方式在参数量、浮点运算量、帧速率方面均优于序列输入,这是由于序列输入需要更多的参数和更高的浮点运算量来捕获序列中的时间依赖关系,由此导致处理速度降低,帧速率随之下降。本文模型识别平均准确率变化不大,而TFL-TSN、Swin-Transformer的识别平均准确率虽然有所增加,但均低于本文CAFNet的图像帧输入方式,因此本文采用图像帧输入方式的CFANet模型对奶牛行为进行识别分类。

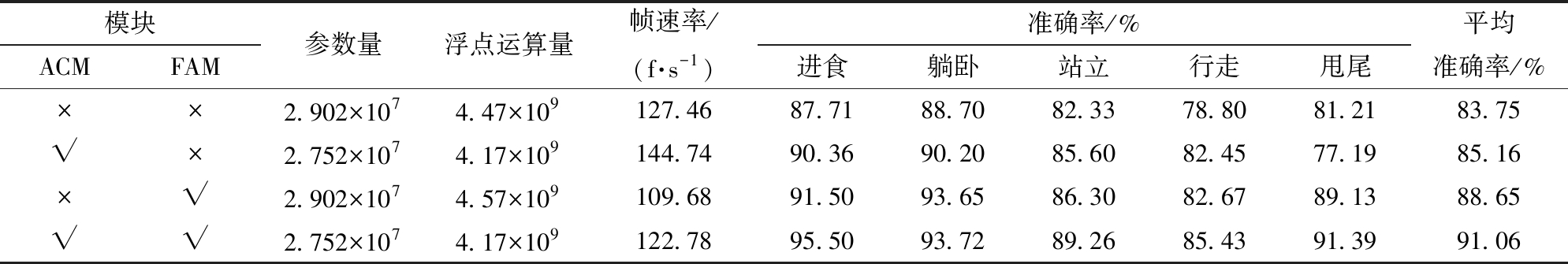

3.3.3 消融实验

为验证ACM模块和FAM模块对改进的奶牛行为识别模型的影响,在上述相同实验条件下,利用该方法对建立的奶牛行为数据集进行识别,参考控制变量法的思想,保证学习率、优化器等参数一致,通过消融实验验证本文模型的效果,结果如表3所示。

表3 模型优化消融实验结果对比

Tab.3 Comparison of model optimization ablation experimental results

注:“×”表示不使用该模块,“√”表示使用该模块。

模块ACMFAM参数量浮点运算量帧速率/(f·s-1)准确率/%进食躺卧站立行走甩尾平均准确率/%××2.902×1074.47×109127.4687.7188.7082.3378.8081.2183.75√×2.752×1074.17×109144.7490.3690.2085.6082.4577.1985.16×√2.902×1074.57×109109.6891.5093.6586.3082.6789.1388.65√√2.752×1074.17×109122.7895.5093.7289.2685.4391.3991.06

相较于原模型,对比引入ACM模块前后,参数量减少、浮点运算量减少、帧速率增加,这是由于原模型7×7方形卷积被替换后参数量减少,且每个位置所需要进行乘法和累加操作的总数减少,加快了模型的推理速度。在ACM提取特征时,更大的感受野增加了网络捕获上下文的能力,进食、躺卧、站立、行走4种行为识别准确率均有所提高。考虑到甩尾与站立、行走两种行为在识别时相似度过大,且牛尾、牛蹄在图像帧中占比过小,通过引入FAM模块,对各通道添加注意力机制并融合各通道特征,聚焦当前图像的重要特征,不同时间段光照下的效果如图7所示。

图7 不同光照条件下SimAM注意力机制识别效果可视化

Fig.7 Visualization of SimAM attention mechanism under different lighting conditions

进食行为集中学习头部及附近食槽,躺卧行为聚焦在腹部及贴近地面部分,行走及站立行为更加关注腿部和蹄部特征,而甩尾作为在其他基本行为状态下发生的行为,模型更注重学习尾部附近特征。在引入FAM后,模型识别的5种行为准确率均有提升,原因在于FAM从全局视图中捕获了更多上下文线索,降低了模型将奶牛主体或部位(牛尾、牛蹄)识别为背景的概率。SimAM注意力机制的添加增强了模型学习细化特征的能力,使得模型对于一些细小特征的变化更加敏感,尤其在甩尾、行走行为发生时,牛尾和牛蹄附近神经元表现出明显空间抑制效应,FAM为其赋予更高的优先权,抑制了周围环境特征的干扰,从而有效区分甩尾、站立、行走3种行为,其中甩尾行为识别效果提升最为明显。而计算复杂度略微增加,帧速率有所下降,主要由于逐点卷积在融合不同通道信息的过程中增加了模型的计算负载,尽管SimAM注意力机制无参数增加,但在计算注意力权重时,仍需要根据特征相似度进行加权以及对特征进行计算和比较操作,行为识别准确率的提升证明该方法是可行的。总体结果表明,本文方法可以实现高精度奶牛基本行为识别。

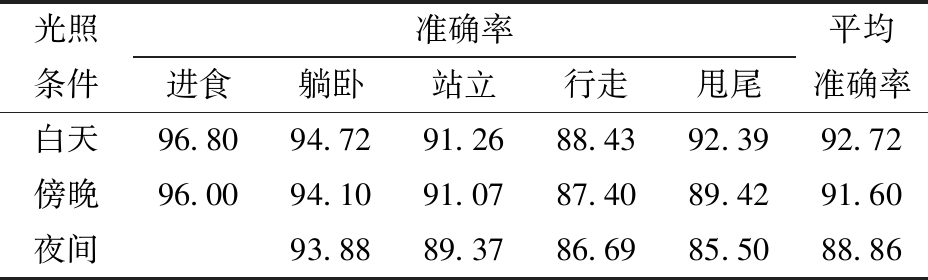

3.3.4 不同光照条件下模型鲁棒性分析

考虑到奶牛养殖场随时间变化,不同光照强度会干扰识别准确率,为保证选取的数据存在光照差异较大,选取10:00—03:00拍摄的视频,时间段包括白天、傍晚、夜间。分析不同时段光照下本文方法的实用性。由于夜间奶牛进食行为较少,本实验在夜间仅对其余4种行为进行识别。

验证结果如表4所示,同一行为识别准确率随着时间的推移而略微降低,可能原因是光照强度的降低使模型将奶牛主体识别为背景,但总体差距并不大。因非对称卷积核与SimAM的组合贯穿整个模型,ACM提取的较大感受野特征通过FAM模块融合空间和通道中包含的光照信息,并传递给下一模块,大大降低了模型将奶牛主体推理为背景的概率。实验结果表明,不同时间段光照条件的变化会对奶牛行为识别准确率产生一定的影响,但本文模型所受光照影响较小。

表4 不同光照条件下本文模型识别效果对比

Tab.4 Comparison of lighting results at different time periods %

光照条件准确率进食躺卧站立行走甩尾平均准确率白天96.8094.7291.2688.4392.3992.72傍晚96.0094.1091.0787.4089.4291.60夜间93.8889.3786.6985.5088.86

(1)为实现养殖场奶牛行为的识别,在ConvNeXt模型的基础上,引入非对称多分支卷积模块和特征注意力模块,提出了一种多分支并行结构且融合空间和通道注意力信息的奶牛行为识别模型。

(2)实验结果表明,CAFNet模型对进食、躺卧、站立、行走、甩尾行为的识别准确率分别达到95.50%、93.72%、89.26%、85.43%、91.39%。本文模型相较于ResNet 50、ResNeXt50、TFL-TSN、Swin-Transformer平均准确率分别提高13.03、7.95、8.46、5.06个百分点。

(3)不同时间段光照条件下的实验结果表明,光照强度的变化对奶牛行为识别准确率产生一定的影响,但本文模型所受影响较小。本文模型可以满足奶牛养殖场环境下奶牛行为识别的需要,为奶牛疾病监测及感知奶牛异常提供了技术支持。

[1] 程国栋, 吴建寨, 邢丽玮,等. 基于IMU的细粒度奶牛行为判别[J]. 中国农业大学学报, 2022, 27(4): 179-186.CHENG Guodong, WU Jianzhai, XING Liwei, et al. Fine-grained cow behavior discrimination based on IMU[J]. Journal of China Agricultural University, 2022, 27(4): 179-186. (in Chinese)

[2] 张宏鸣, 孙扬, 赵春平,等. 反刍家畜典型行为监测与生理状况识别方法研究综述[J]. 农业机械学报, 2023, 54(3): 1-21.ZHANG Hongming, SUN Yang, ZHAO Chunping, et al. Review on typical behavior monitoring and physiological status identification methods of ruminants[J]. Transactions of the Chinese Society for Agricultural Machinery, 2023, 54(3): 1-21.(in Chinese)

[3] 赵凯旋, 何东健. 基于卷积神经网络的奶牛个体身份识别方法[J]. 农业工程学报, 2015, 31(5): 181-187.ZHAO Kaixuan, HE Dongjian. Individual cow identification method based on convolutional neural network[J]. Transactions of the CSAE, 2015, 31(5): 181-187.(in Chinese)

[4] REITH S, HOY S. Review: behavioral signs of estrus and the potential of fully automated systems for detection of estrus in dairy cattle[J]. Animal, 2018, 12(2): 398-407.

[5] 康熙, 刘刚, 初梦苑,等. 基于计算机视觉的奶牛生理参数监测与疾病诊断研究进展及挑战[J]. 智慧农业(中英文), 2022, 4(2): 1-18.KANG Xi, LIU Gang, CHU Mengyuan, et al. Research progress and challenges of physiological parameter monitoring and disease diagnosis of dairy cows based on computer vision[J]. Smart Agriculture, 2022, 4(2): 1-18.(in Chinese)

[6] RIABOFF L, POGGI S, MADOUASSE A,et al.Development of a methodological framework for a robust prediction of the main behaviours of dairy cows using a combination of machine learning algorithms on accelerometer data[J]. Computers and Electronics in Agriculture, 2020, 169:105179.

[7] 王俊, 张海洋, 赵凯旋,等. 基于最优二叉决策树分类模型的奶牛运动行为识别[J]. 农业工程学报, 2018, 34(18): 202-210.WANG Jun, ZHANG Haiyang, ZHAO Kaixuan, et al. Dairy cow behavior recognition based on optimal binary decision tree classification model[J]. Transactions of the CSAE, 2018, 34(18): 202-210.(in Chinese)

[8] PENG Y, KONDO N, FUJIURA T, et al. Classification of multiple cattle behavior patterns using a recurrent neural network with long short-term memory and inertial measurement units[J]. Computers and Electronics in Agriculture, 2019, 157: 247-253.

[9] HOANG Q T, PHUNG C P K, BUI T N, et al. Cow behavior monitoring using a multidimensional acceleration sensor and multiclass SVM[J]. International Journal of Machine Learning and Networked Collaborative Engineering, 2018, 2(3): 110-118.

[10] WU D, WANG Y, HAN M, et al. Using a CNN-LSTM for basic behaviors detection of a single dairy cow in a complex environment[J]. Computers and Electronics in Agriculture, 2021, 182: 106016.

[11] YIN X, WU D, SHANG Y, et al. Using an EfficientNet-LSTM for the recognition of single cow’s motion behaviours in a complicated environment[J]. Computers and Electronics in Agriculture, 2020, 177: 105707.

[12] FUENTES A, YOON S, PARK J, et al. Deep learning-based hierarchical cattle behavior recognition with spatio-temporal information[J]. Computers and Electronics in Agriculture, 2020, 177: 105627.

[13] 王少华, 何东健, 刘冬. 基于机器视觉的奶牛发情行为自动识别方法[J]. 农业机械学报, 2020, 51(4): 241-249.WANG Shaohua, HE Dongjian, LIU Dong. Automatic recognition method of dairy cow estrus behavior based on machine vision[J]. Transactions of the Chinese Society for Agricultural Machinery, 2020, 51(4): 241-249.(in Chinese)

[14] YANG Q, XIAO D, CAI J. Pig mounting behaviour recognition based on video spatial-temporal features[J]. Biosystems Engineering, 2021, 206: 55-66.

[15] 刘忠超, 何东健. 基于卷积神经网络的奶牛发情行为识别方法[J]. 农业机械学报, 2019, 50(7): 186-193.LIU Zhongchao, HE Dongjian. Recognition method of cow estrus behavior based on convolutional neural network[J]. Transactions of the Chinese Society for Agricultural Machinery, 2019, 50(7): 186-193.(in Chinese)

[16] WANG R, GAO Z, LI Q, et al. Detection Method of cow estrus behavior in natural scenes based on improved YOLO v5[J]. Agriculture, 2022, 12(9): 1339.

[17] BLOCH V, FRONDELIUS L, ARCIDIACONO C, et al. Development and analysis of a CNN-and transfer-learning-based classification model for automated dairy cow feeding behavior recognition from accelerometer data[J]. Sensors, 2023, 23(5): 2611.

[18] MA S, ZHANG Q, LI T, et al. Basic motion behavior recognition of single dairy cow based on improved Rexnet 3D network[J]. Computers and Electronics in Agriculture, 2022, 194: 106772.

[19] 王克俭,孙奕飞,司永胜,等.基于时空特征的奶牛视频行为识别[J].农业机械学报,2023,54(5):261-267,358.WANG Kejian, SUN Yifei, SI Yongsheng, et al. Video behavior recognition of dairy cows based on spatio-temporal features[J]. Transactions of the Chinese Society for Agricultural Machinery, 2023, 54(5): 261-267,358.(in Chinese)

[20] WANG L, XIONG Y, WANG Z, et al. Temporal segment networks: towards good practices for deep action recognition[C]∥European Conference on Computer Vision. Springer, Cham, 2016: 20-36.

[21] 顾静秋,王志海,高荣华,等.基于融合图像与运动量的奶牛行为识别方法[J].农业机械学报,2017,48(6):145-151.GU Jingqiu, WANG Zhihai, GAO Ronghua, et al. Recognition method for cow behavior based on combination of image and activities[J]. Transactions of the Chinese Society for Agricultural Machinery, 2017, 48(6): 145-151.(in Chinese)

[22] LIU Z, LIN Y, CAO Y, et al. Swin transformer: hierarchical vision transformer using shifted windows[C]∥Proceedings of the IEEE/CVF International Conference on Computer Vision, 2021: 10012-10022.

[23] YANG L, ZHANG R Y, LI L, et al. Simam: a simple, parameter-free attention module for convolutional neural networks[C]∥International Conference on Machine Learning. PMLR, 2021: 11863-11874.

[24] HSIAO T Y, CHANG Y C, CHOU H H, et al. Filter-based deep-compression with global average pooling for convolutional networks[J]. Journal of Systems Architecture, 2019, 95: 9-18.

[25] XIONG R, YANG Y, HE D, et al. On layer normalization in the transformer architecture[C]∥International Conference on Machine Learning. PMLR, 2020: 10524-10533.

[26] BA J L, KIROS J R, HINTON G E. Layer normalization[J]. arXiv preprint, arXiv:1607.06450, 2016.

[27] HENDRYCKS D, GIMPEL K. Gaussian error linear units (gelus)[J]. arXiv preprint, arXiv:1606.08415, 2016.

[28] LOSHCHILOV I, HUTTER F. SGDR: stochastic gradient descent with warm restarts[J]. arXiv preprint, arXiv:1608.03983, 2016.