动物行为通常可以作为评估其健康状况的一个重要参考[1-2],当动物处于生病、疼痛状态或特定的生理阶段时会表现出不同的行为特征[3]。例如绵羊在感染羊痒螨后会表现出抓挠、撕咬等异常行为[3];当绵羊患病时,其反刍时间会有明显的变化[4]。因此,监测动物行为表现可以用于疾病早期检测[5-7],例如可以根据绵羊行走状态来诊断跛行[6],根据反刍活动判断瘤胃健康状态[8]。利用人工观察进行动物行为监测不仅耗时、低效而且容易产生主观错误[9],因此已经不适应规模化养殖的需要[10]。基于盈利和动物福利考虑,设计合理的自动监测和识别分类系统可以有效替代人工进行动物行为监测[11-12]。

基于计算机视觉的动物行为监控方法因为具有非接触、无应激和效率高的特点已经逐渐开始替代可穿戴式传感器,被用到精准畜牧养殖领域[7],并在动物行为评估中发挥着重要作用[13]。随着深度学习的迅速发展,将计算机视觉和深度学习结合进行动物行为监控和分析得到了较多的研究。研究人员基于获取的图像通过深度学习进行动物行为识别和分类,很多深度学习模型得到了应用,比如Faster R-CNN[14]、YOLO[15]、SSD[16]、Mask R-CNN[17]、FCN[18]等被用于识别动物的行为。利用深度学习进行动物行为识别的前提是基于大量的训练样本对模型进行训练,而样本制作通常采用图像标记和注释的方式,这需要消耗大量的人力和时间成本[10]。此外,基于图像进行深度学习模型的训练,只能从静止图像中提取空间特征,这忽略了行为的连贯性和时间特征(运动信息)。行为是由在时间序列上的一系列连续活动组成的,连续帧之间的时间信息对于判断行为类别是很重要的,尤其是在区分类似行走和站立等活动和非活动行为时。然而基于静态图像去定义或分类这些特征可能会面临挑战[19]。因此,有必要结合空间和时间信息来识别动物行为。

基于连续的视频序列进行深度学习模型的训练和识别可以克服基于静态图像所带来的问题[20-21]。因此,基于视频的动物行为识别近年来得到了大量研究,一些研究人员尝试从视频的多帧连续图像中提取运动特征以获得更丰富的动态行为状态,并对行为类别进行判断。目前,这些研究已经被应用到多种动物的行为识别中,例如牛的站立和行走[21]、饮水、进食和反刍[22-23]、跛行[24]等。在猪的进食、躺卧、行走、抓挠、攀爬和爬跨行为[19,25-26]、咬尾行为[27]、饮水和饮水时游戏[28]、侵略性行为[29] 等的行为识别研究中也使用了基于视频和深度学习的方法。提取视频特征所用到的深度学习网络,包括但不限于双流卷积网络[30]、三维卷积神经网络[31]和LSTM网络[32-33]等。作为一种特殊的RNN网络,LSTM网络具有记忆长短期信息能力,可以处理时序问题。与对行为进行建模的双流和三维卷积网络不同,基于LSTM的方法将视频视为有序的帧序列,行为可以通过每一帧的特征变化来表示。BiLSTM是由前向LSTM和后向LSTM组合而成,可以分别捕获绵羊过去和未来隐含的时间序列特征[23]。考虑到动物行为转换的双向性质,例如动物在某一时间段内发生从站立到行走,再从行走到站立的转换,使用双向LSTM可以改善分类结果。此外,2个行为状态之间转换的过渡过程容易造成识别的干扰[34],而在实际监测中过渡过程不能忽略,使用双向LSTM将有助于显示过渡过程的正确分类[35]。

残差网络在图像领域是一种主流模型,内部使用跳跃连接,通过使用残差连接,能够通过增加深度来提高准确率并减少过拟合的发生。Res3D作为常用的三维残差卷积神经网络,在行为识别领域得到了广泛应用[36-37]。为了提高动物行为识别能力,减少制作深度学习模型训练集时人工和时间成本,本文在三维残差卷积神经网络Res3D和BiLSTM的基础上进行优化,设计一种深度学习网络用于绵羊行为快速精准识别。

本研究使用的视频数据来自河北省衡水市志豪畜牧科技有限公司的现场试验,试验时间为2021年2月7日—4月25日。试验时随机选择一个羊舍内的4个围栏,每个围栏的尺寸均为3 m×2.5 m。试验选择的羊舍是孕羊专用羊舍,每个围栏内有一只怀孕的小尾寒羊。当孕羊分娩后被转移,新的怀孕母羊被放置进来。每个围栏内安装一个摄像机(海康威视,2CD2T46XMV3-LGLSE)。摄像机安装位置距离地面2 m,向下倾斜65°拍摄,这种安装方式能够使拍摄的视频画面仅包括目标围栏中的羊只活动区域。试验过程中,共获取13只羊的视频,这些视频包括羊只进食、行走、站立、躺卧和反刍等各种行为。所有试验均通过河北农业大学动物实验伦理委员会审批(ID:1090064)。

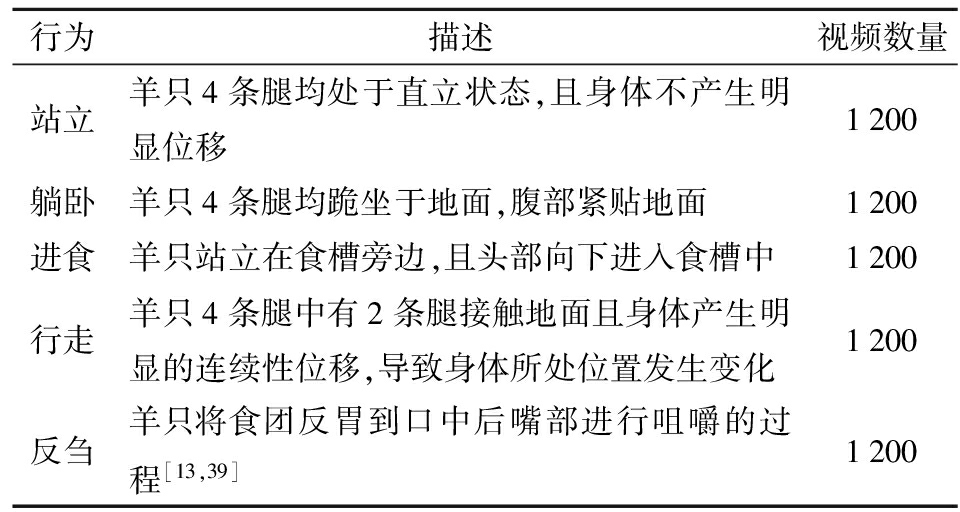

从13只羊的视频里随机选择4只羊的视频,采用公开数据集UCF101的格式来制作视频训练数据集。视频处理过程中,对羊只的进食、站立、行走、躺卧和反刍5种行为进行观察和剪辑,使每一段短视频中只包含一种行为,羊只不同行为定义如表1所示。经过处理,共得到6 000个短视频,其中每种行为短视频数量均为1 200个,视频时长为5~15 s,帧率为30 f/s。制作完成的短视频按照行为的不同被分别放到对应的文件夹下,文件夹采用行为类型来命名。由于行为类型不同,每个短视频长度并不完全一致,所以导致每种行为类型的视频总长度也不完全相同,但是这种差异是正常且可以被接受的[38]。此外,制作完成的短视频包含不同时间段和不同光照情况的样本,这保证了该方法对不同照明条件的适应性和训练数据的丰富性。此外,从原始视频中另外制作1 200个时长为6 s的短视频构成测试数据集。测试数据集中羊只每种行为短视频数量均为240,且测试数据集与训练数据集中的视频不重复。

表1 行为数据集信息

Tab.1 Behavior dataset information

行为描述视频数量站立羊只4条腿均处于直立状态,且身体不产生明显位移1200躺卧羊只4条腿均跪坐于地面,腹部紧贴地面1200进食羊只站立在食槽旁边,且头部向下进入食槽中1200行走羊只4条腿中有2条腿接触地面且身体产生明显的连续性位移,导致身体所处位置发生变化1200反刍羊只将食团反胃到口中后嘴部进行咀嚼的过程[13,39]1200

羊只的行为是一个连续的状态,上一时刻的行为与下一时刻行为之间具有很强的相关性和连续性。与图像相比,视频流同时包含空间和时间特征信息,能够很好地反映出连续帧之间的相关性和连续性。利用深度学习网络可以提取出运动行为之间的时序特征,从而判断出不同的行为类型。本文设计了一种融合三维残差卷积神经网络、注意力机制和双向长短期记忆网络的深度学习网络模型(AdRes3D-BiLSTM),基于视频流识别羊只的不同行为。

图1为AdRes3D-BiLSTM网络模型结构图,该模型首先使用Res3D模块分析视频流中连续帧的时空信息,然后将提取的特征向量序列输入BiLSTM模块进行时序特征筛选和更新,最后根据BiLSTM的输出对羊只行为结果进行识别和分类。本文设计的深度学习网络在Res3D模块的特征提取部分引入了深度可分离卷积,大幅度减少了浮点运算量和模型大小,并嵌入基于运动的注意力机制,专注于行为特征以提高识别能力。在Res3D特征提取模块中,Conv3D表示3D卷积操作,3×7×7和3×3×3表示卷积核尺寸,64、128、256和512表示通道数,DSConv表示深度可分离卷积,Conv表示普通卷积,折线表示残差连接,Fully connect(FC)表示全连接层;在Actionnet注意力模块中,Conv为卷积操作,3×3×3、1×1、3×3表示卷积核尺寸,Channel pooling表示对通道上的输入张量进行平均,Spatial pooling表示对输入进行空间平均池化,X(t)、X(t+1)、X(t+2)表示相邻的帧,Concat表示向量数据的拼接操作,Sigmoid为深度学习中常用的激活函数。

图1 AdRes3D-BiLSTM结构

Fig.1 AdRes3D-BiLSTM structure

视频流的各个组成帧之间存在较强的时空关联性,二维卷积只能提取空间特征而无法提取时间关联信息。多个连续的帧可以叠加成一个视频空间,在这个空间中可以使用三维(Three dimensional,3D)卷积核代替二维卷积核执行卷积操作,这样实现了空间范围内卷积操作代替平面上的卷积操作。3D卷积可以捕捉到连续帧之间存在的时空特征,即可以整合空间和时间信息[40],进而捕捉到羊只行为的运动信息,这样可以有效提升分类精度。此外,18层的Res3D网络结构深度在视频分类的准确性、计算复杂度和内存之间达到较好的平衡[41],所以本文采用18层的Res3D网络作为前期提取网络。

深度可分离卷积可以将标准化卷积分解为深度卷积和逐点卷积[42],运算时深度卷积先对输入向量的每个通道进行卷积,然后利用逐点卷积完成对深度卷积输出向量的组合。与普通卷积相比,深度可分离卷积可以显著减少参数量。如图1所示,为了防止网络不稳定,在Resnet块2、Resnet块4、Resnet块6、Resnet块8中选择交叉使用深度可分离卷积和普通卷积,使网络模型轻量化,克服了3D卷积计算量大的缺点。

输入网络的视频中不同的帧对判断行为类别起的作用不同,比如羊只由站立行为过渡到行走行为时,表现出羊只行走的帧往往比表现出羊只将要行走从而发生身体移动的帧更加关键,此类动作有较强的时序性。为了区分各帧中特征图的重要程度,本文在Res3D网络中引入基于运动的混合注意力机制模块Actionnet[43]来重新分配特征图之间的权重,加大对关键特征图的关注,弱化冗余特征图对识别结果的影响,从而提高网络提取行为特征的鲁棒性,其构成如图1所示。Actionnet由时空注意力模块(STE)、通道注意力模块(CE)和运动注意力模块(ME) 3个子模块组成。在提取羊只行为特征过程中,STE子模块利用3D卷积激发时空信息,提取出对分类有用的关键特征信息;CE子模块通过在2个FC层之间插入一维卷积层来表征通道特征的时间信息;ME子模块利用相邻帧之间的时间维度建模运动信息。为了可以同时融合时空、通道、运动3个方面的特征信息,将这3个子模块并联组成Actionnet模块,Actionnet模块最终的输出量通过这3个子模块各自生成的特征相加得到。Actionnet模块兼顾了时空信息、不同通道间的时序信息和相邻帧之间动作的变化轨迹3个重要信息,使网络更关注真正感兴趣的区域,对相对重要的信息分配更多的权重,忽略不重要的信息。

RNN由于梯度消失的原因只能有短期记忆,而LSTM引入了门函数(遗忘门、输入门、输出门)和记忆单元,很好地解决了这个问题,是一种更稳健的RNN形式[32]。如图1所示,BiLSTM由一个前向 LSTM层和一个后向LSTM层构成,前向 LSTM利用先前的信息来预测当前行为类别,后向 LSTM利用未来的信息来预测当前行为类别,上下文信息同时得到利用的方式有助于提高模型的行为识别能力。与传统的单向LSTM相比,BiLSTM可以同时学习过去和未来的信息,从而获得更加稳健的时间特征,这样能够更好地获得视频中羊只运动时产生的时序数据特征之间的相关性。因此,本文在Res3D-Actionnet模块之后采用BiLSTM来进一步处理时序数据。最后经过行为预测模块的全连接层输入到Softmax层,最终输出行为预测结果和置信度。

本文设计的AdRes3D-BiLSTM网络模型训练时输入图像尺寸为112像素×112像素,网络的初始学习率为0.01,利用迭代周期(epoch)衰减策略,每迭代10次通过将学习率除以10来更新一次参数值,优化器为Adam。训练批量大小设为8。隐藏层维数设为512,经过Bi-LSTM提取的特征向量序列输入到全连接层的维数为1 024,输出维数为5的向量。网络最后的Softmax层的参数dim设为1。试验进行的迭代次数为600次,每10次保存一个权重模型,共保存60个权重文件。

训练数据集中随机抽取64%的短视频作为训练网络时的训练数据,20%和16%的短视频分别作为训练过程中用于模型性能分析的测试数据和验证数据。羊只的运动是一个持续性的过程,不可能在瞬间发生突变。为了提高在训练和识别过程中的效率,对数据集中的短视频以每3帧提取1帧的方式进行稀疏采样。将每个视频转换出来的图像序列按照视频的原始顺序命名,从中选取连续的16帧作为一次输入。

本文构建的AdRes3D-BiLSTM网络模型基于Python 3.6编程语言和Pytorch 1.0.0深度学习框架来实现。运行网络的计算机采用i9-10900 K 3.70 GHz CPU,NVIDIA GeForce RTX 3090 GPU,32 GB内存,操作系统为64位Ubuntu 20.04,CUDA版本为11.4。

采用精确率(Precision,P)、召回率(Recall,R)、F1值(F1-score)和准确率(Accuracy,A)4个指标对网络模型的性能进行评价。

此外,采用帧速率评价模型的检测速度,采用浮点运算量评价模型的计算复杂度,采用内存占用量评价模型大小。

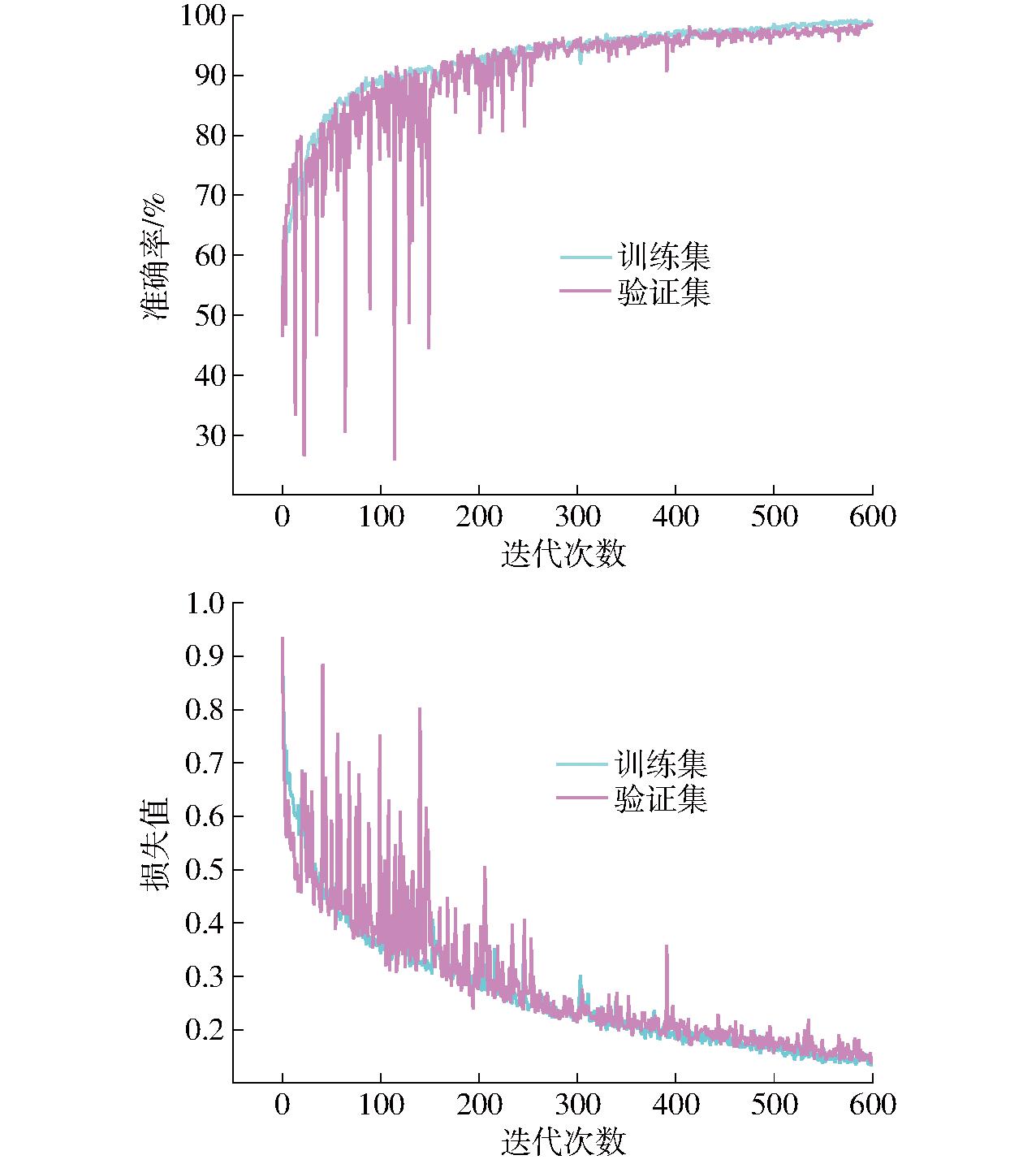

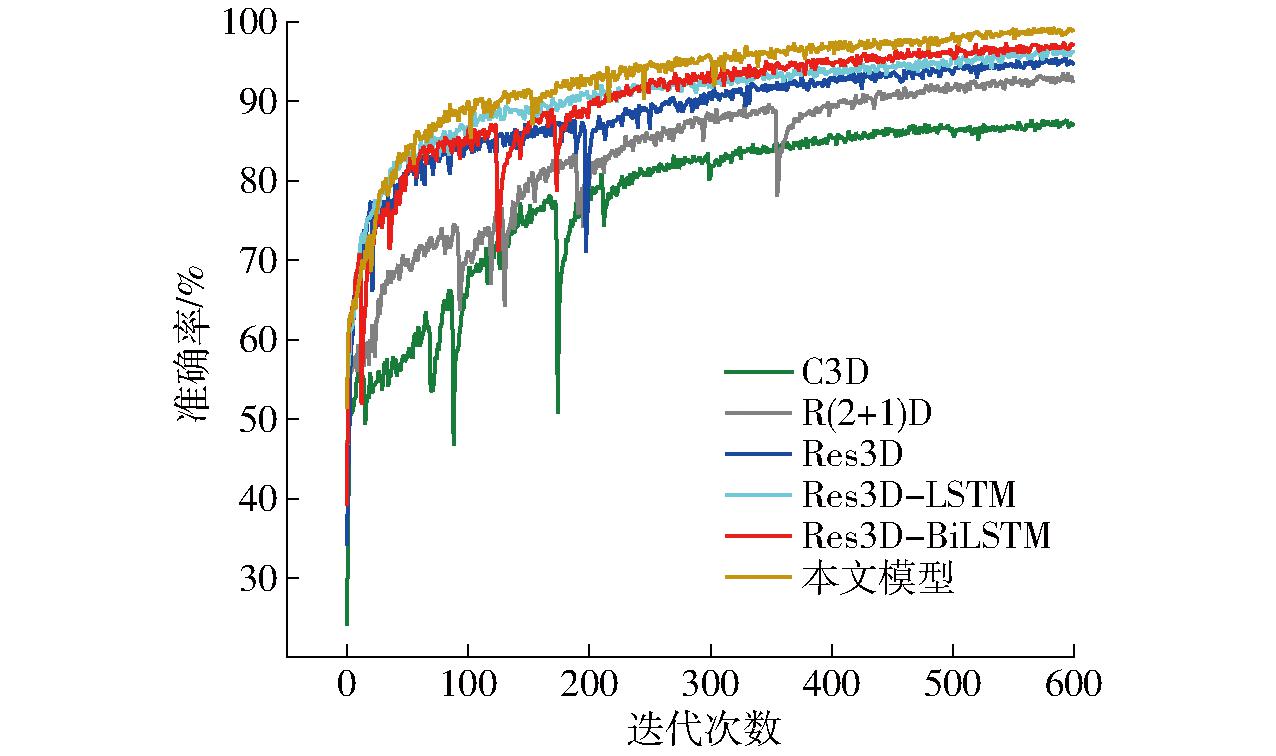

模型训练过程如图2所示,共进行600次迭代。从图2中可以看出,在前150次迭代训练中,模型的识别准确率和损失值虽然出现较为明显的振荡,但是分别呈现出快速上升和快速下降的总体趋势。150~400次迭代中,模型的识别准确率和损失值的振荡明显下降。迭代400次之后,模型准确率的上升趋势逐渐变缓,损失值下降趋势也逐渐变缓直至趋于稳定。

图2 行为识别模型训练集和验证集的损失值和准确率变化曲线

Fig.2 Loss and accuracy change curves of train and validation set for behavior recognition model

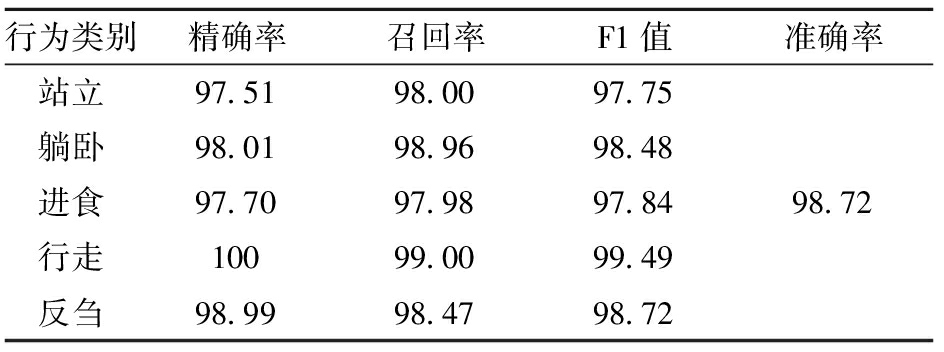

测试集中的1 200个短视频被输入训练完成的AdRes3D-BiLSTM网络中进行行为识别。输入视频时采用滑动窗口采样机制将连续的图像帧输入网络[13],每3帧提取1帧,连续提取16帧作为一个滑动窗口。表2为测试集识别结果,从表中可以看出,站立和进食行为识别精确率较低,分别为97.51%和97.70%。行走行为识别精确率最高,为100%。从召回率和F1值来看,表现出了相同的规律。网络模型综合识别准确率达到98.72%。这表明Res3D-BiLSTM网络对于运动特征明显的行为具有很好的识别效果。

表2 羊只不同行为的精确率、召回率和F1值

Tab.2 Precision,recall,and F1-score of different behaviors of sheep %

行为类别精确率召回率F1值准确率站立97.5198.0097.75躺卧98.0198.9698.48进食97.7097.9897.8498.72行走10099.0099.49反刍98.9998.4798.72

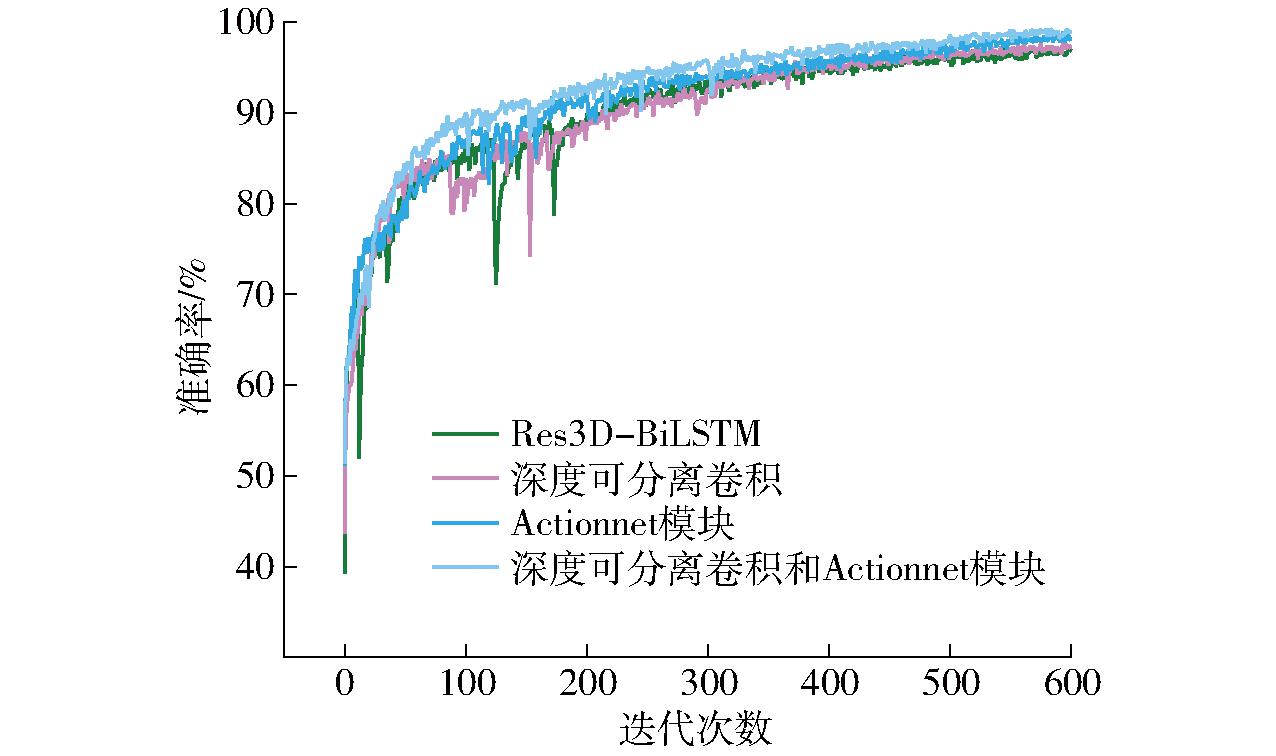

本文设计的AdRes3D-BiLSTM网络中引入深度可分离卷积和Actionnet两种操作,为了验证这两种处理模式对网络性能的影响,设计了消融试验。图3为引入深度可分离卷积和Actionnet前后,网络模型在训练过程中表现的对比。从图3中可以看出,当只引入深度可分离卷积后,在前200次迭代过程中,网络的振荡得到一定的改善。经过200次迭代后,网络性能的提高变得不再明显。当只引入Actionnet后,在整个训练过程中,网络性能的提升始终体现。这表明相对于深度卷积,Actionnet对网络的性能影响更大。当深度可分离卷积和Actionnet全部引入网络后,网络性能提升更加明显,这表明引入这两种操作有效地提升了网络训练性能。

图3 不同模块的训练精度曲线

Fig.3 Training accuracy curves for different modules

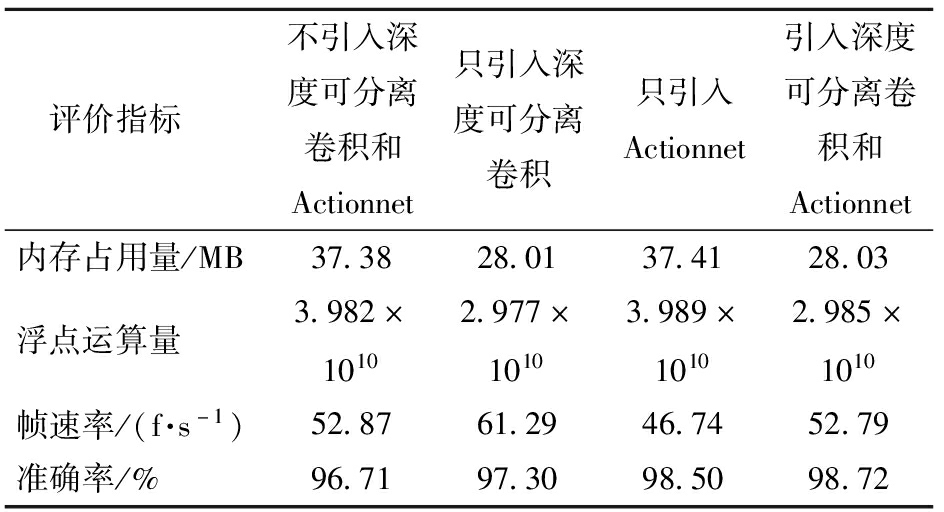

表3为引入深度可分离卷积和Actionnet前后网络在测试集的识别结果。从表3可以看出,将普通卷积替换为深度可分离卷积后,网络模型的内存占用量减少了25.06%,浮点运算量减少了25.23%,并且帧速率达到了61.29 f/s,执行速度提高了15.92%,为后续应用到边缘设置奠定了基础。此外,当引入深度可分离卷积后,模型识别准确率提高了0.59个百分点,达到97.30%。虽然引入深度可分离卷积对模型精度的提高影响较小,但是使模型浮点运算量和内存占用量得到了大幅度降低。因此,引入深度可分离卷积比较好地兼顾模型压缩和提升速度的需求,为网络轻量化带来了可能。单独引入Actionnet模块后网络在测试集的识别准确率达到了98.50%,比原来提高了1.79个百分点。

表3 不同模块在AdRes3D-BiLSTM网络中产生的影响

Tab.3 Effects of different modules on AdRes3D-BiLSTM networks

评价指标不引入深度可分离卷积和Actionnet只引入深度可分离卷积只引入Actionnet引入深度可分离卷积和Actionnet内存占用量/MB37.3828.0137.4128.03浮点运算量3.982×10102.977×10103.989×10102.985×1010帧速率/(f·s-1)52.8761.2946.7452.79准确率/%96.7197.3098.5098.72

当引入深度可分离卷积和基于运动的Actionnet后,网络模型对测试集的识别准确率提高了2.01个百分点。而且帧速率达到52.79 f/s,比视频帧率提高75.96%,可以满足实时识别的要求。此外,模型内存占用量和浮点运算量分别下降了25.01%和25.03%,以最小的计算开销实现了高精度行为识别。

近年来,三维卷积神经网络被越来越多的应用于行为识别领域,C3D[33]和R(2+1)D[44]是较为常见的三维卷积神经网络模型,本团队在前期工作中设计了一种Res3D-LSTM网络模型并进行了检验。为了检验本文提出的AdRes3D-BiLSTM网络模型的性能,设计了一个对比试验。使用同样的训练集和测试集对C3D、R(2+1)D、Res3D、Res3D-LSTM、Res3D-BiLSTM和AdRes3D-BiLSTM共6种网络模型的识别效果进行了比较。

3.2.1 训练过程比较

图4为6种不同模型的训练精度曲线,从图中可以看出,C3D模型在训练过程中振荡最明显,且训练结束后最终稳定值也最小。其他5种模型训练结果均优于C3D,Res3D训练结果优于R(2+1)D,将Res3D和LSTM结合,训练性能进一步得到提升。将LSTM替换为BiLSTM后与Res3D结合,训练性能没有明显的改善。但是加入深度可分离卷积和Actionnet注意力(AdRes3D-BiLSTM)后,模型的训练性能再次得到提升。此外,AdRes3D-BiLSTM模型在整个训练过程中几乎没有出现较大的振荡。

图4 不同模型的训练精度曲线

Fig.4 Comparison model training accuracy curves

3.2.2 测试集识别结果比较

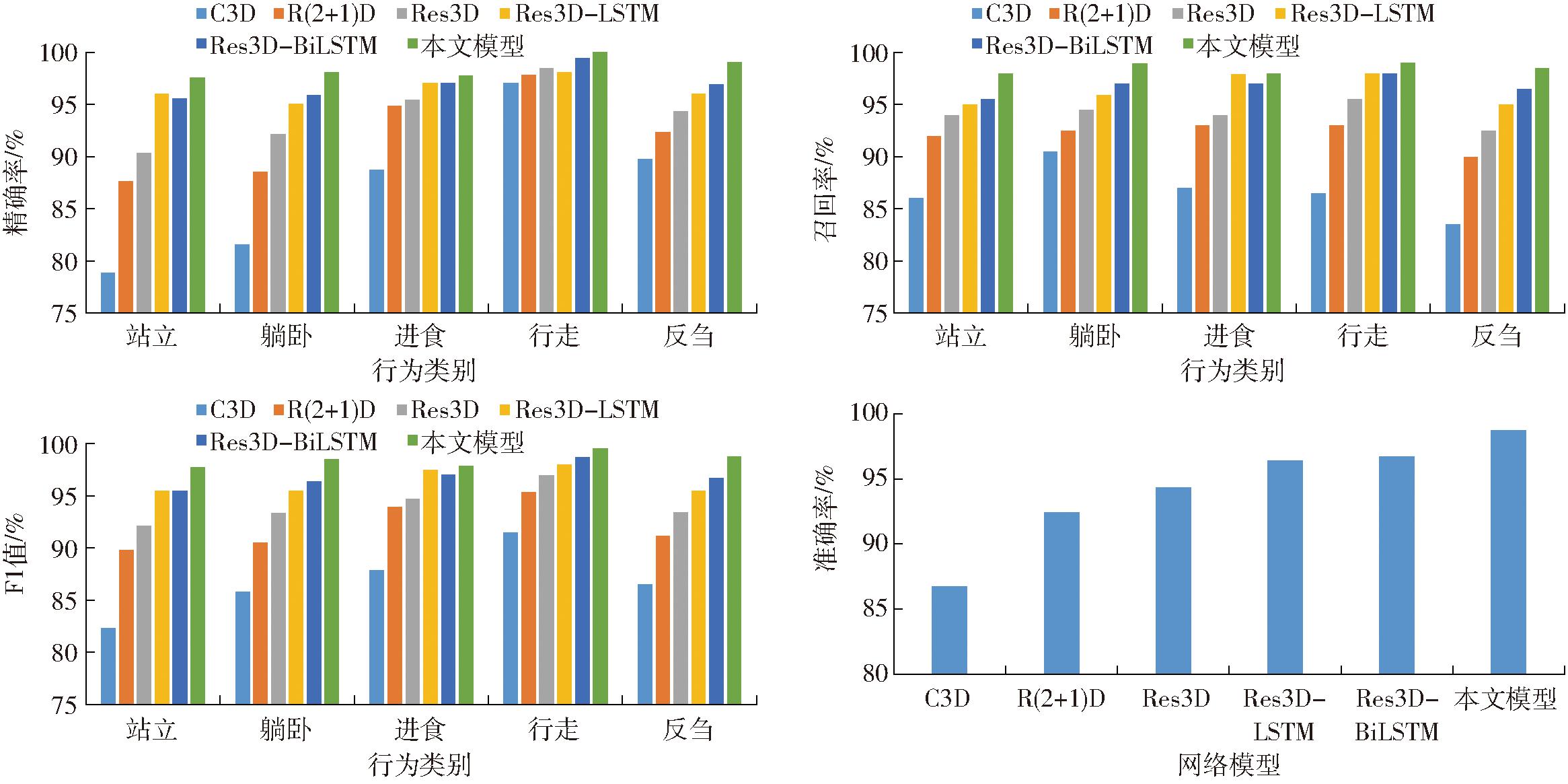

训练完成的6种网络模型在同一个测试集上分别进行了行为识别,识别结果如图5所示。从图中可以看出,对于羊只5种行为,在识别的精确率、召回率、F1值和准确率4个评价指标上,AdRes3D-BiLSTM网络模型均得分最高。相对于C3D、R(2+1)D、Res3D、Res3D-LSTM、Res3D-BiLSTM模型,AdRes3D-BiLSTM的识别精确率分别提高了11.32、6.24、4.34、2.04、1.52个百分点,识别召回率分别提高了11.78、6.38、4.38、2.12、1.68个百分点,识别的F1值分别提高了11.70、6.35、4.38、2.08、1.60个百分点,识别的准确率分别提高了11.97、6.33、4.37、2.32、2.01个百分点。

图5 基于不同模型的羊只不同行为识别精确率、召回率、F1值和准确率对比

Fig.5 Comparison of precision,recall,F1-score,and accuracy based on different models in recognizing different behaviors of sheep

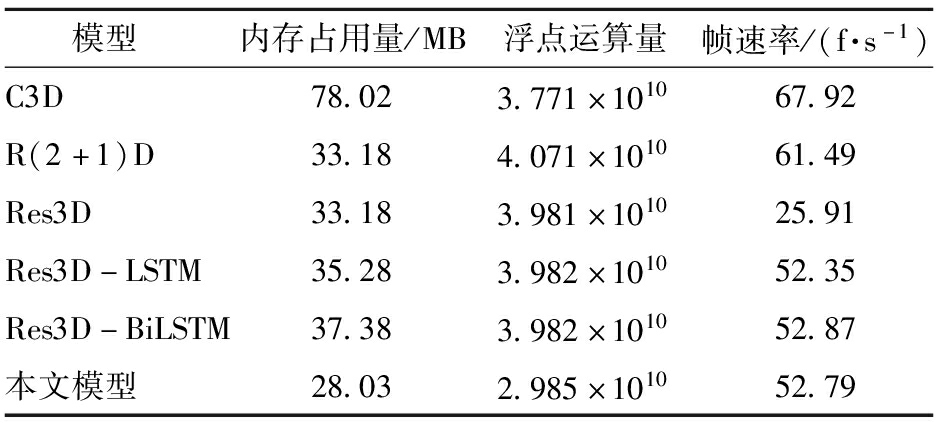

表4为6种不同网络模型在内存占用量、浮点运算量和帧速率3个性能指标上的对比结果。从表4中可以看出,AdRes3D-BiLSTM模型的内存占用量最小,仅为28.03 MB,比C3D、R(2+1)D、Res3D、Res3D-LSTM、Res3D-BiLSTM分别降低了49.99、5.15、5.15、7.25、9.35 MB。与之类似的是,AdRes3D-BiLSTM模型浮点运算量也是6种模型中最小的,为2.985×1010,比C3D、R(2+1)D、Res3D、Res3D-LSTM、Res3D-BiLSTM分别降低7.86×109、1.086×1010、9.96×109、9.97×109、9.97×109。在帧速率方面,AdRes3D-BiLSTM虽然低于C3D的67.92 f/s和R(2+1)D的61.49 f/s,但是仍然达到了52.79 f/s。在一般的视频流中,帧率一般为30 f/s,因此AdRes3D-BiLSTM的实时处理速度完全可以满足要求。

表4 不同时空特征提取网络对比

Tab.4 Comparison of different spatio-temporal feature extraction networks

模型内存占用量/MB浮点运算量帧速率/(f·s-1)C3D78.023.771×101067.92R(2+1)D33.184.071×101061.49Res3D33.183.981×101025.91Res3D-LSTM35.283.982×101052.35Res3D-BiLSTM37.383.982×101052.87本文模型28.032.985×101052.79

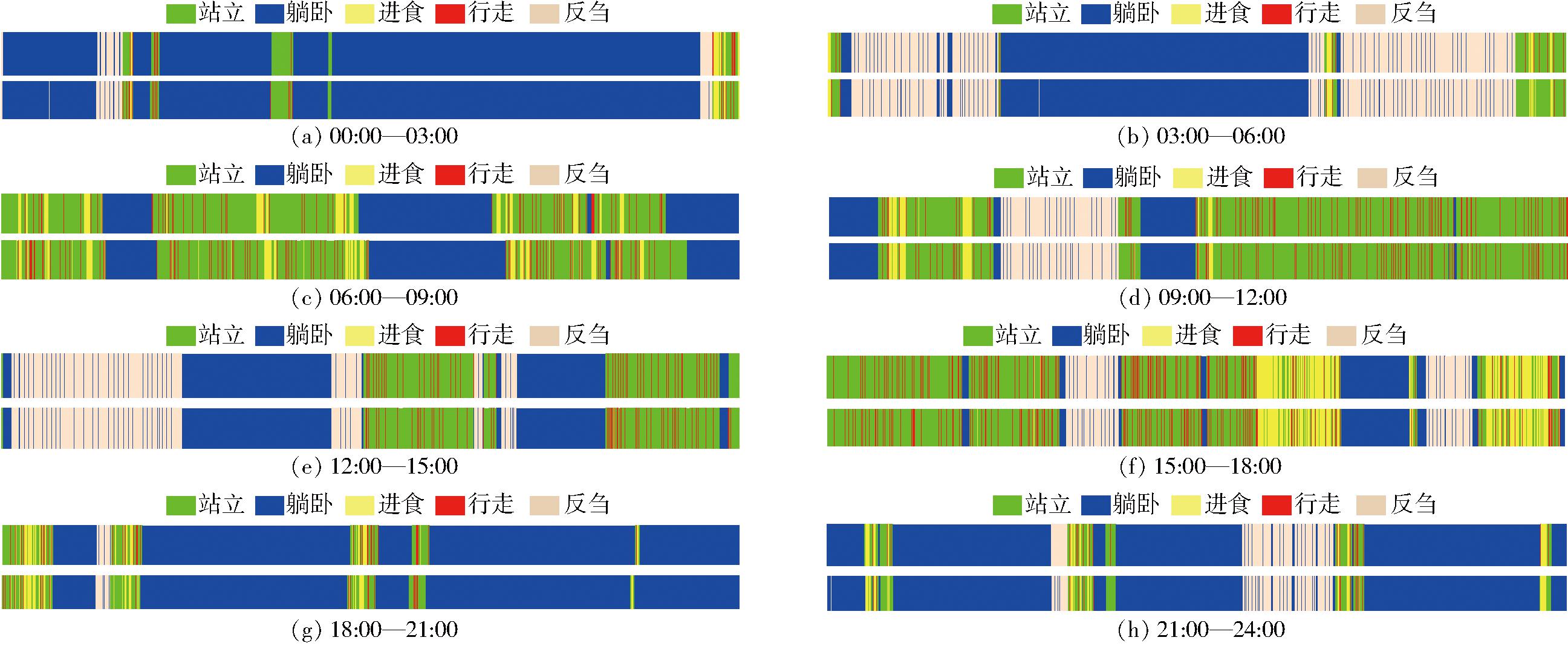

为了进一步验证和分析AdRes3D-BiLSTM网络模型的性能,从收集的羊只生产前7 d的视频数据中随机选择一个24 h的连续视频,将24 h的视频数据分为8段分别进行试验。视频内共包含羊只站立、躺卧、进食、行走、反刍5种行为。图6为识别结果,上图为某个视频中真实行为在时间轴上的分布,下图为网络识别出的行为在时间轴上的分布。

图6 绵羊连续视频的行为识别结果

Fig.6 Behavior recognition results of continuous sheep videos

从图6中可以看出,在一种行为向另一种行为过渡时,AdRes3D-BiLSTM网络容易产生误识别。误识别的原因有2个:①羊只进食过程中,头部偶尔会短暂抬起,然后继续进食,虽然整个过程都应该属于进食状态,但是当羊只短暂抬头时在视觉上与站立行为很相似,容易造成误识别。②为了减少系统开销,使用了滑动窗口机制对视频流进行抽帧处理,这也容易导致在行为状态发生改变时做出错误的识别[13]。

本文融合Res3D、BiLSTM和注意力机制设计了一个用于羊只行为识别的三维卷积神经网络模型(AdRes3D-BiLSTM),并引入深度可分离卷积提高了深度学习模型轻量化程度。该模型可以直接基于视频进行训练并对视频进行行为识别。试验结果表明,该模型对羊只5种不同行为综合识别准确率达到了98.72%,帧速率可达52.79 f/s,能够满足针对视频流的羊只行为实时识别的要求。

[1] MEPHAM T B.The role of food ethics in food policy[J].Proceedings of the Nutrition Society,2020,59:609-618.

[2] 齐琳,包军,李剑虹.动物行为学研究在动物福利养殖中的应用[J].中国动物检疫,2009(9):68-69.

[3] GOUGOULIS D A,KYRIAZAKIS I,FTHENAKIS G C.Diagnostic significance of behaviour changes of sheep:a selected review[J].Small Ruminant Research,2010,92(1-3):52-56.

[4] MANSBRIDGE N,MITSCH J,BOLLARD N,et al.Feature selection and comparison of machine learning algorithms in classification of grazing and rumination behaviour in sheep[J].Sensors,2018,18(10):3532.

[5] MARTISKAINEN P,J RVINEN M,SKÖN J P,et al.Cow behavior pattern recognition using a three-dimensional accelerometer and support vector machines[J].Applied Animal Behaviour Science,2009,119(1-2):32-38.

RVINEN M,SKÖN J P,et al.Cow behavior pattern recognition using a three-dimensional accelerometer and support vector machines[J].Applied Animal Behaviour Science,2009,119(1-2):32-38.

[6] BARWICK J,LAMB D,DOBOS R,et al.Predicting lameness in sheep activity using tri-axial acceleration signals[J].Animals,2018,8(1):12.

[7] SU Q G,TANG J L,ZHAI M X,et al.An intelligent method for dairy goat tracking based on Siamese network[J].Computers and Electronics in Agriculture,2022,193:106636.

[8] CHEN Y J,HE D J,FU Y X,et al.Intelligent monitoring method of cow ruminant behavior based on video analysis technology[J].International Journal of Agricultural and Biological Engineering,2017,10(5):194-202.

[9] ALVARENGA F A P,BORGES I,PALKOVI L,et al.Using a three-axis accelerometer to identify and classify sheep behaviour at pasture[J].Applied Animal Behaviour Science,2016,181:91-99.

L,et al.Using a three-axis accelerometer to identify and classify sheep behaviour at pasture[J].Applied Animal Behaviour Science,2016,181:91-99.

[10] CHENG M,YUAN H B,WANG Q F,et al.Application of deep learning in sheep behaviors recognition and influence analysis of training data characteristics on the recognition effect[J].Computers and Electronics in Agriculture,2022,198:107010.

[11] DWYER C M,LAWRENCE A B.Frequency and cost of human intervention at lambing:an interbreed comparison[J].Veterinary Record,2005,157(4):101-104.

[12] STOTT A W,MILNE C E,GODDARD P J,et al.Projected effect of alternative management strategies on profit and animal welfare in extensive sheep production systems in Great Britain[J].Livestock Production Science,2005,97(2-3):161-171.

[13] NASIRAHMADI A,STURM B,EDWARDS S,et al.Deep learning and machine vision approaches for posture detection of individual pigs[J].Sensors,2019,19(17):3738.

[14] RAO Y,JIANG M,WANG R,et al.On-farm welfare monitoring system for goats based on internet of things and machine learning[J/OL].International Journal of Distributed Sensor Networks,2020.https:∥doi.org/10.1177/1550147720944030.

[15] 王少华,何东健.基于改进YOLO v3模型的奶牛发情行为识别研究[J].农业机械学报,2021,52(7):141-150.

WANG Shaohua,HE Dongjian.Estrus behavior recognition of dairy cows based on improved YOLO v3 model[J].Transactions of the Chinese Society for Agricultural Machinery,2021,52(7):141-150.(in Chinese)

[16] ZHANG Y Q,CAI J H,XIAO D Q,et al.Real-time sow behavior detection based on deep learning[J].Computers and Electronics in Agriculture,2019,163:104884.

[17] 李丹,张凯锋,李行健,等.基于 Mask R-CNN 的猪只爬跨行为识别[J].农业机械学报,2019,50(增刊):261-266.

LI Dan,ZHANG Kaifeng,LI Xingjian,et al.Mounting behavior recognition for pigs based on Mask R-CNN[J].Transactions of the Chinese Society for Agricultural Machinery,2019,50(Supp.):261-266.(in Chinese)

[18] YANG A Q,HUANG H S,YANG X F,et al.Automated video analysis of sow nursing behavior based on fully convolutional network and oriented optical flow[J].Computers and Electronics in Agriculture,2019,167:105048.

[19] ZHANG K F,LI D,HUANG J Y,et al.Automated video behavior recognition of pigs using two-stream convolutional networks[J].Sensors,2020,20(4):1085.

[20] FUENTES A,YOON S,PARK J,et al.Deep learning-based hierarchical cattle behavior recognition with spatio-temporal information[J].Computers and Electronics in Agriculture,2020,177:105627.

[21] QIAO Y L,GUO Y Y,YU K P,et al.C3D-ConvLSTM based cow behaviour classification using video data for precision livestock farming[J].Computers and Electronics in Agriculture,2022,193:106650.

[22] YIN X Q,WU D H,SHANG Y Y,et al.Using an EfficientNet-LSTM for the recognition of single cow’s motion behaviours in a complicated environment[J].Computers and Electronics in Agriculture,2020,177:105707.

[23] WU D H,WANG Y F,HAN M X,et al.Using a CNN-LSTM for basic behaviors detection of a single dairy cow in a complex environment[J].Computers and Electronics in Agriculture,2021,182:106016.

[24] JIANG B,YIN X Q,SONG H B.Single-stream long-term optical flow convolution network for action recognition of lameness dairy cow[J].Computers and Electronics in Agriculture,2020,175:105536.

[25] LI D,ZHANG K F,LI Z B,et al.A spatiotemporal convolutional network for multi-behavior recognition of pigs[J].Sensors,2020,20(8):2381.

[26] CHEN C,ZHU W X,STEIBEL J,et al.Recognition of feeding behaviour of pigs and determination of feeding time of each pig by a video-based deep learning method[J].Computers and Electronics in Agriculture,2020,176:105642.

[27] LIU D,OCZAK M,MASCHAT K,et al.A computer vision-based method for spatial-temporal action recognition of tail-biting behaviour in group-housed pigs[J].Biosystems Engineering,2020,195:27-41.

[28] CHEN C,ZHU W X,STEIBEL J,et al.Classification of drinking and drinker-playing in pigs by a video-based deep learning method[J].Biosystems Engineering,2020,196:1-14.

[29] 高云,陈斌,廖慧敏,等.群养猪侵略性行为的深度学习识别方法[J].农业工程学报,2019,35(23):192-200.

GAO Yun,CHEN Bin,LIAO Huimin,et al.Recognition method for aggressive behavior of group pigs based on deep learning[J].Transactions of the CSAE,2019,35(23):192-200.(in Chinese)

[30] SIMONYAN K,ZISSERMAN A.Two-stream convolutional networks for action recognition in videos[J].Advances in Neural Information Processing Systems,2014,27:11797475.

[31] TRAN D,BOURDEV L,FERGUS R,et al.Learning spatiotemporal features with 3D convolutional networks[C]∥Proceedings of the IEEE International Conference on Computer Vision,2015:4489-4497.

[32] HOCHREITER S,SCHMIDHUBER J.Long short-term memory[J].Neural Computation,1997,9(8):1735-1780.

[33] GERS F A,SCHMIDHUBER J,CUMMINS F.Learning to forget:continual prediction with LSTM[J].Neural Computation,2000,12(10):2451-2471.

[34] ROBERT B,WHITE B J,RENTER D G,et al.Evaluation of three-dimensional accelerometers to monitor and classify behavior patterns in cattle[J].Computers and Electronics in Agriculture,2009,67(1-2):80-84.

[35] TURNER K E,THOMPSON A,HARRIS I,et al.Deep learning based classification of sheep behaviour from accelerometer data with imbalance[J].Information Processing in Agriculture,2023,10(3):377-390.

[36] LONG L J,JOHNSON Z V,LI J Y,et al.Automatic classification of Cichlid behaviors using 3D convolutional residual networks[J].Iscience,2020,23:101591.

[37] YI Z W,SUN Z H,FENG J C,et al.3D residual networks with channel-spatial attention module for action recognition[C]∥2020 Chinese Automation Congress (CAC),2020:5171-5174.

[38] 叶枫,丁锋.不平衡数据分类研究及其应用[J].计算机应用与软件,2018,35(1):132-136.

YE Feng,DING Feng.Research and application of unbalanced data classification[J].Computer Applications and Software,2018,35(1):132-136.(in Chinese)

[39] NICOL A U,PERENTOS N,MARTINS A Q,et al.Automated detection and characterisation of rumination in sheep using in vivo electrophysiology[J].Physiology &Behavior,2016,163:258-266.

[40] OUYANG X,XU S J,ZHANG C Y,et al.A 3D-CNN and LSTM based multi-task learning architecture for action recognition[J].IEEE Access,2019,7:40757-40770.

[41] TRAN D,RAY J,SHOU Z,et al.ConvNet architecture search for spatiotemporal feature learning[J].ArXiv Preprint arXiv:1708.05038,2017.

[42] HOWARD A G,ZHU M,CHEN B.MobileNets:efficient convolutional neural networks for mobile vision applications[J].ArXiv Preprint arXiv:1704.04861,2017.

[43] WANG Z W,SHE Q,SMOLIC A.ACTION-Net:multipath excitation for action recognition[C]∥Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition,2021:13214-13223.

[44] TRAN D,WANG H,TORRESANI L,et al.A closer look at spatiotemporal convolutions for action recognition[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,2018:6450-6459.