油茶是一种亚热带常绿灌木,在许多国家作为油料植物被广泛种植,不仅是一种重要的经济林物种,而且还具有丰富的不饱和脂肪酸[1],营养价值高。而油茶果实密度大,闭塞严重,油茶收获需要大量的人力,采收效率低下[2],因此油茶果的机械化采收势在必行。

基于机器视觉的深度学习算法被广泛应用于科学研究中,包括缺陷检测[3]、病虫害检测[4]、植物表型[5]、除草管理[6]等。目前,果蔬目标检测主要采用两种方法,一种是基于颜色、纹理[7-8]、边缘[9]等的传统图像检测和分割技术。然而,浅层特征只能在有限的场景中检测目标,这些方法虽然提供相对较快的处理速度,但是往往缺乏泛化性和鲁棒性,不适合复杂背景下油茶的识别。而使用深度学习策略可以解决复杂环境下的作物检测问题。IQBAL等[10]使用Inception v3对8个芒果品种进行自动分类和分级,考虑到颜色、大小、形状和纹理等特征,该方法分类准确率达到99.2%和分级准确率96.7%,具有良好的检测效果,且模型轻量化易于部署。WANG等[11]使用YOLO v7算法识别小米辣,通过使用可变形卷积使模型轻量化同时不降低检测速度,可以满足边缘部署条件。CONG等[12]提出一种基于Swin Transformer注意力机制的改进Mask RCNN,使用UNet3+提高Mask头和Mask分割质量,在叶片遮挡情况下有效分割不同类别的青椒,但是这种一阶段检测模型检测速度慢,不能满足实时性要求。

目前的研究应用中,目标检测为目标的实时追踪奠定基础,目标检测的精度决定目标追踪器的追踪效果。多目标追踪指在事先不知道目标数量的情况下,对视频中的多个目标进行检测并分配ID进行轨迹跟踪,其中每个目标都有不同的ID,以便后续进行轨迹预测、精确查找等。DeepSORT是目前最流行的多目标跟踪算法,一般与深度学习框架相结合,最先应用于人和车辆检测计数方面,目前已被广泛应用于果园产量估计[13-14]、禽类养殖[15]、动物保护[16]、船舰实时检测追踪[17]等。ZHOU等[18]使用YOLO v5s模型结合DeepSORT实现对单个稻穗成长发育的定位追踪,为获取每棵稻穗成长发育的表型变换以及指定合理施肥策略奠定基础。

机器识别的精确度是实现自动化采收、产量估计等的重要前提。油茶果识别不仅面临颜色多变、近景色、小目标等困境,还存在生长环境复杂的问题,比如多遮挡、不均匀光照等。综合考虑这些影响因素,如何提高果园油茶的识别效果以及满足网络模型轻量化要求使之便于部署是本研究的重点。此外,为了将单幅图像的检测结果进一步可视化,以及为预测油茶果的产量提供理论支持,对COF-YOLO v8n模型检测到的油茶果进行计数。本文对YOLO v8n网络进行3方面的改进,使网络在复杂田间环境下具有更高的鲁棒性,且模型足够轻量使之便于实现边缘部署。

本研究以油茶果为实验对象。油茶果实通常为球形,与叶片的形状对比明显;其品种多,存在红褐色、青色等不同颜色;果实通常粘连成长,密度大。由于油茶的外形颜色与经济林物种冬枣等相似,因此基于油茶的研究有望推广到其他种类的果实中。

油茶数据集在江苏省南京市江宁区的油茶果种植基地获取。拍照设备为ZED-Mini相机,采集天气分为晴天和阴天,采集时间段分别为07:00—11:00、13:00—18:00,获取得到不同光照强度、不同颜色的油茶图像共788幅。图1为多样性数据集。

图1 多样性油茶数据集

Fig.1 Diversity Camellia oleifera datasets

1.2.1 数据扩充

数据扩充是在训练前对整个数据集进行预处理,目的是增加数据集的大小和多样性。使用OpenCV库对原始数据集进行扩充。为模仿运动抖动导致的图像模糊,对图像添加椒盐、高斯噪声;为模仿相机在一瞬间捕捉到不同角度的图像,对原始数据进行仿射、平移、翻转等变换。数据增强后共计3 566幅图像,使用Pycharm中的LabelImg对图像进行标注,分为严重闭塞(0,油茶果被遮挡部分大于整个果实的1/4)和轻微闭塞或不闭塞(n,油茶果被遮挡的部分小于整个果实的1/4)2类,严重闭塞总计6 778个油茶标签,轻微闭塞或不闭塞有 6 989个标签,油茶类别标签占比约为1∶1。数据集按照8∶2划分为训练集和验证集。图2为增强后图像。

图2 数据扩充

Fig.2 Data augmentation

1.2.2 数据增强

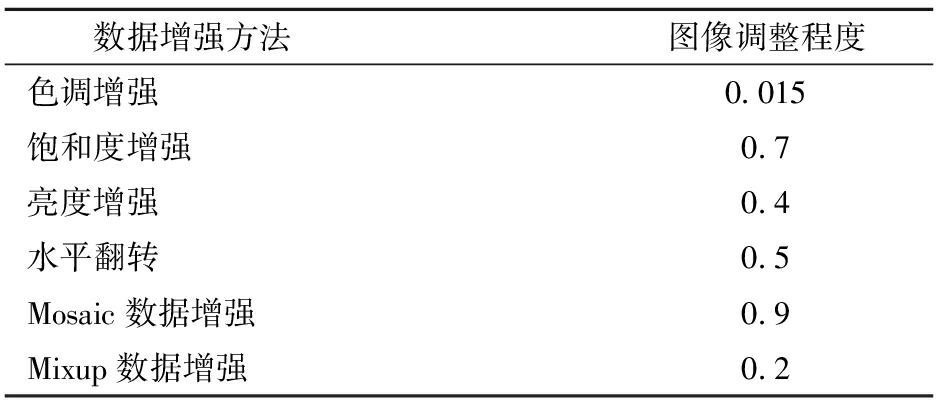

数据在进行训练时,网络会通过随机色调增强、饱和度增强、亮度增强、水平翻转、Mosiac、Mixup等变换生成多样化的训练样本,增加数据的多样性,提高模型的泛化能力。数据增强应用于每个训练迭代时,通过随机对训练样本进行变换,使模型每次看到的样本有所不同。表1为训练过程中数据增强的超参数。

表1 训练过程中数据增强方法

Tab.1 Data augmentation method during training

数据增强方法图像调整程度色调增强0.015饱和度增强0.7亮度增强0.4水平翻转0.5Mosaic数据增强0.9Mixup数据增强0.2

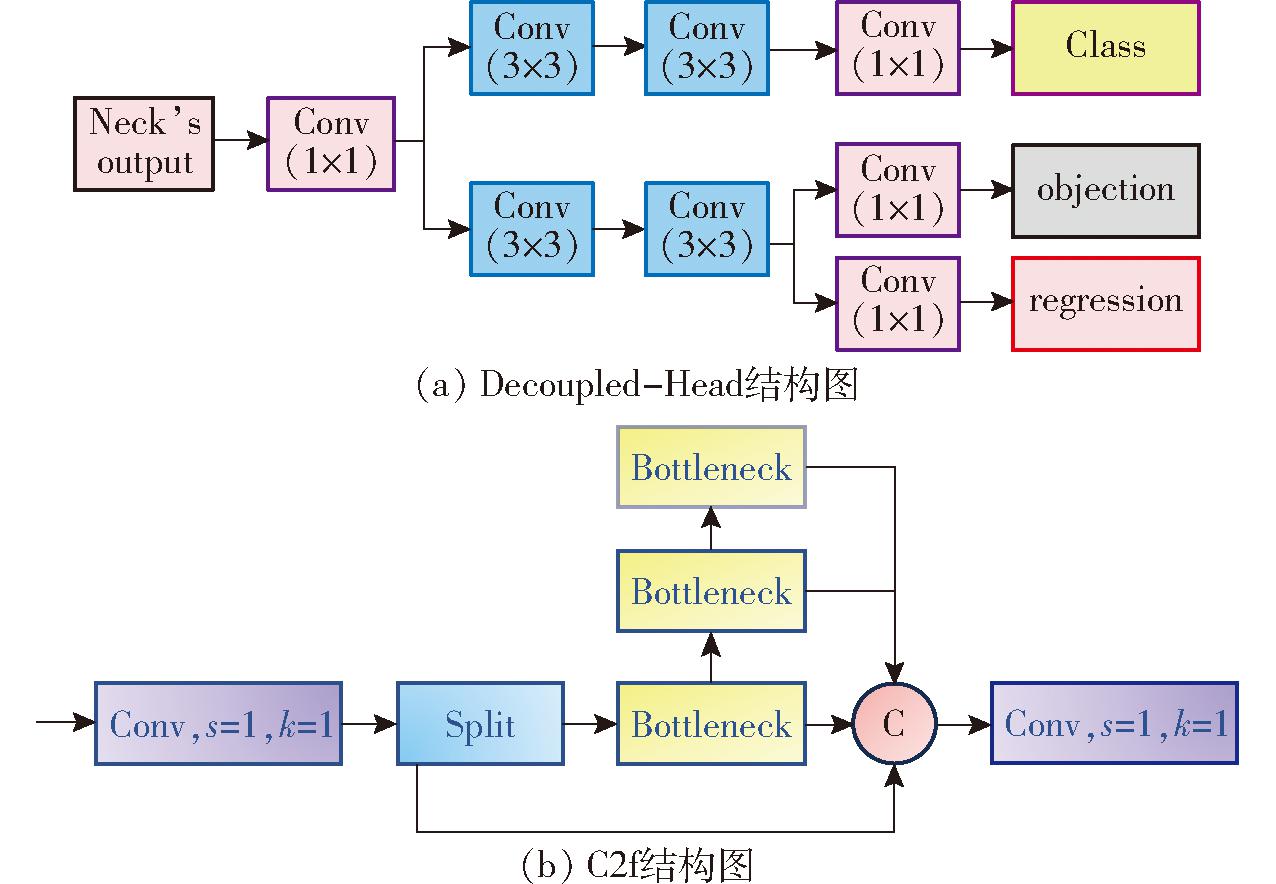

YOLO v8是2023年Ultralytics公司开源的新网络,集成目标检测、关键点检测、实例分割、实时追踪等任务。相比YOLO v5,最大的改进是采用基于中心检测算法的无锚框(Anchor-Free)检测方式,直接检测物体的中心区域和边界信息,将分类和回归解耦为2个子网,因无需手动设计锚框从而减小了由于选择锚框数量和尺寸而导致的干扰,能有效提高目标检测的准确性,尤其对小目标更加友好,因为不同尺寸的锚框数量一般不平衡,所以可能会导致小目标的检测效果差,而Anchor-Free这种无锚框设计解决了这种数量不平衡问题。使用Decoupled-Head作为最终检测头,Decoupled-Head包含2个并行的分支,每个分支都包含2个3×3的卷积层,其中一个分支用于预测分类,另一个分支用于预测回归和目标置信度,将分类和回归任务进行分开预测,从而减少这两任务之间的冲突,理论上能够提高模型性能,图3a为Decoupled-Head的结构图;此外C3模块改为C2f模块,同时将上采样之前的1×1卷积去除,将Backbone不同阶段输出的特征直接输入上采样操作,C2f综合C3模块以及YOLO v7中的ELAN优点,具有丰富的梯度信息流的同时还保证轻量化,图3b为C2f结构图。

图3 YOLO v8n的改进部分示意图

Fig.3 Improvement schematic of YOLO v8n

因为YOLO v8n网络是YOLO v8系列中最小的网络,更易满足轻量化要求,本文模型在YOLO v8n的基础上进行改进。

1.4.1 轻量化网络重建

模型轻量化方便完成边缘部署,从而利于实现后续的采摘工作。本文利用SCConv[19](Spatial and channel reconstruction convolution)使COF-YOLO v8n模型轻量化。SCConv是2023年LI团队开发的一种轻量化卷积,由SRU(Spatial reconstruction unit)和CRU(Channel reconstruction unit)两部分串联组成,通过减少标准卷积中的空间和通道特征冗余来降低模型参数量和浮点运算量(FLOPs)。

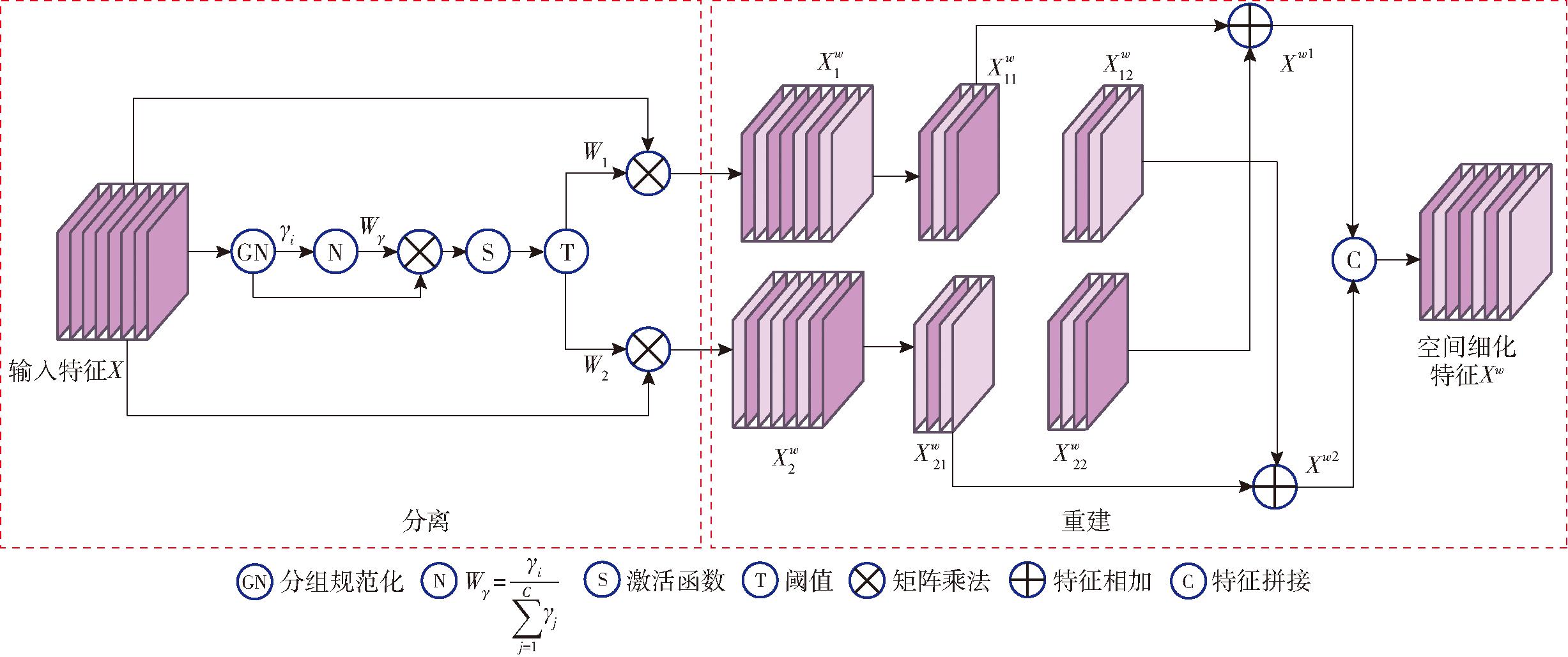

SRU通过分离-重建2部分抑制空间冗余,获得空间细化特征Xw。图4为其原理图。

图4 SRU模型原理图

Fig.4 SRU model principle diagram

首先将输入特征X进行组归一化(GN)得到输出特征Xout为

(1)

式中 u——X的均值 ε——正常数

γ、β——学习参数

σ——X的标准差

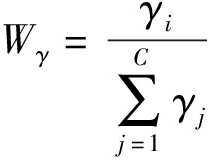

将随机初始化参数γ归一化后得到通道权重Wγ为

(2)

式中 i、j——索引变量

C——通道数量

将Wγ与Xout相乘的值映射到(0,1)之间,使用阈值进行门控。大于阈值的Wγ视为有用特征设置为W1,小于阈值的Wγ视为无用特征设置为W2。W的计算公式为

W=Gate(sigmoid(Wγ(Xout))

(3)

式中 Gate——门控函数

W——通过门控同时得到的富信息权重W1和弱信息权重W2

使用交叉重建方式在空间维度上增强有用特征抑制冗余特征,从而获得空间细化特征Xw。

(4)

(5)

(6)

(7)

Xw=Xw1∪Xw2

(8)

式中 ![]() 从

从![]() 中进一步分离得到的丰富信息

中进一步分离得到的丰富信息

![]()

![]() 中剩下的较不丰富的信息

中剩下的较不丰富的信息

![]() 信息量大的特征

信息量大的特征

![]() 信息量小的特征

信息量小的特征

Xw1、Xw2——交叉重构特征

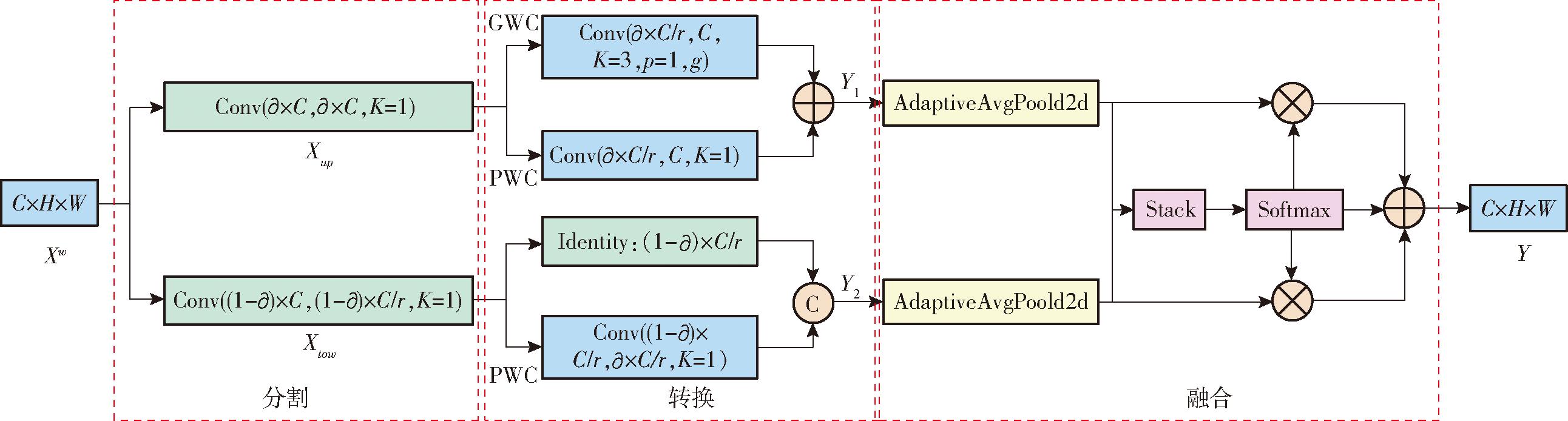

所得空间细化特征Xw在通道上还是冗余的,采用CRU进行分割-转换-融合策略减少通道冗余。图5为CRU的实现原理图。

图5 CRU的实现原理图

Fig.5 CRU implementation diagram

使用分割将特征进一步分为富特征提取器Xup和浅特征提取器Xlow,Xup采用高效卷积运算GWC(Group-wise convolution)结合PWC(Group-wise convolution)替代K×K卷积,以较少的计算成本提取代表性特征Y1,Xlow用廉价的1×1 PWC操作来生成具有浅层隐藏细节的特征映射得到Y2,作为Xup特征提取器的补充,对Y1和Y2进行融合,即可得到具有更多有效信息的Y。因此输入特征X经过SRU和CRU之后既能减少信息冗余又能提取出有效信息。

1.4.2 MPDIOU改进

由于现有大多数损失函数在不同预测结果下具有相同的值,降低了边界框回归的收敛速度和准确性,受水平矩形的几何特征启发,SILIANG等[20]设计一种基于最小点距离的新型损失函数,使用MPDIOU可以直接预测边界框与实际标注框之间的左上角和右下角点之间的距离。具体计算公式为

(9)

其中![]()

(10)

(11)

式中 A、B——两个任意图形

w、h——输入图像宽度、高度

![]() 图形A的左上和右下点坐标

图形A的左上和右下点坐标

![]() 图形B的左上和右下点坐标

图形B的左上和右下点坐标

d1、d2——图形A、B的左上角点之间的欧氏距离和右下角点之间的欧氏距离

MPDIOU简化了两个边界框之间的相似性比较,帮助算法选择最合适的边界框来准确定位目标。使用MPDIOU可以有效解决果实重叠导致的检测框失真现象,有效降低油茶果漏检问题。

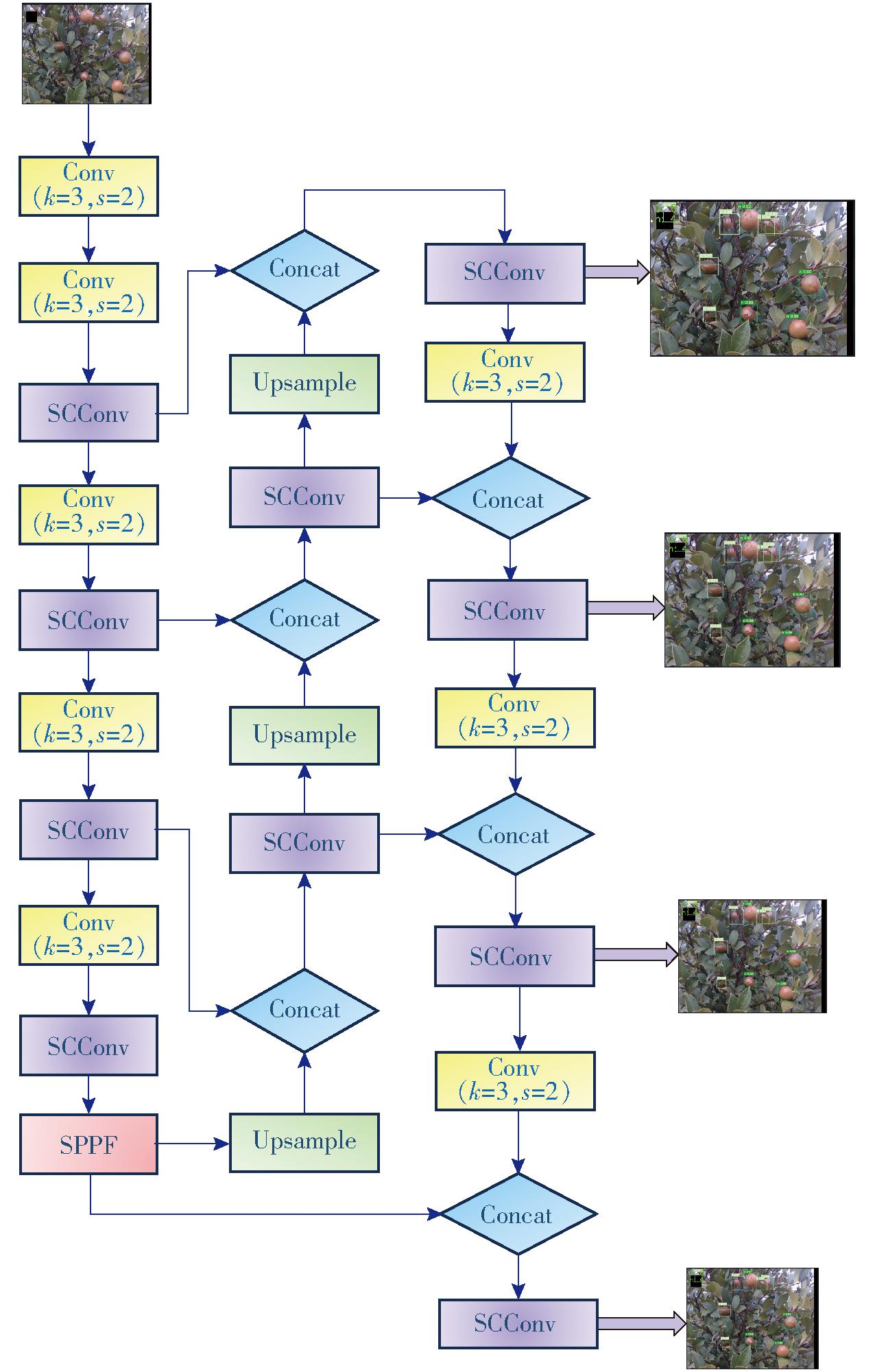

1.4.3 小目标检测层添加

当处理小目标油茶图像识别问题时,面临油茶直径在15~45 mm范围内、低像素覆盖率,以及可能被树叶、枝干和其他果实遮挡等问题。此外,输入图像尺寸对小目标油茶识别也产生了干扰,因为过大的图像会导致缩放,使小目标的识别更加困难。为了应对这些挑战,对YOLO v8n网络进行优化,并添加一个专门处理小目标的预测头。这个预测头将允许网络更加关注像素较小的油茶实例,从而提高小目标油茶识别准确性。当输入尺寸为640像素×640像素的特征图时,YOLO v8n输出特征图尺寸为40像素×40像素、80像素×80像素、20像素×20像素,调整网络结构后,添加一个160像素×160像素的小目标检测层。由于YOLO v8n是基于无锚框进行检测的,所以不再需要使用K-means算法对锚框进行重新设计。图6为改进COF-YOLO v8n模型结构图。

图6 改进COF-YOLO v8n网络结构图

Fig.6 Improved COF-YOLO v8n network structure diagram

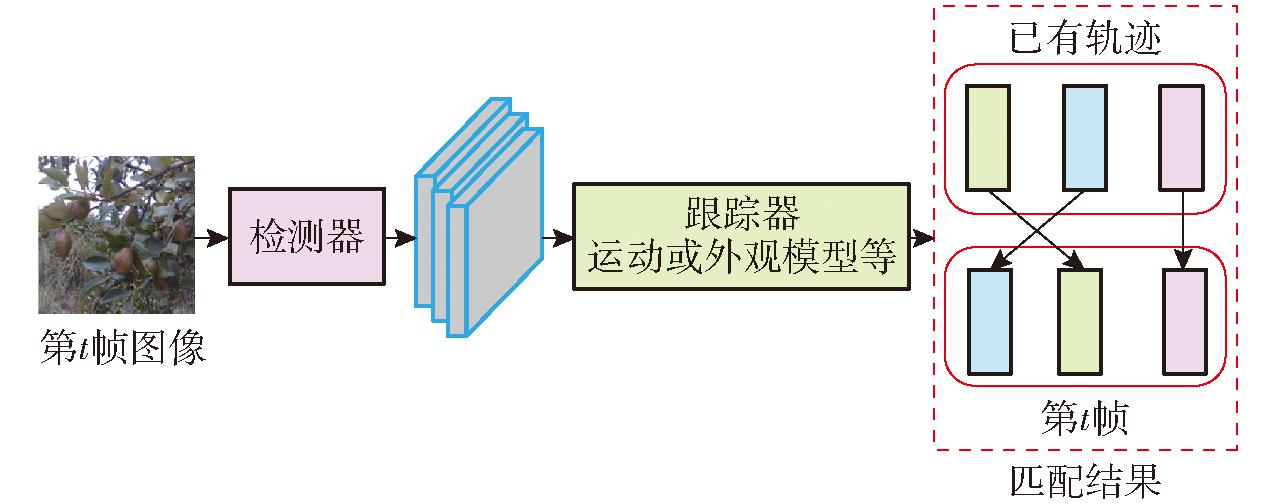

DeepSORT[21]是对SORT[22]的改进,用于目标跟踪,是一种基于行人再识别数据集离线训练的深度学习模型。在实时目标跟踪中,提取目标的特征进行最近邻匹配,提高了遮挡情况下的目标跟踪效果。同时也减少了目标ID跳变的问题。DeepSORT算法的核心思想仍然是传统的单假设跟踪方法,使用递归卡尔曼滤波和逐帧数据关联。流程操作如下:①读取当前目标检测帧的位置和各检测帧图像块的深度特征。②根据帧的置信度对帧进行滤波,去除置信度低的帧和特征。③随后对检测帧进行非极值抑制,消除一个目标的多帧。④利用卡尔曼滤波预测目标在当前帧中的位置。

追踪器一般都是和目标检测网络结合实现多目标的追踪功能。图7为目标检测器和DeepSORT结合实现物体追踪的原理图。

图7 物体追踪原理图

Fig.7 Object tracking principle diagram

1.6.1 环境配置

本研究模型训练和测试均在同一环境下运行,计算机的GPU为NVIDIA GeForce RTX3070Ti,CPU为AMD Ryzen 7 5800X 8核处理器,操作系统为Windows 11,使用PyTorch 1.10、Python 3.9和CUDA12.1。

1.6.2 模型评价指标

为了评估模型性能,使用精确率(Precision,P)、召回率(Recall,R)、平均精度均值(mAP)作为评价指标。

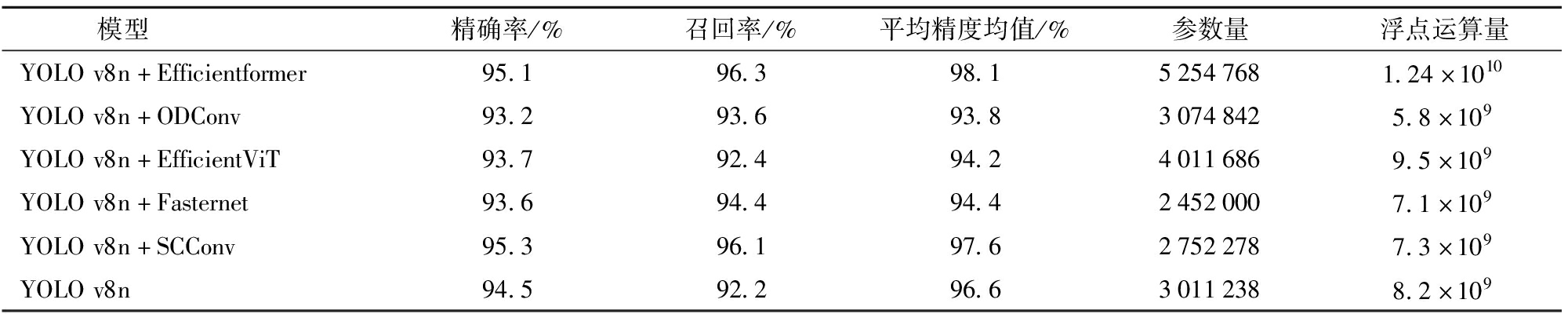

为了验证本文使用的SCConv的有效性,对比近两年的轻量化SOTA(State of the art)模型,选用Efficientformer[23]、ODConv[24](Omni-dimensional dynamic convolution)、Fasternet[25]、EfficientViT[26]轻量化网络进行对比实验,结果如表2所示。

表2 轻量化网络对比结果

Tab.2 Comparison results of lightweight network

模型精确率/%召回率/%平均精度均值/%参数量浮点运算量YOLOv8n+Efficientformer95.196.398.152547681.24×1010YOLOv8n+ODConv93.293.693.830748425.8×109YOLOv8n+EfficientViT93.792.494.240116869.5×109YOLOv8n+Fasternet93.694.494.424520007.1×109YOLOv8n+SCConv95.396.197.627522787.3×109YOLOv8n94.592.296.630112388.2×109

由表2可知,基于动态卷积的ODConv具有比较小的参数量以及最小的浮点运算量,检测方面,召回率比YOLO v8n增加1.4个百分点,但是精确率、平均精度均值分别比YOLO v8n降低1.3、2.8个百分点;Fasternet具有最少的参数量以及较低的浮点运算量,召回率比YOLO v8n增加2.2个百分点,但精确率、平均精度均值分别比 YOLO v8n降低0.9、2.2个百分点;Efficientformer相比于YOLO v8n在精确率、召回率、平均精度均值上均有提升,分别提升0.6、4.1、1.5个百分点,但是参数量以及计算复杂度比较大;而SCConv具有较少的参数量以及比较小的计算复杂度,且在精确率、召回率、平均精度均值方面的表现均比YOLO v8n好,分别高0.8、3.9、1.0个百分点。综上所述,SCConv具有更好的表现能力,在减少模型复杂度的同时,能够提高模型的识别效果,因此利用SCConv替代YOLO v8n的C2f是合理的。

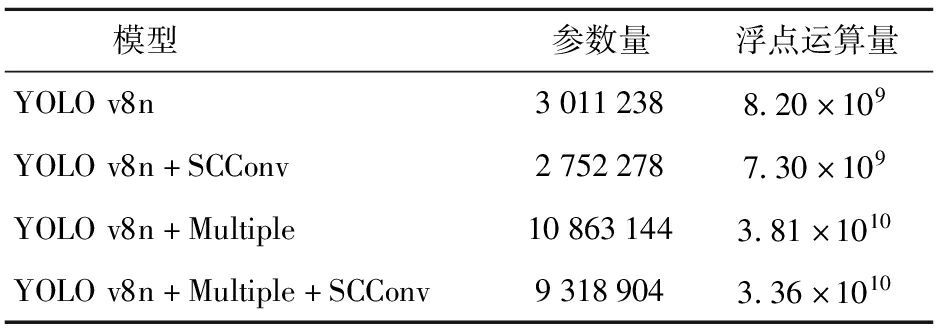

使用SCConv替换YOLO v8n中的C2f,实验证明可以有效降低参数量和浮点运算量,表3为添加SCConv后的参数量以及计算量。

表3 轻量化模型参数

Tab.3 Parameters of lightweight models

模型参数量浮点运算量YOLOv8n30112388.20×109YOLOv8n+SCConv27522787.30×109YOLOv8n+Multiple108631443.81×1010YOLOv8n+Multiple+SCConv93189043.36×1010

注:Multiple表示加入小目标检测层。

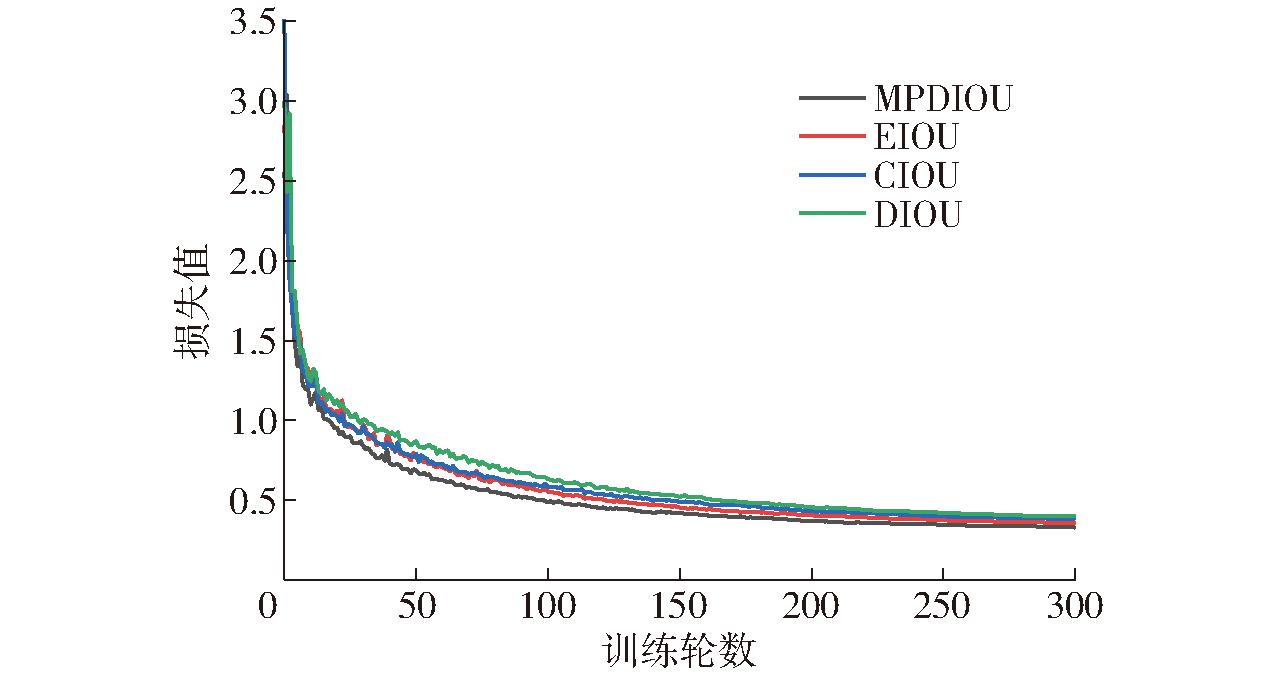

YOLO v8n默认使用的损失函数是CIOU,将CIOU改为EIOU、DIOU、MPDIOU损失函数后,在验证集上进行对比实验,如图8所示,MPDIOU比CIOU在验证集上表现更好,类别损失更低。

图8 不同IOU在验证集上的类别损失值

Fig.8 Class loss values for different IOU thresholds on validation set

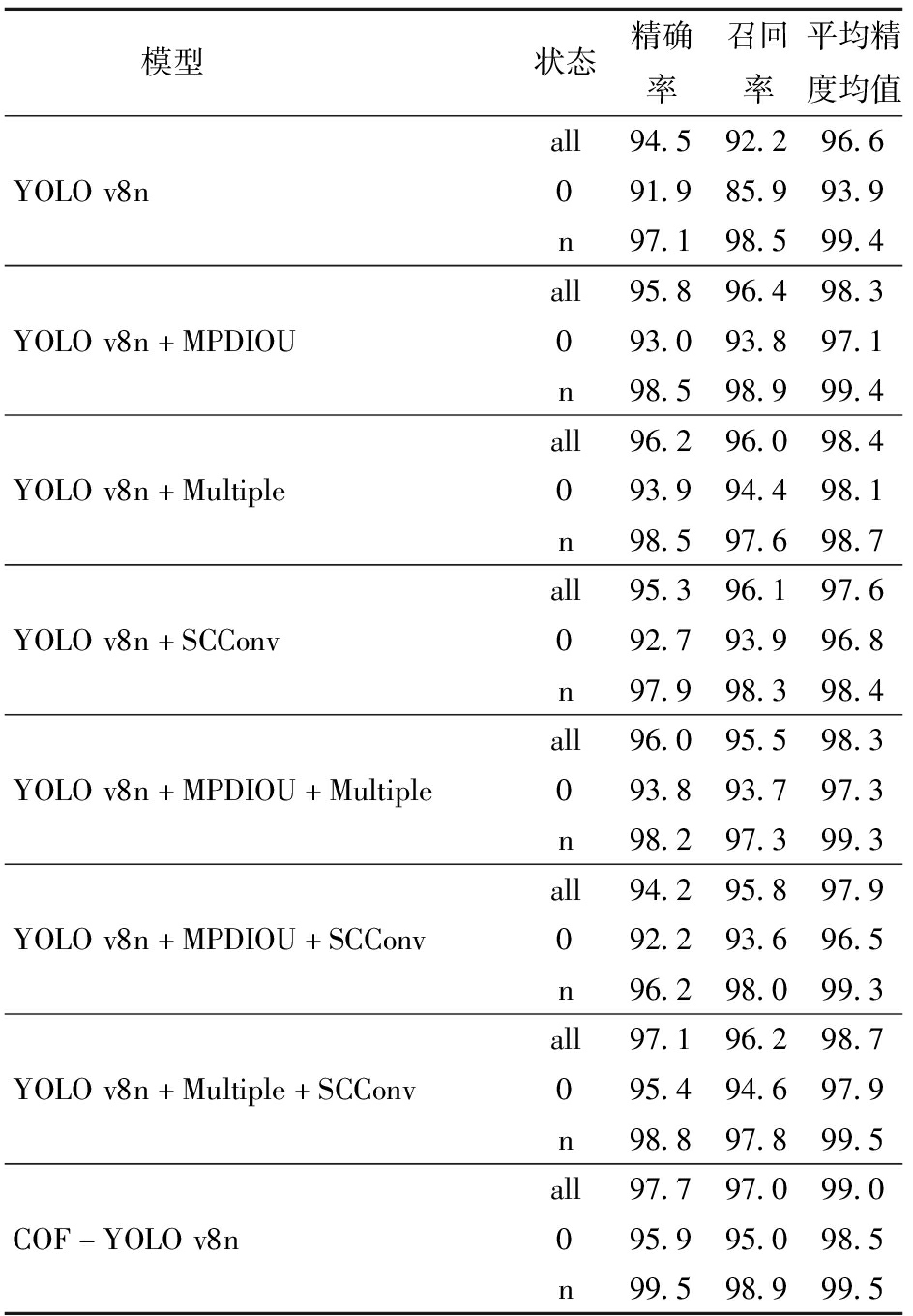

分别使用MPDIOU、Multiple、SCConv改进YOLO v8n网络,所得消融实验结果如表4所示。表中状态all表示油茶果未被遮挡。

表4 消融实验结果

Tab.4 Results of ablation experiments %

模型状态精确率召回率平均精度均值all94.592.296.6YOLOv8n091.985.993.9n97.198.599.4all95.896.498.3YOLOv8n+MPDIOU093.093.897.1n98.598.999.4all96.296.098.4YOLOv8n+Multiple093.994.498.1n98.597.698.7all95.396.197.6YOLOv8n+SCConv092.793.996.8n97.998.398.4all96.095.598.3YOLOv8n+MPDIOU+Multiple093.893.797.3n98.297.399.3all94.295.897.9YOLOv8n+MPDIOU+SCConv092.293.696.5n96.298.099.3all97.196.298.7YOLOv8n+Multiple+SCConv095.494.697.9n98.897.899.5all97.797.099.0COF-YOLOv8n095.995.098.5n99.598.999.5

由表4可得,YOLO v8n对不闭塞或轻微闭塞情况下的油茶检测效果较好,严重闭塞情况下油茶的检测效果却不理想。但当向YOLO v8n中加入MPDIOU、Multiple、SCConv后,网络整体的参数均有提升。加入MPDIOU后在严重闭塞时精确率、召回率、平均精度均值分别提高1.1、7.9、3.2个百分点;加入Multiple后,对于严重闭塞的精确率、召回率、平均精度均值分别提高2.0、8.5、4.2个百分点;当加入MDPIOU、SCConv后,严重闭塞情况下的精确率、召回率、平均精度均值分别提高0.3、7.7、2.6个百分点;同时加入Multiple和SCConv时,在严重闭塞时的精确率、召回率、平均精度均值分别提高3.5、8.7、4个百分点;同时加入Multiple和MPDIOU后在严重闭塞时的精确率、召回率、平均精度均值分别提高1.9、7.8、3.4个百分点。

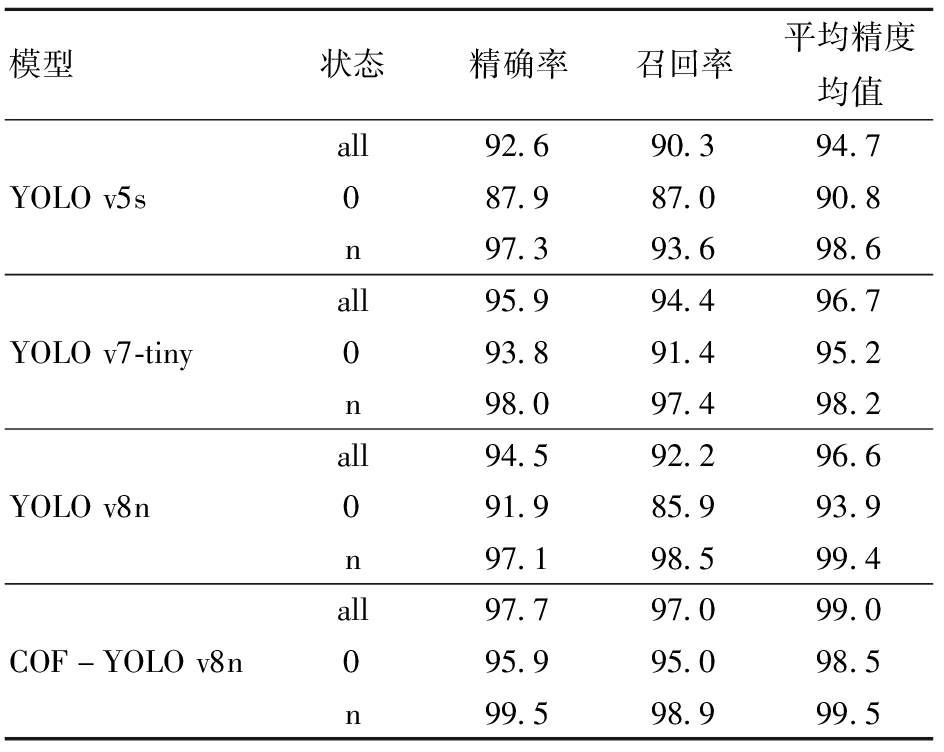

为了验证COF-YOLO v8n的检测优势,将其与未经改进的YOLO v5s、YOLO v7-tiny、YOLO v8n网络进行对比,结果如表5所示。

表5 YOLO模型对比实验结果

Tab.5 Experimental comparison results of YOLO model %

模型状态精确率召回率平均精度均值all92.690.394.7YOLOv5s087.987.090.8n97.393.698.6all95.994.496.7YOLOv7-tiny093.891.495.2n98.097.498.2all94.592.296.6YOLOv8n091.985.993.9n97.198.599.4all97.797.099.0COF-YOLOv8n095.995.098.5n99.598.999.5

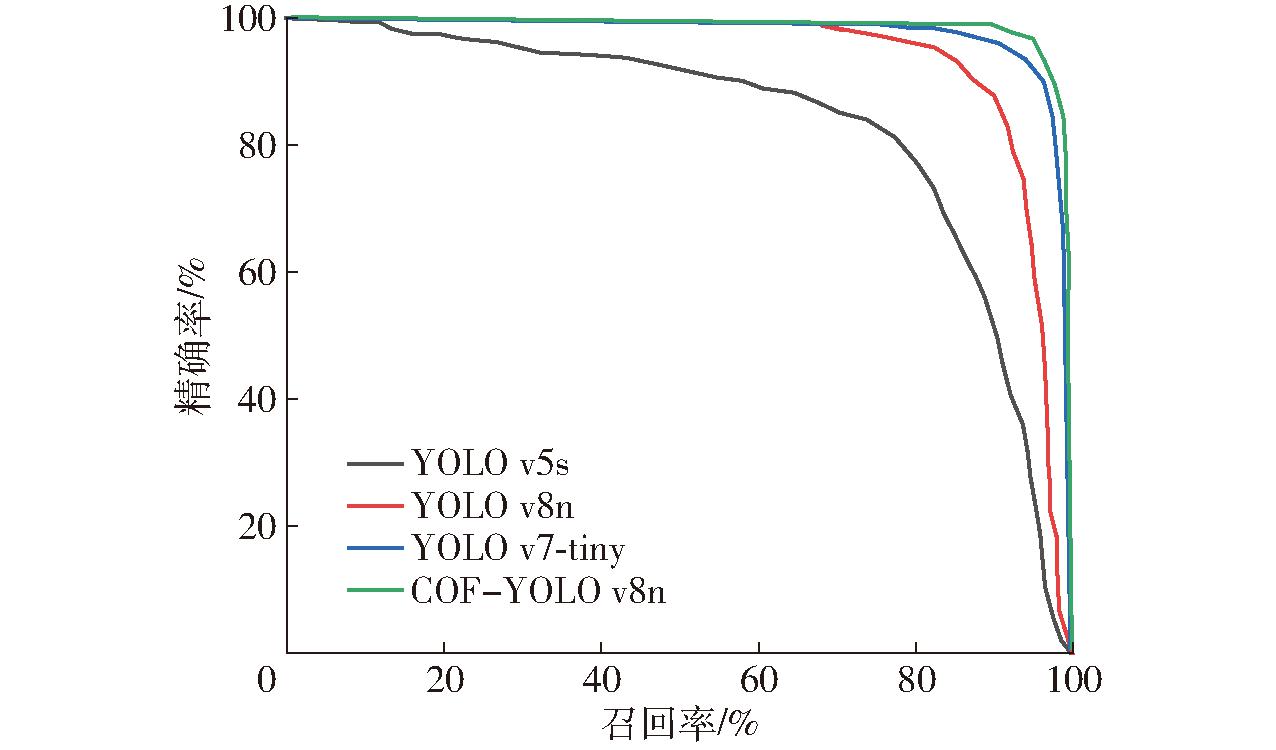

由表5可知,YOLO v7-tiny相比YOLO v5s和YOLO v8n具有更高的精确率、召回率、平均精度均值,因为YOLO v7-tiny网络较深,能对特征进行深度提取,但YOLO v7-tiny在验证集上的推理时间比较长,不利于模型的部署以及实时检测。COF-YOLO v8n在整个数据集上的精确率、召回率、平均精度均值比表现较好的YOLO v7-tiny分别高1.8、2.6、2.3个百分点,严重闭塞情况下的精确率、召回率、平均精度均值分别比YOLO v7-tiny高2.1、3.6、3.3个百分点。

由于轻微闭塞或者无闭塞情况下模型的识别效果均较好,只对严重闭塞情况下油茶进行P-R曲线可视化,如图9所示。

图9 验证集在不同模型上的P-R曲线

Fig.9 P-R curves of validation set on different models

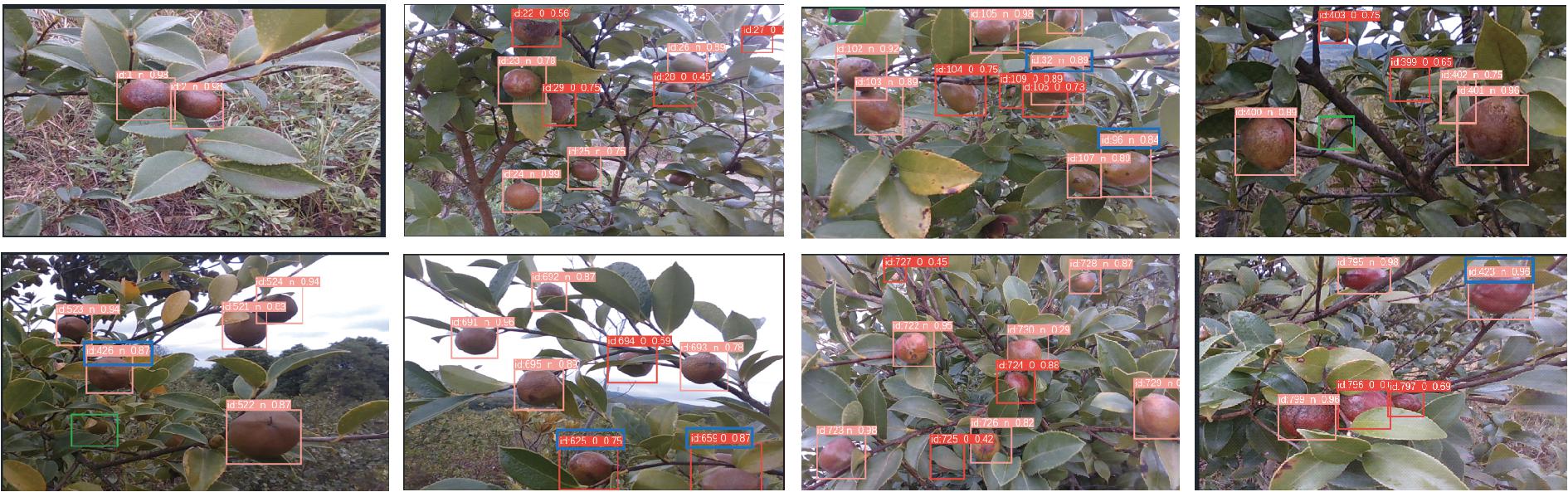

2.5.1 静态图像识别计数

将YOLO v8n与YOLO v8n+SCConv、YOLO v8n+MPDIOU、COF-YOLO v8n在验证集上的检测效果进行对比,来验证改进模型的有效性。在检测到油茶果的同时,算法还能实现对单幅图像不同类别的油茶果实进行计数,计数结果显示在可视化图像的左上角。图10中紫色框表示漏检,蓝色框表示误检。

图10 检测结果可视化

Fig.10 Detection visualizations

图10从上到下展示的7幅可视化图像的光照强度逐渐减弱,油茶的颜色也由深变浅。为了区分不同模型的检测结果,设置目标检测框颜色随机生成;为了防止目标框宽度太宽导致检测失真,根据特征图大小设置检测框的宽度。针对图10中第2、3、4行图像,对比YOLO v8n、YOLO v8n+SCConv 和YOLO v8n+MPDIOU的可视化检测结果,可得出加入MPDIOU后能改善果实重叠情况下油茶果的识别效果。对比图10中的所有图像,比较YOLO v8n+MPDIOU、YOLO v8n+SCConv和COF-YOLO v8n模型可得,加入小目标层之后的模型对树枝、树叶遮挡、近景色以及小目标油茶具有更好的识别能力。由此表明改进后的模型能够更好地适应小目标、近景色、严重闭塞、不同光照下的油茶果,能够有效提高油茶的识别精度,有效改善漏检现象。

2.5.2 基于COF-YOLO v8n+DeepSORT的动态视频识别计数

将动态视频作为COF-YOLO v8n的输入,再将得到的油茶果信息作为DeepSORT输入,每个检测到的油茶果都将被分配唯一的追踪号,并在不同的视频结果中关联相同的水果数据,得到的动态检测结果如图11所示。图中蓝色框表示跳动的油茶ID,绿色框表示漏检。

图11 COF-YOLO v8n+DeepSORT的油茶跟踪结果

Fig.11 COF-YOLO v8n+DeepSORT realized tracking of Camellia oleifera fruit

视频由人手持相机以速度约0.15 m/s拍摄获得,视频帧率(FPS)为29 f/s,即每帧图像出现的时间约为34.5 ms,而目标检测时间总共为14.8 ms,目标匹配以及目标状态更新需要13.4 ms,将DeepSORT追踪器设置为每间隔10 f抽取一幅图像,抽取的相邻2幅图像有70%左右的油茶重复,每个油茶在视频中持续存在约345 ms,远远大于目标检测和追踪所需时间,因此能够满足输入视频的实时检测要求。但是追踪存在较明显的漏检现象,如绿色框所示。此外,同一幅图像中出现了油茶果ID切换现象,一方面由于目标追踪器可能会出现关联错误,将2个或多个不同的目标油茶误认为是同一个油茶,从而使目标从较高的ID跳到较低的ID,另一方面由于部分油茶在外观或运动上非常相似,导致追踪器可能发生混淆,从而导致ID切换,导致最终计数偏少。视频最后一帧检测到油茶的最大ID是798,而手工计数3次取平均值得到视频中总的油茶数目约为987个,即目标检测追踪精度约为81.9%。使用YOLO v8n+DeepSORT追踪到的油茶的最大ID为658,目标检测追踪的精度约为67%。因此COF-YOLO v8n配合DeepSORT能更好地实现油茶的追踪计数。

对比前人改进的油茶果识别实验,基于YOLO v8n改进的COF-YOLO v8n模型具有更高的精确率、召回率以及平均精度均值,表6为对比结果。

表6 实验结果对比

Tab.6 Comparison of experimental results with predecessors %

模型精确率召回率平均精度均值YOLOv5s[27]90.7398.3894.00YOLOv5s[2]94.8094.6098.40MaskR-CNN[28]89.4292.8689.85COF-YOLOv8n97.7097.0099.00

由表6可得,改进的YOLO v8n模型相比其它改进模型具有更高的识别精确率以及平均精度均值。相比一阶段算法Mask R-CNN,COF-YOLO v8n在精确率、召回率、平均精度均值方面分别提高8.28、4.14、9.15个百分点;相比周宏平等[2]提出的基于多源图像融合的油茶识别算法,COF-YOLO v8n在精确率、召回率、平均精度均值方面处于绝对优势;相比宋怀波等[27]改进的YOLO v5s网络,COF-YOLO v8n识别精确率以及平均精度均值均具有优势,召回率相对低1.38个百分点,分析原因可能是将油茶分为严重闭塞和轻微闭塞,虽然在轻微闭塞或无闭塞情况下油茶的召回率达到98.9%,但当严重闭塞和轻微闭塞油茶的标签数量相当的情况下,油茶整体的召回率会被严重闭塞的油茶拉低。综合可得,COF-YOLO v8n模型能够实现复杂情况下油茶的识别,能为未来自动化采收提供支持。

此外,在计数方面,赵春江等[29]也能实现鸡和鸡蛋计数功能,对视频中的每帧图像进行计数,但是视频图像之间存在目标重复出现,算法却并不能区分相同目标,因此会出现严重的重复计数现象;WANG等[30]使用改进的YOLO v3实现静态输入的计数,但是并不能真正实现番茄产量预估,因为一幅图像只是拍摄番茄的局部且存在遮挡;ZHANG等[31]通过无人机拍摄苹果树全景图,使用YOLOX对经过处理后的全景图像实现识别计数,从而估计单棵苹果树的产量,但果实闭塞情况难以避免,因此会出现产量少估现象。而本文提出的计数方法成本低,易于实现,不仅仅可以对输入的图像进行计数,还可以实现对3D视频中出现的所有油茶进行实时跟踪,通过对整棵树上的油茶进行3D拍摄,可以解决油茶闭塞问题,避免油茶少计数或重复计数的情况,可以帮助实现果园的产量估计。

(1)通过添加小目标检测层,使严重闭塞情况下的精确率、召回率、平均精度均值分别提高2.0、8.5、4.2个百分点,从验证集上的检测效果看,网络对小目标油茶果以及被树枝、树叶遮挡的油茶果具有优秀的识别能力;通过添加MPDIOU损失函数替代YOLO v8n的CIOU损失函数,从检测效果上看,网络对因果实重叠而导致的油茶漏检有明显的改善,很大程度上降低了漏检率;加入MPDIOU后相比YOLO v8n在严重遮挡情况下召回率提高7.9个百分点;加入SCConv之后使模型既能均衡精度又能均衡检测速度;改进后的COF-YOLO v8n整体的精确率、召回率、平均精度均值比YOLO v8n分别提高3.2、4.8、2.4个百分点,在严重遮挡情况下精确率、召回率、平均精度均值分别比YOLO v8n提高4.0、9.1、4.6个百分点。此外,对比前人改进模型的数据可得,本文提出的COF-YOLO v8n模型比前人的改进算法更能适应复杂环境。

(2)对于静态输入图像,COF-YOLO v8n具有更强的泛化能力以及鲁棒性,且可对检测到的不同类别的油茶进行计数;对于3D视频帧图像,用COF-YOLO v8n结合DeepSORT能够实现油茶的实时检测,最终得到检测检测器精度为81.9%,比未经改进的YOLO v8n+DeepSORT更适合实时检测计数。

[1] ZHOU Y,TANG Y,ZOU X,et al.Adaptive active positioning of Camellia oleifera fruit picking points:classical image processing and YOLO v7 fusion algorithm[J].Applied Siences,2022,12(24):12959.

[2] 周宏平,金寿祥,周磊,等.基于多模态图像的自然环境下油茶果识别[J].农业工程学报,2023,39(10):175-182.

ZHOU Hongping,JIN Shouxiang,ZHOU Lei,et al.Recognition of Camellia oleifera fruit in natural environment based on multimodal image[J].Transactions of the CSAE,2023,39(10):175-182.(in Chinese)

[3] YANG Y,KANG H.An enhanced detection method of PCB defect based on improved YOLO v7[J].Electronics,2023,12(9):2120.

[4] CHEN J,CHEN J,ZHANG D,et al.Using deep transfer learning for image-based plant disease identification[J].Computers and Electronics in Agriculture,2020,173:105393.

[5] LEE C,YANG M,TSENG H,et al.Single-plant broccoli growth monitoring using deep learning with UAV imagery[J].Computers and Electronics in Agriculture,2023,207:107739.

[6] RAI N,ZHANG Y,RAM B G,et al.Applications of deep learning in precision weed management:a review[J].Computers and Electronics in Agriculture,2023,206:107698.

[7] JANANI M,JEBAKUMAR R.Detection and classification of groundnut leaf nutrient level extraction in RGB images[J].Advances in Engineering Software,2023,175:103320.

[8] ALSHEHHI R,MARPU P R.Change detection using multi-scale convolutional feature maps of bi-temporal satellite high-resolution images[J].European Journal of Remote Sensing,2023,56(1):2161419.

[9] QUAN Y,LI M,HAO Y,et al.Tree species classification in a typical natural secondary forest using UAV-borne LiDAR and hyperspectral data[J].Giscience &Remote Sensing,2023,60(1):2171706.

[10] IQBAL H M R,HAKIM A.Classification and grading of harvested mangoes using convolutional neural network[J].International Journal of Fruit Science,2022,22(1):95-109.

[11] WANG F,JIANG J,CHEN Y,et al.Rapid detection of Yunnan Xiaomila based on lightweight YOLO v7 algorithm[J].Frontiers in Plant Science,2023,14:1200144.

[12] CONG P,LI S,ZHOU J,et al.Research on instance segmentation algorithm of greenhouse sweet pepper detection based on improved Mask RCNN[J].Agronomy,2023,13(1):196.

[13] HE L,FANG W,ZHAO G,et al.Fruit yield prediction and estimation in orchards:a state-of-the-art comprehensive review for both direct and indirect methods[J].Computers and Electronics in Agriculture,2022,195:106812.

[14] GAN H,LEE W S,ALCHANATIS V,et al.Active thermal imaging for immature citrus fruit detection[J].Biosystems Engineering,2020,198:291-303.

[15] JIANG K,XIE T,YAN R,et al.An attention mechanism-improved YOLO v7 object detection algorithm for hemp duck count estimation[J].Agriculture,2022,12(10):1659.

[16] CHEN X,PU H,HE Y,et al.An efficient method for monitoring birds based on object detection and multi-object tracking networks[J].Animals,2023,13(10):1713.

[17] JIANG Q,LI H.Silicon energy bulk material cargo ship detection and tracking method combining YOLO v5 and DeepSORT[J].Energy Reports,2023,9:151-158.

[18] ZHOU Q,GUO W,CHEN N,et al.Analyzing nitrogen effects on rice panicle development by panicle detection and time-series tracking[J].Plant Phenomics,2023,5:0048.

[19] LI J,WEN Y,HE L.SCConv:spatial and channel reconstruction convolution for feature redundancy[C]∥Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition,2023:6153-6162.

[20] SILIANG M,YONG X.MPDIoU:a loss for efficient and accurate bounding box regression[J].arXiv preprint arXiv:2307.07662,2023.

[21] WOJKE N,BEWLEY A,PAULUS D.Simple online and realtime tracking with a deep association metric[C]∥2017 IEEE International Conference on Image Processing (ICIP).IEEE,2017:3645-3649.

[22] BEWLEY A,GE Z,OTT L,et al.Simple online and realtime tracking[C]∥2016 IEEE International Conference on Image Processing (ICIP).IEEE,2016:3464-3468.

[23] LI Y,YUAN G,WEN Y,et al.Efficientformer:vision transformers at mobilenet speed[J].Advances in Neural Information Processing Systems,2022,35:12934-12949.

[24] LI C,ZHOU A,YAO A.Omni-dimensional dynamic convolution[J].arXiv preprint arXiv:2209.07947,2022.

[25] CHEN J,KAO S,HE H,et al.Run,don’t walk:chasing higher FLOPS for faster neural networks[C]∥Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition,2023:12021-12031.

[26] XIONG J T,LIN R,LIU Z,et al.The recognition of litchi clusters and the calculation of picking point in a nocturnal natural environment[J].Biosystems Engineering,2018,166:44-57.

[27] 宋怀波,王亚男,王云飞,等.基于YOLO v5s的自然场景油茶果识别方法[J].农业机械学报,2022,53(7):234-242.

SONG Huaibo,WANG Ya’nan,WANG Yunfei,et al.Identification method of Camellia oleifera fruit in natural scene based on YOLO v5s[J].Transactions of the Chinese Society for Agricultural Machinery,2022,53(7):234-242.(in Chinese)

[28] 王梁,侯义锋,贺杰.基于Mask-RCNN的自然场景下油茶果目标识别与检测[J].中国农机化学报,2022,43(12):148-154.

WANG Liang,HOU Yifeng,HE Jie.Target recognition and detection of Camellia oleifera in natural scene based on Mask-RCNN[J].Chinese Journal of Agricultural Mechanization,2022,43(12):148-154.(in Chinese)

[29] 赵春江,梁雪文,于合龙,等.基于改进YOLO v7的笼养鸡/蛋自动识别与计数方法[J].农业机械学报,2023,54(7):300-312.

ZHAO Chunjiang,LIANG Xuewen,YU Helong,et al.Automatic identification and counting method of caged chicken/egg based on improved YOLO v7[J].Transactions of the Chinese Society for Agricultural Machinery,2023,54(7):300-312.(in Chinese)

[30] WANG X,VLADISLV Z,VIKTOR O,et al.Online recognition and yield estimation of tomato in plant factory based on YOLO v3[J].Scientific Reports,2022,12(1):8686.

[31] ZHANG Y,ZHANG W,YU J,et al.Complete and accurate holly fruits counting using YOLOX object detection[J].Computers and Electronics in Agriculture,2022,198:107062.